- 1java datainputstream_Java中DataInputStream的用法

- 2M1安装JDK_macos m1安装jdk8

- 3渗透测试中powershell基础_(new-object system.net.webclient).downloadfile

- 4【玩转幻兽帕鲁】一键迁移本地单人世界(房间)存档上云【腾讯云版】

- 5基于mqtt协议的物联网项目之微信小程序(二)_微信小程序使用mqtt协议

- 6DataFunSummit:2022年数据治理在线峰会:核心内容与学习收获(附大会核心PPT下载)

- 7zabbix自定义监控项、监控内存使用率、监控磁盘使用率并创建图形_zabbix监控磁盘使用率

- 8python基础语法整理汇总,python基础语法菜鸟教程_python语法基础

- 9关系型(MySql)、键值型(Redis)、列型(HBase)、文档型(MongoDB)和图型(Neo4j)数据库优缺点选型对比-《七周七数据库》读书笔记_mongodb、hbase、redis、neo4j数据库对比分析

- 10金三银四面试必看,复盘字节测试开发面试:一次测试负责人岗位面试总结_测试开发岗位面试要求

开放Gemma而非“开源”,谷歌为何转变大模型竞争策略?_gemma 不对中国开放嘛

赞

踩

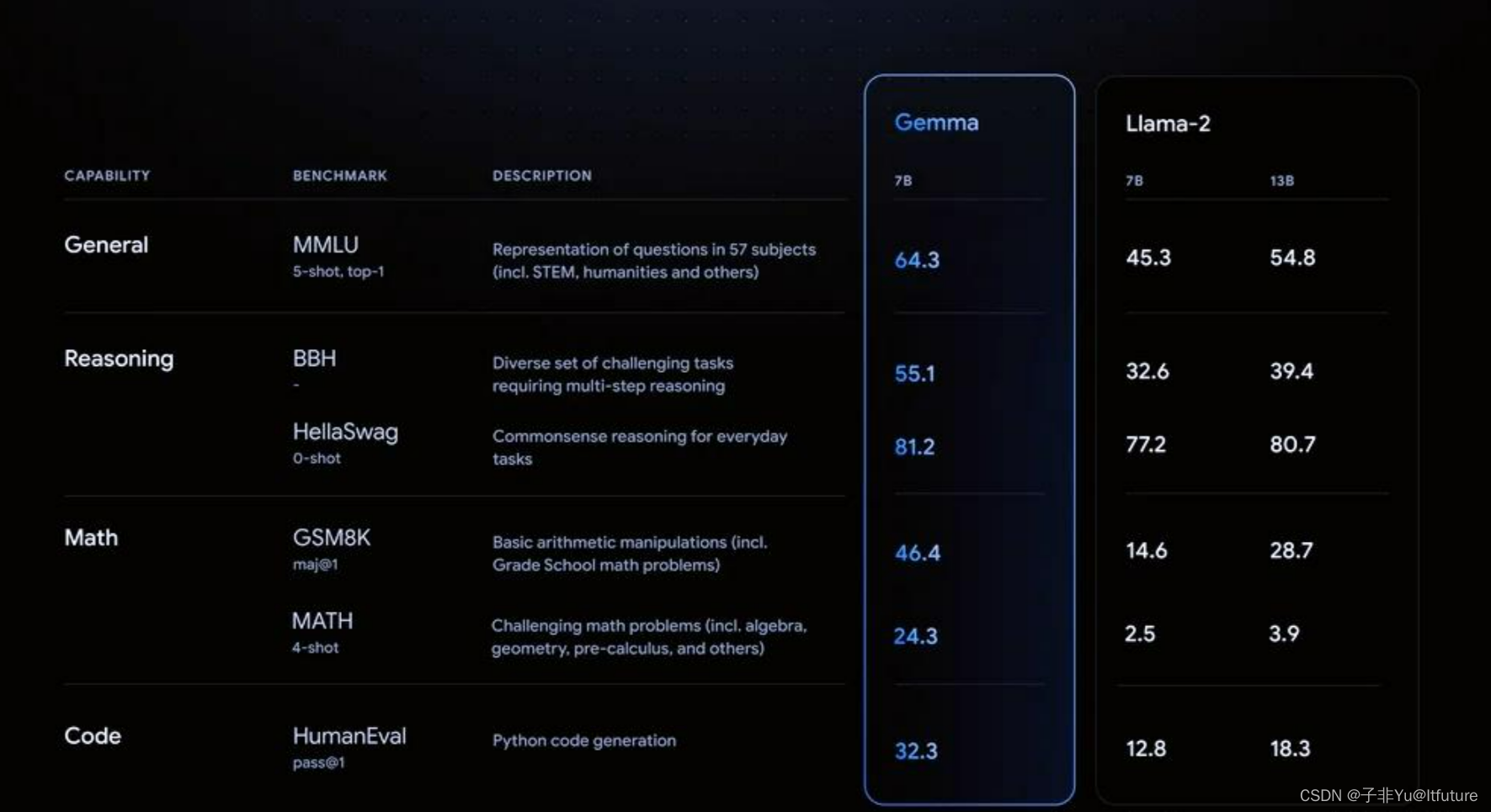

2月21日晚,谷歌宣布新一代免费可商用大语言模型Gemma在全球开放使用。该模型被谷歌视为自身“最先进的开放模型”。

开放而非开源!!

值得注意的是,谷歌强调Gemma为开放模型,而非“开源”,这意味着谷歌并不会分享Gemma的多项技术细节,包括Gemma的源代码、训练数据等。在应用上,谷歌称其使用条款允许所有组织负责任地进行商用和分发。

一、Gemma开源模型

Gemma是一系列轻量级、最先进的开放模型,采用了与创建Gemini模型相同的研究和技术。由Google DeepMind和Google的其他团队开发,Gemma受到Gemini的启发,其名称反映了拉丁文中的"gemma",意为“宝石”。除了发布模型权重之外,我们还提供工具,支持开发者创新、促进协作,并引导对Gemma模型的负责任使用。

Gemma仅用于处理文本信息,其基础技术架构与谷歌最强AI模型Gemini一致,但参数规模较小,仅有20亿参数和70亿参数两个规模版本,且两种参数规模的Gemma模型都会有预训练和指令微调版本。

Gemm较小的参数规模有助于Gemma实现更广泛部署。谷歌介绍称,Gemma支持主流AI框架,还可在笔记本电脑、台式机、物联网、移动设备和云端等环境上运行。

二、Gemma从今天开始在全球范围内提供。以下是关键的详细信息:

-

1.我们发布了两种规模的模型权重:Gemma 2B和Gemma 7B。每个规模都有经过预训练和指导微调的变体。

-

2.新的负责任生成式人工智能工具包提供了使用Gemma创建更安全人工智能应用程序的指导和必要工具。

-

3.我们提供了适用于所有主要框架(JAX、PyTorch和TensorFlow通过本机Keras 3.0)的推理和监督微调(SFT)的工具链。

-

3.与Ready-to-use Colab和Kaggle笔记本以及与Hugging Face、MaxText、NVIDIA NeMo和TensorRT-LLM等流行工具的集成相结合,使得使用Gemma变得非常容易入门。

-

4.经过预训练和指导微调的Gemma模型可以在您的笔记本电脑、工作站或Google Cloud上运行,并可以轻松部署在Vertex AI和Google Kubernetes Engine(GKE)上。

-

5.跨多个人工智能硬件平台的优化确保了行业领先的性能,包括NVIDIA GPU和Google Cloud TPU。

-

6.使用条款允许各种规模的组织进行负责任的商业使用和分发。

三、为什么这样做?

Gemm开放Gemma或是针对开源大模型领域所受批评的部分回应。此前谷歌和OpenAI因坚持技术封闭而遭到外界抨击,两者在最新、最先进的模型上都选择了闭源,被认为不利于技术进步。

去年Google貌似已经下定决心要闭源了,这可能源于低估了追赶OpenAI的技术难度,Bard推出令人大失所望使得谷歌不得不面对现实,去年下半年进入很尴尬的局面,闭源要追上OpenAI估计还要不少时间,而开源方面Meta已下决心,还有Mistral这种新秀冒头,逐渐主导了开源市场,这导致无论开源闭源,谷歌都处于被两面夹击,进退为难的境地。很明显,Gemma代表谷歌大模型策略的转变:兼顾开源和闭源,开源主打性能最强大的小规模模型,希望脚踢Meta和Mistral;闭源主打规模大的效果最好的大模型,希望尽快追上OpenAI。目前大模型开源形成三巨头局面:Google Gemma、Meta LLama和欧洲的Mistral。

目前大模型巨头混战,形成了打压链局面:OpenAI处于链条顶端,主要打压对手是有潜力追上它的竞争对手:谷歌和Anthropic,Mistral估计也正在被列入OpenAI的打压列表中。这个打压链条是这样的:OpenAI→Google &Anthropic & Mistral→ Meta→其它大模型公司

四、谷歌这一竞争策略如何?

谷歌开源Gemma不是针对OpenAI 宣发策略的反击,Gemimi 系列的定位才是对标GPT 4的。Gemma是针对开源届的,也就是针对Meta和Mistral的,这侧面说明Meta的LLama 3很快就要发布了,或者Mistral最近会有新品发布。

通过Gemma再次证明:

- 只要数据量足够多(Gemma 7B用到了6万亿Token,效果和Mistral 7B 差不多,这也侧面说明了之前大家猜测Mistral 7B使用了大约7万亿Token的大概率属实)

- 数据质量足够好(增加数学、代码、科学论文等增强模型推理能力的数据),小模型的能力仍然能够得到持续提升。

关于大模型的开源和闭源,我认为如果想发展大模型还是得比模型规模,这方面开源模型相对闭源模型出于明显劣势,短期内难以追上GPT 4或GPT 4v,且这种类型的大模型,即使是开源也只能仰仗谷歌或者Meta这种财大气粗的大公司,主要是太消耗资源了,一般人玩不起,国内这方面阿里千问系列做得比较好,肯把比较大规模的模型开源出来,更提供了modelscope这样的平台促进技术交流,属实难得。

另外,开源模型应该把主要精力放在开发并开源出性能足够强的小规模大模型上(SLLM,Small Large Language Model)。

我觉得谷歌的开源策略是非常合理的。目前看,作出强大的SLLM并没有太多技巧,主要是把模型压小的基础上,大量增加训练数据的规模,数据质量方面则是增加数学、代码等数据来提升模型的推理能力,比如Gemma 7B用6万亿Token数据,Mistral 7B的7万亿Token数据,两者也应该大量采用了增强推理能力的训练数据,只要持续增加训练数据的规模和质量,模型效果会持续提升,所以SLLM模型的性能天花板目前也没有到头,只要有更多更高质量的数据,就能持续提升SLLM模型的效果,仍然有很大空间。

SLLM相对GPT 4这种追求最强效果的模型比,训练成本低得多,而因为模型规模小,推理成本也极低,只要持续优化效果,从应用层面,大家肯定会比较积极地部署SLLM用来实战的,市场潜力巨大。也就是说,SLLM应该是没有太多资源,但是还是有一些资源的大模型公司必争之地。

因此,谷歌这一策略可能也预示着2024年在SLLM这方面关注度也比较高,我也相信2024年开源SLLM会有更惊艳黑马出场!!