热门标签

热门文章

- 1SST-EmotionNet: 基于空-谱-时的注意力三维稠密网络脑电情感识别_metaemotionnet: spatial-spectral-temporal based at

- 2antd踩坑记录之upload上传_为何 filelist 受控时,上传不在列表中的文件不会触发 onchange 后续的 status

- 3打开ms office相关软件如Visio, 发生闪退 ,打不开,无反应问题_visio安装助手打不开

- 4使用 TensorFlow 2.0 实现高水准的自然语言处理_tensorfolw 自然语言处理demo

- 5NLP与GPT联合碰撞:大模型与小模型联合发力_gpt和nlp

- 6npm ERR! code EACCES npm ERR! syscall mkdir

- 7Keras Dense层详解

- 8快速搭建美团外卖(第三方)微信小程序(附精选源码32套,涵盖商城团购等)_外卖小程序源码

- 9CNN模型之VGGNet_%20%20vgcnnb

- 10【动手学深度学习-pytorch】8.5 循环神经网络的从零开始实现

当前位置: article > 正文

【Python+中文NLP】(一) NLTK库_nltk库主要用于处理什么

作者:小丑西瓜9 | 2024-03-24 09:32:56

赞

踩

nltk库主要用于处理什么

一、nltk库

nltk是一个python工具包, 用来处理与自然语言相关的东西. 包括分词(tokenize), 词性标注(POS), 文本分类等,是较为好用的现成工具。但是目前该工具包的分词模块,只支持英文分词,而不支持中文分词。

1.安装nltk库

在命令行输入:

- conda install nltk #anaconda环境

- pip install nltk #纯python环境

进入对应的环境中,输入如下:

- import nltk

- nltk.download()

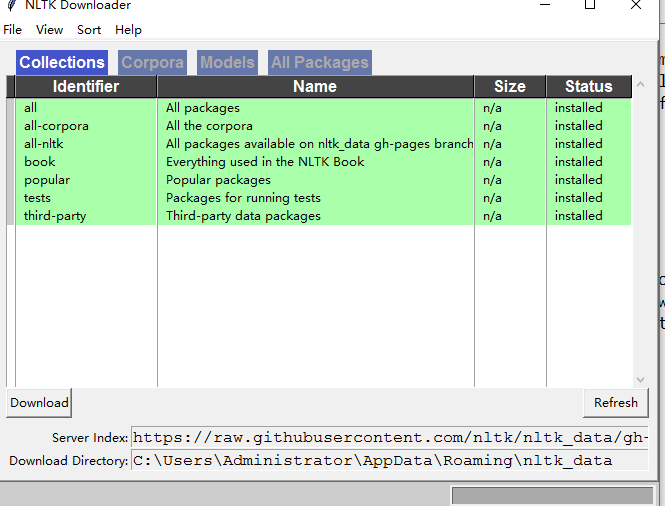

运行后,弹出NLTK Downloader窗口,自定义安装内容 (博主选择all ,即全部安装,大概3.2G左右) ,安装成功如下图所示:

2.nltk库的使用方法

(1)学习资料

【参考文章】

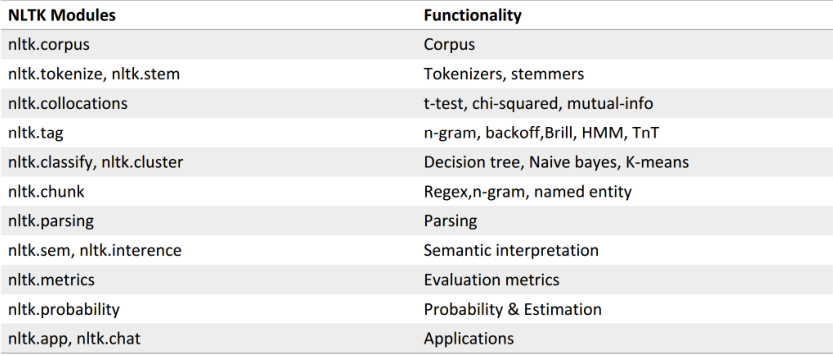

【nltk功能模块】如下图

推荐阅读

相关标签