热门标签

热门文章

- 1SteamVR---UI交互_steam vr ui 交互

- 2检查c#代码内存泄露工具-CLR Profiler_c# clr profiler

- 3如何在Linux下使用GPG(GnuPG)加密及解密_gungpg

- 4python从入门到精通第三版,python3.8从入门到精通pdf_python从入门到精通第三版pdf下载

- 5python常见相关组件汇总(个人学习)_python组件

- 6深度半监督学习方法总结

- 7【Unity】 2D贪吃豆开发流程_unity2d吃豆豆游戏向上碰撞物体,不能销毁

- 8jq用到的插件整理_jquery.superslide.2.1.1.min.js

- 9却话文心一言(Chatgpt们),存算一体真能突破AI算力“存储墙”|“能耗墙”|“编译墙”?_计算 存储墙

- 10正则表达式的一些高级用法

当前位置: article > 正文

作业合集-书生浦语大模型实战化训练营

作者:小小林熬夜学编程 | 2024-02-28 21:23:46

赞

踩

作业合集-书生浦语大模型实战化训练营

第二课作业-轻松玩转书生·浦语大模型趣味 Demo

基础作业:

- 使用 InternLM-Chat-7B 模型生成 300 字的小故事(需截图)。

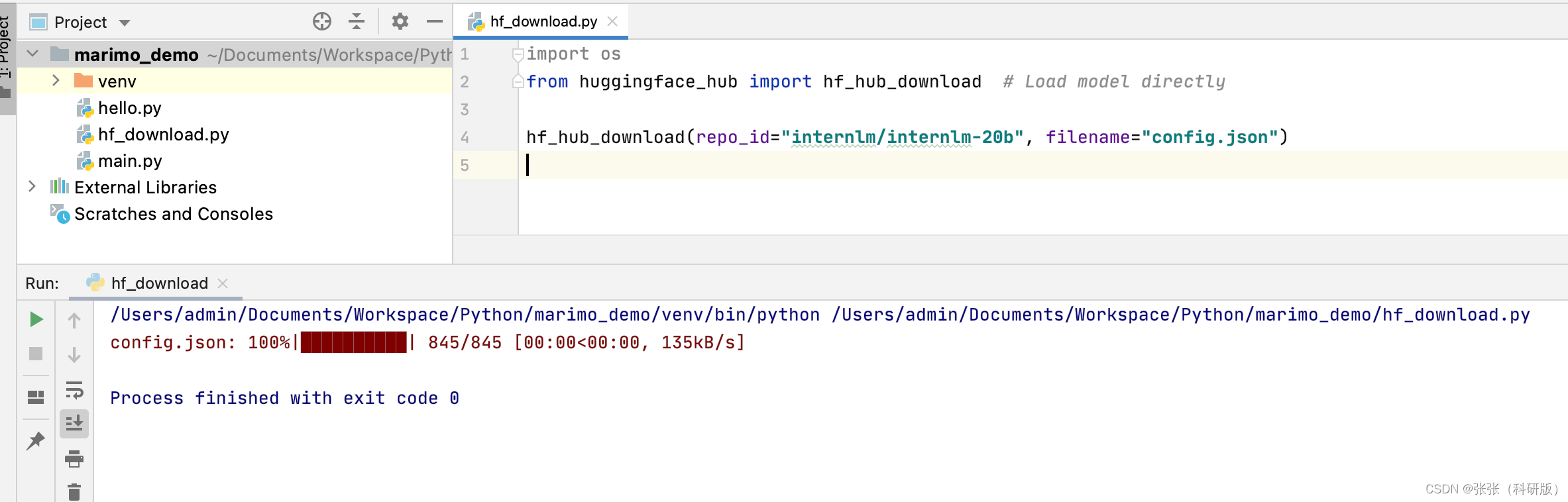

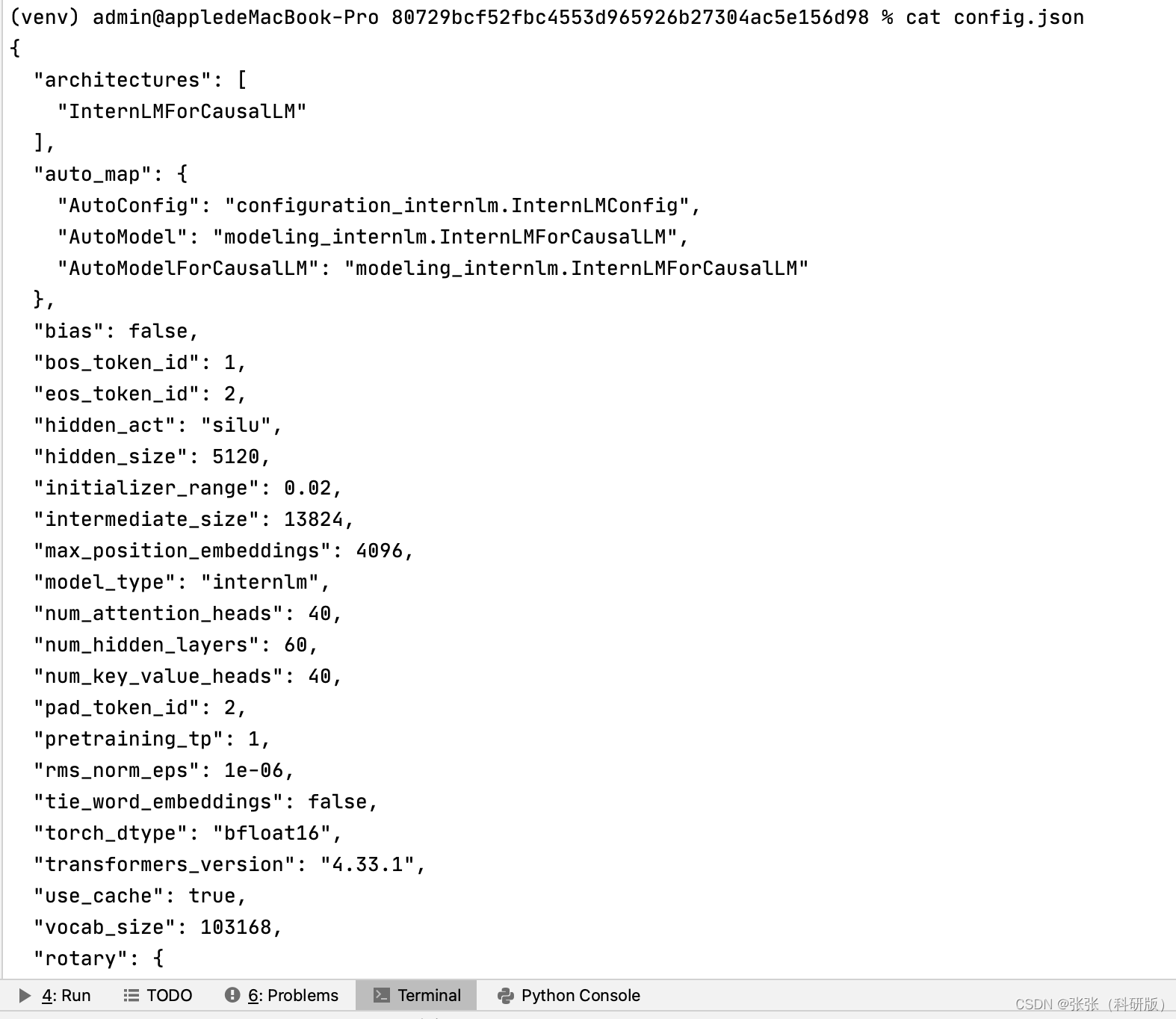

熟悉 hugging face 下载功能,使用 huggingface_hub python 包,下载 InternLM-20B 的 config.json 文件到本地(需截图下载过程)。

进阶作业(可选做)

- 完成浦语·灵笔的图文理解及创作部署(需截图)

- 完成 Lagent 工具调用 Demo 创作部署(需截图)

第三课作业-基于 InternLM 和 LangChain 搭建你的知识库

基础作业:

复现课程知识库助手搭建过程 (截图)

进阶作业:

选择一个垂直领域,收集该领域的专业资料构建专业知识库,并搭建专业问答助手,并在 OpenXLab 上成功部署(截图,并提供应用地址)

第四课作业-XTuner大模型单卡低成本微调实践

基础作业:

构建数据集,使用 XTuner 微调 InternLM-Chat-7B 模型, 让模型学习到它是你的智能小助手,效果如下图所示,本作业训练出来的模型的输出需要将不要葱姜蒜大佬替换成自己名字或昵称!

微调前

微调后

进阶作业:

- 将训练好的Adapter模型权重上传到 OpenXLab、Hugging Face 或者 MoelScope 任一一平台。

- 将训练好后的模型应用部署到 OpenXLab 平台,参考部署文档请访问

第五课作业-LMDeploy 的量化和部署

基础作业:

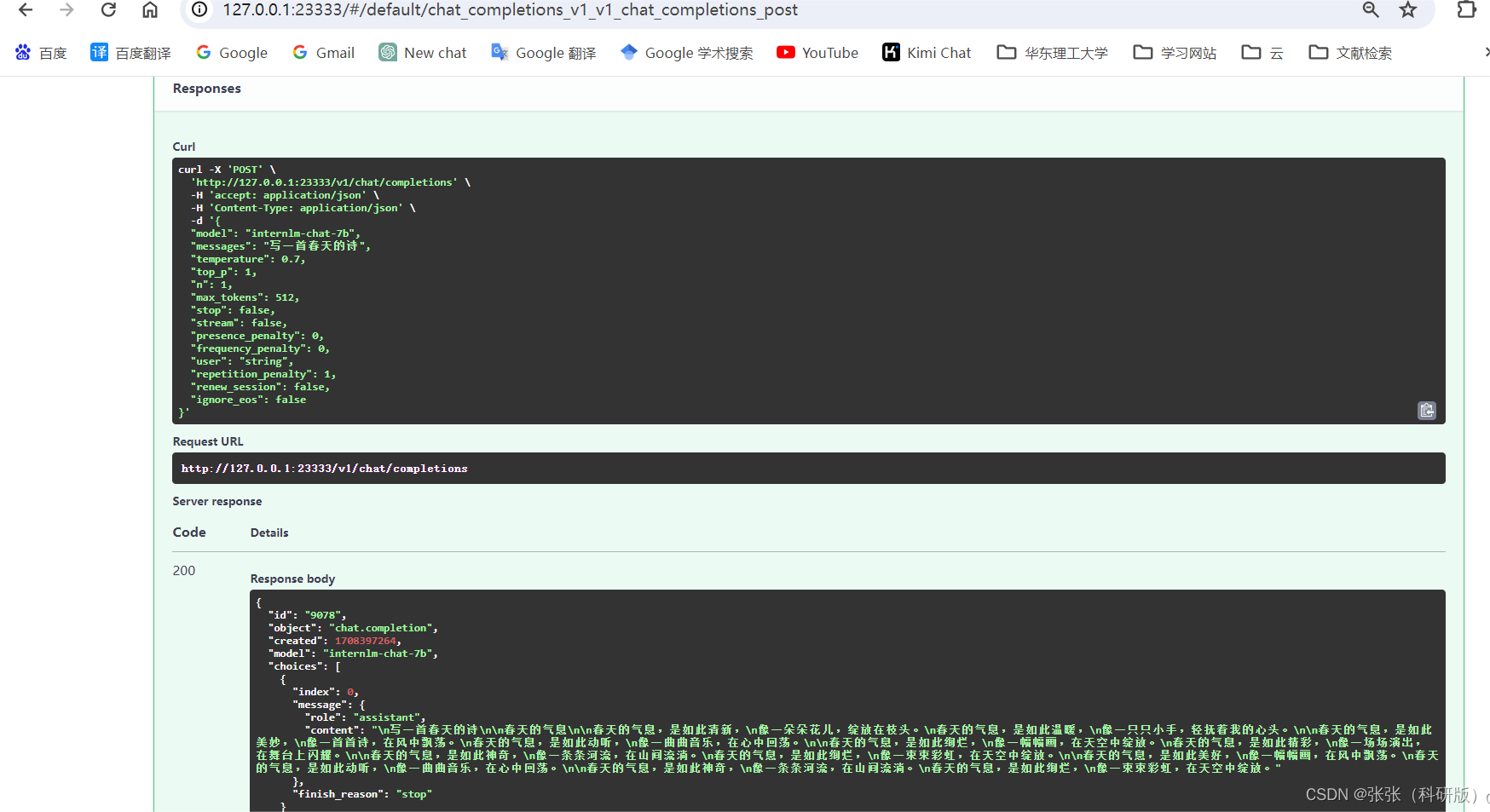

- 使用 LMDeploy 以本地对话、网页Gradio、API服务中的一种方式部署 InternLM-Chat-7B 模型,生成 300 字的小故事(需截图)

进阶作业(可选做)

- 将第四节课训练自我认知小助手模型使用 LMDeploy 量化部署到 OpenXLab 平台。

- 对internlm-chat-7b模型进行量化,并同时使用KV Cache量化,使用量化后的模型完成API服务的部署,分别对比模型量化前后(将 bs设置为 1 和 max len 设置为512)和 KV Cache 量化前后(将 bs设置为 8 和 max len 设置为2048)的显存大小。

- 在自己的任务数据集上任取若干条进行Benchmark测试,测试方向包括:

(1)TurboMind推理+Python代码集成

(2)在(1)的基础上采用W4A16量化

(3)在(1)的基础上开启KV Cache量化

(4)在(2)的基础上开启KV Cache量化

(5)使用Huggingface推理

第六课作业-opencompass大模型评测

基础作业

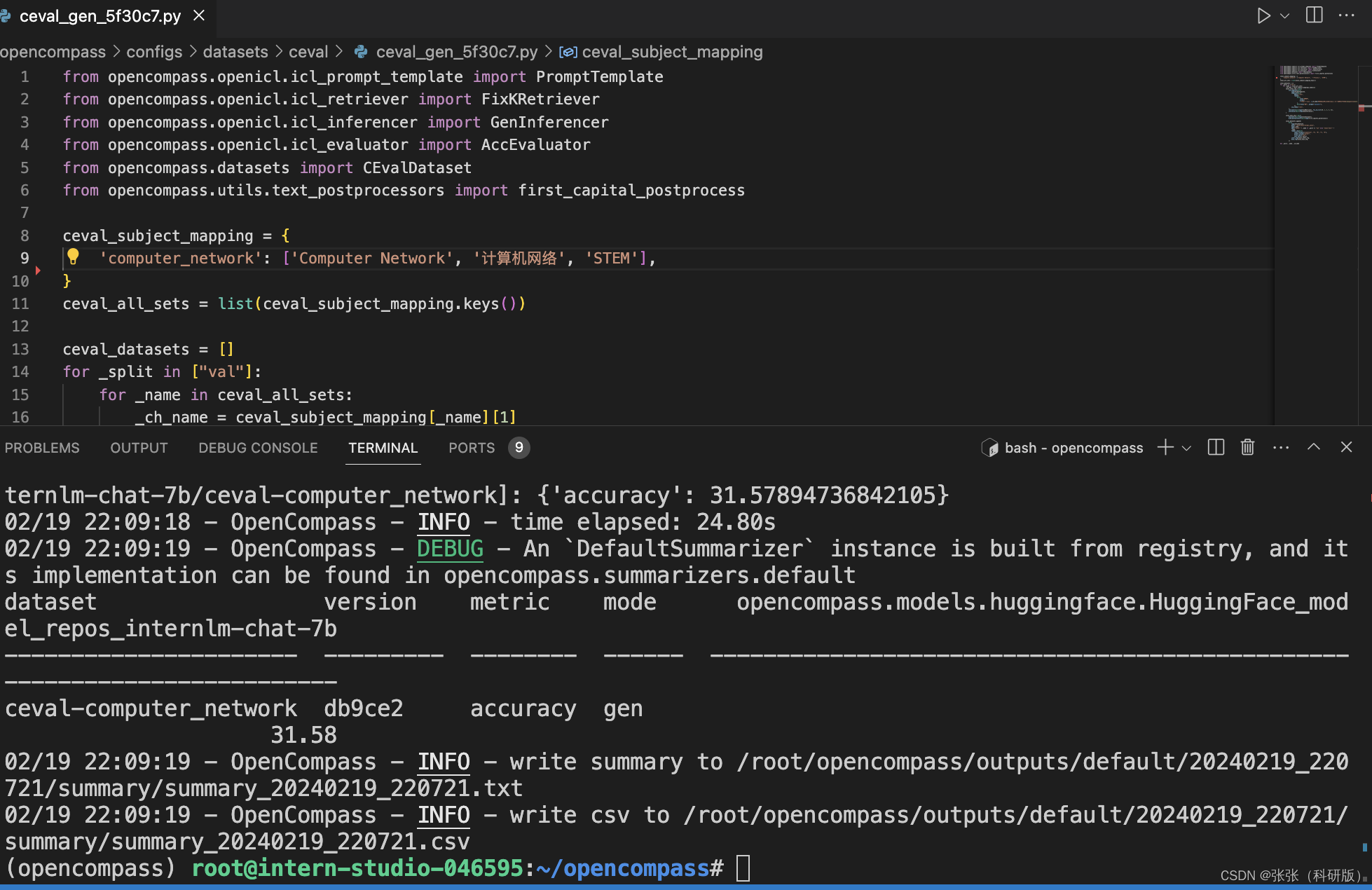

- 使用 OpenCompass 评测 InternLM2-Chat-7B 模型在 C-Eval 数据集上的性能

进阶作业

- 使用 OpenCompass 评测 InternLM2-Chat-7B 模型使用 LMDeploy 0.2.0 部署后在 C-Eval 数据集上的性能

声明:本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:【wpsshop博客】

推荐阅读

相关标签