热门标签

热门文章

- 1Cassandra的五种用例_cassandra数据库示例

- 2axios的基本使用_axios-0.21.0.js

- 3unity 制作行李箱密码_unity密码箱

- 4小程序和webview如何通信?_小程序和webview通信

- 5php轮播加载图片慢,打开网页时图片加载很慢怎么办?网页图片打开慢的解决方法...

- 6Xunity.autotranslator机翻unity引擎的游戏

- 7ajax实现翻书效果,jquery实现的翻书效果

- 8修改el-table表格单元格边框颜色_el-table border颜色

- 9QML的使用

- 10【数值预测案例】(5) LSTM 时间序列气温数据预测,附TensorFlow完整代码_lstm预测未来七天的数据

当前位置: article > 正文

BERT学习【BERT的例子以及作用】

作者:小小林熬夜学编程 | 2024-03-06 11:44:23

赞

踩

BERT学习【BERT的例子以及作用】

一、case

1.case1

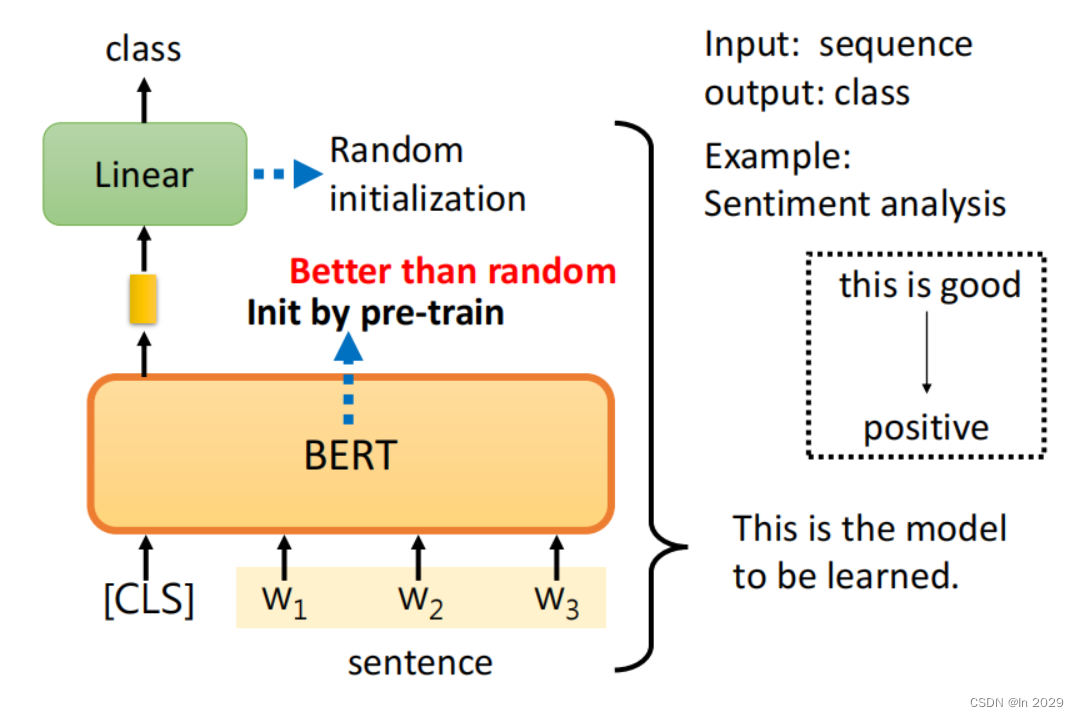

多输入单输出。通过输入一个句子(sequence),然后输出一个句子的分类(这个句子是正向还是负向)。将句子输入BERT,然后通过softmax输出分类。

2.case2

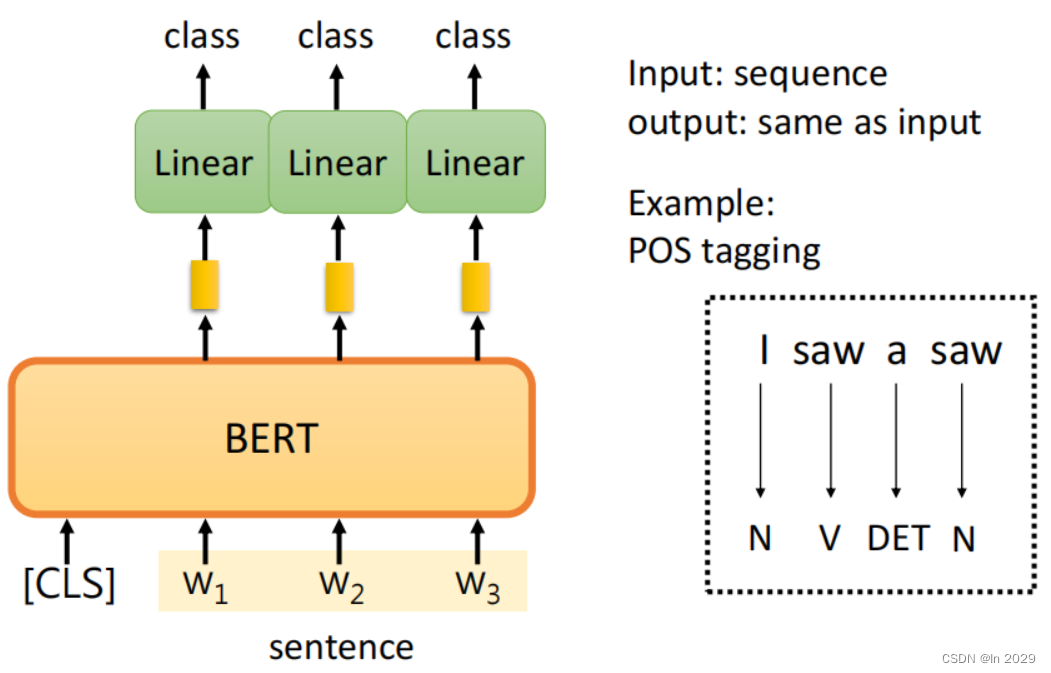

多输入多输出。输入一个句子,输出句子中每个单词的词性。每一个词对应一个向量,然后每一个向量分别做一个linear的transformer乘以矩阵,在经过softmax输出类别

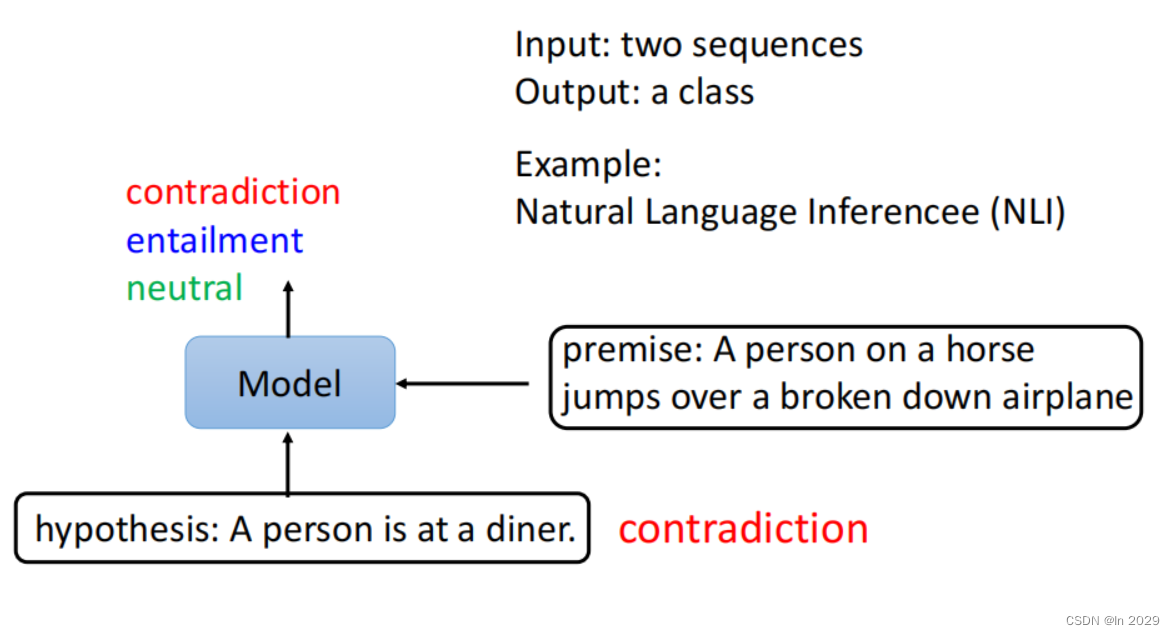

3.case3

多输入单输出。输入两个句子,输出这两个句子是否相关。

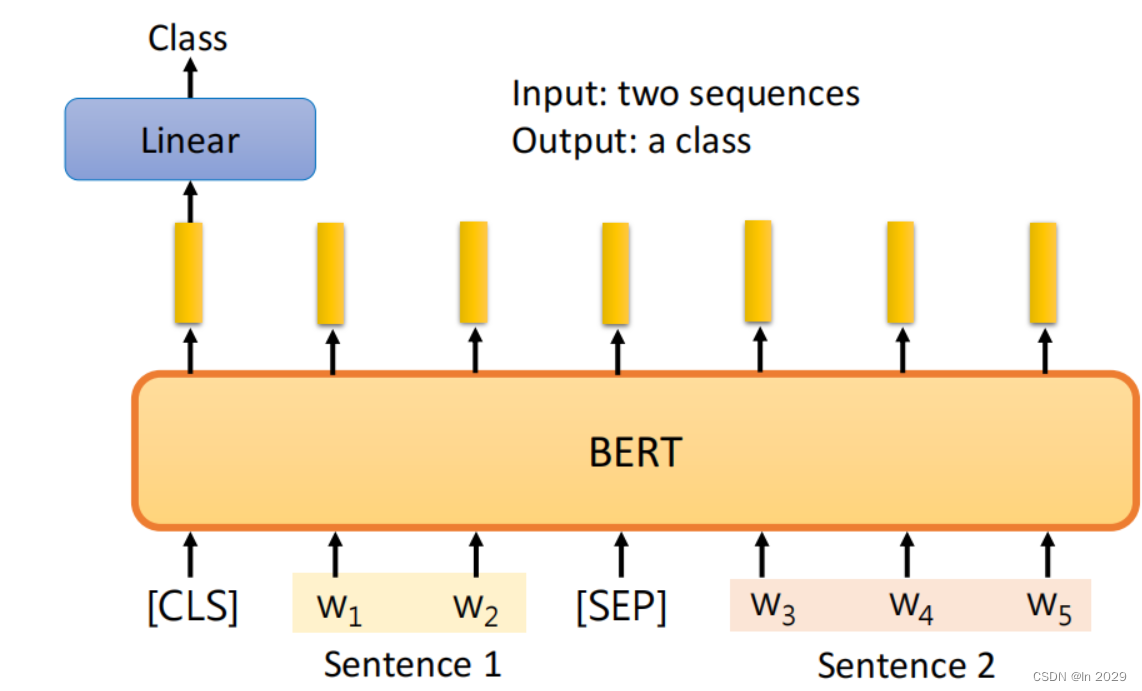

输入两个句子以及[SEP]和[CLS]到BERT中,然后在[CLS]对应位置,经过Lineartransformer,最后通过softmax输出分类。

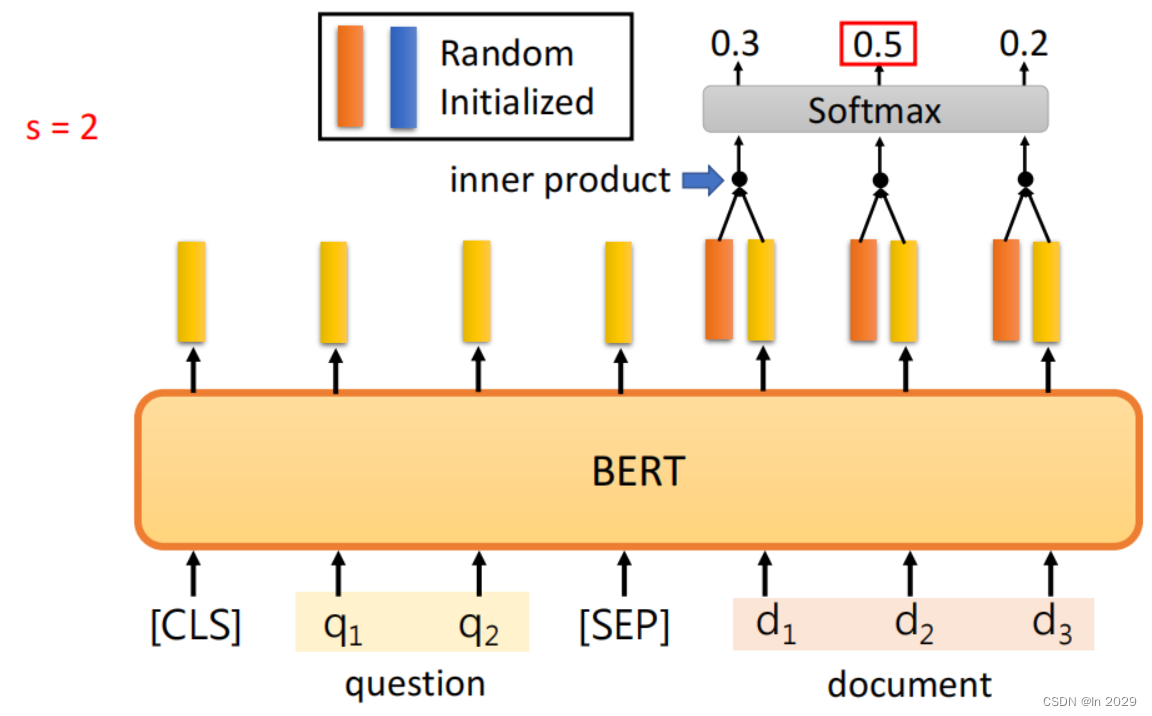

4.case4

多输入多输出。将问题和文章输入到BERT中,通过RandomInitialized,与输入内容对应的向量做内积,通过softmax输出,选择可能性最大的内容输出。

二、work作用

1.例子

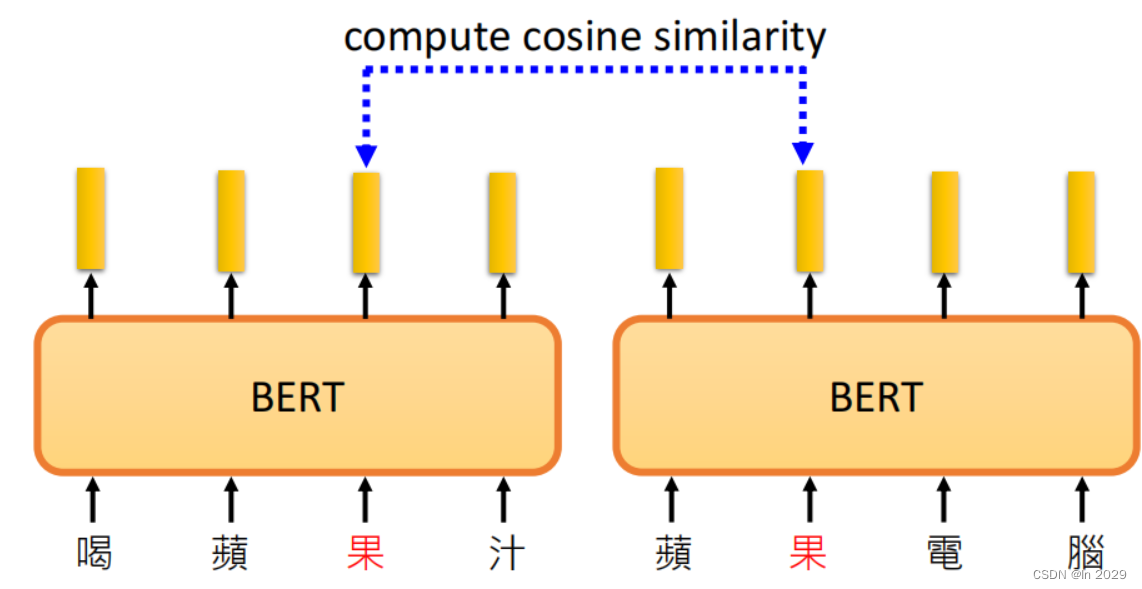

喝苹果汁的过和评估电脑的过是不一样的。因为将内容输入到BERT中,BERT是一个encoder,带有selfattention,会根据上下文的不同,果对应的向量也不同。

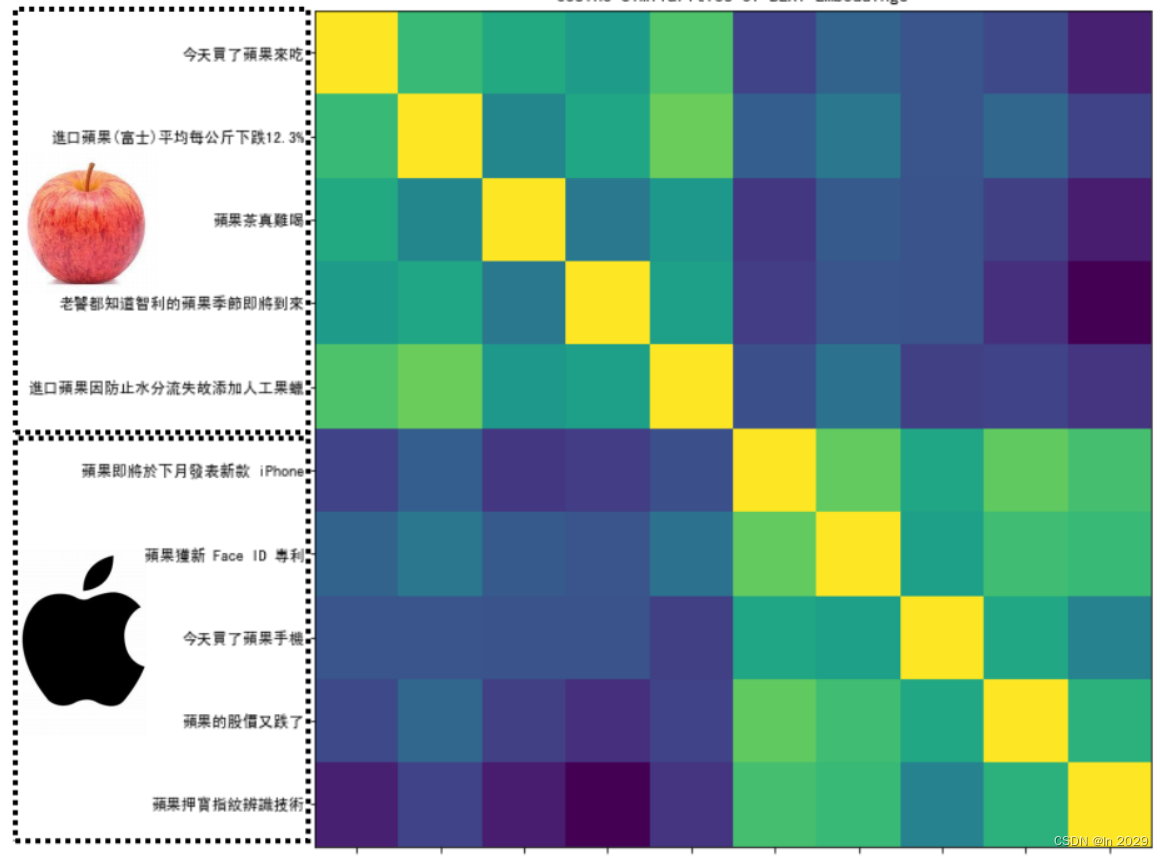

通过计算果的相似度,上面5句话是代表能吃的果,下面的5句话代表苹果公司,两两之间做相似度,形成一个10x10的矩阵。黄色代表相似度高,蓝色代表相似度低。

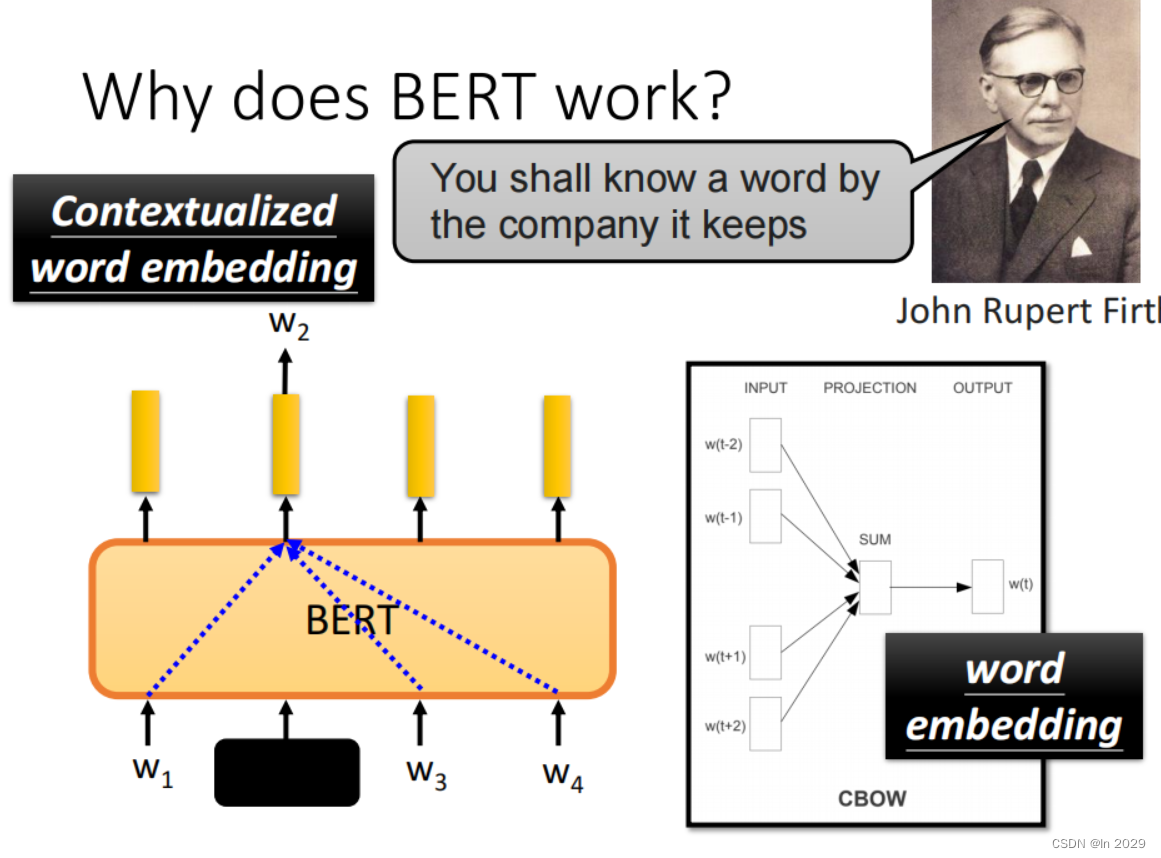

2.BERT根据上下文预测填空

BERT根据w2的上下文即w1、w3、w4,可以预测出w2的内容。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小小林熬夜学编程/article/detail/198525?site

推荐阅读

相关标签