- 1python中argsort_浅析python中numpy包中的argsort函数的使用

- 2PyCharm下载安装_pycharmxiazaianzhaung

- 3全屋智能,华为和小米的优劣势在哪?_华为智能 缺点

- 4编写ChatGPT指令(Prompt)的万能模板以及使用示例!_chagpt如何写propt

- 5【Linux】Linux下centos更换国内yum源_centos 6 yum更新源

- 6【数据结构】拓扑排序的实现_为什么拓扑排序中,可以使用栈或者队列来暂存度为0的顶点

- 7二叉树的先序、中序、后序以及层次遍历_先序遍历

- 8git:一、GIT介绍+安装+全局配置+基础操作_请确保本地完成了 git 的全局配置

- 9软件测试面试题_每天一道软件测试面试题系列 (六)_如何提交高质量的软件缺陷(Bug)记录,Web项目中的安全测试怎么测?

- 10python实现刷问卷星份数(面向对象)_问卷星python刷问卷

本地部署Llama3中文版并弱智吧测试

赞

踩

▼最近直播超级多,预约保你有收获

—1—

中文微调版 Llama 3

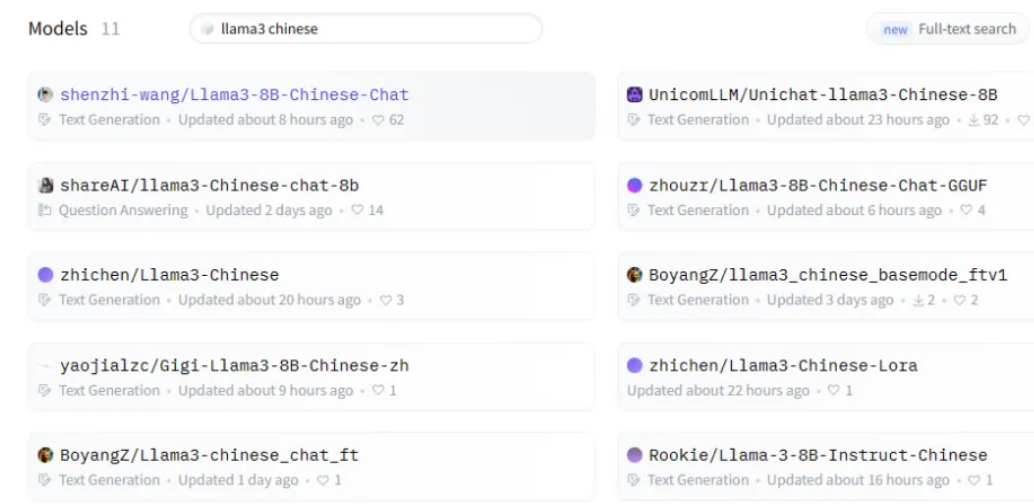

随着 Meta 发布 Llama 3 新一代最强劲开源大模型,在 Hugging Face 开源社区涌现了不少中文微调版 Llama 3,如下图所示:

同时,也整理下目前的中文版 Llama 3 大模型列表,如下图所示:

- 联通微调版:https://www.modelscope.cn/models/UnicomAI/Unichat-llama3-Chinese/summary

- Openbuddy微调版:https://www.modelscope.cn/models/OpenBuddy/openbuddy-llama3-8b-v21.1-8k/summary

- zhichen微调版:https://github.com/seanzhang-zhichen/llama3-chinese

- Rookie微调版:https://github.com/Rookie1019/Llama-3-8B-Instruct-Chinese

- shareAI-V1:https://opencsg.com/models/shareAI/llama3-Chinese-chat-8b

- shareAI-V2:https://modelscope.cn/models/baicai003/Llama3-Chinese_v2/summary

—2—

Ollama 部署中文微调版 Llama 3

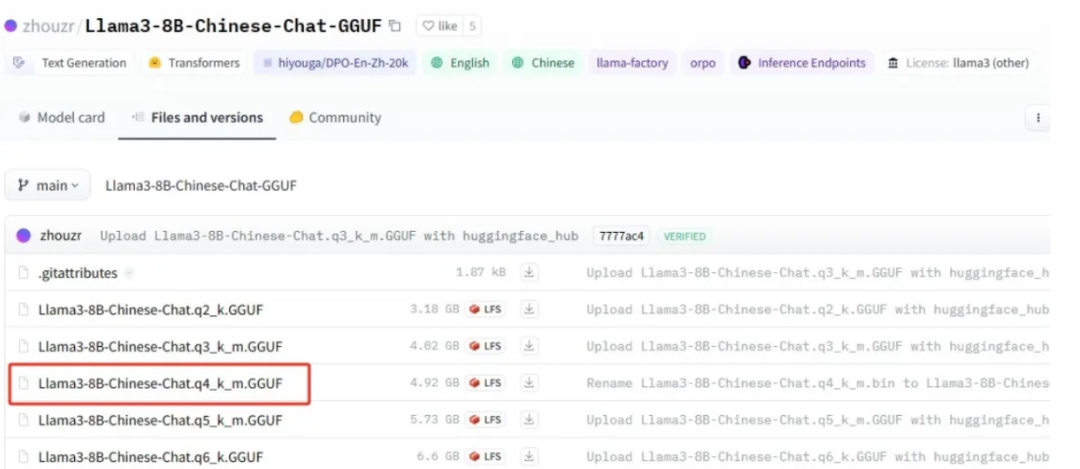

经过对比和测试,我们选择 Hugging Face社区的 zhouzr/Llama3-8B-Chinese-Chat-GGU F模型,推荐下载使用 q4_k_m 版本:

第一步、将下载的 GGUF 大模型上传到指定位置,编写 Modelfile。

- FROM ./Llama3-8B-Chinese-Chat.q4_k_m.GGUF

- TEMPLATE """{{ if .System }}<|start_header_id|>system<|end_header_id|>

- {{ .System }}<|eot_id|>{{ end }}{{ if .Prompt }}<|start_header_id|>user<|end_header_id|>

- {{ .Prompt }}<|eot_id|>{{ end }}<|start_header_id|>assistant<|end_header_id|>

- {{ .Response }}<|eot_id|>"""

- PARAMETER stop "<|start_header_id|>"

- PARAMETER stop "<|end_header_id|>"

- PARAMETER stop "<|eot_id|>"

- PARAMETER stop "<|reserved_special_token"

第二步、执行 ollama create llama3-Chinese:8B -f Modelfile 创建大模型。

- (base) [root@localhost my_model]# ollama create llama3-Chinese:8B -f Modelfile

- transferring model data

- creating model layer

- creating template layer

- creating parameters layer

- creating config layer

- using already created layer sha256:74db82a06a038230371e62740a9b430140e4df3a02c5ddcbe97c9bee76d6455e

- writing layer sha256:8ab4849b038cf0abc5b1c9b8ee1443dca6b93a045c2272180d985126eb40bf6f

- writing layer sha256:c0aac7c7f00d8a81a8ef397cd78664957fbe0e09f87b08bc7afa8d627a8da87f

- writing layer sha256:109fb4827ddd6f21dd04a405dec5e1c9e39cf139e89b98536875a782938c02f5

- writing manifest

- success

第三步、执行 ollama list 查看,已成功运行。

- (base) [root@localhost my_model]# ollama list

- NAME ID SIZE MODIFIED

- llama3-Chinese:8B e45ad8ada59e 4.9 GB 33 seconds ago

- qwen:14b-chat-v1.5-q5_K_M ba0e61d66b27 10 GB 6 weeks ago

—3—

测试中文微调版 Llama 3

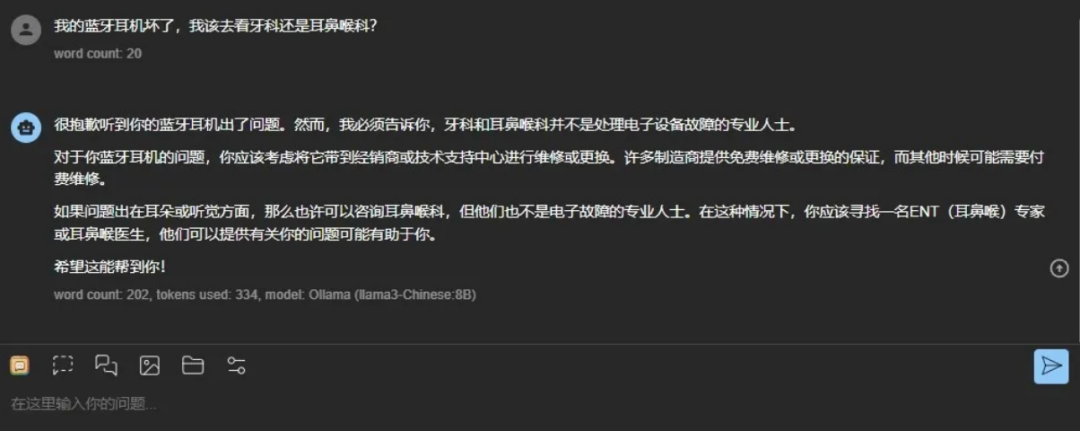

第一、弱智吧问题测试

第二、代码能力测试

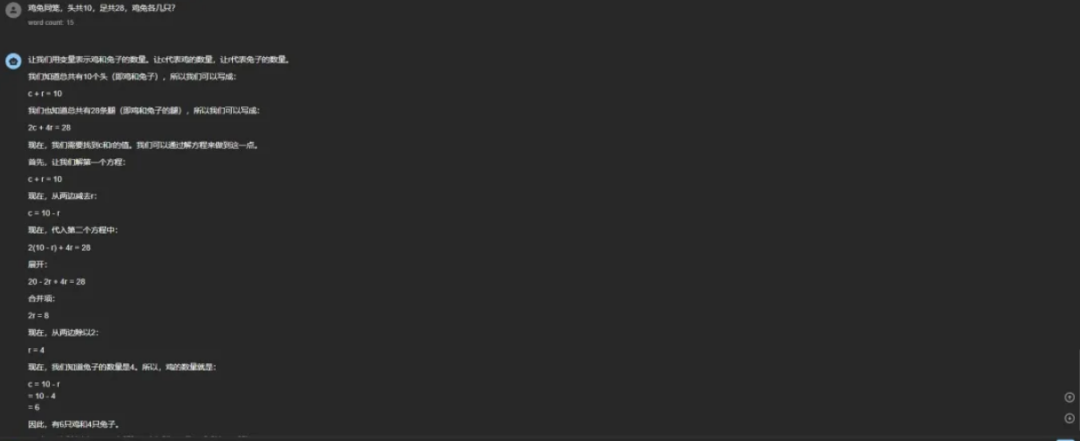

第三、数学能力测试

可以看到,Llama 3 微调版的确强大,推荐大家使用起来!

参考:https://mp.weixin.qq.com/s/v6K61fTzaMLS1-wKCHoNWw

为了帮助同学们彻底掌握大模型 Agent 智能体、知识库、向量数据库、 RAG、知识图谱的应用开发、部署、生产化,今天我会开4场直播和同学们深度剖析,请同学们点击以下预约按钮免费预约。

—4—

AI大模型开发技能直播课程

大模型的技术体系非常复杂,即使有了知识图谱和学习路线后,快速掌握并不容易,我们打造了大模型应用技术的系列直播课程,包括:通用大模型技术架构原理、大模型 Agent 应用开发、企业私有大模型开发、向量数据库、大模型应用治理、大模型应用行业落地案例等6项核心技能,帮助同学们快速掌握 AI 大模型的技能。

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。