虚拟人主播的诞生:技术原理与未来前景

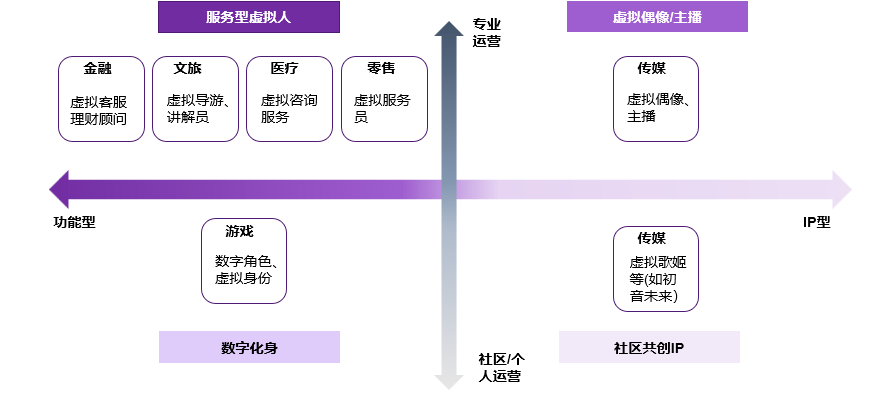

随着人工智能技术的迅猛发展,虚拟人主播(Virtual Influencer)作为AIGC(Artificial Intelligence Generated Content)的一个重要应用,正逐渐走入大众视野。虚拟人主播不仅在娱乐和广告行业引发了巨大反响,还在教育、医疗等领域展现出广泛的应用前景。本文将探讨虚拟人主播的技术原理,并展望其未来发展前景。

虚拟人主播的技术原理

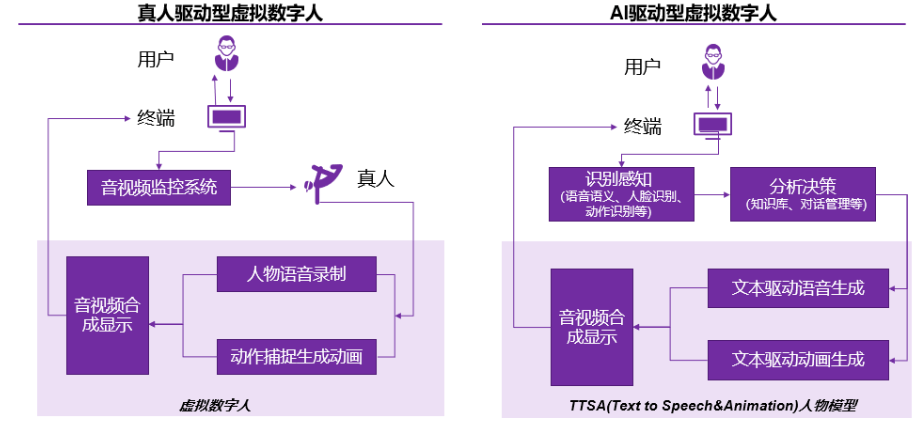

虚拟人主播的核心技术涉及以下几个方面:

- 计算机视觉:用于捕捉和处理虚拟人的外观和表情。

- 自然语言处理(NLP):用于生成和理解虚拟人主播的语音和文本内容。

- 语音合成:用于生成逼真的虚拟人语音。

- 动作捕捉和动画生成:用于生成虚拟人的动态表现。

计算机视觉

计算机视觉技术在虚拟人主播的生成过程中起到了关键作用。通过3D建模和动画技术,可以创建出栩栩如生的虚拟人形象。以下是一个简单的3D建模示例,使用Python和Open3D库:

自然语言处理(NLP)

NLP技术使得虚拟人主播能够生成和理解自然语言文本。以下是一个使用Transformers库进行文本生成的示例:

语音合成

语音合成技术使得虚拟人主播能够生成自然流畅的语音。以下是一个使用Google Text-to-Speech (gTTS)库进行语音合成的示例:

动作捕捉和动画生成

动作捕捉技术用于捕捉真人的动作,并将其映射到虚拟人上,从而生成逼真的动画效果。以下是一个使用Blender进行简单动画生成的Python示例:

虚拟人主播的未来前景

商业应用

虚拟人主播在商业领域的应用前景广阔。通过虚拟人主播,企业可以实现24/7的客户服务,提供个性化的广告推广,并在社交媒体上吸引大量粉丝。例如,虚拟人主播可以实时生成产品推荐视频,解答客户疑问,甚至举办虚拟发布会。

教育与培训

在教育和培训领域,虚拟人主播可以作为虚拟导师,为学生提供个性化的辅导和教学内容。虚拟人主播可以实时生成教学视频,解答学生问题,并根据学生的学习进度调整教学策略。此外,虚拟人主播还可以用于职业培训,提供模拟面试和技能训练。

医疗健康

在医疗健康领域,虚拟人主播可以作为虚拟医生,为患者提供健康咨询和疾病预防建议。虚拟人主播可以实时生成健康指导视频,解答患者问题,并根据患者的健康状况提供个性化的建议。例如,虚拟人主播可以为患者提供饮食建议、运动指导,甚至心理咨询。

社交媒体与娱乐

虚拟人主播在社交媒体和娱乐领域的应用也非常广泛。虚拟人主播可以作为虚拟偶像,吸引大量粉丝,并通过直播、短视频等形式与粉丝互动。虚拟人主播可以实时生成娱乐内容,解答粉丝问题,并通过虚拟演出、虚拟综艺节目等形式提供娱乐服务。

虚拟人主播的技术挑战与解决方案

尽管虚拟人主播展示了广阔的应用前景,但在实际开发和应用中仍面临诸多技术挑战。以下是一些主要的技术挑战及其解决方案:

1. 真实感与逼真度

挑战:为了使虚拟人主播更加逼真,必须解决外观、动作和表情的真实感问题。这包括高质量的3D建模、精细的动作捕捉和自然的表情生成。

解决方案:结合深度学习和计算机图形学技术,可以生成更加逼真的虚拟人形象。例如,GAN(生成对抗网络)可以用于生成高质量的虚拟人脸,神经网络可以用于生成自然的表情和动作。

以下是一个使用StyleGAN生成虚拟人脸的示例代码:

2. 自然语言理解与生成

挑战:虚拟人主播需要理解用户输入的自然语言并生成恰当的回应,这涉及到复杂的语义理解和上下文分析。

解决方案:利用预训练的语言模型,如GPT-3,可以显著提升虚拟人主播的语言理解和生成能力。结合对话管理系统,可以实现更加自然和流畅的互动。

以下是一个使用GPT-3生成对话的示例代码:

3. 语音合成与语音识别

挑战:生成自然流畅的语音,以及准确识别用户的语音输入,是实现虚拟人主播自然对话的关键。

解决方案:使用深度学习技术,可以显著提升语音合成和语音识别的性能。例如,使用WaveNet或Tacotron2模型可以生成高质量的语音,而使用预训练的ASR(Automatic Speech Recognition)模型可以实现高精度的语音识别。

以下是一个使用Tacotron2和WaveNet进行语音合成的示例代码:

4. 实时性与性能优化

挑战:为了实现实时互动,虚拟人主播需要在短时间内完成图像生成、语音合成和文本处理等任务,这对计算资源和性能提出了较高要求。

解决方案:利用高效的模型推理框架(如ONNX、TensorRT),以及分布式计算和云服务,可以显著提升虚拟人主播的实时性能。此外,针对特定任务进行模型压缩和优化(如量化、剪枝)也可以有效提高模型的推理速度。

以下是一个使用ONNX进行模型优化和推理的示例代码:

未来前景

更加个性化和智能化的虚拟人主播

随着深度学习和数据驱动方法的不断进步,未来的虚拟人主播将变得更加个性化和智能化。通过对用户行为数据的分析,虚拟人主播可以提供更加个性化的内容和服务,实现真正的智能互动。

多模态互动

未来的虚拟人主播将不仅限于语音和文本的互动,还将结合图像、视频和虚拟现实等多种模态,实现更加丰富和逼真的互动体验。例如,虚拟人主播可以在虚拟现实环境中与用户进行互动,提供身临其境的体验。

广泛应用于各行各业

随着技术的成熟和成本的降低,虚拟人主播将广泛应用于各行各业。例如,在金融领域,虚拟人主播可以作为虚拟金融顾问,为用户提供投资建议和风险管理;在旅游领域,虚拟人主播可以作为虚拟导游,为用户提供个性化的旅游攻略和体验。

人机协作的新模式

虚拟人主播不仅可以独立工作,还可以与真人主播协作,形成“人机协作”的新模式。通过虚拟人主播和真人主播的协同工作,可以实现更加高效和丰富的内容生产和服务提供。例如,在新闻领域,虚拟人主播可以实时生成新闻内容,真人主播可以进行深度解读和分析。

总结

虚拟人主播作为AIGC(人工智能生成内容)的重要应用,展示了人工智能在内容生成领域的巨大潜力。本文通过介绍虚拟人主播的技术原理、实际应用、技术挑战、伦理与社会影响以及未来前景,全面分析了虚拟人主播这一创新技术。

技术原理

虚拟人主播依赖计算机视觉、自然语言处理、语音合成和动作捕捉等技术。这些技术协同工作,使虚拟人主播不仅能生成逼真的虚拟形象,还能进行自然流畅的互动。

实际应用

虚拟人主播已在新闻播报、直播带货、教育培训和客户服务等多个领域展现出广泛的应用前景。通过高效和个性化的服务,虚拟人主播可以大幅提升用户体验和服务质量。

技术挑战

尽管虚拟人主播技术进步显著,但仍面临真实感与逼真度、自然语言理解与生成、语音合成与语音识别以及实时性与性能优化等技术挑战。通过结合深度学习和高效计算框架,这些挑战正在逐步解决。

伦理与社会影响

虚拟人主播技术带来了隐私和数据安全、虚拟与现实的界限、职业替代与就业问题以及文化和价值观影响等伦理和社会问题。企业责任和政府监管在确保技术安全性和透明度方面至关重要,同时需要加强公众教育,提高用户的辨识能力和使用素养。

未来前景

虚拟人主播的未来研究方向包括多模态交互、个性化和智能化、伦理与法律以及社会影响与对策。随着技术的不断进步和应用场景的拓展,虚拟人主播将成为日常生活和各行各业的重要组成部分。

总之,虚拟人主播在提升用户体验和服务效率方面具有巨大潜力,但也需重视其带来的伦理和社会挑战。通过技术创新、规范发展和公众教育,虚拟人主播将为我们带来更加智能和便利的未来。

希望这篇总结能够帮助您更好地理解虚拟人主播技术及其应用前景。如果需要进一步的讨论或补充,请随时告知。