- 1pytest使用详解

- 2Docker Compose部署Mongodb教程-单机_docker compose mongodb

- 3上班的时候我用多模态大模型openui将组内所有前端代码重新生成一遍,同事们晚上聚餐没叫我_大模型 生成前端代码

- 4hbase伪分布式安装_hbase启动没有hquorumpeer模块

- 5css实现多行文本的展开收起

- 6基于SpringBoot+Vue的农产品直卖商城系统(附开题报告)_基于springboot的便民农产品

- 7AI国际顶会ICLR 2024结果揭晓,蚂蚁集团11篇论文入选_icml2024流程

- 8php教程--案例22(用户头像上传)

- 9Unity Android通过拍照和相册上传头像(图片)_unity 使用安卓设备的相机拍照

- 10Flutter Android 混合开发实战-集成与调用_java调用flutter

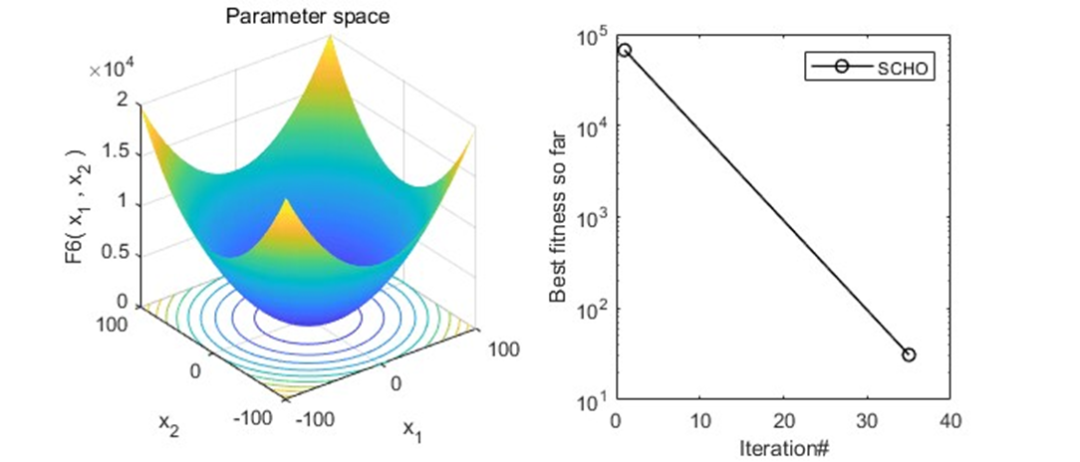

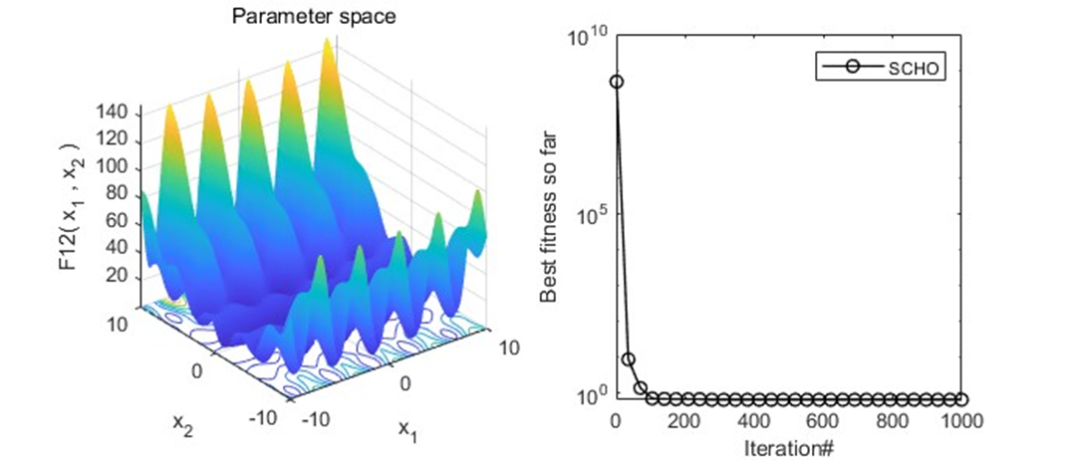

2023年智能算法之双曲正弦余弦优化器(SCHO),原理公式详解,附matlab代码

赞

踩

双曲正弦余弦优化器(Sinh Cosh Optimizer,SCHO)是一种新型元启发式算法,该算法基于双曲正弦和双曲余弦特性的数学启发,具有进化能力强、搜索速度快、寻优能力强的特点。该成果于2023年10月发表在SCI一区,Top顶刊Knowledge-Based Systems上。

SCHO的灵感来源有三点。首先,如何在勘探和开发之间取得平衡是一个巨大的挑战,其次,面对复杂多样的问题,仍需要提出新的元启发式算法。最后,基于数学启发的优化算法的提出,如sin、cos算法和算术优化算法(AOA),为研究元启发式算法指明了一个新的可能方向。双曲函数是三角函数中常见的一类,其中sinh和cosh是最基本的双曲函数。元启发式算法可以利用cosh和sinh的两个特性。一是cosh值总是大于1,这是勘探与开发的关键边界,另一种是sinh值在[−1,1]区间内,且接近于零,可以提高勘探开发效率。

算法原理

(1)初始化阶段

与其他元启发式算法一样,SCHO也从随机初始化一组候选解开始。初始化的候选解的数学公式如下所示: 其中X是由以下公式得到的随机候选解集合, 表示第i个解的第j个位置,N表示候选解的个数,dim为问题维数。 其中rand表示[0,1]中的随机值,ub和lb分别为变量的上界和下界。

(2)勘探阶段

在本研究中,探索下一个位置仍然与它的位置有关,并得到了迄今为止的最优解。在优化过程中,探索分为两个阶段,应该存在于以后的迭代中,以逃避局部最优。在这两个阶段之间切换的值通过以下数学公式: 其中Max迭代表示迭代的最大值,floor是MATLAB中向下舍入的函数,ct是用于设置两相切换点的系数。在第一阶段中,在早期的迭代中,搜索代理位置附近的搜索空间外部将被探索,然后搜索代理将逐渐接近获得的最佳解。第一阶段勘探位置更新函数的数学公式如下所示: 其中t表示当前迭代, 、 分别表示第i个解在当前迭代和下次迭代中的第j个位置; 为到目前为止得到的最优解的第j个位置,r1,r2为区间[0,1]内的随机数; 为第一勘探阶段 的权重系数,控制第一阶段候选解远离自身,逐渐向最优解探索,通过以下公式计算得到。 其中 为单调递减函数,由以下公式计算, 和 为[0,1]中的随机数; 是控制第一阶段勘探精度的敏感系数,固定为0.388; 从一个很小的值逐渐减小,这说明了自身位置对于位置更新的重要性,因此,候选解在第一阶段逐渐远离自己,然后寻找最优解。其中 为控制勘探精度的敏感系数,根据本案例实验,其值为0.45。 在第二阶段的探索中,搜索代理几乎不受最佳解的影响,因此它们基于当前位置进行无方向性的探索。其位置更新函数的数学公式如下所示: 其中,ε是一个极小的正数,根据本文实验,ε为0.003。W2为第二勘探阶段最佳的 的权重系数, 乘以ε大大削弱了最优解对当前解的影响,从而导致对 周围的候选解进行无向随机勘探,W2由以下公式计算得到: 其中r6为[0,1]中的随机数,a2为用以下公式计算得到的单谐递减函数: 式中,n为控制第二阶段勘探精度的敏感系数,根据本文实验,取值为0.5。

(3)开发阶段

为了充分利用搜索空间,开发分为两个阶段,在整个迭代过程中进行。在第一个开发阶段,开发了X的邻近空间,因此开发公式如下表示: 其中 , 属于区间[0,1]中的随机数。 是第一阶段开发的权重系数,它控制候选解从近到远地开发其周围的搜索空间,其数学公式如下所示: 其中 , 是[0,1]中的随机数,a1已由上面公式定义,u与第一勘探阶段相同,固定为0.388。

在开发的第二阶段,候选解将围绕迄今为止获得的最优解进行深度开发,并且围绕最优解的开发强度将随着迭代次数的增加而增加。位置更新函数如下所示: 其中 、 是区间[0,1]中的随机数, 控制第二开发阶段的程度,它的绝对值在后面的迭代中逐渐增加,增加了开发程度。方程中绝对值前面的系数用于保持候选解的多样性。

(4)有界搜索策略

为了充分利用潜在的搜索空间,在SCHO中采用了一种类似于后期动物狩猎的策略,称为有界搜索策略。通过在早期迭代中探索整个搜索区域,可以找到潜在的搜索空间。为了充分挖掘和利用潜力空间,首先将所有候选解随机初始化到该潜力空间中,然后对该空间进行深度挖掘和利用。该策略的每一开始都是通过以下公式计算: 其中k是从1开始的正整数, 由以下公式计算, 分别表示开始当前和下一个有界搜索策略的迭代次数。α是一个敏感系数,它控制着潜空间深部勘探开发的精度,本实验通过实验将α取为4.6。 其中β控制启动有界搜索策略的值,并设置为1.55。当SCHO每次都使用有界搜索策略时,优化问题的上界和下界将使用以下公式计算:

其中 和 表示潜在搜索空间的上界和下界, 表示次优解的第 个位置。

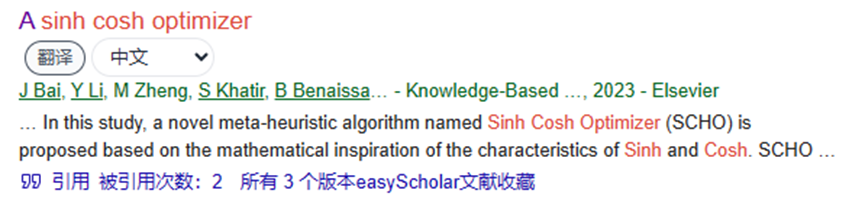

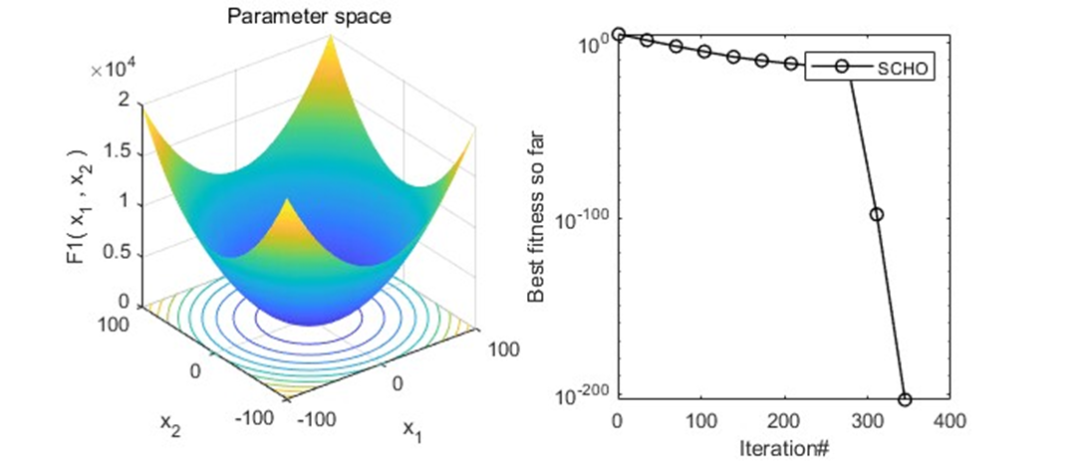

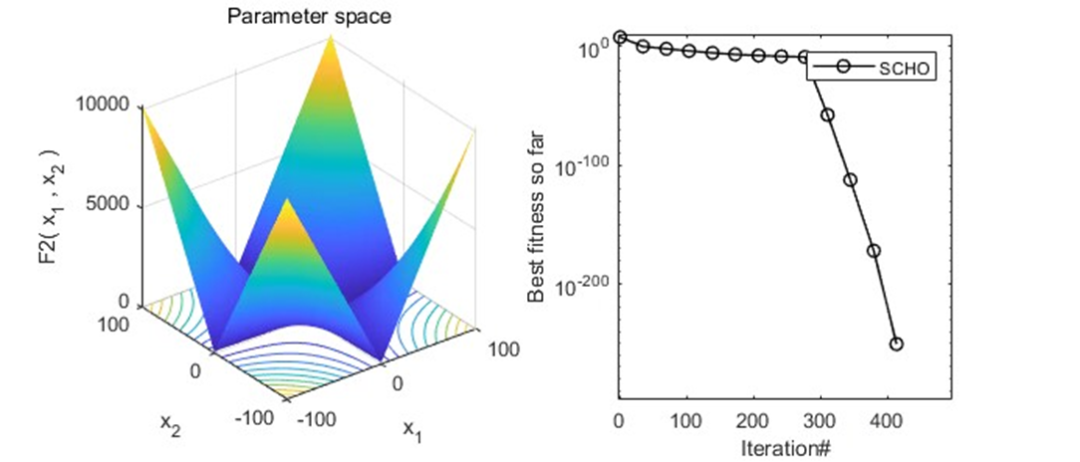

结果展示

以为CEC2005函数集为例,进行结果展示:

MATLAB核心代码

参考文献

[1] Bai J, Li Y, Zheng M, et al. A sinh cosh optimizer[J]. Knowledge-Based Systems, 2023, 282: 111081.

完整代码获取方式:后台回复关键字:

TGDM101