- 1Linux网站搭建(nginx+php+mysql)_nginx php

- 2SQL中的条件语句WHEN-THEN-ELSE_sql when

- 3ESP32 E (10309) task_wdt: Task watchdog got triggered. The following tasks did not reset the watchdo

- 4免费的爬虫软件【2024最新】

- 5Java关键字_java的关键字

- 6Python并发编程:多线程与多进程实践_python并发适合多线程还是多进程

- 7S2 算法学习之FFT 初识2_s2算法

- 8linux怎么用命令设置日期,Linux系统教程_怎样用命令行更改Linux系统的日期和时间?...

- 9前端React项目的Next.js项目通过CSS引入自定义字体文件_nextjs 字体打包后找不到

- 10curl -Ss http://www.workerman.net/check.php | PHP

对FedAvg中模型聚合过程的理解_fedavg公式

赞

踩

问题

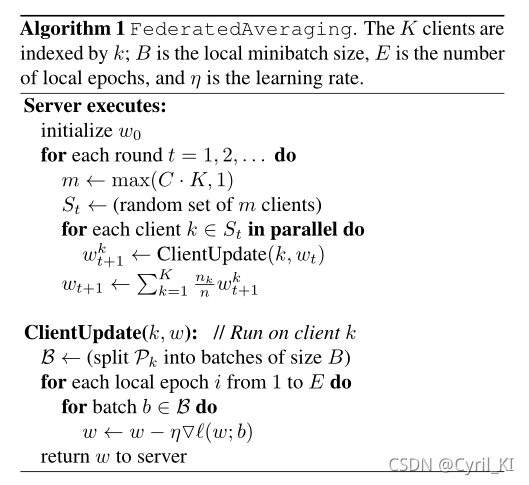

联邦学习原始论文中给出的FedAvg的算法框架为:

参数介绍:

K

K

K表示客户端的个数,

B

B

B表示每一次本地更新时的数据量,

E

E

E表示本地更新的次数,

η

\eta

η表示学习率。

首先是服务器执行以下步骤:

- 初始化参数。

- 对每一轮通信来说:首先计算出 m = m a x ( C ⋅ K , 1 ) m=max(C \cdot K, 1) m=max(C⋅K,1),然后随机选择m个客户端,对这m个客户端做如下操作(所有客户端并行执行):更新本地的 w t k w_t^{k} wtk得到 w t + 1 k w_{t+1}^{k} wt+1k。所有客户端更新结束后,将 w t + 1 k w_{t+1}^{k} wt+1k传到服务器,服务器整合所有 w t + 1 k w_{t+1}^{k} wt+1k得到最新的全局参数 w t + 1 w_{t+1} wt+1。

对每一个本地客户端来说,要做的就是更新本地参数,具体来讲:

- 把自己的数据集按照参数B分成若干个块,每一块大小都为B。

- 对每一块数据,需要进行E轮更新:算出该块数据损失的梯度,然后进行梯度下降更新,得到新的本地 w w w。

- 更新完后 w w w将被传送到中央服务器,服务器整合所有客户端计算出的 w w w,得到最新的全局模型参数 w t + 1 w_{t+1} wt+1

- 客户端收到服务器发送的最新全局参数模型参数,进行下一次更新。

我们仔细观察server的最后一步:

w

t

+

1

=

∑

k

=

1

K

n

k

n

w

t

+

1

k

w_{t+1}=\sum_{k=1}^{K}\frac{n_k}{n}w_{t+1}^k

wt+1=k=1∑Knnkwt+1k

也就是说,虽然我们只是对

m

m

m个客户端进行本地训练更新得到了其对应的

w

t

+

1

k

w_{t+1}^k

wt+1k,但最终我们却对所有

K

K

K个客户端进行了聚合。

聚合

那么针对聚合,就有以下两种情况。

1. 聚合所有客户端

服务器端每次将新的全局模型发送给全部客户端,并且聚合全部客户端的模型参数。如果客户端未被选中,那么一轮通信结束后,该客户端的模型为一轮通信开始时从服务器获得的初始模型。

设当前全局模型为

w

t

w_t

wt,服务器选中了

m

m

m个客户端(集合

V

V

V),

m

m

m个客户端本地更新完毕后,服务器端的聚合公式为:

w

t

+

1

=

∑

k

∈

V

n

k

n

w

t

+

1

k

+

∑

k

∉

V

n

k

n

w

t

w_{t+1}=\sum_{k \in V}\frac{n_k}{n}w_{t+1}^k+\sum_{k\notin V}\frac{n_k}{n}w_t

wt+1=k∈V∑nnkwt+1k+k∈/V∑nnkwt

也就是说,每一次聚合时服务器端都将所有客户端的模型考虑在内。

2. 仅聚合被选中的客户端

服务器每次只是将当前新的参数传递给被选中的模型,并且只是聚合被选中客户端的模型参数。

设当前全局模型为

w

t

w_t

wt,服务器选中了

m

m

m个客户端(集合

V

V

V),然后将

w

t

w_t

wt只发送给这

m

m

m个客户端。

m

m

m个客户端训练完毕后,服务器端的聚合公式为:

w

t

+

1

=

∑

k

∈

V

n

k

n

w

t

+

1

k

w_{t+1}=\sum_{k \in V}\frac{n_k}{n}w_{t+1}^k

wt+1=k∈V∑nnkwt+1k

3. 选择

虽然原始论文中对所有 K K K个客户端都进行了聚合,但在真正实现时,感觉用第二种会更好一点,因为如果客户端数量很庞大,每一次通信都会有不小的代价,用第二种会明显降低通信成本。