- 1WordPress配置文件wp-config.php自定义路径(提高安全性必做)_wordpress 设置文件路径

- 2python笔记——jieba库_jieba.cut

- 3ICRA2021会议-----SLAM方向汇总_5252b.con

- 4自然语言处理: 第十七章RAG的评估技术RAGAS

- 5机器学习 - 图像识别_机器学习 图形识别

- 6命名实体识别代码阅读_datasets.load_from_disk

- 7【AIGC调研系列】Grok1.5相比Grok1的优势在哪

- 8日常pytho3练习脚本之--分词及自然语言处理

- 9Azure AI 服务之语音识别

- 10微信公众号自动回复聊天机器人实现(PHP)_php 自动对话

这15个大模型LLM最新研究成果很有看点_近期除了vllm,还有那些值得一读的llm推理的相关论文

赞

踩

大模型到目前为止已经有了许多的研究成果了,这次就和大家分享几个比较有意思的工作,篇幅原因只做简单介绍,需要论文原文及源码的同学看文末。

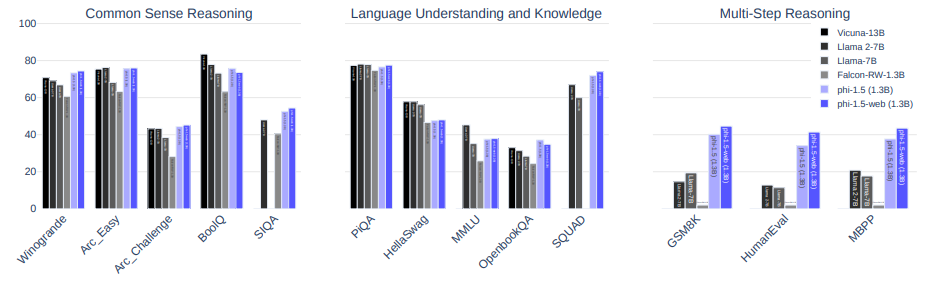

1、phi-1.5

Textbooks Are All You Need II: phi-1.5 technical report

《phi-1.5技术报告》

一句话概括:本文提出了一个名为phi-1.5的新型预训练语言模型,它具有13亿参数,在自然语言理解任务上的表现可与体量更大的模型媲美,并在更复杂的推理任务上优于许多非前沿大模型,展现出逐步思考、原位学习等大模型的许多特性,相比依赖网络数据的模型,phi-1.5可以生成更连贯、更少有害内容的文本。

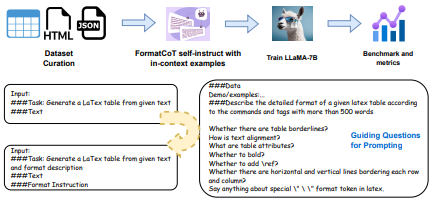

2、Struc-Bench

Struc-Bench: Are Large Language Models Really Good at Generating Complex Structured Data?

《LLM生成结构化数据》

一句话概括:尽管GPT-4等大型语言模型在多方面展现强大能力,但在需要生成复杂结构化输出的任务上仍面临挑战,本研究通过提出Struc-Bench基准套件和结构感知微调方法,评估了当前语言模型生成复杂结构化数据的能力,识别了其常见错误类型,并提出了改进模型在格式、推理和理解能力等多个维度的未来研究方向。

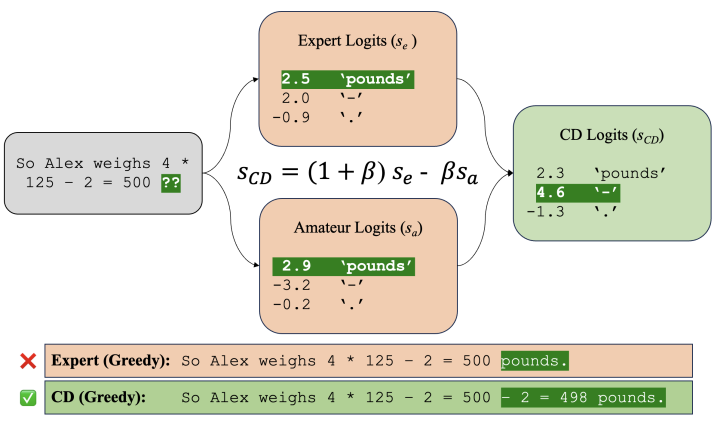

3、Contrastive Decoding

Contrastive Decoding Improves Reasoning in Large Language Models

《对比解码改进了大语言模型的推理能力》

一句话概括:论文展示了对比解码这一简单、计算量小、无需训练的文本生成方法可以在各类推理任务上显著改进贪心解码,从而在不改变模型参数的情况下提升大语言模型的推理能力。对比解码通过最大化生成序列在强模型上的联合概率与在弱模型上的联合概率之差,可以避免一些抽象推理错误,并防止简单地复制输入的链式推理。

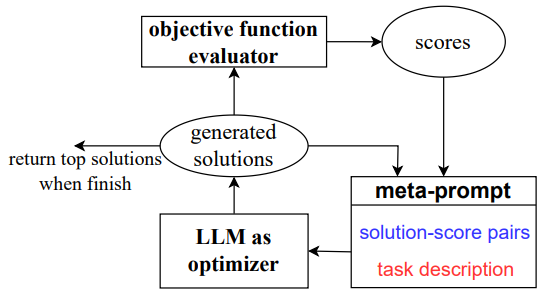

4、OPRO

Large Language Models as Optimizers

《大语言模型可以优化提示词》

一句话概括:本文提出了一种简单高效的方法,通过自然语言描述的提示,利用大规模语言模型作为无需 gradient 的通用优化器,在各类优化问题上取得显著提升。该方法每步通过语言模型根据包含之前结果的提示生成新解,迭代优化提示以产生更好解。实验表明,与人工设计的提示相比,该方法优化的提示可以显著提升语言模型在GSM8K、BigBench等任务上的效果。

5、RAIN

RAIN: Your Language Models Can Align Themselveswithout Finetuning

《LLM无需微调自行对齐》

一句话概括:文章提出了可回绕的自回归推理方法,使预训练语言模型可以评估自己的生成,并用评估结果指导回绕和生成,实现人机一致而无需额外 Align 数据或模型调整。实验结果证明该方法可以大幅提升模型生成的无害率而维持有效率。

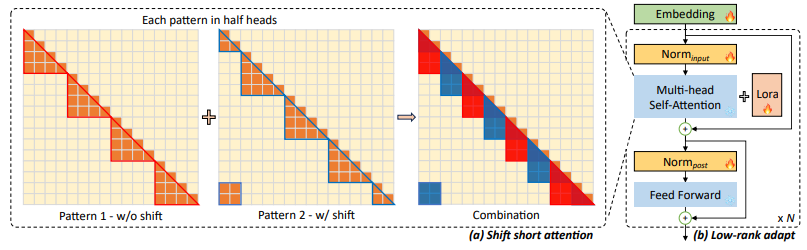

6、LongLoRA

LongLoRA: Efficient Fine-tuning of Long-Context Large Language Models

《大语言模型高效微调》

一句话概括:本文提出了LongLoRA方法,通过稀疏局部注意力机制与逻辑回归适配器的结合,以较低计算成本有效扩展了大规模预训练语言模型的上下文长度,在多个任务上取得了与全模型微调相当的效果,还收集了LongQA数据集以进行有监督的长上下文微调。

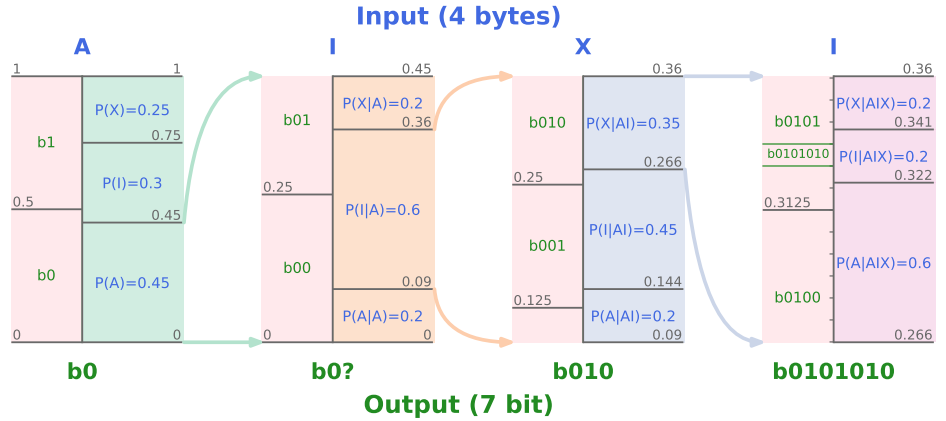

7、语言模型即压缩

Language Modeling Is Compression

《语言模型即压缩》

一句话概括:本文提出从压缩的角度理解语言模型预训练,并证明语言模型训练等价于学习无损文本压缩表示,大语言模型确实学习到了强大的通用压缩能力,压缩视角为分析和改进语言模型提供了新思路。

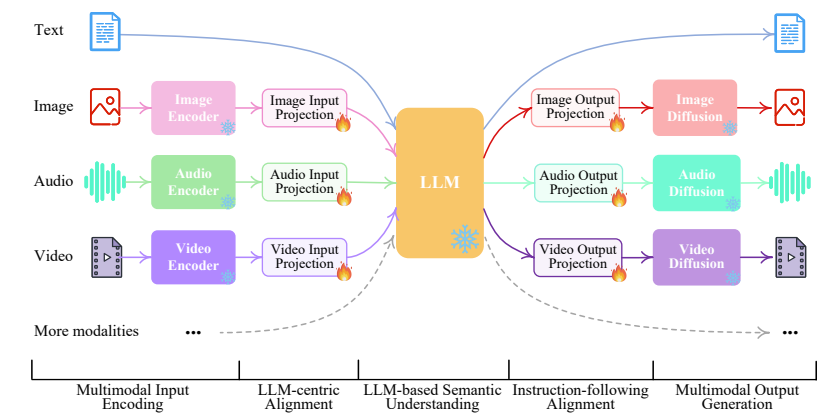

8、NExT-GPT

NExT-GPT: Any-to-Any Multimodal LLM

《多模态语言模型中的任意转换》

一句话概括:本文提出NExT-GPT,一个端到端的通用多模态语言模型,可以输入输出任意组合的文本、图像、视频和音频模态,只需要调整极小量的参数即可实现多模态理解和生成,并通过跨模态指令调优赋予模型复杂的跨模态语义理解能力。

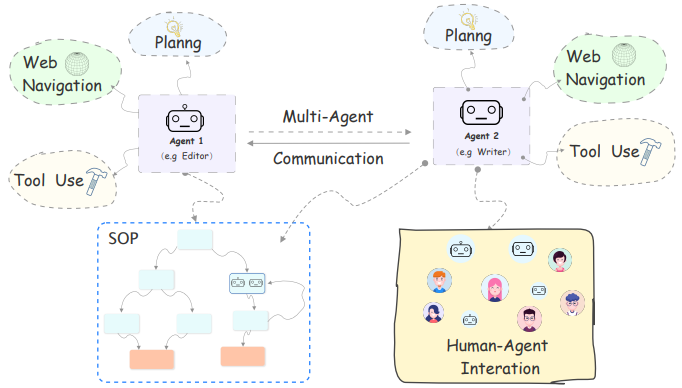

9、Agents

Agents: An Open-source Framework for Autonomous Language Agents

《自主语言代理开源框架》

一句话概括:本文提出了Agents,一个开源的Python框架,用于构建自主的语言代理,具有模块化设计、支持多种对话任务、可自定义对话策略等特点,降低了语言代理开发门槛,为研究人员和开发者构建智能对话应用提供了一个灵活全面的平台。

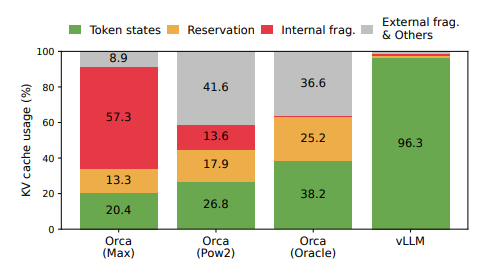

10、vLLM

Efficient Memory Management for Large Language Model Serving with PagedAttention

《大语言模型服务的高效内存管理》

一句话概括:作者提出了PagedAttention算法。在此基础上,作者构建了vLLM系统,实现了:(1)键值缓存内存的近零浪费,(2)请求内部和跨请求之间的灵活缓存共享,进一步减少内存使用。评估结果显示,与目前最先进的系统(如FasterTransformer和Orca)相比,vLLM系统在相同延迟水平下提高了常用大语言模型的吞吐量2-4倍。

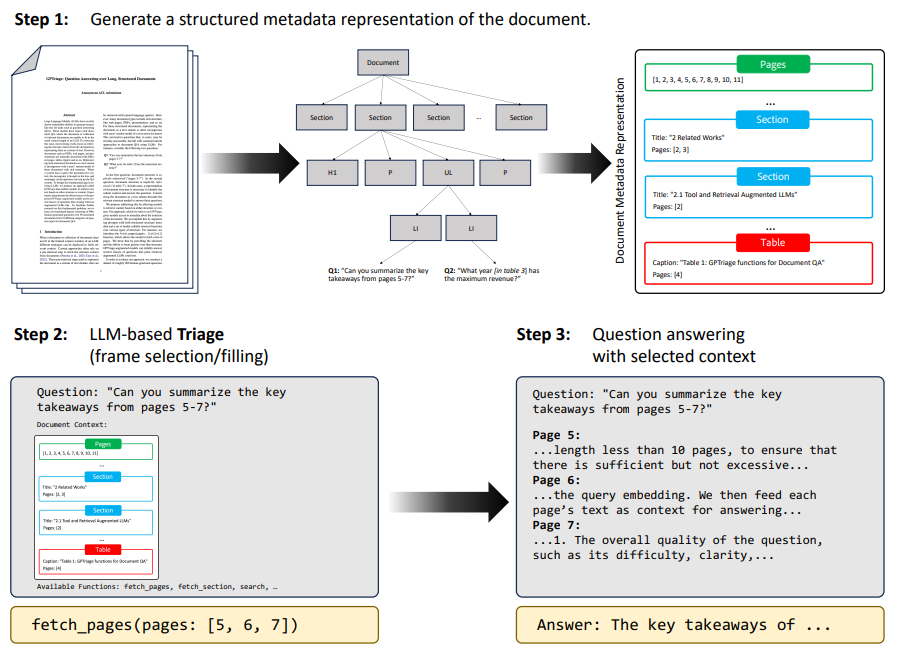

11、PDFTriage

PDFTriage: Question Answering over Long, Structured Documents

《针对长篇、结构化文档的问答系统》

一句话概括:为了解决大型语言模型在长文档问答中无法容纳完整文档内容的问题,现存的方法主要通过检索相关上下文来表示为纯文本。但是诸如PDF、网页和演示文稿等文档本质上具有丰富的结构,将其简化为纯文本与用户的文档心智模型不符。为此,论文提出了PDFTriage,使模型可以基于结构或内容检索上下文,以弥合在处理结构化文档时的鸿沟。

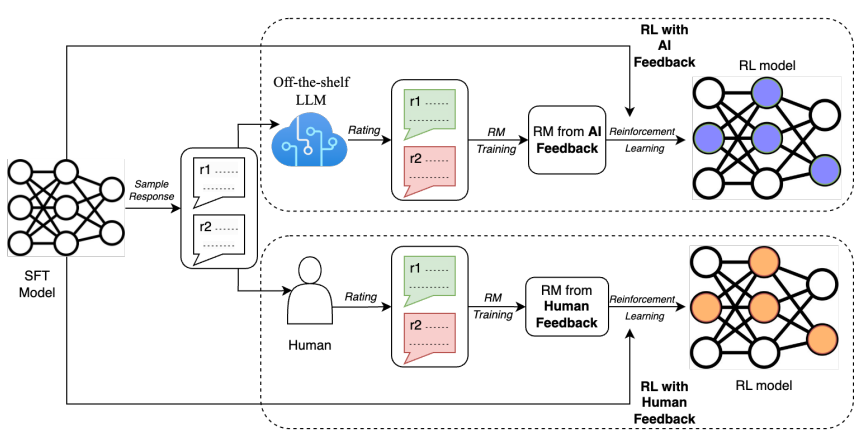

12、RLAIF

RLAIF:Scaling Reinforcement Learning from Human Feedback with AI Feedback

《利用AI反馈扩展人类反馈的强化学习》

一句话概括:基于人类反馈的强化学习(RLHF)可以有效指导大语言模型满足人类偏好,但获取高质量的人类偏好标注是一个关键瓶颈。论文比较了RLHF与RLAIF(用预训练语言模型代替人类给出偏好标注的强化学习方法),发现两者取得了类似的改进。在文本摘要任务上,与监督微调的基线模型相比,人类评估者在近70%的情况下更偏好RLAIF和RLHF生成的摘要。

13、COVE

CHAIN-OF-VERIFICATION REDUCES HALLUCINATION IN LARGE LANGUAGE MODELS

《用于对抗LLMs中的产生幻觉问题的“链式验证”》

一句话概括:大语言模型生成合理但错误的事实信息(即幻觉)是未解决的问题。本文研究语言模型对其响应进行推敲从而纠正错误的能力,提出了链式验证(COVE)方法:模型(i)起草初始响应,(ii)计划验证问题以核查起草内容,(iii)独立回答问题,避免答案受其他响应影响,(iv)生成最终验证后的响应。

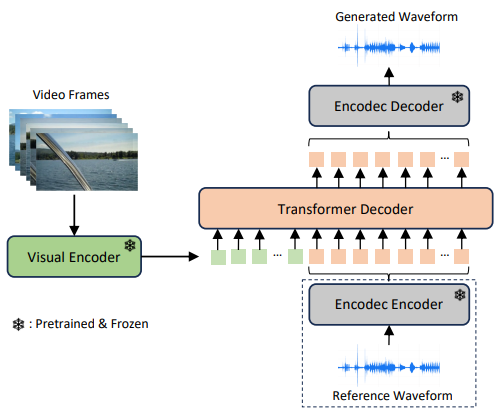

14、FoleyGen

FoleyGen: Visually-Guided Audio Generation

《基于视觉指导的音频生成》

一句话概括:本文提出FoleyGen,这是基于语言模型范式的开域视频到音频生成系统,能够利用视觉特征指导音频标记的生成,并通过视觉注意机制解决生成音频与视频动作失配的问题。

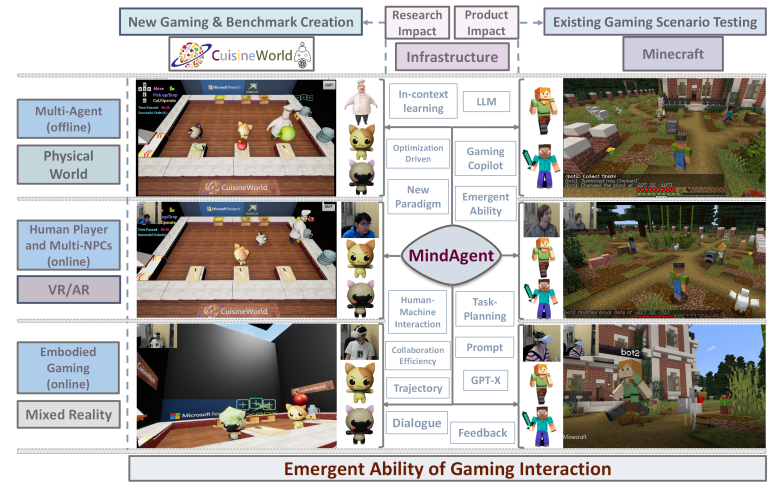

15、MindAgent

MindAgent: Emergent Gaming Interaction

《基于大语言模型的多智能体规划》

一句话概括:本文提出MindAgent框架评估多智能体游戏互动中智能体的规划和协调能力,并在CUISINEWORLD游戏中实现人机协作,结果表明该框架可以帮助大规模语言模型通过从大量语言语料中学习获得规划协调技能。

关注下方《学姐带你玩AI》

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。