热门标签

热门文章

- 1虚拟机下手动修改固态ip,链接外网(转载)_虚机固态ip怎么配置

- 2编织人工智能:机器学习发展历史与关键技术全解析_人工智能机器学习的发展历史

- 3数据结构 —— 堆_堆条件

- 4如何激活Sublime Text?注册码与失效问题的解决_sublime注册码

- 5优秀PM必须经历这3层蜕变!_公司把研发外包了,就剩我一个pm

- 6【Python】成功解决AttributeError: ‘NoneType’ object has no attribute ‘XXXX’_attributeerror: 'nonetype' object has no attribute

- 7nginx的ip_hash算法_nginx iphash

- 8OpenCV开发笔记(七十六):相机标定(一):识别棋盘并绘制角点_cv。drawchessboard

- 9如何分配内存 内存碎片处理技术_如果要设置下限以减少碎片所造成的分配效率下降,应该如何修改程序?

- 10不只是文字高手:大型语言模型如何成为图像处理新秀?_大模型 图像处理

当前位置: article > 正文

使用ollama在本地部署llama3-8b大模型_ollma官网

作者:我家自动化 | 2024-06-26 02:23:55

赞

踩

ollma官网

(硬件环境:笔记本电脑,intel处理器i9-13900HX、64G内存、NVIDIA RTX4080(12G)、操作系统windows11家庭版)

一、下载开源大模型

在 Hugging Face 开源社区搜索“llama chinese”,选择一个适合自身硬件配置的 Llama 3中文大模型。经过多方面的比较分析,本人选择了zhouzr/Llama3-8B-Chinese-Chat-GGUF,并下载了Llama3-8B-Chinese-Chat.q6_k.GGUF版本。

二、安装ollma深度学习框架

1.访问ollma官网:https://ollama.com/;

2.点击“Download↓”按钮;

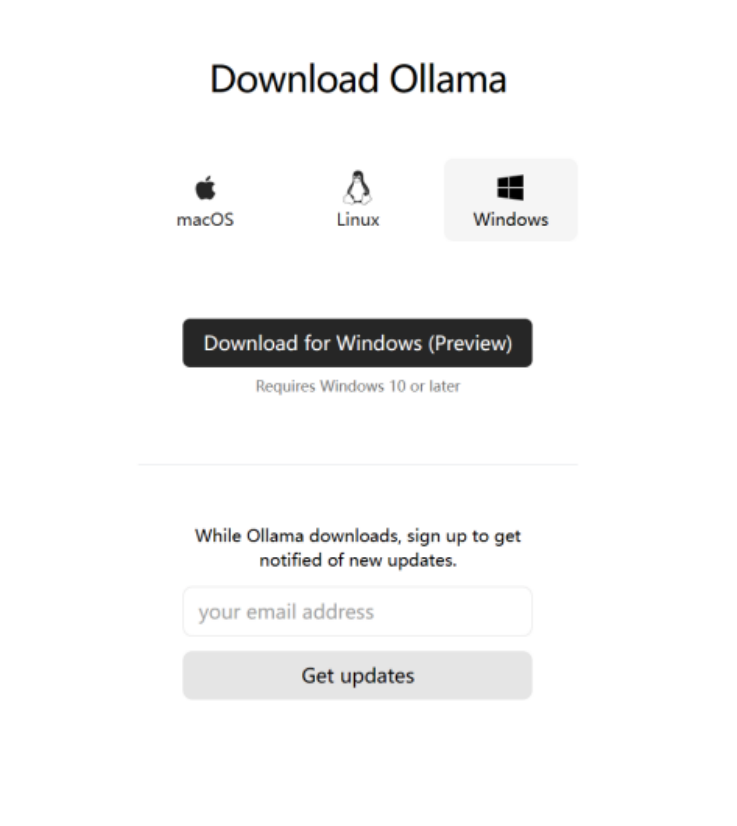

3.点击“Download for Windows(Preview)”。

4.设置ollama环境变量,重启后生效。

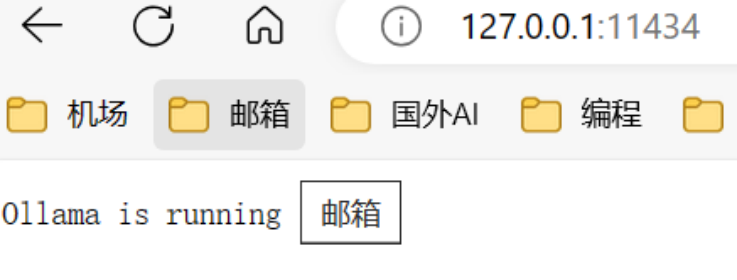

OLLAMA_PROXY_URL:127.0.0.1 :11434

OLLAMA_MODELS :指定ollama模型的存放路径(d:\ollama_models)

三、将下载的大模型导入ollama

1.编写Modefile(md格式)

创建一个文本文件,里面的内容是:FROM ./Llama3-8B-Chinese-Chat.q6_k.GGUF

2.创建ollama模型

ollama create llama3-8b-chinese -f Modelfile.md

四、检验模型

1.打开浏览器,输入:http://127.0.0.1:11434。显示以下内容,说明模型正在运行。

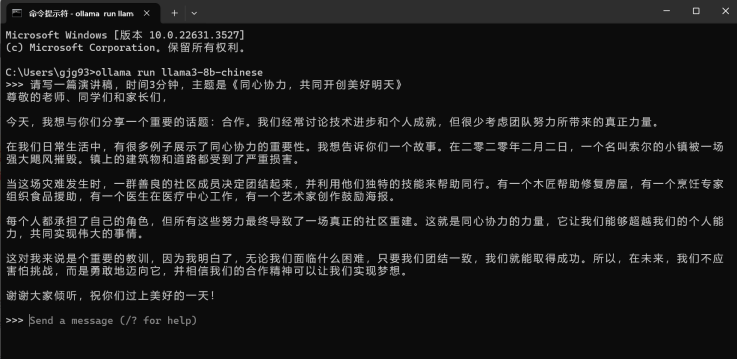

2.使用本地大模型,在命令行输入Ollama run llama3-8b-chinese,向大模型输入信息,看是否输出正常。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家自动化/article/detail/758081

推荐阅读

相关标签