热门标签

热门文章

- 1快慢指针找环的入口,Floyd算法推导_floyd入环点推导 知乎

- 22024钉钉杯A题烟草营销案例数据分析【完整解题过程+代码】_钉钉杯a题代码

- 3小红书,已破!支持无水印批量下载_小红书无水印下载软件

- 4【算法专题】二叉树中的深搜(DFS)_二叉树深度优先搜索dfs

- 5铁打的阿里,流水的美团,21届校招生Offer薪资曝光后,伤了老员工的心…

- 6OnePlus安装Kali-NetHunter

- 7idea配置maven3.6.1以及配置阿里云镜像以及配置jdk版本,附maven下载地址百度网盘_maven安装包百度网盘

- 8解决北京户口,中科院计算所校招,CV/图像处理工程师,博士优先

- 9全球“微软蓝屏”事件:一场网络安全与系统韧性的全面检验

- 10umi-ocr识别文件夹所有文件并导入数据库_umi-ocr 通过python

当前位置: article > 正文

爬虫入门傻瓜式教程!不会你砍我!爬当当网的书名~_beautiful soup爬当当网

作者:我家自动化 | 2024-07-14 14:20:28

赞

踩

beautiful soup爬当当网

喵。最近新学爬虫,学半天笔记做半天给我学迷糊了,于是决定跨出第一步!先写一个吧~!(写这个就写了半天,应该没有比我更呆的人了。)

要用到的导入

from bs4 import BeautifulSoup #解析网页

import requests #URL用

首先进入当当网的主页~在主页搜索栏随便搜个啥,比如:美女

此时可以看到 链接里结尾是 &act=input:

然后再点击第2页~

发现结尾变成了 &act=input&page_index=2

再点回第一页!

发现结尾是 &act=input&page_index=1

于是发现URL的通用格式是:

index 后面输第几页就能去第几页

URL=“https://search.dangdang.com/?key=美女&act=input&page_index=”

因为想简单的爬书名~

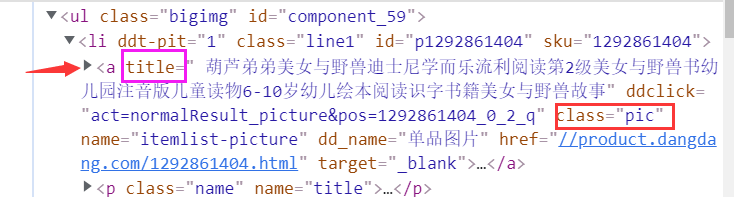

所以善用网页前端的代码找书名在哪个标签里!先找到了所有的书名所在的大类:是class为bigimg 的 ul 标签里

对照打开第一个li标签,发现书名(title属性) 在 class为pic的 a标签里。只要能得到这个title属性就可以得到书名啦

实现o( ̄▽ ̄)ブ:

from bs4 import BeautifulSoup import requests URL="https://search.dangdang.com/?key=美女&act=input&page_index=" pagenum=1 while(pagenum<=2): html=requests.get(URL+str(pagenum)).text soup=BeautifulSoup(html,'lxml') text_ul=soup.find_all('ul',{"class":"bigimg"}) for ul in text_ul: texts=ul.find_all('a',{"class":"pic"}) for t in texts: print(t.get('title')) pagenum+=1

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家自动化/article/detail/825047

推荐阅读

相关标签