- 1【大模型应用开发 动手做AI Agent】多Agent协作

- 2RocketMQ 篇一 Linux环境安装rocketmq_rocketmq5 liunx 安装

- 3成都有哪些牛逼的互联网公司

- 4队列的基本操作(C/C++)_c++队列的基本操作

- 5python中turtle图标换成其他图片_教你用Python制作表情包,实现换脸技术!

- 6【iOS】—— 内存的五大分区_ram分区

- 7对比传统交易模式与基于区块链的交易模式_传统的中心化存储方式及依赖第三方的交易模式 数据交易

- 8实现两个字符串内容的相似度_字符串相似度

- 9DES算法的加解密原理(详细算法+样例Demo)_des解密

- 10Kali Linux基础命令:find命令学习一_kali find

一文速览Gemma及其微调:通过我司七月的早期paper-7方面review数据集微调Gemma2_gemma2:27b

赞

踩

前言

如此文《七月论文审稿GPT第3.2版和第3.5版:通过paper-review数据集分别微调Mistral、gemma》所讲

Google作为曾经的AI老大,我司自然紧密关注,所以当Google总算开源了一个gemma 7b,作为有技术追求、技术信仰的我司,那必须得支持一下,比如用我司的paper-review数据集微调试下,彰显一下gemma的价值与威力

后来我司考虑到毕竟llama的生态更完善、迭代速度更快,故之后更多是微调llama,然后Google到底是不甘落后,24年6.27,在时隔4个月之后,Google终于推出了gemma的升级版:gemma2

我其实想说,如果是前几年的AI时代,这个速度可以了,但如今是大模型时代,还是太慢了(毕竟llama已到3,Claude则已到3.5)

- 不过既然推出了,加之我司把论文审稿的数据弄成7方面review之后,llama2、llama3都还没pk赢过gpt4(4方面review下微调llama2,早已赢过了GPT4-1106;7方面review下微调llama3却只和GPT4打成平手)

- 如此,可以让情况4的早7数据 微调下gemma2,过程中保持:“微调的prompt用的是potential,与阿荀给的训练数据中的摘要prompt的格式一致”,包括推理的prompt

预期是:开源模型得在7方面review下微调后的表现,类似4方面review那样,也是可以超过gpt4的(功夫不负有心人的是,终于超了,详见本文文末,也预示着我司审稿团队开发整整一年的七月论文审稿GPT 达到了对外发布上线的标准了,太不容易了..)

如此,便有了本文(且把之前关于gemma1的介绍也从上面那篇文章 《通过paper-review数据集分别微调Mistral、gemma》中脱离出来,归纳到本文)

第一部分 Google推出gemma,试图与llama、Mistral形成三足鼎立之势

Google在聊天机器人这个赛道上,可谓被双向夹击

- 闭源上被OpenAI的ChatGPT持续打压一年多(尽管OpenAI用的很多技术比如transformer、CoT都是Google发明的,尽管Google推出了强大的Gemini)

- 开源上则前有Meta的llama,后有Mistral的来势汹汹

终于在24年2.21,按耐不住推出了开源模型gemma(有2B、7B两个版本,这是其技术报告,这是其解读之一),试图对抗与llama、Mistral在开源场景上形成三足鼎立之势

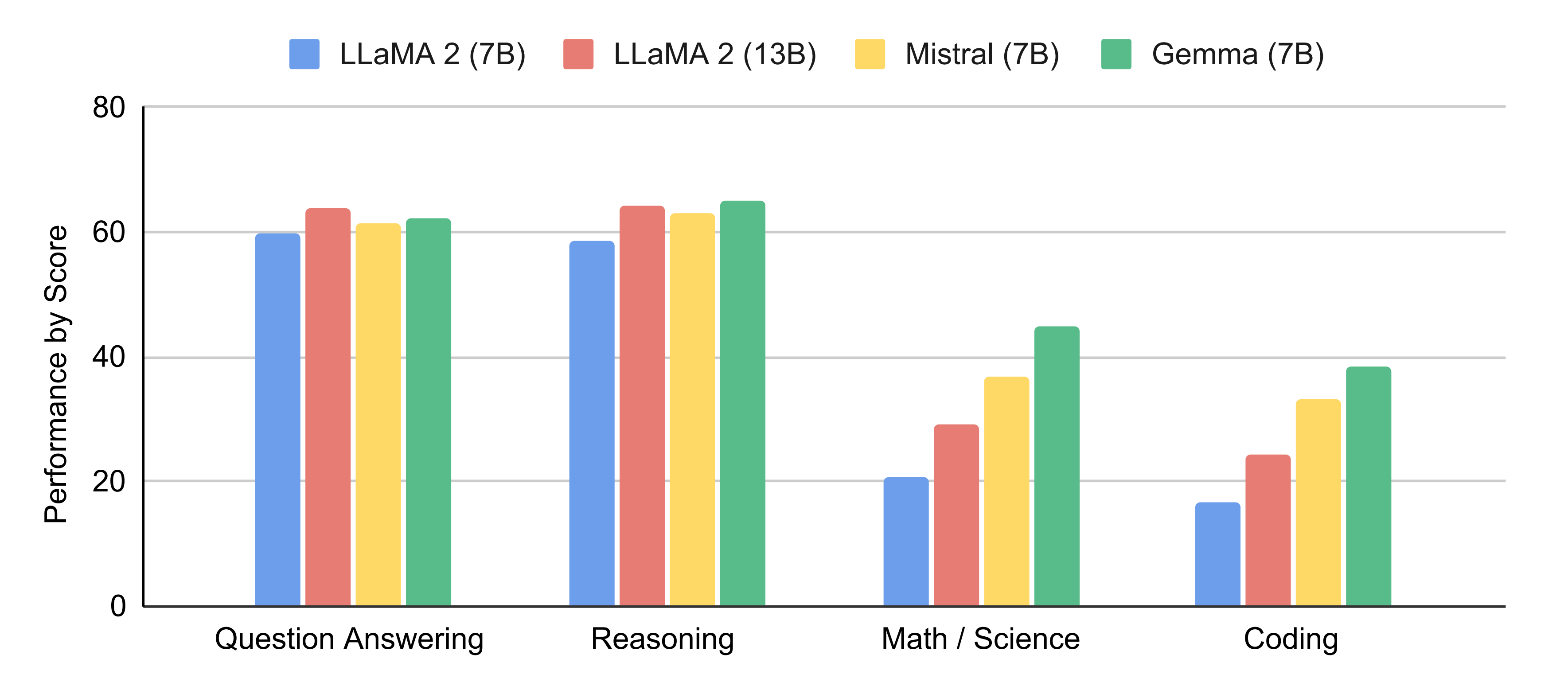

1.1 gemma 7B的性能:比肩Mistral 7B、超越llama 7B

Gemma 7B在 18 个基于文本的任务中的 11 个上优于相似参数规模的开放模型,例如除了问答上稍逊于llama 13B,其他诸如常识推理、数学和科学、编码等任务上的表现均超过了llama2 7B/13B(关于llama2的介绍请看此文的第三部分)、Mistral 7B

1.2 模型架构:基于Transformer解码器、多头/多查询注意力、RoPE、GeGLU、RMSNorm

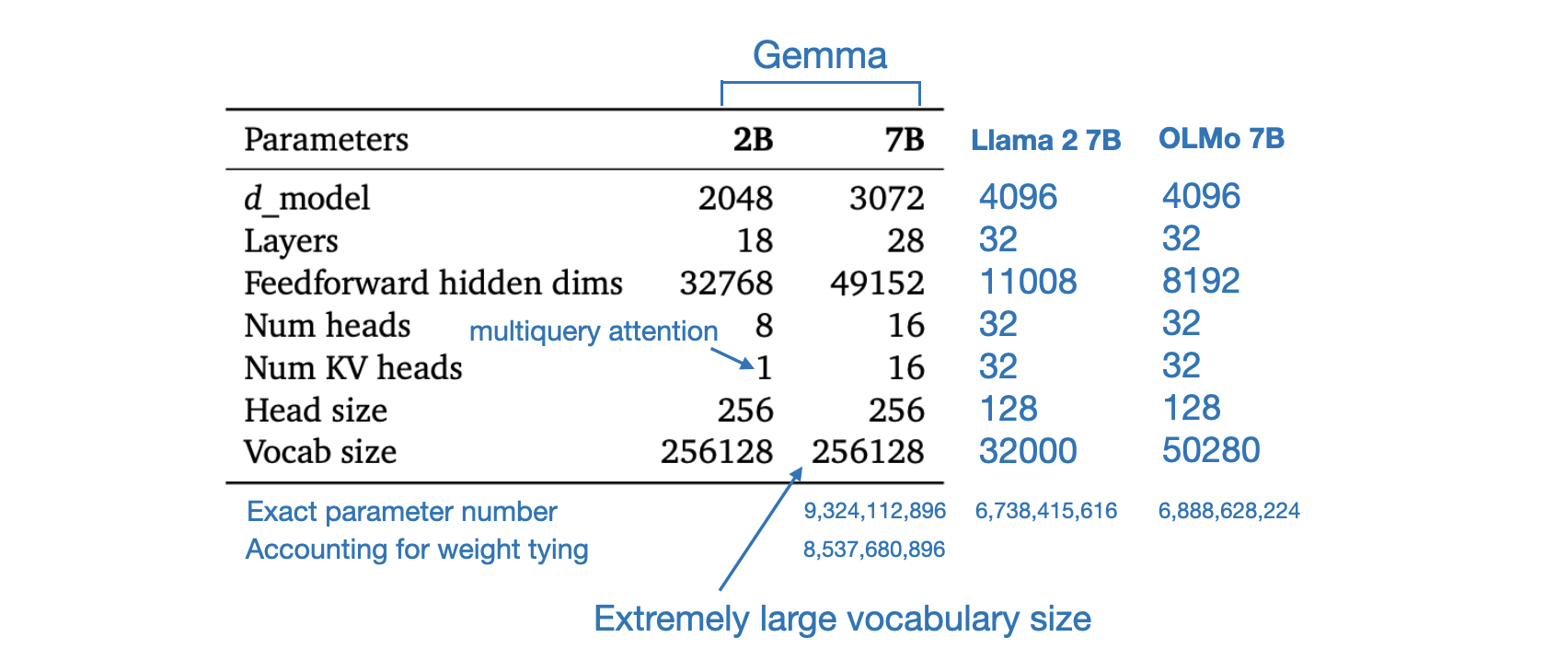

1.2.1 基于Transformer解码器:上下文8192、词表256K、训练数据集6万亿token

Gemma 模型架构基于 Transformer 解码器

- 模型训练的上下文长度为 8192 个 token

- 其词表则比llama2 所用的32K大太多了,为 256k个token(导致我们微调gemma 7b时,在论文审稿所需要的理想长度12K之下且在已经用了qlora和flash attention的前提之下,48g显存都不够,详见此文)

- 至于训练数据集达到6万亿个token(即We trained Gemma models on up to 6T tokens of text,而llama2的训练集只有2万亿个token)

1.2.2 7B/2B模型使用多头注意力/多查询注意力、RoPE、GeGLU、RMSNorm

此外,gemma还在原始 transformer 论文的基础上进行了改进,改进的部分包括:

- 多查询注意力:7B 模型使用多头注意力(即MHA,如下图最左侧所示),而 2B 检查点使用多查询注意力「即MQA,如下图最右侧所示,声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家自动化/article/detail/858659

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。