热门标签

热门文章

- 1linux用户、组管理及权限_linux 501

- 2慢查询优化案例之将子查询替换为临时表再与其他表进行表关联_优化器将子查询转换成多表查询

- 3linux下segmentation fault(段错误)总结_linux segmentation fault

- 4【正点原子K210连载】第十九章 machine.PWM类实验 摘自【正点原子】DNK210使用指南-CanMV版指南

- 5【华为OD统一考试B卷 | 100分】数据分类(C++ Java JavaScript Python)_js 数据分类华为od

- 6javaWeb网上购物系统的设计与实现_commoditydepict

- 7深入分析 Android ContentProvider (三)

- 8程序开发中的软实力和硬实力_软件工程专业求职应聘硬实力和软实力包括哪些方面

- 9ElasticSearch-学习笔记04【Java客户端操作索引库】_java 创建elasticsearch索引

- 10Android SO文件保护OLLVM混淆加固——混淆篇(二)_ollvm混淆so文件

当前位置: article > 正文

【Tauri】(5):本地运行candle和 qwen 大模型,并测试速度_qwen1.5-0.5b怎么在cpu上运行

作者:木道寻08 | 2024-07-19 10:52:08

赞

踩

qwen1.5-0.5b怎么在cpu上运行

1,本地运行candle

关于candle项目

https://github.com/huggingface/candle

Hugging Face 使用rust开发的高性能推理框架。

语法简单, 风格与 PyTorch 相似。

CPU 和 Cuda Backend:m1、f16、bf16。

支持 Serverless(CPU)、小型和快速部署

支持 WASM,可在浏览器中运行模型。

2,使用CPUP 运行qwen2-1.5大模型

cargo run --example qwen -- --model-id Qwen/Qwen1.5-0.5B-Chat --prompt 北京景点推荐

- 1

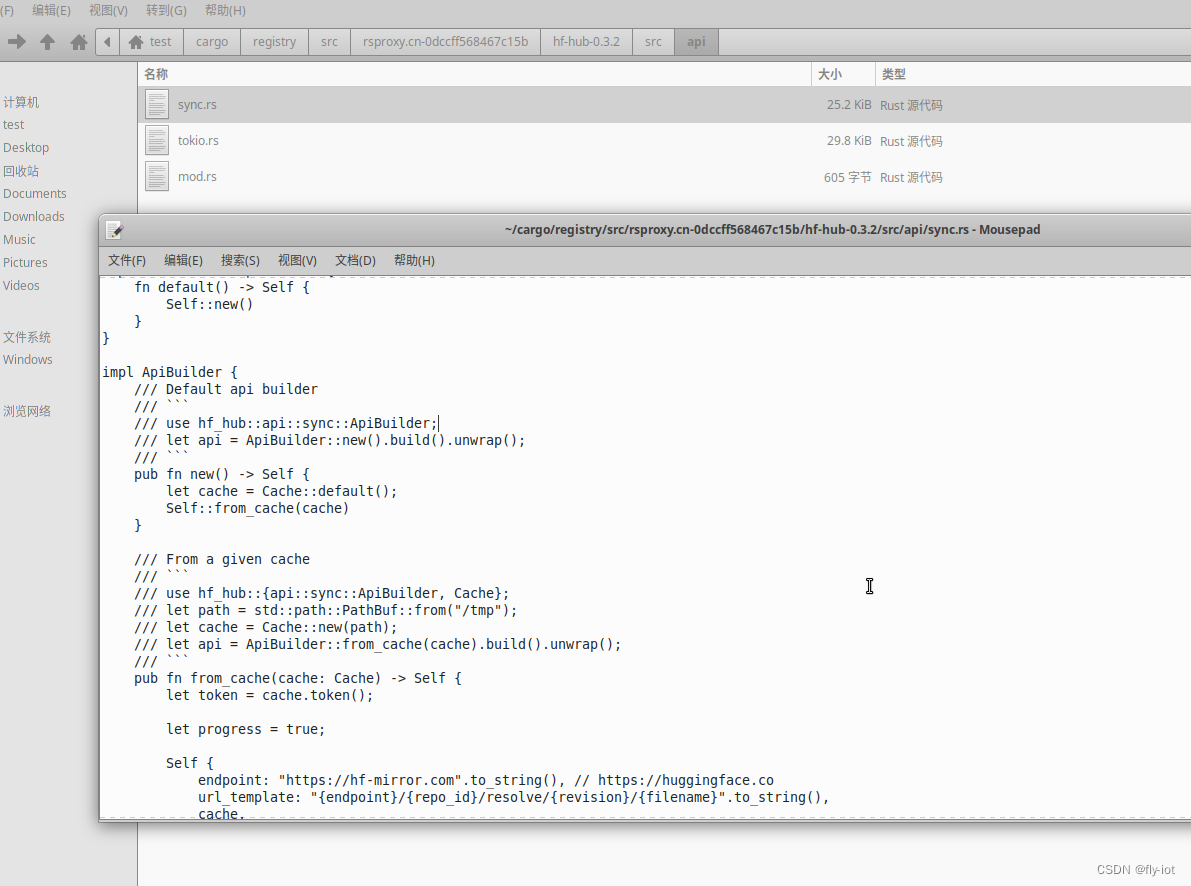

因为网络原因,需要修改地址:

把 https://huggingface.co 修改成 https://hf-mirror.com/

pub fn from_cache(cache: Cache) -> Self {

let token = cache.token();

let progress = true;

Self {

endpoint: "https://huggingface.co".to_string(),

url_template: "{endpoint}/{repo_id}/resolve/{revision}/{filename}".to_string(),

cache,

token,

progress,

}

}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

~/cargo/registry/src/rsproxy.cn-0dccff568467c15b/hf-hub-0.3.2/src/api/sync.rs

否则会报错,访问不到:

Running `target/debug/examples/qwen --model-id Qwen/Qwen1.5-0.5B-Chat --prompt '北京景点推荐'`

avx: true, neon: false, simd128: false, f16c: true

temp: 0.00 repeat-penalty: 1.10 repeat-last-n: 64

Error: request error: https://huggingface.co/Qwen/Qwen1.5-0.5B-Chat/resolve/main/tokenizer.json: Connection Failed: Connect error: Network is unreachable (os error 101)

Caused by:

0: https://huggingface.co/Qwen/Qwen1.5-0.5B-Chat/resolve/main/tokenizer.json: Connection Failed: Connect error: Network is unreachable (os error 101)

1: Network is unreachable (os error 101)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

3,总结下

使用 candle还是非常方便的,使用另外一种方案运行大模型。

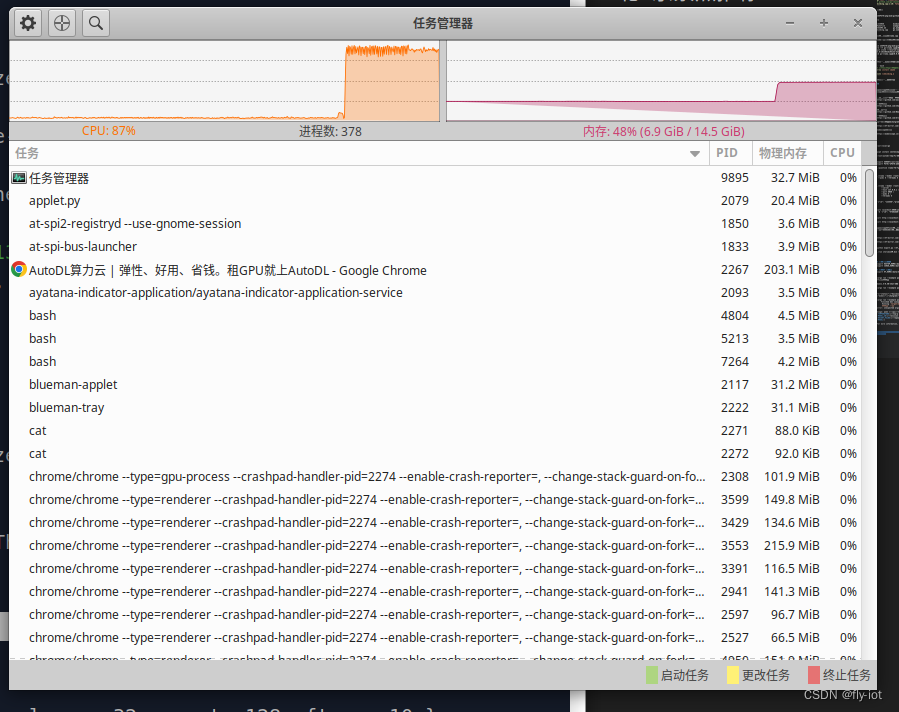

使用 cpu 速度就慢多了,开启量化的版本也慢:

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/木道寻08/article/detail/851069

推荐阅读

相关标签