- 1设计资讯 | 这款受数学方程启发的平板桌:配集成黑胶唱片机和无线充电器

- 2ubuntu中尝试安装ros2_ubuntu安装ros2

- 3简单剖析下kafka重点特性_kafka使用特性

- 4在搭载英特尔® 凌动™ 处理器的 Android* 手机和平板电脑上开发传感器应用_intel 凌动处理器 android

- 5国产数据库-达梦数据库sql语句中if、case when条件的使用,国产数据库(达梦数据库)case when sql语法和mysql有点不一样的地方,看了你也会_达梦 case when

- 6Online Tracking by Learning Discriminative Saliency Map with Convolutional Neural Network_saliency map结合1d-cnn

- 7Java直接杀死线程方法_如何杀死一个线程?

- 8腾讯云AI代码助手:智驭Python,编织代码的诗篇 —— 深度测评体验_腾讯vscode ai插件

- 9C语言 —— 函数递归

- 10「实战案例:使用 LSTM 进行单变量时间序列预测(附Python完整代码)_lstm实际应用案例

【机器学习300问】106、Inception网络结构如何设计的?这么设计的目的是什么?_inception模块

赞

踩

谷歌的Inception网络,也被称为GoogLeNet,是Google在2014年推出的一种深度卷积神经网络(CNN)模型,在这之前的AlexNet、VGG等结构都是通过增大网络的深度(层数)来获得更好的训练效果,但层数的增加会带来很多负作用,比如overfit、梯度消失、梯度爆炸等。Inception网络的核心组成部分是所谓的"Inception模块",这是对传统卷积神经网络架构的创新。

一、Inception模块

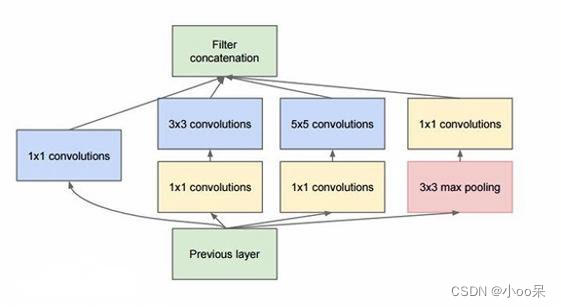

(1)Inception模块

Inception模块的基本设计理念是通过在一个层内并行地使用不同大小的卷积核(例如1x1, 3x3, 5x5)以及最大池化操作,能够在不显著增加计算负担的前提下,捕获图像的不同尺度特征。具体来说,模块包含以下几个部分:

按照上图中Inception模块中的几个部分,一个个介绍一下他们的作用:

- 1x1卷积层:Inception模块中的1x1卷积层不仅用于减少计算量,还能够有效控制网络中的参数数量。通过降低特征图的深度(通道数),它减轻了网络的复杂性,从而减少了梯度在深层网络中传播时可能遇到的路径数量,防止梯度爆炸和梯度消失。

- 3x3和5x5卷积层:Inception模块通过并行使用不同大小的卷积核和池化操作,能够在不同的尺度上提取特征,这增加了网络的多样性,减少了单一路径上的依赖,从而间接帮助梯度更好地传播。但5x5卷积因其较大的感受野而计算成本较高,因此较少使用。

- 最大池化层:增加模型对不同尺度信息的鲁棒性。

- 拼接输出:会在深度维度上被拼接(Filter concatenation),形成一个具有丰富特征表示的输出。

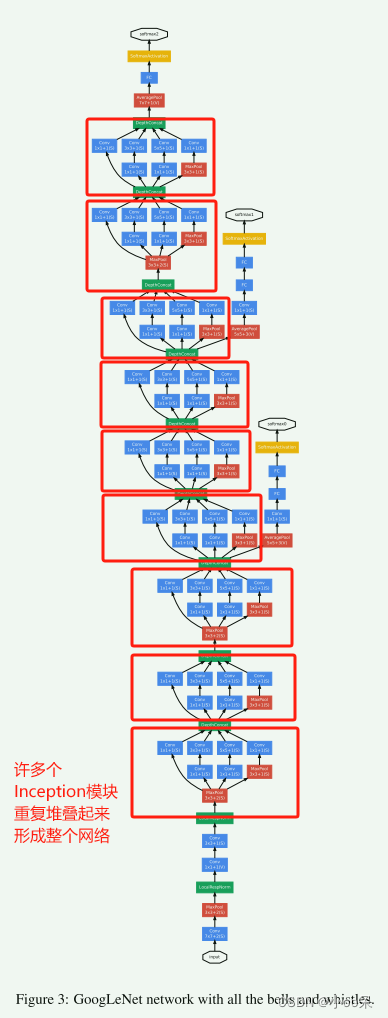

(2)Inception网络架构

通常Inception网络是从几个传统的卷积层开始,用于初步特征提取。然后网络主体由多个Inception模块堆叠而成,每个模块根据需要可能包含不同数量的卷积层和不同配置的Inception结构。在最后的几个模块之后,会使用全局平均池化层来替代全连接层,这一步骤可以显著减少参数数量,同时保持模型的判别能力。之后,通常会接一个或几个全连接层用于最终的分类任务。

Inception网络经历了多次迭代,从Inception V1到V4,以及Xception等变种。这些后续版本在基础Inception模块上进行了优化,例如引入了批量归一化、因子分解卷积、残差连接等技术,以进一步提高模型的效率和准确性,同时继续解决梯度消失和过拟合等问题。

二、Inception网络结构的优点

Inception网络无需人为干预以确定使用哪个过滤器或是否进行池化操作,这些参数均由网络内部机制自主决定。你可以给网络添加这些参数的所有可能值,并通过连接这些输出,让网络在训练过程中自我学习,以优化其参数配置,并确定最佳的过滤器组合。

(1)多尺度并行处理

Inception模块通过并行使用不同大小的卷积核和池化操作,自动地在不同尺度上捕捉特征,这在一定程度上模拟了“自主决定”各种滤波器尺寸的效果,无需人工精确选择单一最优尺寸。这种设计减少了对人工特征工程的依赖,提高了模型的泛化能力。

(2)高效利用计算资源

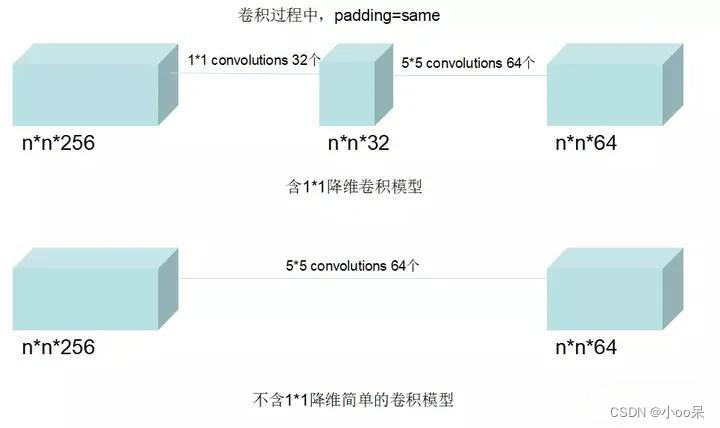

通过使用1x1卷积核进行降维,以及分解大尺寸卷积(如用两个3x3卷积代替一个5x5卷积),Inception网络在保持强大表达能力的同时,有效控制了模型的复杂度和计算成本,这是其一大优势。这里用一个例子来说明一下:

① 不包含1x1卷积模块的情况

参数量:

对于一个5x5卷积层,如果输入通道数为256,输出通道数为64,则参数量为卷积核的尺寸乘以输入通道数再乘以输出通道数,即

连接数:

每个神经元的连接数包括所有输入通道上的权重加上一个偏置项。对于5x5卷积核,每个输出通道有 个连接。总连接数为每个输出通道的连接数乘以输出通道数再乘以输出特征图的尺寸,即

② 包含1x1卷积模块的情况

在Inception结构中,通常会在5x5卷积之前使用1x1卷积来进行降维,假设1x1卷积的输出通道数为32,这样可以减少后续5x5卷积的计算负担。

参数量:

- 1x1卷积参数量:

- 5x5卷积参数量:在经过1x1卷积降维后,输入通道变为32,所以参数量为

连接数:

- 1x1卷积的每个输出通道有

个连接,总共

个连接。

- 5x5卷积的每个输出通道有

个连接,总共有

个连接。

- 总连接数为两部分之和

③ 计算结果

- 不包含1x1卷积模块时,对于输出特征图尺寸为 7×7 的情况,连接数为约 20,073,536

- 包含1x1卷积模块时,同样的输出尺寸下,连接数减少到约 2,914,912

- 不包含1x1卷积模块的情况下参数量为 409,600

- 包含1x1卷积模块的情况下参数量为 59,392

计算证实包含1x1卷积模块的结构显著减少了模型的参数量和连接数,从而降低了计算复杂度,提高了训练效率,同时保持了模型的表达能力。

(3)集成多种特征

Inception模块的结构允许网络整合不同类型的特征信息(局部的、全局的、不同尺度的),这种集成方式有利于学习更丰富的图像表示,提高分类或检测的准确性。

(4)灵活可拓展

Inception网络的模块化设计便于调整和扩展,研究人员可以根据特定任务的需求,通过增加或修改Inception模块来优化模型结构,这赋予了模型极高的灵活性。