- 1关于YOLOv5提示ModuleNotFoundError: No module named ‘ultralytics.yolo‘的解决办法_no module named 'ultralytics.yolo

- 2ZooKeeper的基本概念

- 3【堆/排序】堆排序的两种建堆方法_堆排序中两种建堆方法

- 4ambari 离线安装_ambari离线安装

- 5[Tb/and FPGA实现与门激励的设计]——用Tb/and FPGA打造高效与门激励_写一个与门的激励模块

- 6STM32高频注入,FOC矢量控制驱动方案及移植量产实践_dengfoc stm32移植

- 7pdps安装oracle12安装,PDPS安装使用过程问题点处理

- 8如何查看docker中有哪些容器_docker desktop里面的容器怎么看

- 9动手学深度学习(Pytorch版)代码实践 -深度学习基础-12Kaggle竞赛:预测房价

- 10AI实践与学习4_大模型之检索增强生成RAG实践_大模型 qwen 增强索引rag 离线

最全大数据进阶之路——Spark SQL环境搭建_sparksql环境搭建,2024年最新普通二本的辛酸大数据开发面试之路

赞

踩

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

-

NameNode(master)

1)负责客户端请求的响应

2)负责元数据(文件的名称、副本系数、Block存放的DataNodes)的管理 -

DataNodes(slave)

1)存储用户的文件对应的数据块(Block)

2)要定期向NameNode发送心跳信息,汇报本身及其所有的block信息,健康状况 -

副本系数

- It stores each file as a sequence of blocks. The blocks of a file are replicated for fault tolerance. The block size and replication factor are configurable per file.( 默认情况下,块大小是 128M,默认复制因子是 3)

- An application can specify the number of replicas of a file. The replication factor can be specified at file creation time and can be changed later.( 复制因子和块大小, 可以改的)

环境搭建

- 下载Hadoop

http://archive.cloudera.com/cdh5/cdh/5/

2.6.0-cdh5.7.0

wget http://archive.cloudera.com/cdh5/cdh/5/hadoop-2.6.0-cdh5.7.0.tar.gz

- 1

- 2

- 3

- 4

- 5

2)安装jdk

下载

解压到app目录:tar -zxvf jdk-7u51-linux-x64.tar.gz -C ~/app/

验证安装是否成功:~/app/jdk1.7.0_51/bin ./java -version

建议把bin目录配置到系统环境变量(~/.bash_profile)中

export JAVA_HOME=/home/hadoop/app/jdk1.7.0_51

export PATH=$JAVA_HOME/bin:$PATH

- 1

- 2

- 3

3)机器参数设置

- 修改机器名:

vi /etc/sysconfig/network

NETWORKING=yes

HOSTNAME=hadoop001

- 1

- 2

- 3

- 设置ip和hostname的映射关系:

vi /etc/hosts

192.168.199.200 hadoop001

127.0.0.1 localhost

- 1

- 2

- 3

- ssh免密码登陆(本步骤可以省略,但是后面你重启hadoop进程时是需要手工输入密码才行)

ssh-keygen -t rsa

cp ~/.ssh/id_rsa.pub ~/.ssh/authorized_keys

- 1

- 2

- 3

4)Hadoop配置文件修改:~/app/hadoop-2.6.0-cdh5.7.0/etc/hadoop

- hadoop-env.sh

配置Java目录export JAVA_HOME=/home/hadoop/app/jdk1.7.0_51

- core-site.xml

配置伪分布式

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop001:8020</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/app/tmp</value>

</property>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- hdfs-site.xml

调整副本系数

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

- 1

- 2

- 3

- 4

- 5

5)格式化HDFS

注意:这一步操作,只是在第一次时执行 ,每次如果都格式化的话,那么HDFS上的数据就会被清空

~/app/hadoop-2.6.0-cdh5.7.0/bin/hdfs namenode -format

看到下面日志表示成功

X X X X Xhas been successfully formatted.

6)启动HDFS

~/app/hadoop-2.6.0-cdh5.7.0/sbin/start-dfs.sh

验证是否启动成功:

- 1

- 2

jps

DataNode

SecondaryNameNode

NameNode

浏览器

http://hadoop001:50070/

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

7)停止HDFS

sbin/stop-dfs.sh

HDFS命令

[hadoop@hadoop000 bin]$ ./hadoop Usage: hadoop [--config confdir] COMMAND where COMMAND is one of: fs run a generic filesystem user client version print the version jar <jar> run a jar file checknative [-a|-h] check native hadoop and compression libraries availability distcp <srcurl> <desturl> copy file or directories recursively archive -archiveName NAME -p <parent path> <src>* <dest> create a hadoop archive classpath prints the class path needed to get the credential interact with credential providers Hadoop jar and the required libraries daemonlog get/set the log level for each daemon s3guard manage data on S3 trace view and modify Hadoop tracing settings or CLASSNAME run the class named CLASSNAME Most commands print help when invoked w/o parameters. [hadoop@hadoop000 bin]$ ./hadoop fs Usage: hadoop fs [generic options] [-appendToFile <localsrc> ... <dst>] [-cat [-ignoreCrc] <src> ...] [-chgrp [-R] GROUP PATH...] [-chmod [-R] <MODE[,MODE]... | OCTALMODE> PATH...] [-chown [-R] [OWNER][:[GROUP]] PATH...] [-copyFromLocal [-f] [-p] [-l] <localsrc> ... <dst>] [-copyToLocal [-p] [-ignoreCrc] [-crc] <src> ... <localdst>] [-count [-q] [-h] [-v] [-x] <path> ...] [-cp [-f] [-p | -p[topax]] <src> ... <dst>] [-df [-h] [<path> ...]] [-du [-s] [-h] [-x] <path> ...] [-find <path> ... <expression> ...] [-get [-p] [-ignoreCrc] [-crc] <src> ... <localdst>] [-getfacl [-R] <path>] [-getfattr [-R] {-n name | -d} [-e en] <path>] [-getmerge [-nl] <src> <localdst>] [-help [cmd ...]] [-ls [-C] [-d] [-h] [-q] [-R] [-t] [-S] [-r] [-u] [<path> ...]] [-mkdir [-p] <path> ...] [-moveFromLocal <localsrc> ... <dst>] [-moveToLocal <src> <localdst>] [-mv <src> ... <dst>] [-put [-f] [-p] [-l] <localsrc> ... <dst>] [-rm [-f] [-r|-R] [-skipTrash] <src> ...] [-rmdir [--ignore-fail-on-non-empty] <dir> ...] [-test -[defsz] <path>] [-text [-ignoreCrc] <src> ...] [-touchz <path> ...] [-usage [cmd ...]]

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 常用命令

hadoop fs -ls /

hadoop fs -cat /``hadoop fs -text /

hadoop fs -put /``hadoop fs -copyFromLocal /

hadoop fs -get /README.txt ./

hadoop fs -mkdir /hdfs-test

hadoop fs -mv

hadoop fs -rm

hadoop fs -rmdir

hadoop fs -rmr==hadoop fs -rm -r

hadoop fs -getmerge

hadoop fs -mkdir /hdfs-test

### MapReduce

MapReduce性能远低于Spark

并且只适合做离线处理不适合做实时处理和流式处理

YARN架构详解

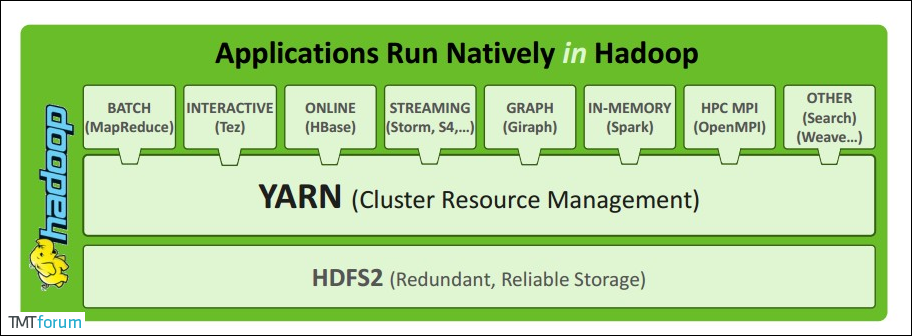

Apache YARN (Yet Another Resource Negotiator) 是 hadoop 2.0 引入的集群资源管理系统。用户可以将各种服务框架部署在 YARN 上,由 YARN 进行统一地管理和资源分配。

The fundamental idea of MRv2 is to split up the two major functionalities of the JobTracker, resource management and job scheduling /monitoring, into separate daemons. The idea is to have a global ResourceManager (RM) and per-application ApplicationMaster (AM). An application is either a single job in the classical sense of Map-Reduce jobs or a DAG of jobs.

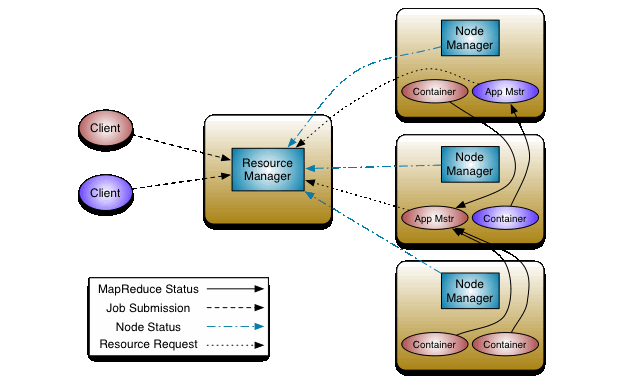

1 RM(ResourceManager) + N NM(NodeManager)

- Client

- 向

RM提交任务 - 杀死任务

- ResourceManager

ResourceManager通常在独立的机器上以后台进程的形式运行,一个集群active状态的`ResourceManager`只有一个 ,它是整个 集群资源的主要协调者和管理者 。

-2)启动/监控`ApplicationMaster`(一个作业对应一个AM)和监控`NodeManager`- 负责给用户提交的所有应用程序分配资源 ,它根据应用程序优先级、队列容量、ACLs、数据位置等信息,做出决策,然后以共享的、安全的、多租户的方式制定分配策略,调度集群资源。

- NodeManager

整个集群中有N个,负责单个节点的资源管理和使用以及task的运行情况

-

NodeManager是 YARN 集群中的每个具体 节点的管理者 。 -

主要 负责该单个节点内所有容器的生命周期的管理,监视资源和跟踪节点健康 。具体如下:

- 定时启动时向

ResourceManager注册并定时发送心跳消息,等待ResourceManager的指令; - 维护

Container的生命周期,监控Container的资源使用情况和启停的各种命令; - 管理任务运行时的相关依赖,根据

ApplicationMaster的需要,在启动Container之前将需要的程序及其依赖拷贝到本地。

- 定时启动时向

- ApplicationMaster

每个应用/作业对应一个,负责应用程序的管理

-

在用户提交一个应用程序时,YARN 会启动一个轻量级的 进程

ApplicationMaster。 -

ApplicationMaster负责协调来自ResourceManager的资源,并通过NodeManager监视容器内资源的使用情况,同时还负责任务的监控与容错。具体如下:- 根据应用的运行状态来决定动态计算资源需求;

- 向

ResourceManager申请资源,为应用程序向RM申请资源(container),并分配给内部任务 - 跟踪任务状态和进度,NM通信以启停task, task是运行在container中的

- 负责任务的容错。

- Container

Container是 YARN 中的 资源抽象 ,它封装了某个节点上的多维度资源,如内存、CPU、磁盘、网络等。- 当 AM 向 RM 申请资源时,RM 为 AM 返回的资源是用

Container表示的。 - YARN 会为每个任务分配一个

Container,该任务只能使用该Container中描述的资源。ApplicationMaster可在Container内运行任何类型的任务。例如,MapReduce ApplicationMaster请求一个容器来启动 map 或 reduce 任务

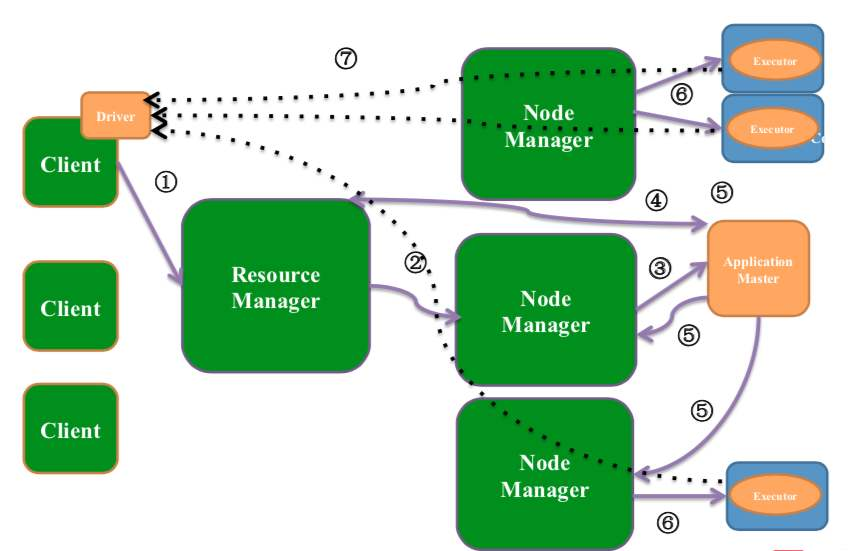

YARN执行流程

- 客户端

client向yarn集群提交作业 , 首先①向ResourceManager申请分配资源 Resource Manager会为作业分配一个Container(Application manager),Container里面运行这(Application Manager)Resource Manager会找一个对应的NodeManager通信②,要求NodeManager在这个container上启动应用程序Application Master③Application Master向Resource Manager申请资源④(采用轮询的方式通过RPC协议),Resource scheduler将资源封装发给Application master④,Application Master将获取到的资源分配给各个Node Manager,并监控运行情况⑤Node Manage得到任务和资源开始执行作业⑥- 再细分作业的话可以分为 先执行

Map Task,结束后在执行Reduce Task最后再将结果返回給Application Master等依次往上层递交⑦

YARN环境搭建

[hadoop@hadoop001 hadoop]$ pwd

/home/hadoop/app/hadoop-2.6.0-cdh5.7.0/etc/hadoop

- 1

- 2

- 3

- mapred-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

- 1

- 2

- 3

- 4

- 5

- yarn-site.xml

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

- 1

- 2

- 3

- 4

- 5

启动yarn:sbin/start-yarn.sh

验证是否启动成功

jps

ResourceManager

NodeManager

web: http://hadoop001:8088

- 1

- 2

- 3

- 4

- 5

- 6

停止yarn: sbin/stop-yarn.sh

提交mr作业到yarn上运行: wc

hadoop jar /home/hadoop/app/hadoop-2.6.0-cdh5.7.0/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.6.0-cdh5.7.0.jar wordcount /input/wc/hello.txt /output/wc/

[hadoop@hadoop001 sbin]$ hadoop fs -ls /output/wc

20/10/16 05:17:27 WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

Found 2 items

-rw-r--r-- 1 hadoop supergroup 0 2020-10-16 04:54 /output/wc/_SUCCESS

-rw-r--r-- 1 hadoop supergroup 26 2020-10-16 04:54 /output/wc/part-r-00000

[hadoop@hadoop001 sbin]$ hadoop fs -cat /output/wc/part-r-00000

20/10/16 05:17:52 WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

hello 2

welcome 2

world 1

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

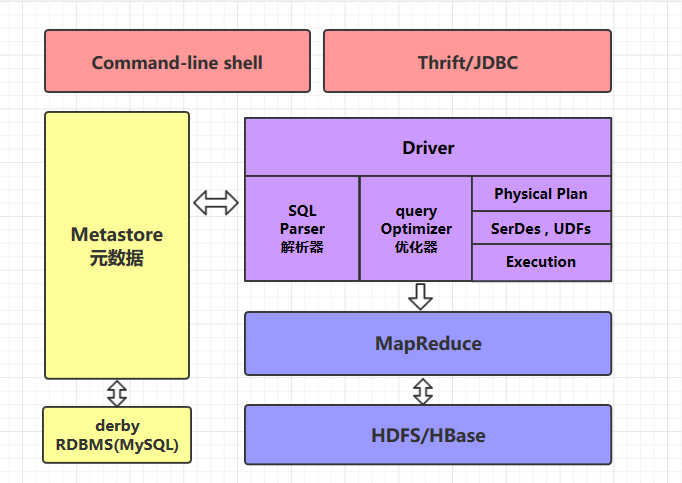

Hive环境搭建

| Hive | RDBMS | |

|---|---|---|

| 查询语言 | Hive SQL | SQL |

| 数据储存 | HDFS | Raw Device or Local FS |

| 索引 | 无(支持比较弱) | 有 |

| 执行 | MapReduce、 Tez | Excutor |

| 执行时延 | 高,离线 | 低 , 在线 |

| 数据规模 | 非常大, 大 | 小 |

Hive底层的执行引擎有:MapReduce、Tez、Spark

Hive on MapReduce

Hive on Tez

Hive on Spark

1)Hive下载:http://archive.cloudera.com/cdh5/cdh/5/

wget http://archive.cloudera.com/cdh5/cdh/5/hive-1.1.0-cdh5.7.0.tar.gz

2)解压

tar -zxvf hive-1.1.0-cdh5.7.0.tar.gz -C ~/app/

3)配置

系统环境变量(~/.bahs_profile)

export HIVE_HOME=/home/hadoop/app/hive-1.1.0-cdh5.7.0   **网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。** **[需要这份系统化资料的朋友,可以戳这里获取](https://bbs.csdn.net/topics/618545628)** **一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!** -1.1.0-cdh5.7.0.tar.gz -C ~/app/` 3)配置 系统环境变量(~/.bahs\_profile)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

export HIVE_HOME=/home/hadoop/app/hive-1.1.0-cdh5.7.0

- 1

[外链图片转存中…(img-Yu9AhKu8-1715100346159)]

[外链图片转存中…(img-lEJk38fR-1715100346159)]

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!