- 1计算机网络中23是什么端口号,什么是网络端口,端口有哪些分类-电脑自学网

- 2【话题】程序员应该有什么职业素养

- 3java的JVM学习总结第一章——JVM与java的体系结构

- 4【文献阅读】受山体阴影影响的冰湖制图方法研究(Li JunLi等人,2018.09,IJRS)_阴影损失文献

- 5【数据结构】线性表之《带头双向循环链表》超详细实现

- 6LLM 大模型学习必知必会系列(十):基于AgentFabric实现交互式智能体应用,Agent实战_dashscope中的llm的api

- 7ue4 UMG添加到场景_unreal umg放到世界空间

- 8译文:dBA和dBC的不同_dba和dbc的区别

- 9网站高性能架构设计——web前端与池化_前端架构设计

- 10spring整合openAI大模型之Spring AI_spring ai maven

循环神经网络(RNN)与长短期记忆网络(LSTM)_循环神经网络 短时间记忆

赞

踩

前言: 通过前面的学习,我们以BP神经网络为基础,认识到了损失函数,激活函数,以及梯度下降法的原理;而后学习了卷积神经网络,知道图像识别是如何实现的。今天这篇文章,讲述的就是计算机如何通过RNN与LSTM来做到自然语言的理解。

引入:

自然语言中,存在着强烈的语序和语境,词与词之前,是存在着时序顺序的,既然是存在着时序顺序,那就意味着词与词,之间是存在着逻辑关系,并不是单独的,那么当我们把一句话中的每个字,用独热编码表示后,一个字一个字的输入到神经网络中,就需要一种手段,来记录下字与字之间的关系,更通俗一点,就是我们下一个字的训练,是需要和上一个字的训练产生一些联系的,那么我们就需要再BP神经网络的基础上,想一个办法来实现这个机制。

循环神经网络:

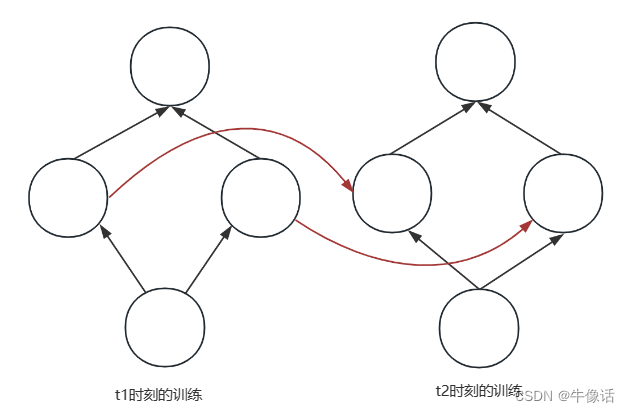

要想实现上面的机制,聪明的科学家已经帮我们想到了如何让每次训练之间产生联系,当我们把隐含层中的输出,作为下一个训练时刻隐含层的输入,就可以让每一次训练产生联系,如下图:

红色的线条,就是隐含层传递参数给下一个时刻隐含层的参数。我们用下面这张图,再来详细解释一下具体的执行:

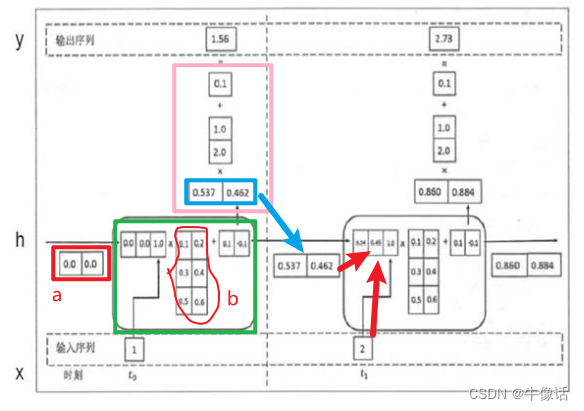

- 首先是两个时刻t0和t1,使用随机正态分布初始化网络中的节点,因为我们输入的是一维的向量,但是从b可以看出,隐含层中的神经元是两个,并且每个神经元中有一个三维向量,所以我们的a,就使用一个2维向量,这样就可以补齐成一个3维的了。

- 绿色框内,就是隐含层再t0时刻的计算,蓝色框内就是隐含层计算后,使用激活函数获取的值。

- 粉色框就是隐含层和输出层的计算矩阵,最后再通过一个激活函数输出。

- 可以看出在t1时刻,蓝色框作为上一个时刻隐含层的输出和t1时刻的输入,组合成了一个新的向量来进行运算,这就使得下个时刻的训练和上一个时刻产生了联系。

其中隐含层一般使用tanh作为激活函数,输出层使用softMax来作为激活函数。

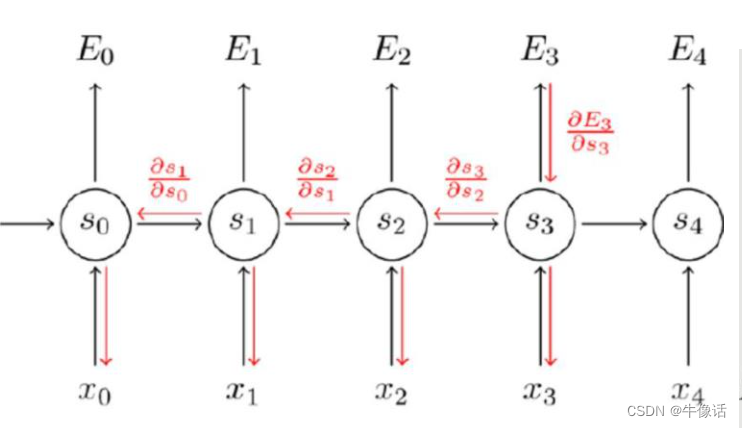

当我们进行了一句话的训练后,会产生很多个时刻,每个时刻都有一个误差值,我们使用bp神经网络的反向传播,梯度下降法 就可以去更新每个节点的权值,如下图,在E3时刻使用梯度下降法反向传播,更新了输出节点和隐含层节点的权值,图中可以明显看出,S3节点是需要前面时刻节点的链式法则来求导的

因为是使用链式求导,所以就会存在一个致命的问题,会导致梯度消失,当一句话长度过于的长,就会导致后面。因为随着求导的次数增多,值就会越来越小,所以导致了梯度消失,所以我们就需要学习下面的LSTM长短期记忆神经网络。

长短期记忆神经网络:

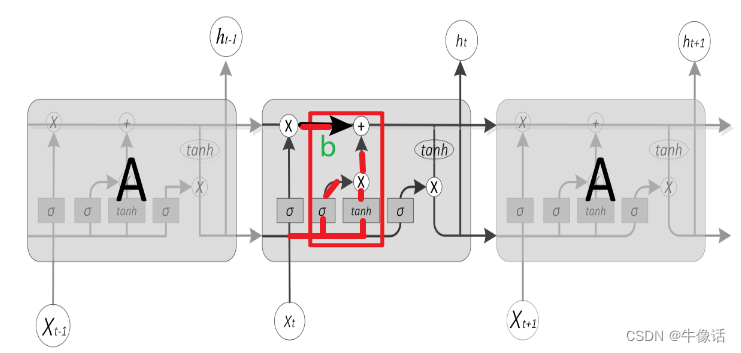

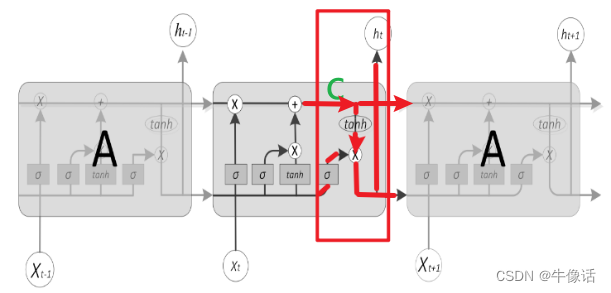

LSTM宏观结构上和RNN并无差异,但是在隐含层的微观结构却完全不一样。

长短期记忆神经网络的隐含层结构包含:遗忘门,输入门,输出门。

遗忘门: 遗忘门通过接收上一个时刻隐含层输出,以及该时刻的输入,经过sigmoid函数的变换,以上一时刻的输出a做乘法,做归一化处理。

输入门: 通过接收上一个时刻隐含层输出,以及该时刻的输入,一个经过sigmoid变化,一个经过tanh变换,然后使用乘法,把候选者加入细胞中,再和遗忘门计算出来的b,进行一个加法操作,就可以实现重要信息的保留,忘掉不重要的信息

输出门: 接收上一个时刻隐含层输出,以及该时刻的输入,经过一个sigmoid变换,与输入门和遗忘门的和C,进行一个乘法运算,就可以得到ht时刻的输出,以及下一个t+1时刻隐含层的输入。

参考:深度学习及其应用(赵卫东)