- 1音频录制(react)_recorder-core是否支持react

- 2银河麒麟操作系统添加新硬盘后流程_银河麒麟格式化硬盘

- 3前端和后端是如何交互的_前端和后端交互的方法

- 42023 安装 facebookresearch slowfast 自定义数据集训练 yolo数据集转ava数据集_slowfast数据集

- 5Android工具类整合_jsondp

- 6hive窗口函数rank()/dense_rank()/row_number()的区别

- 7PMBOK知识点整理【第四章项目整合管理】(49个子过程、输入、工具和技术、输出)_整合管理的七个过程

- 8RabbitMQ:Docker Compose部署RabbitMQ_docker compose rabbitmq

- 9linux(ubuntu) 系统修改/etc/fstab文件后无法进入系统的解决方法_ubuntu更改了fstab无法进入系统了

- 10python慕课版课后题答案,python123和中国大学慕课

GraspNet-1Billion 论文阅读

赞

踩

GraspNet-1Billion

CVPR2020

上海交大

论文和数据集地址:https://graspnet.net/

总体

主要解决训练数据不足和抓取姿态表示形式不同,没有统一的评估方法;仿真数据和真实场景数据存在gap

本文主要贡献是提出一个大规模数据集,一个统一的评价指标,一个端到端的物体抓取姿态预测方法

数据集

深度相机与机械臂固定连接,控制机械臂沿固定轨迹运动,只需要第一帧的6D位姿,后续的帧通过标定好的相机参数进行传递。

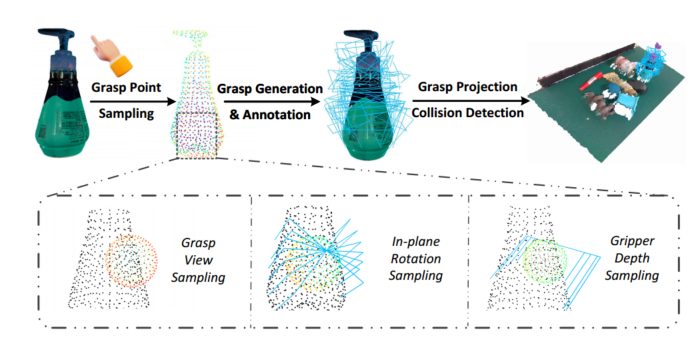

抓取姿态标注流程:

a. 抓取点采样

b. 抓取生成:视角、平面旋转和抓取深度采样

c. 通过物体的6D姿态投影场景中得到抓取姿态

d 碰撞检测

评价指标

Precision@k:前k个抓取的精度

网络

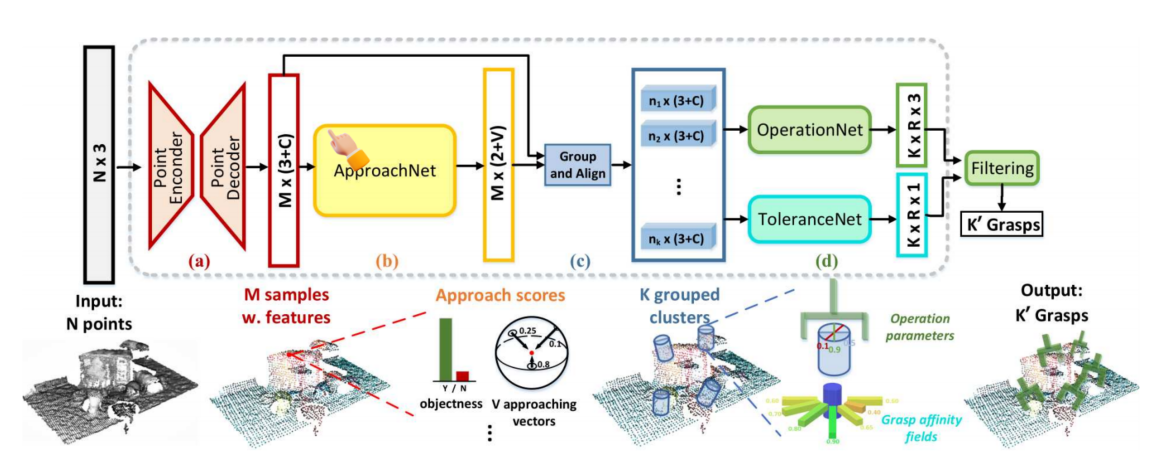

输入:点云

输出:抓取姿态(相对于相机坐标系)

pointnet++:

最远点采样算法, 点云分类

Approach Network:

输出能否抓取和预先定义的接近向量数量

Operation Network:

圆柱区域变换

旋转和宽度:分类比回归效果更好

Tolerance Network

grasp affinity fields:增加扰动还是有效的

摘要

物体抓取在许多应用中都是至关重要的,也是一个具有挑战性的计算机视觉问题。然而,对于复杂的场景,目前的研究存在训练数据不足和缺乏评估基准的问题。在这项工作中,我们提供了一个具有统一评估系统的大规模抓取姿势检测数据集。我们的数据集包含97280个RGB-D图像,超过10亿个抓取姿势。同时,我们的评估系统通过分析计算直接报告抓取是否成功,这能够评估任何种类的抓取姿势,而无需详尽地标记真值。 此外,本文还提出了一种基于点云输入的端到端抓取姿态预测网络,通过解耦的方式学习机器人的接近方向和操作参数,并设计了一种新的抓取亲和度场来提高抓取鲁棒性。实验结果表明,本文的数据集和评估系统能够很好地与真实世界的实验结果相吻合,网络的性能达到了最先进的水平。 我们的数据集、源代码和模型可在www.graspnet.net上公开获取。