- 1打造个性化github主页 二 WakaTime - 动态统计你的工作量_怎么通过wakatime美化github

- 2树莓派科学小实验4B--08_倾斜传感器、干簧管、震动传感器_三个传感器树莓派实验

- 3OPENCV面试题

- 4CTF之逆向Reverse入门推荐学习知识点总结面向新手小白_ctf reverse

- 5springboot集成sse实现后端流式输出消息_springboot流式

- 6Android开发—基于OpenCV实现相机实时图像识别跟踪,入职3个月的Android程序员面临转正_opencv实时图像追踪

- 7小程序云函数调用_小程序云函数抓包

- 86个超级实用的免费网盘搜索网站分享_盘131

- 9遍历HashMap的五种方式_hashmap遍历

- 10kafka基础知识

Stable Diffusion【ControlNet】:ControlNet的IP-Adapter预处理器:SD垫图实现_controlnet预处理器

赞

踩

大家好,今天我们来详细介绍一下ControlNet的预处理器IP-Adapter。简单来说它就是一个垫图的功能,我们在ControlNet插件上传一张图片,然后经过这个预处理器,我们的图片就会在这张上传的图片的基础上进行生成。该预处理器提供的垫图功能,让SD的实用性再上一个新的台阶,在很多方面将彻底改变SD的使用流程。

一.Ip-Adapter是什么

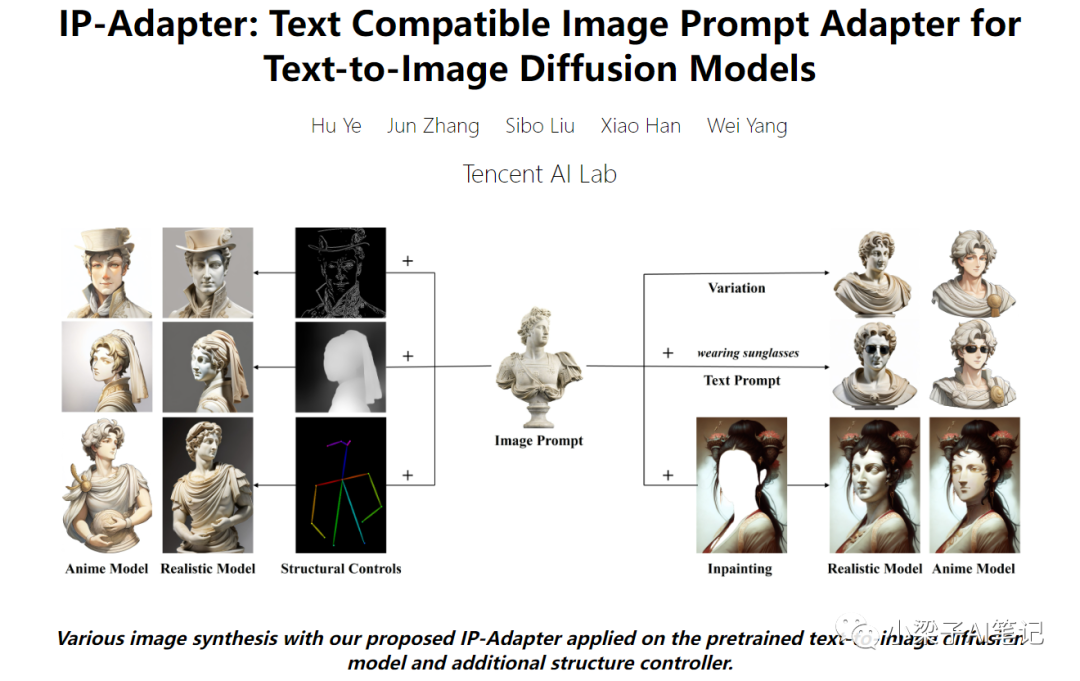

IP-Adapter,它的全称是 Text Compatible Image Prompt Adapter for Text-to-Image Diffusion Models,翻译成中文就是:用于文本到图像扩散模型的文本兼容图像提示适配器,名字有些长,读起来也很拗口。不过我们可以简单的理解就是图片提示或者垫图。

IP-Adapter是腾讯研究院出品的一个新的ControlNet模型,旨在使预训练的文本到图像扩散模型能够生成具有图像提示的图像。使用Stable Diffusion的同学深知提示词的重要性,无论是文生图还是图生图,我们都需要撰写相应的提示词以展现特定元素。为了避免生成不符合期望的内容,我们还需编写反向提示词。提示词可以说是图片的灵魂。

然而,Stable Diffusion 本身支持的提示词都是文本提示词,仅使用文本提示生成所需的图像是非常棘手的,因为它通常涉及复杂的提示工程。文字提示的另一种选择是图片提示,俗话说:“一张图片胜过千言万语”。

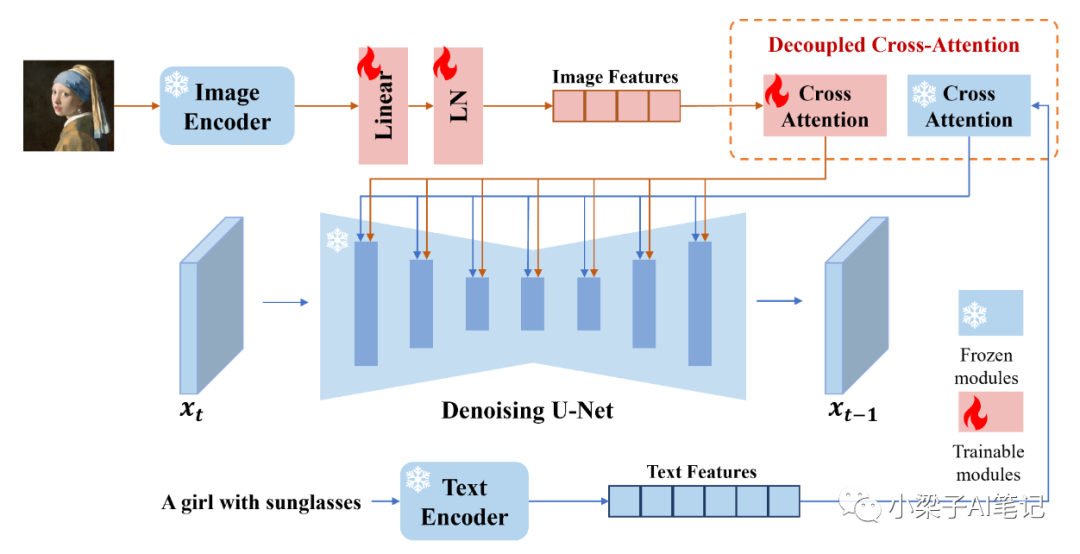

IP-Adapter是一种有效的轻量级适配器,用于实现预训练文本到图像扩散模型的图像提示能力。IP-Adapter的关键设计是分离文本特征和图像特征的交叉注意层的解耦交叉注意机制。仅具有 22M 参数的 IP-Adapter 就可以达到与微调图像提示模型相当甚至更好的性能。

IP-Adapter由两部分组成:图像编码器从图像提示中提取图像特征,以及具有解耦交叉注意机制的自适应模块将图像特征嵌入到预训练的文本到图像扩散模型中。

如果想深入研究IP-Adapter可以参照以下文档。

论文资料:https://ip-adapter.github.io/

项目地址:https://github.com/tencent-ailab/IP-Adapter

二. Ip-Adapter的安装

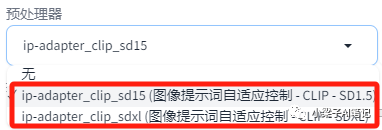

ControlNet中的IP Adapter控制模型相对较新,需要把ControlNet的模型更新到1.1.400以上的版本才可以。升级完成后在预处理器里找到IP-Adapter的选项了。

不过预处理器里没有模型也会报错的。

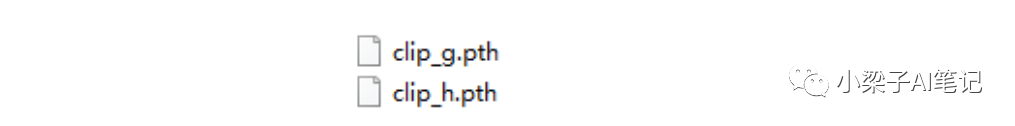

您需要下载这2个预处理器模型放到/extensions/sd-webui-controlnet/annotator/downloads/clip_vision/目录下面即可。

控制模型的下载

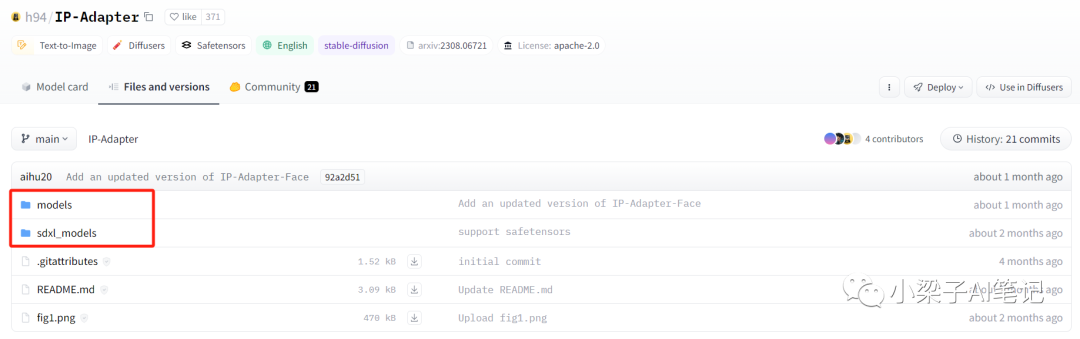

地址:https://huggingface.co/h94/IP-Adapter/tree/main

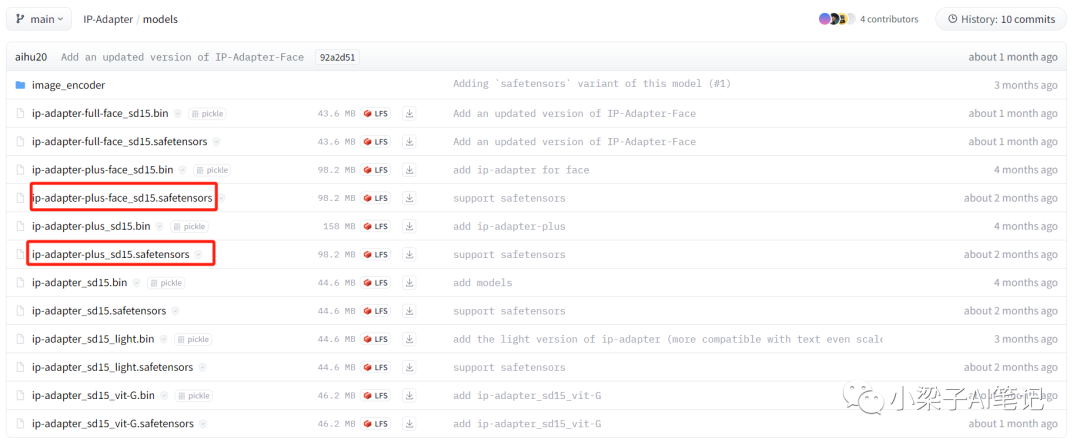

其中,models文件夹下面是适用于SD1.5模型的,下面红框中的2个是目前我们使用最多的。

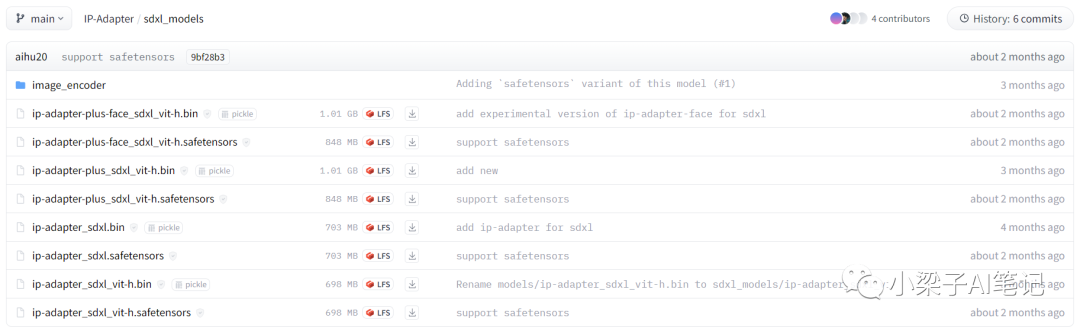

sdxl_models文件夹下面是适用于SDXL模型的。

下载完成后放到/extensions/sd-webui-controlnet/models/目录下面即可。

三. IP-Adapter的使用(官网)

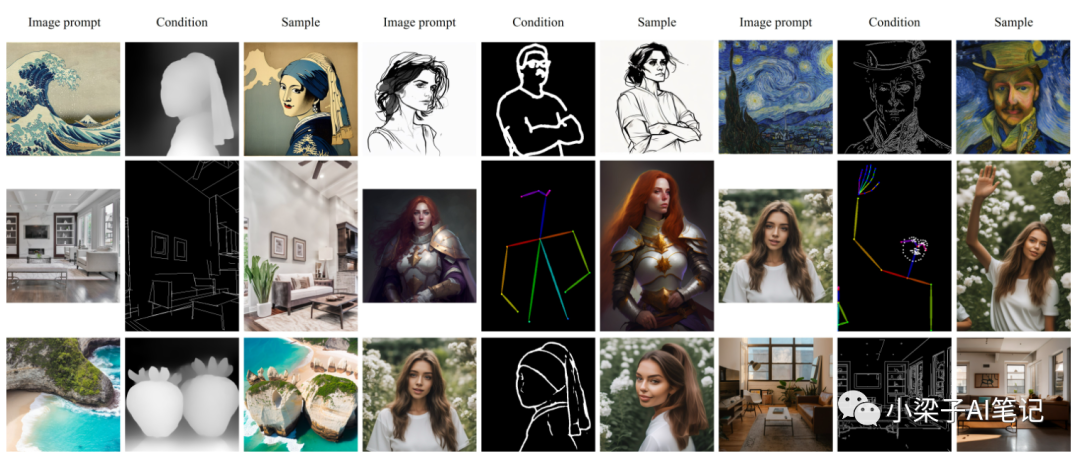

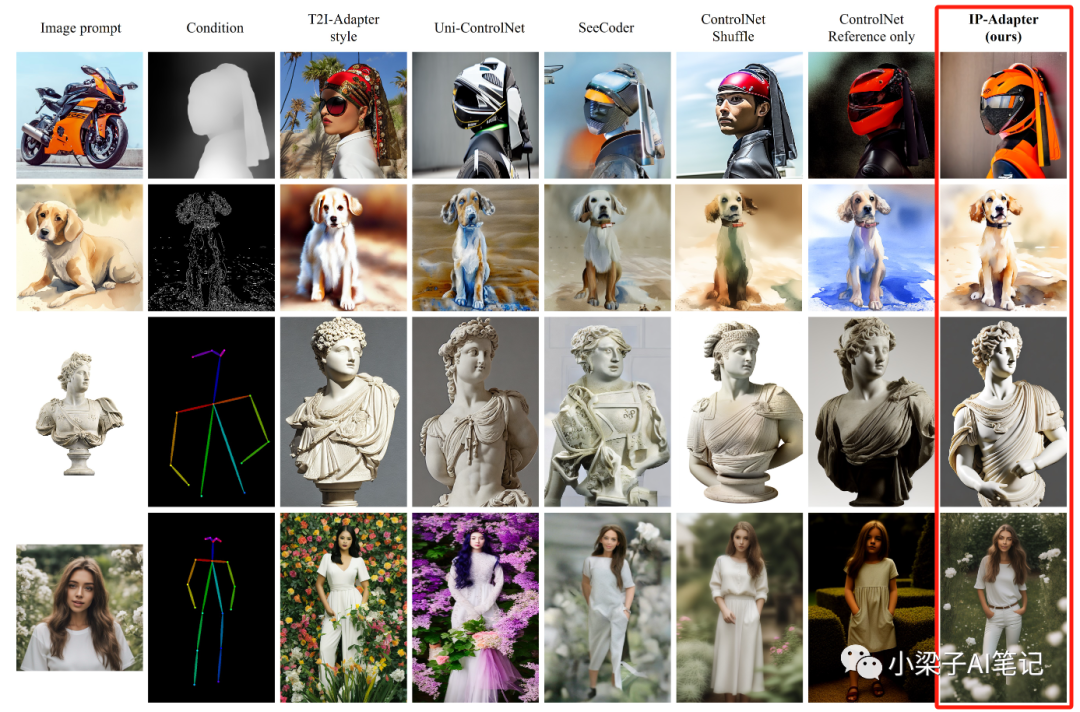

在IP-Adapter官网有很多使用效果实例,我们先直观的看一下,以便对IP-Adapter的应用有一个直观的了解和感受。

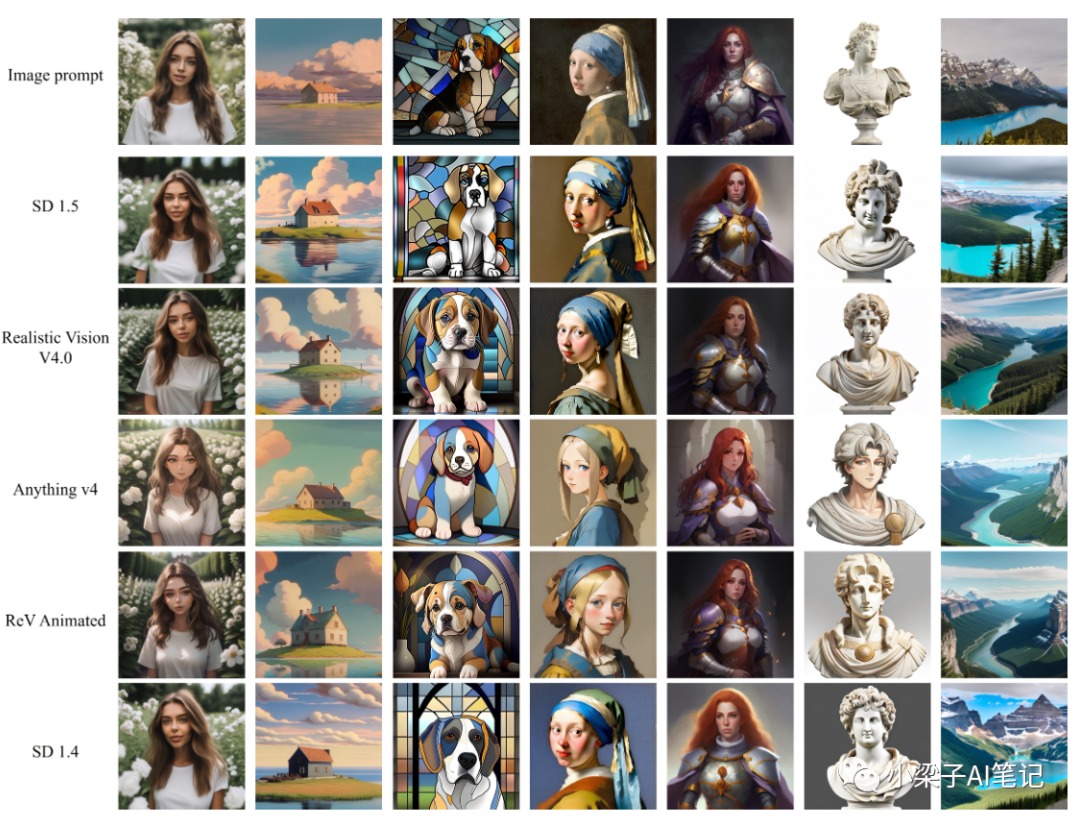

(1)一张图片在不同大模型下的不同效果。

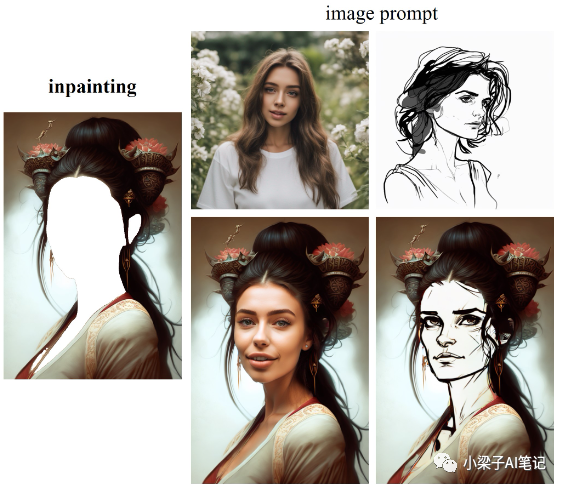

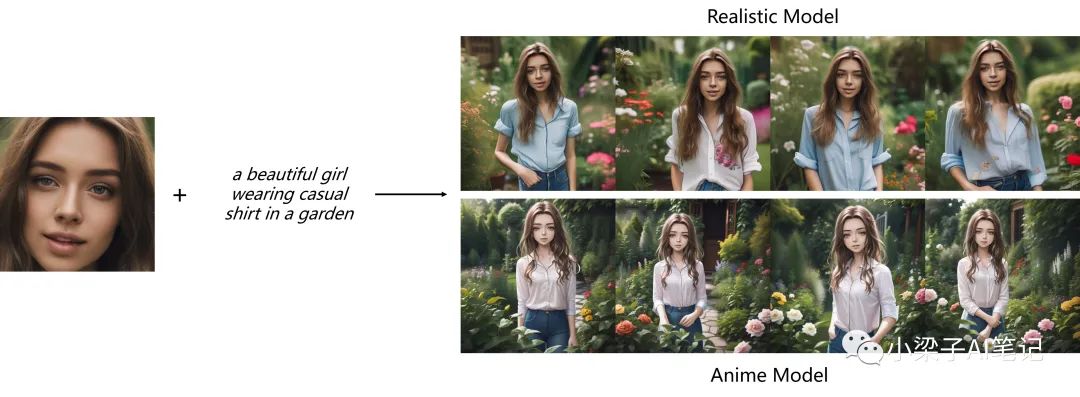

(2)图生图

(3)局部重绘

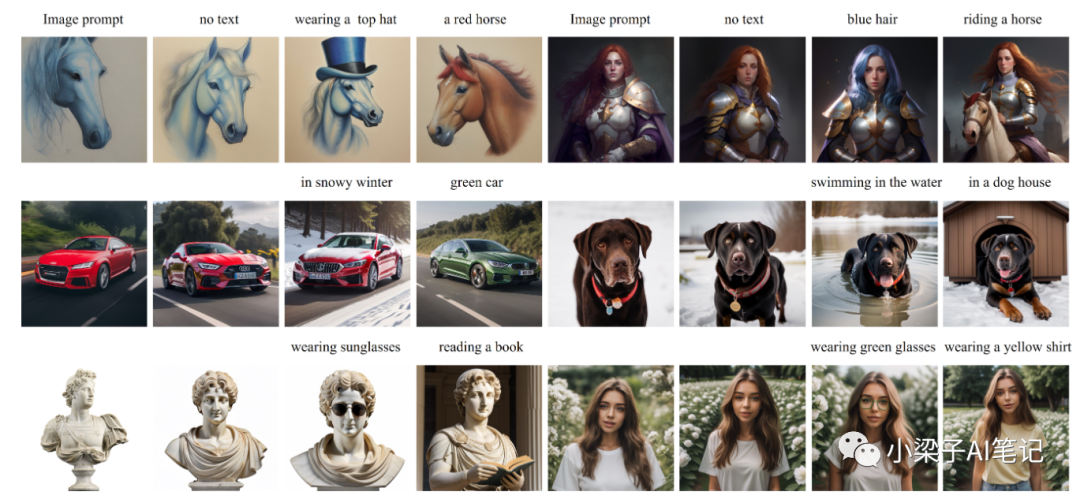

(4)图像提示+文本提示

(5) IP_Adapter与T2I-Adapter结合使用

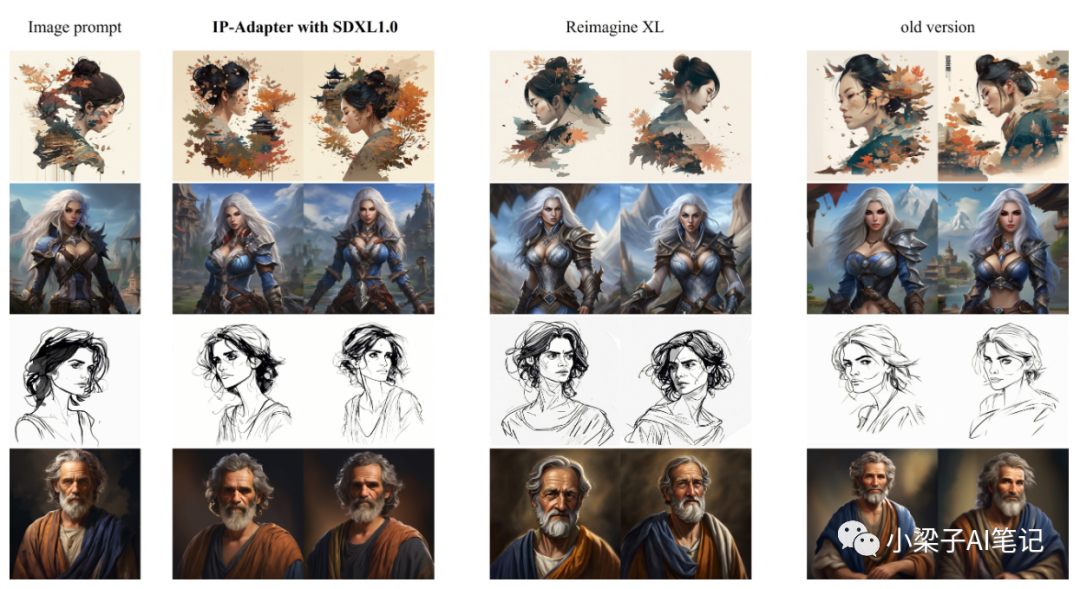

(6)SDXL1.0

IP-Adapter不仅在图像质量方面优于其他方法,而且生成的图像与参考图像能更好地对齐。

四. Ip-Adapter的初体验

下面我们使用一个最简单的实例来体验一下IP-Adapter的具体使用。

这里我们不使用任何正向提示词和反向提示词。

文生图相关参数设置

-

采样器:DPM++2M Karras

-

采样迭代步数:30

-

图片宽高:保持和上传图片的宽高一致即可

ControlNet参数设置如下:

相关参数设置如下:

-

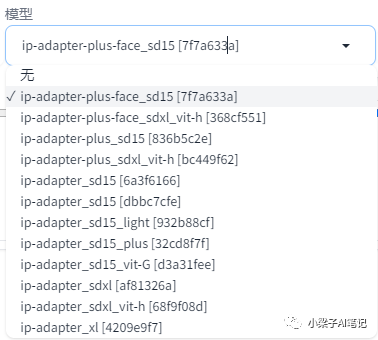

控制类型:选择"IP-Adapter"

-

预处理器:ip-adapter_clip_sd15

-

模型:ip-adapter_sd15_plus(最大程度的还原原参考图,建议选择该模型)

-

控制权重:设置为0.5。

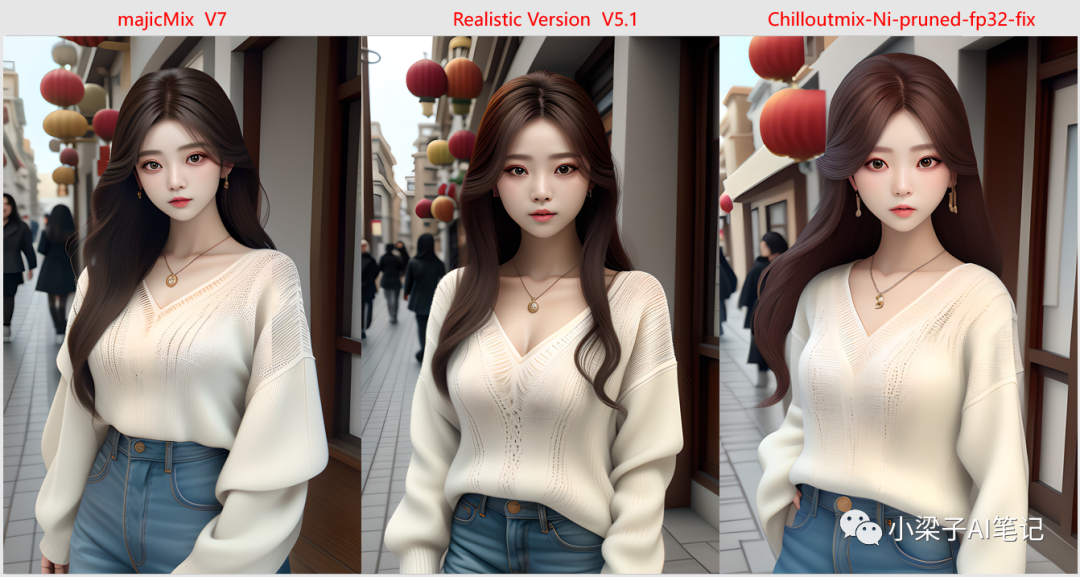

这里我们选择不同的大模型看一下生成图片的效果。

原图:

下面是不同真人模型下生成图片的效果图。

主体的脸型、发型、服装、姿势和参考图都挺像的,背景也基本都是相同的内容,只是不同的大模型也会有大模型各自的特色。

我们将IP-Adapter控制模型为ip-adapter_sd15。

主体的脸型、发型与参考图挺像的,背景,人物姿势和服装在不同的大模型下发生了一些变化,可见ip-adapter_sd15生成图片的相似度不如ip-adapter_sd15_plus。

我们将IP-Adapter控制模型为ip-adapter-plus-face_sd15。该控制器只能保存脸型和发型的一致,服装、人物姿势和图片背景变化就非常大了。毕竟从控制器的名称就可以看出来,该控制器只保持脸部相关的一致。

IP-Adapter控制器是SD中实现垫图效果的一个非常重要的功能,有很多的不同的玩法和应用场景,后面的文章中还会继续分享,大家可以继续保持关注。

好了,今天的分享就到这里了,希望今天分享的内容对大家有所帮助。 文章使用的AI绘画SD整合包、各种模型插件、提示词、AI人工智能学习资料都已经打包好放在网盘中了,有需要的小伙伴文末扫码自行获取。

写在最后

AIGC技术的未来发展前景广阔,随着人工智能技术的不断发展,AIGC技术也将不断提高。未来,AIGC技术将在游戏和计算领域得到更广泛的应用,使游戏和计算系统具有更高效、更智能、更灵活的特性。同时,AIGC技术也将与人工智能技术紧密结合,在更多的领域得到广泛应用,对程序员来说影响至关重要。未来,AIGC技术将继续得到提高,同时也将与人工智能技术紧密结合,在更多的领域得到广泛应用。

感兴趣的小伙伴,赠送全套AIGC学习资料和安装工具,包含AI绘画、AI人工智能等前沿科技教程,模型插件,具体看下方。

一、AIGC所有方向的学习路线

AIGC所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

二、AIGC必备工具

工具都帮大家整理好了,安装就可直接上手!

三、最新AIGC学习笔记

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

五、实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

若有侵权,请联系删除

若有侵权,请联系删除