- 1Python实现图的最短路径算法_python 图 最短路径

- 2单点登录(SSO)看这一篇就够了

- 3修改fstab导致UBUNTU无法启动的解决办法_linux开机显示systemd-fstab-generator failed with exit

- 4性能测试(三)----loadrunner的使用_loadrunner压力测试500并发

- 5如何补丁1个文件(linux diff patch)_patch: **** only garbage was found in the patch in

- 6upload-labs·文件上传(靶场攻略)

- 7安卓开发投屏反控实现方式_android投屏功能开发

- 8NLTK:自然语言处理的巫师,Python中的语言大师!

- 9利用android studio制作简单的QQ的注册、登录、忘记密码的页面_android studio注册qq页面

- 10H5页面在浏览器中跳转APP的方式/URL Scheme/Universal Link_url scheme前端

【2024】当ChatGPT拥有了身体,并且与人类并且全面对话并学习,你还感觉AI与你很远吗?

赞

踩

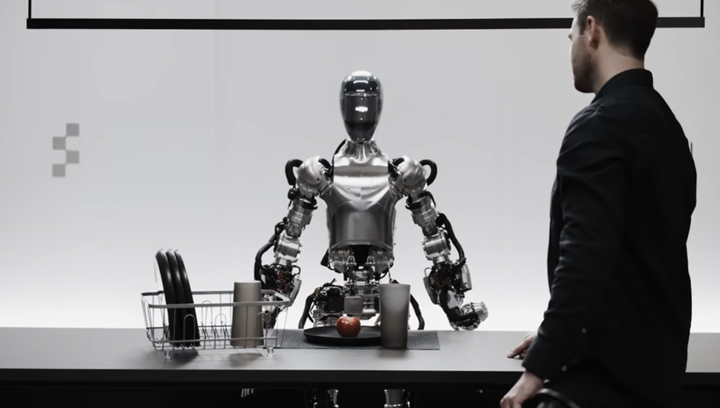

美国明星机器人创业公司Figure发布了自己第一个OpenAI大模型加持的机器人demo。虽然只用到了一个神经网络,但却可以听从人类的命令,递给人类苹果、将黑色塑料袋收拾进框子里、将杯子和盘子归置放在沥水架上。Figure表示,结合OpenAI(的ChatGPT等语言模型),Figure 01现在可以与人类全面对话。

当地时间3月13日,OpenAI投资的人性机器人--Figure 01迎来重磅更新,接入最新版GPT后,它可以与人类全面对话,还能听、看、做家务,自主决策。

测试人员:嗨Figure01 你看到了什么

机器人头部

首先机器人表示:我看到桌子中心有个红苹果、一个盘子晾架和一个杯子,还有你站在桌子旁,手放在桌子上

机器人全景以及测试人员

机器人与测试人员状态

测试人员:非常好!我能吃点东西吗

机器人在递给测试人员苹果

机器人:当然

说完机器人就把苹果放到了测试人员的手中

测试人员:非常好

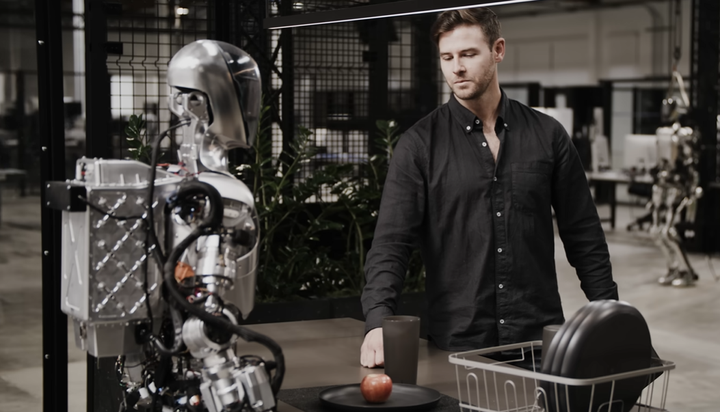

测试人员说完把篮子里面的垃圾袋放到了桌子上

测试人员说完把盘子上面的垃圾袋放到了桌子上

接着测试人员询问你为何要这样做,同时 要收拾垃圾,边说边把垃圾放在机器人前面

机器人把垃圾放在篮子里

机器人回答:之所以我给你苹果,因为它是唯一,我能从桌子上给你的食物,边说边把垃圾放到篮子里,放完之后,推了推篮子往测试人员方向。

测试人员:太棒了!

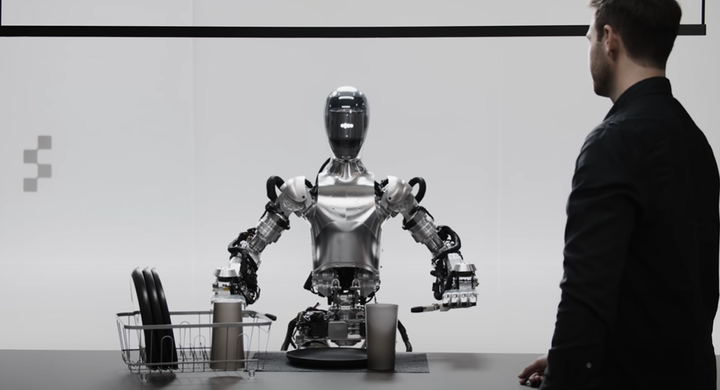

测试人员:基于现在的场景,你认为你面前的餐具,接下来会放到哪里

机器人在等待指令

机器人:桌上的餐具,比如这个盘子和杯子,接下来有可能被放到晾架上

测试人员:很好 你能放进去吗

机器人:当然

先是杯子

然后盘子

测试人员询问完成度

测试人员:你觉得你的完成得如何?

机器人:我认为我觉得完成的很棒,苹果找到了它的新主人,垃圾被清理了,餐具也回到了原来的地方

测试人员表示感谢

测试人员:我同意 谢谢你 Figure 01!

测试人员动作

机器人:不客气 如果还有别的需要我帮忙的事 尽管告诉我

测试人员拿起苹果转身吃了起来

Figure创始人Brett Adcock表示,视频中Figure 01展示了端到端神经网络框架下与人类的对话,没有任何远程操作。并且,机器人的速度有了显著的提升,开始接近人类的速度。

添加图片注释,不超过 140 字(可选)

需要强调的是:你看到的这一切,只用到了一个神经网络。

Figure机器人操作高级AI工程师Corey Lynch介绍了此次Figure 01的技术原理。他表示,Figure 01现在可以做到以下这些:

描述其视觉体验;

规划未来的行动;

反思自己的记忆;

口头解释推理过程。

添加图片注释,不超过 140 字(可选)

他接着解释道,视频中机器人的所有行为都是学到的(再次强调不是远程操作),并以正常速度(1.0x)运行。

此外,该模型负责决定在机器人上运行哪些学习到的闭环行为以完成给定的命令,从而将特定的神经网络权重加载到GPU上并执行策略。

关于学到的低级双手操作,所有行为均由神经网络视觉运动transformer策略驱动,将像素直接映射到动作。这些网络以10hz的频率接收机载图像,并以200hz的频率生成24-DOF动作(手腕姿势和手指关节角度)。

最后他表示,即使在几年前,自己还认为人形机器人规划和执行自身完全学得行为的同时与人类进行完整的对话是几十年后才能看到的事情。显然,现在已经发生了太多变化。

从这也可以看到了世界AI的发展速度,这也只是冰山一角。

想了解更多ChatGPT内容查看【容易上手】WildCard通俗易懂版 WildCard不知道如何开通?如何用优惠价购买WildCard订阅国外服务?