热门标签

热门文章

- 1AI辅写疑似度怎么查看:七个简单步骤详解_ai疑似度查询

- 2论文翻译 | FCOSv2:《FCOS: A Simple and Strong Anchor-free Object Detector》

- 3NSSCTF题解

- 4vue项目UEditor富文本编辑器升级(从1.4.3升级到1.5.0)_edui-editor

- 5如何区分一段代码是C++还是C代码编写的_怎么看出来一个程序是c加加

- 6猿创征文|低代码开发15个高效开源项目推荐_低代码 开源_开源低代码

- 7自动抢票神器,低调使用,随时被下架_bypass不能用了吗

- 8代码随想录算法训练营第三十八天|● 理论基础 ● 509. 斐波那契数 ● 70. 爬楼梯 ● 746. 使用最小花费爬楼梯

- 9开源与在线 M3U8 Downloader 项目介绍及使用指南

- 10全志T113开发板Qt远程调试_全志t113开发版

当前位置: article > 正文

LSTM原理+实战(Python)_lstm实战

作者:秋刀鱼在做梦 | 2024-06-21 05:16:22

赞

踩

lstm实战

目录

1 LSTM原理

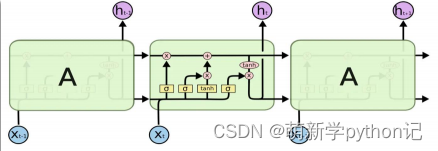

LSTM(Long Short-Term Memory),作为一种特殊的循环神经网络(RNN)结构,通过引入遗忘门、输入门和输出门这三种类型的门控机制来控制信息的流动,从而有效解决了传统RNN在处理长序列时容易出现的梯度消失和梯度爆炸问题。这些门结构使得LSTM能够记住长期依赖的信息,并在自然语言处理、语音识别、机器翻译等众多领域中展现出强大的序列处理能力。

2 LSTM与RNN的区别

LSTM

是RNN一种,大体结构几乎一样。区别是:它的“记忆细胞”改造过、该记的信息会一直传递,不该记的会被“门”截断。

原始

RNN

的隐藏层只有一个状态,即

h,它对于短期的输入非常敏感。LSTM再增加一个状态,即 c,让它来保存长期的状态,称为

单元状态(cell state) 或内部记忆单元或内部状态。其中c 记录了当前时刻为止的所有历史信息。

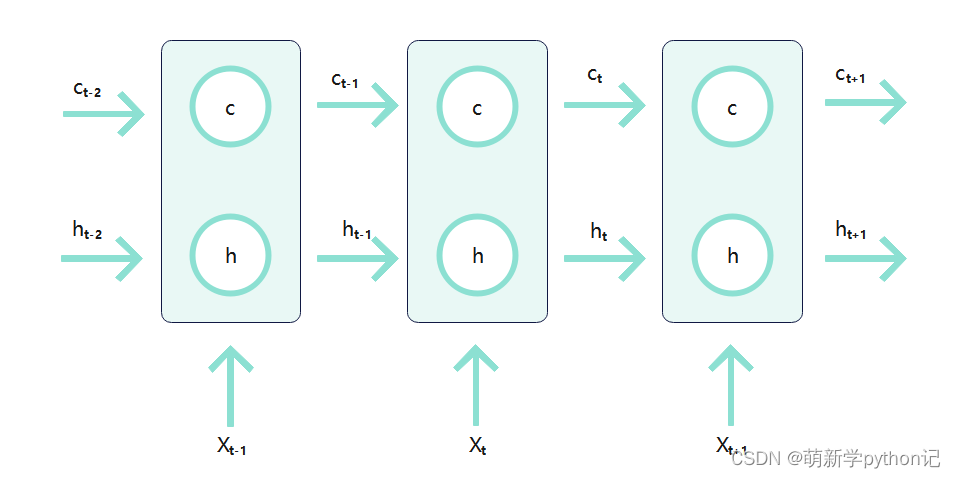

在

t

时刻,

LSTM

的

输入

有三个: 当前时刻网络的输入值 x

t ;

上一时刻LSTM

的输出值

h

t

−1;

以及上一时刻的单元状态

c

t

−1。

LSTM的

输出

有两个:当前时刻LSTM

输出值

h

t

; 和当前时刻的单元状态 c

t。

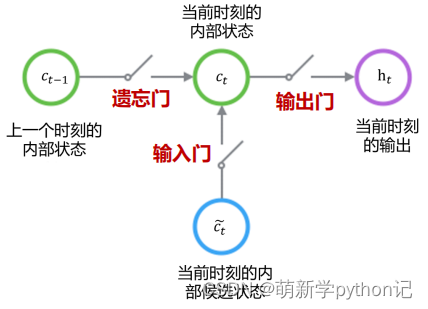

3.2 控制c和h的构架

遗忘门(forget gate):① 遗忘门可以保存很久很久之前的信息。 ② 它决定了上一时刻的单元内部状态 声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/秋刀鱼在做梦/article/detail/742160

推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。