- 1【Qwen2部署实战】探索Qwen2-7B:通过FastApi框架实现API的部署与调用_qwen2 api调用

- 2秋招面试题系列- - -Java 工程师(六)

- 3【SQL】索引过多的缺点_索引过多的副作用

- 4拉格朗日插值法在数据分析中的应用——Python插值scimpy,lagrange_拉格朗日插值在数据清洗的应用

- 5美的集团计算机综合面试群面,世界500强美的集团群面经验分享

- 6Python基础学习:序列数据结构(列表与元组)_python a sequence结构

- 7冒泡排序(不断将大的数字向下沉)_冒泡排序大数下沉

- 8并行CRC计算HDL代码生成工具的秘密(六字真言)_并行crc在线计算

- 9AIGC-Stable Diffusion发展及原理总结_aigc生成训练数据

- 10c++初级-2-引用

笔记:Visualizing Deep Networks by Optimizing with Integrated Gradients

赞

踩

原文:https://www.researchgate.net/publication/332873867_Visualizing_Deep_Networks_by_Optimizing_with_Integrated_Gradients

作者:Zhongang Qi, Saeed Khorram, Li Fuxin School of Electrical Engineering and Computer Science, Oregon State University

收录于CVPR 2019

Abstract

针对heatmap可视化深层网络时,heatmap与网络无关误导解释的问题,提出了I-GOS(Integrated-Gradients Optimized Saliency) 方法对heatmap进行优化,使遮蔽后的图像分类得分最大程度降低(有点像perturbation based 方法)。

新颖:提出以积分梯度代替常规梯度计算下降方向,避免了局部最优,加快了收敛速度。

优势:与以前的方法相比,我们的方法可以根据不同的用户需求灵活地计算出任意分辨率的热图;实验证明我们的方法生成的heatmap与底层深层网络做的决策更相关(而不是修复输入图像本身)。

1.Introduction

介绍了深度学习解释性和heatmap。

解释深层神经网络的方法,GBP,DeconvNet,指出他们的问题:本质上是在做(部分)图像恢复,突出对象的边界从而产生更多人类可解释的视图,这并不一定代表模型真正学到的东西。

Perturbation Based早期方法——直接优化deletion-game:收敛太慢。

积分梯度方法——产生的heatmap不明确,难理解。

上述方法对比:

模型对靛蓝彩鹀的原预测概率是100%,在三种方法计算出的像素占比都是6.4%的情况下,删除这部分像素,I-GOS预测的概率最低,只显示这部分像素,I-GOS预测的概率最高,说明I-GOS计算出的heatmap和模型决策最一致(模型:没你我就无法识别,有你我就能识别,因此你最合我意)。

我们的方法:

在本文中,我们提出了一种新的可视化方法I-GOS(积分梯度优化显著性),它利用积分梯度改进了《perturbation based…》中的掩模优化方法。该思想是,积分梯度所提供的方向可能会产生比正常梯度可更好的全局最优,因此,我们将掩模优化中的梯度替换为积分梯度。由于积分梯度的计算成本较高,我们采用了基于线搜索的梯度投影法来最大限度地利用积分梯度的每一次计算(不积分了,直接累加步数)。我们的方法生成了更好的热图,并且与原始掩模优化相比,使用了更少的计算时间,因为线搜索在寻找合适的步长方面更有效,允许更少的迭代使用。

贡献如下:

1.我们开发了一种新的热图可视化方法I-GOS,它优化了一个使用集成梯度作为下降步骤的掩模。

2.通过正则化和微扰,我们更好地避免了在更高分辨率下产生对抗性遮罩,从而使更详细的热图与模型的决策更相关。

3.大量的评估表明,所提出的方法比最先进的方法表现得更好,特别是在insertion和deletion metrics。

2.Related Work

Backpropagation Based…

Perturbation Based…

人类注视…

3.Model Formulation

3.1 梯度和掩模优化

介绍了梯度在输入图像变化导致分类得分变化过程中的意义。

介绍了perturbation based方向上的Mask计算方法:

3.2 积分梯度

公式3对从基像素(基图的像素,理解为全黑全白的图,用来做insertion/deletion game)到原像素的整个过程的梯度求积分,不是只求原像素的梯度,求的是梯度积分,连续过程。

有论文证明过,像素的积分梯度累加起来就是图片得分的差,公式4成立:

(3)中的积分使用近似法求,把积分区间分成一段一段,累加起来(这里已经不是像素了,是图了):

S就是分成的段数,一般为20,附录有数学证明。

下图解释了积分梯度的过程:

A到B,分段累加,控制梯度收敛。

3.3 Integrated Gradients Optimized Heatmaps

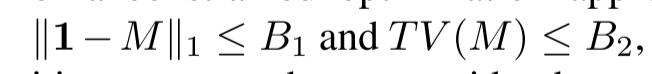

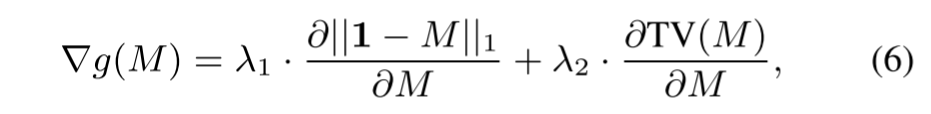

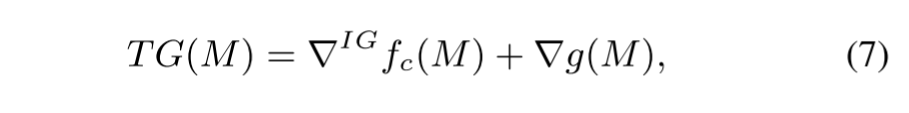

本文的改进源于公式(2)中正则函数g(M),和公式(2)直接对原图求梯度的缺陷。

原正则函数类似 ,导致模型的优化受到限制。上图中的黑色虚线就是原方法的限制范围,加上直接求梯度使得模型无法感知全局的梯度变化,会找到局部最优C;而积分梯度则能改善直接求梯度的不足。

,导致模型的优化受到限制。上图中的黑色虚线就是原方法的限制范围,加上直接求梯度使得模型无法感知全局的梯度变化,会找到局部最优C;而积分梯度则能改善直接求梯度的不足。

因此本文把积分梯度带入到公式(2)中,将原正则函数求偏导:

合起来就是IGOS:

3.4 Computing the step size

为了优化集成梯度的计算,使用了回溯线搜索方法并修改了Armijo条件来帮助计算总梯度的适当步长(这里的修改的理由感觉有点主观,没有数学证明,可以保证方向是正确的,但是数值会不会对结果有影响,修改后的回溯线搜索):

α是步长;β是一个参数(0,1),具体搜索方法:

3.5 Avoiding adversarial examples

降低对抗样本措施:添加噪声和降低mask的像素。

实验

思路清晰