热门标签

热门文章

- 1ElementUI之表格组件

- 2git clone时curl 18 transfer closed with outstanding read data remaining_error: rpc failed; curl 18 transfer closed with ou

- 3数据结构之堆_堆分为大根堆和小跟堆

- 4Qt Window Dialog 无标题栏 ,无边框,可拖动_qt dialog创建无标题栏

- 5泊松分布的通俗理解、推导与应用

- 6前端基础汇总_前端 技术

- 7SQL Server数据库简单查询_sql server查询

- 8【C++】STL 容器 - queue 队列容器 ( queue 容器简介 | queue 容器特点 | push 函数 | pop 函数 | front 函数 )_c++ stl中queue中使用push在队尾插入以及使用pop从队首删除

- 9如何获取注册高德Key使用的SHA1值与包名?_s证书sha1值和apk的sha1不一样

- 10文献学习-14-一种用于高精度微创手术的纤维机器人

当前位置: article > 正文

LLM-202210:GLM【开源双语预训练语言模型】_glm与llm

作者:笔触狂放9 | 2024-06-13 06:46:01

赞

踩

glm与llm

《GLM: General Language Model Pretraining with Autoregressive Blank Infilling》

《GLM-130B: An open bilingual pre-trained model》

一、简介

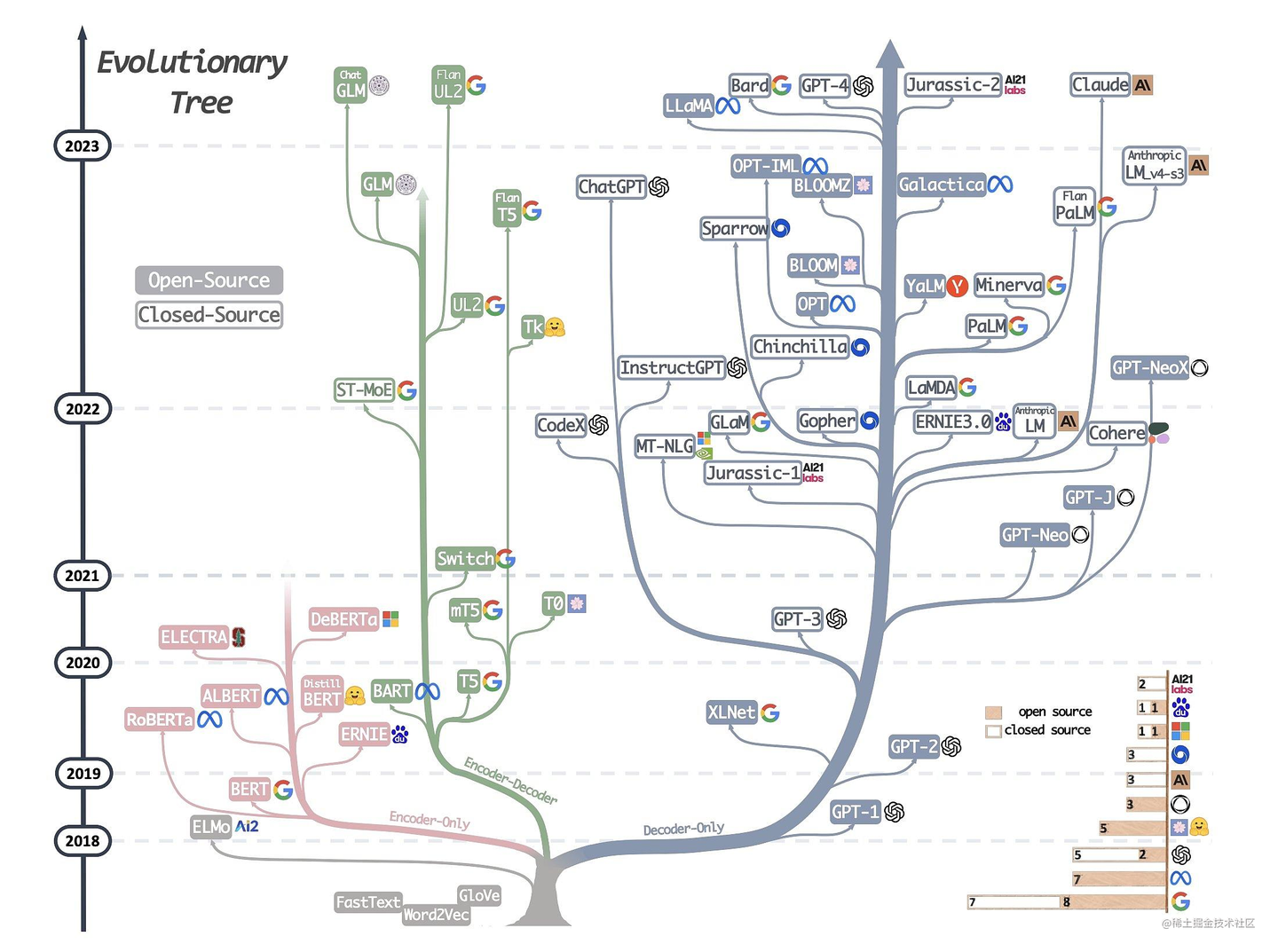

已经有各种类型的预训练架构,包括自编码模型(如BERT),自回归模型(如GPT),以及编码器-解码器模型(如T5)。然而,没有一个预训练框架对包括自然语言理解(NLU)、无条件生成和有条件生成在内的三个主要类别的所有任务表现最好。我们提出了一

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/笔触狂放9/article/detail/711292

推荐阅读

相关标签