- 1函数式编程思想

- 2UCAS - AI学院 - 自然语言处理专项课 - 第11讲 - 课程笔记_噪声信道模型统计翻译的原理

- 3Struts2系列漏洞利用工具-Struts2-Scan(二)_struts2全版本漏洞检测工具

- 4Flutter、ReactNative、uniapp对比_uniapp react native

- 5大数据分析人工智能AI如何管理新冠病毒

- 6门店数据-地图点位数据-大众点评数据分享-2024年2月数据_高德地图 成都 咖啡店 搜索数据

- 7【Git】详解本地仓库的创建、配置以及工作区、暂存区、版本库的认识_git配置本地仓库

- 8linux下解决 git clone每次都要输入用户名密码问题_gitclone需要输入密码

- 9redis数据库简介、redis下载及安装(win64位)、node操作redis、redis实现短信校验注册接口_redis下载官网

- 10区块链的发展趋势,并对C++与区块链相结合进行介绍_c++在区块链领域怎么样

判断人工智能是否可信的“四把尺子”_如何判断人工智能信息的真实性和权威性

赞

踩

1. 前世今生

今天介绍一下可信人工智能的前世今生。人工智能并不是一个新的概念,从1950年的图灵之问开始,到今天产业的蓬勃发展。起起伏伏,人工智能已经走过了三次浪潮,甚至有学者认为,我们今天正处在第四次浪潮,其特点是:广泛的产业落地。

正是由于“落地”,所以才带来了一些问题,因此讨论可信AI正是时候。先来看一些可信AI的例子,大家在网上购物的时候,经常会使用拍照购这一功能,其使用的是计算机识别技术。如果拍照购识别的照片含有“小标签”或者被遮挡了一下,那么这个时候,AI系统就无法准确识别;我们曾经对自动驾驶系统做过一个实验,如果将小广告贴在道路交通牌上,那么就到导致自动驾驶系统误判。

因为人工智能缺乏可解释性,这也限制了人工智能更广泛的应用和赋能。举个例子,无人驾驶车辆在道路上出现事故,该如何定责任?由于无法解释,在将驾驶权从人类转交到人工智能系统的过程中就会产生困难。毕竟,人类驾驶员无法在短短的几秒钟之内对道路情况进行及时的判断。

此外,无论是欧盟的GDPR,还是中国的个人信息保护法,都表明用户的个人信息在使用的时候必须谨慎。这其实也对人工智能系统的模型提出了很多要求。

另一方面,不仅仅是成年人在使用人工智能系统,儿童同样在使用,如何公平地考虑各种因素,保证所有人都公平享受到技术带来的价值,也是人工智能领域从业者所要思考的。

在上述急迫的需求下,2016年欧洲颁布《通用数据保护条例》,2017年12月份,IEEE提出了《人工智能的伦理设计准则》。之后澳洲、美国等多个国家和地区也相继发布相关政策、指南、白皮书。

国内情况如何呢?中国科学家何积丰院士于 2017 年11 月香山科学会议第 S36 次学术研讨会首次在国内提出了 可信人工智能的概念,即人工智能技术本身应具备可信的品质。2017年12月份,工信部发布了《促进新一代人工智能产业发展三年行动计划》,在此之后,中国的科技公司都提出了相应的可信人工智能发展规划。

2019年10月,京东首次在乌镇世界互联网大会提出践行“可信赖AI”六大维度;2021年4月份,可信人工智能正式列为京东探索研究院主要研究方向之一。

其实,可信人工智能也并不是一个新的概念,很多组织或者机构都在谈论可信人工智能。从2017年到今天,已经诞生了许多概念,例如IEEE提出了透明性,以正确的方式使用技术,以人为本,明确责任,造福人类。澳大利亚提出了隐私保护,明确责任,提高透明性和可解释性等。

在中国,我们更多地谈到包容共享、和谐友好、公平公正、安全可控等等几个维度。在学术研究方面,在1998年甚至更早,就有隐私保护、数据治理、公平包容、明确责任等等相关方面的科技文献。

综上,可信涉及的领域非常多,那么这些领域之间有何关系?例如安全可靠意味着什么?它和稳定性和可解释性有什么关系?而在造福社会等主题中,可解释性、隐私保护、公平性在其中发挥怎样的作用?

2. 四把尺子

接下来,我会从四个方面进行“可信”度量,包括:稳定性、可解释性、隐私保护、公平性,可以称之为可信AI判断的四把尺子。

其中,稳定性是指:人工智能系统能够抵抗恶意攻击;可解释性是指:人工智能系统所作出的决策需要让人类能够理解;隐私保护是指:人工智能系统不能把个人的隐私信息或者群体的隐私信息进行泄露;公平性是指:人工智能公平对待所有用户。

如果人工智能在以上四大度量上都达到很高的水平,就能够做到明确责任、透明可信。

稳定性的度量有很多种方式,例如对抗攻击、中毒攻击和后门攻击。这些攻击都会影响人工智能系统,我们需要度量系统在面对这些攻击时,是否足够稳定。这些攻击技术既可互相独立也可以同时存在。

下面举例说明这几种攻击方式:中毒攻击通过按照特殊的规则进行恶意评论等方式,向训练数据集投入干扰数据,继而影响推荐系统的准确度;对抗攻击通过在道路交通标志牌上贴上特殊设计的图案,可以误导自动驾驶系统使其错误识别路牌上的信息,进而造成交通事故;后门攻击具有隐蔽性,可能会被用于对 AI 供应链发动攻击。相比于传统的软件系统,此类干扰对人工智能系统的稳定性影响更大。

可解释性的度量包含很多方面,例如我们如何描述模型的泛化能力?如何理解神经网络损失曲面的几何结构等等。其实,除了模型和算法的可解释性之外,训练样本、测试样本的可解释性也非常重要。人工智能的可解释性还有非常远的路要走,需要学术界在深度学习及人工智能的基础数学理论方面继续发力,只有找到合适的数学工具、统计工具、几何工具才能够有效的描述人工智能系统的可解释性。

今天,人们越来越重视隐私保护,我们在使用人工智能系统的时候,非常想了解它是否保护了我们的个人隐私不受侵犯。如何度量模型的隐私保护能力呢?差分隐私是一个主要的量化指标。其核心思想是,一个具有优秀隐私保护能力的人工智能算法,应当对输入数据中的微小扰动不敏感。

通俗理解是:我们使用一个数据库进行模型训练,对此数据库进行微调之后,就得到了另外一个数据库,然后用微调的数据库再次训练人工智能模型,就会得到另一个模型,最后,衡量两个模型之间的差异,量化模型的隐私保护能力。

基于该思想,可以通过对数据进行下采样、顺序置换、添加噪声等方式,来防御攻击者的隐私窃取行为。

此外,隐私攻击方式也可以用来衡量模型的隐私保护能力。常用的攻击方式有成员推断攻击、模型反转攻击等等。如果攻击的成功率越低,表明模型的隐私保护能力越强。

关于公平性,我们需要考虑个体公平和群体公平两个方面。对于不同的个体,我们希望系统不要有偏差。这非常困难,即使对于人类而言,这也是很难达到的。例如,在参加委员会表决的过程中,为了消除Cultural Specials,通常会有专门的培训。至于群体的公平性,则需要考虑大群体和小群体。

3. 统一框架

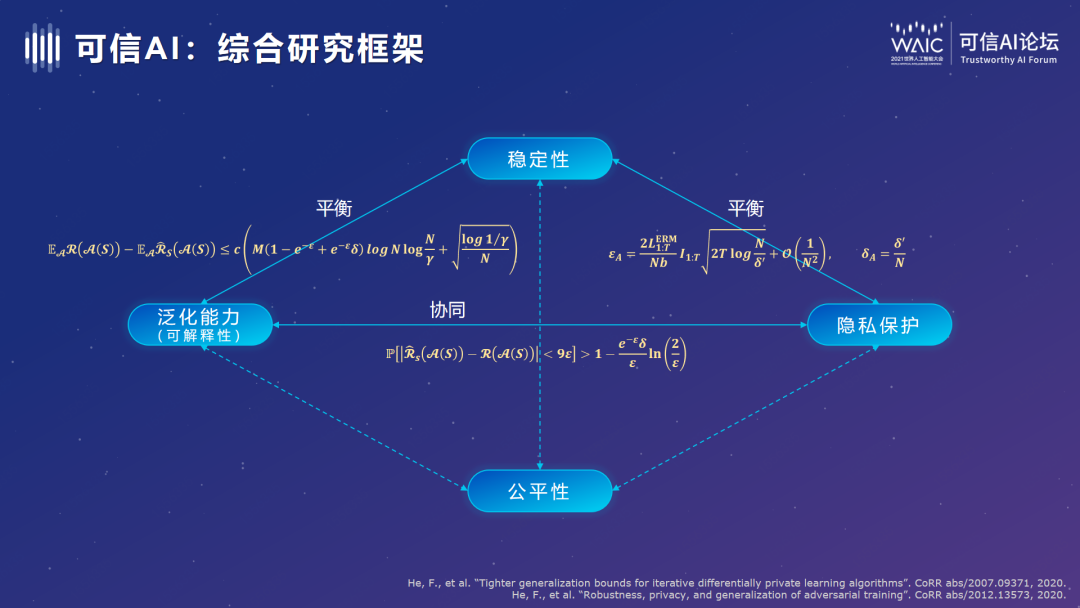

那么,稳定性、隐私保护、公平性、可解释性(泛化能力),它们之间有何联系?如何相互影响?其实需要深入研究。目前对于隐私保护和可解释性之间的关系,我们已经有了初步的研究成果:例如,通过利用差分隐私来解释泛化能力,我们发现模型的泛化能力和隐私保护能力具有协同性。

至于泛化能力和公平性,稳定性和公平性,公平性和隐私保护之间是什么样的关系,有待于我们进一步考察,有可能是协同的,也可能是平衡的。

要想最终实现可信人工智能,就要找到统一的综合治理框架。也就是说,我们需要构建可信人工智能的大一统理论,帮助我们实现有效的可信治理。