- 1Mac电脑安装蚁剑_mac安装蚁剑

- 2Python函数(一):函数的声明、调用以及参数的使用_python 声明函数

- 3AI学习日记——关于Labelme的一些小问题_labelme标注png图片为单通道

- 4Python与Scratch的双向通信_scratch与python结合

- 5快速搞定前端JS面试 -- 第十二章 运行环境 (页面加载、性能优化、安全)(1)

- 6JAVA设计模式学习21——命令模式

- 7手动修改docker中oceanbase-ce容器cpu资源使用上限

- 8python写玫瑰花代码_玫瑰花的python程序代码

- 9OSPF邻居邻接关系

- 10基于NASA C-MAPSS数据的剩余机械寿命RUL预测,Python代码(添加了非常详细中文注释),线性回归LR、支持向量回归SVR、随机森林回归RF、xgboost模型_c-mapss rul怎么取的

YOLOv8算法改进【NO.97】借鉴YOLOv7算法的方法添加辅助训练头_yolov8遥感图像的改进

赞

踩

前 言

YOLO算法改进系列出到这,很多朋友问改进如何选择是最佳的,下面我就根据个人多年的写作发文章以及指导发文章的经验来看,按照优先顺序进行排序讲解YOLO算法改进方法的顺序选择。具体有需求的同学可以私信我沟通:第一,创新主干特征提取网络,将整个Backbone改进为其他的网络,比如这篇文章中的整个方法,直接将Backbone替换掉,理由是这种改进如果有效果,那么改进点就很值得写,不算是堆积木那种,也可以说是一种新的算法,所以做实验的话建议朋友们优先尝试这种改法。

第二,创新特征融合网络,这个同理第一,比如将原yolo算法PANet结构改进为Bifpn等。

第三,改进主干特征提取网络,就是类似加个注意力机制等。根据个人实验情况来说,这种改进有时候很难有较大的检测效果的提升,乱加反而降低了特征提取能力导致mAP下降,需要有技巧的添加。

第四,改进特征融合网络,理由、方法等同上。

第五,改进检测头,更换检测头这种也算个大的改进点。

第六,改进损失函数,nms、框等,要是有提升检测效果的话,算是一个小的改进点,也可以凑字数。

第七,对图像输入做改进,改进数据增强方法等。

第八,剪枝以及蒸馏等,这种用于特定的任务,比如轻量化检测等,但是这种会带来精度的下降。

...........未完待续

一、创新改进思路或解决的问题

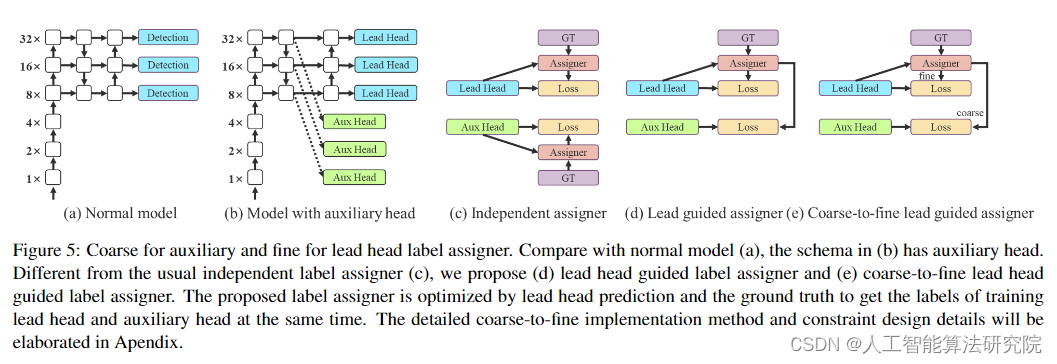

借鉴YOLOv7添加 Aux head 的方法,原因为让网络中间层学到更多信息,有更丰富的梯度信息帮助训练。这里要注意,好的梯度信息能够让相同参数量的网络学的更好。

作者原文为:

By letting the shallower auxiliary head directly learn the information that lead head has learned, lead head will be more able to focus on learning residual information that has not yet been learned.

二、基本原理

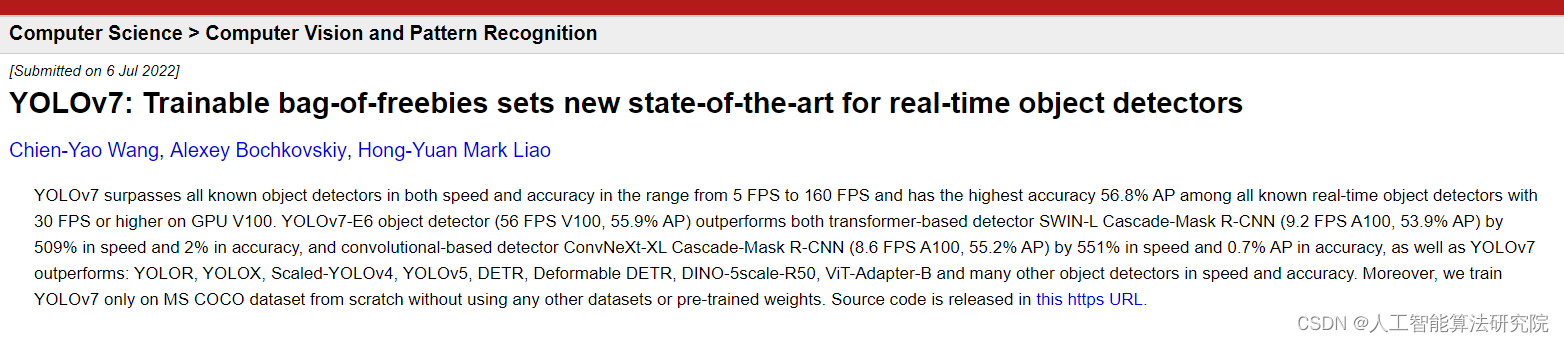

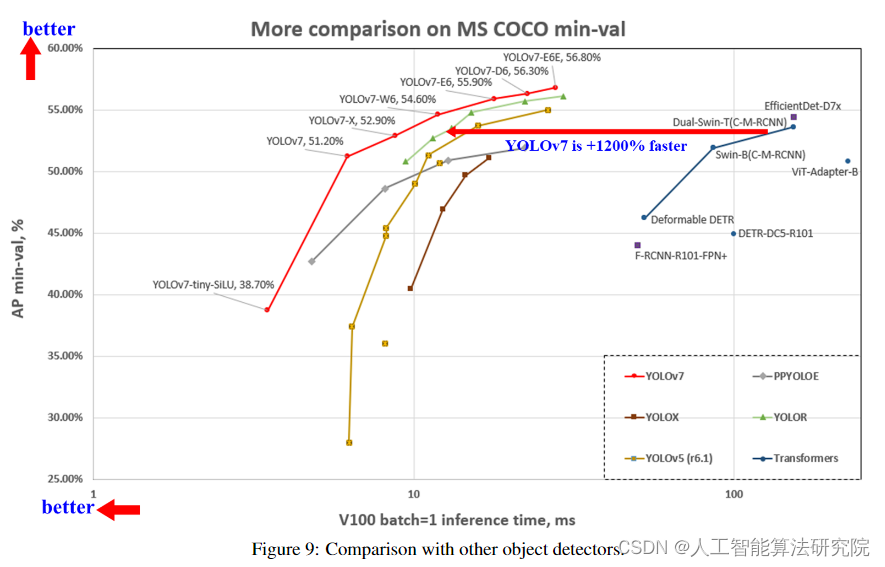

摘要:YOLOv7在5 FPS到160 FPS的范围内的速度和精度都超过了所有已知的对象检测器,并且在GPU V100上具有30 FPS或更高的所有已知实时对象检测器中具有最高的56.8%AP精度。YOLOv7-E6对象检测器(56 FPS V100,55.9%AP)在速度和精度上均优于基于变换器的检测器SWIN-L级联掩码R-CNN(9.2 FPS A100,53.9%AP)509%和2%,基于卷积的检测器ConvNeXt XL级联掩码R-CNN(8.6 FPS A100、55.2%AP)551%和0.7%AP,YOLOv7的性能优于:YOLOR、YOLOX、Scaled YOLOv4、YOLOv5、DETR,可变形DETR、DINO-5scaleR50、ViT-Adapter-B和许多其他物体探测器的速度和精度。此外,我们仅在MS COCO数据集上从头开始训练YOLOv7,而不使用任何其他数据集或预先训练的权重。

摘要:YOLOv7在5 FPS到160 FPS的范围内的速度和精度都超过了所有已知的对象检测器,并且在GPU V100上具有30 FPS或更高的所有已知实时对象检测器中具有最高的56.8%AP精度。YOLOv7-E6对象检测器(56 FPS V100,55.9%AP)在速度和精度上均优于基于变换器的检测器SWIN-L级联掩码R-CNN(9.2 FPS A100,53.9%AP)509%和2%,基于卷积的检测器ConvNeXt XL级联掩码R-CNN(8.6 FPS A100、55.2%AP)551%和0.7%AP,YOLOv7的性能优于:YOLOR、YOLOX、Scaled YOLOv4、YOLOv5、DETR,可变形DETR、DINO-5scaleR50、ViT-Adapter-B和许多其他物体探测器的速度和精度。此外,我们仅在MS COCO数据集上从头开始训练YOLOv7,而不使用任何其他数据集或预先训练的权重。

三、添加方法

部分代码如下所示,详细改进代码可私信我获取。(扣扣2453038530)

- # Ultralytics YOLO 声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/繁依Fanyi0/article/detail/699748推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。