热门标签

热门文章

- 1单兵渗透工具-Yakit-Windows安装使用

- 2【k8s总结】

- 3大数据毕业设计hadoop+spark+hive招聘推荐系统 招聘分析可视化大屏 职位推荐系统 就业推荐系统 招聘爬虫 招聘大数据 计算机毕业设计 机器学习 深度学习 人工智能_spark招聘就业类大屏

- 4媒体邀约有啥要注意的

- 5【CVPR2021】LoFTR:基于Transformers的无探测器的局部特征匹配方法_loftr场景匹配

- 6人工智能的研究方向

- 7uniapp跨域解决_uniapp解决跨域问题

- 8稀疏编码在深度学习中的挑战

- 9【ubuntu-22.04】系统配置之 netplan 网络配置_netplan routes

- 10【深度学习】读取和存储训练好的模型参数(pyTorch)_训练结束后得到了一个pytorchmodel.bin文件,怎么去读取运用他

当前位置: article > 正文

Pytorch 多GPU训练_torch.device多显卡

作者:繁依Fanyi0 | 2024-06-12 12:31:31

赞

踩

torch.device多显卡

Pytorch 多GPU训练

1 导入库

import torch#深度学习的pytoch平台

import torch.nn as nn

from torch.autograd import Variable

from torch.utils.data import DataLoader

from torch.utils.data import TensorDataset

- 1

- 2

- 3

- 4

- 5

2 指定GPU

2.1 单GPU声明

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

- 1

- 2

2.2 多GPU声明

import os

os.environ['CUDA_VISIBLE_DEVICES'] = '0,1,2,3,4,5' #指定GPU编号

device = torch.device("cuda") #创建GPU对象

- 1

- 2

- 3

3 数据放到GPU

x_train = Variable(train,requires_grad=True).to(device=device,dtype=torch.float32) #把训练变量放到GPU

- 1

4 把模型网络放到GPU 【重要】

net = DNN(layers)

net = nn.DataParallel(net)

net.to(device=device)

- 1

- 2

- 3

重要:nn.DataParallel

net = nn.DataParallel(net)

net.to(device=device)

- 使用 nn.DataParallel 打包模型

- 然后用 nn.DataParallel 的 model.to(device) 把模型传送到多块GPU中进行运算

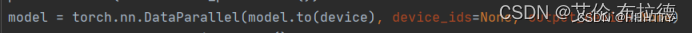

torch.nn.DataParallel(DP)

DataParallel(DP)中的参数:

module即表示你定义的模型device_ids表示你训练时用到的gpu deviceoutput_device这个参数表示输出结果的device,默认就是在第一块卡上,因此第一块卡的显存会占用的比其他卡要更多一些。

当调用nn.DataParallel的时候,input数据是并行的,但是output loss却不是这样的,每次都会在output_device上相加计算

===> 这就造成了第一块GPU的负载远远大于剩余其他的显卡。

DP的优势是实现简单,不涉及多进程,核心在于使用nn.DataParallel将模型wrap一下,代码其他地方不需要做任何更改。

例子:

5 其他:多GPU并行

加个判断:

if torch.cuda.device_count() > 1:

model = torch.nn.DataParallel(model)

- 1

- 2

model = Model(input_size, output_size) # 实例化模型对象

if torch.cuda.device_count() > 1: # 检查电脑是否有多块GPU

print(f"Let's use {torch.cuda.device_count()} GPUs!")

model = nn.DataParallel(model) # 将模型对象转变为多GPU并行运算的模型

model.to(device) # 把并行的模型移动到GPU上

- 1

- 2

- 3

- 4

- 5

- 6

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/繁依Fanyi0/article/detail/708080

推荐阅读

相关标签