- 1web服务器(Tomcat & Servlet)

- 2paho-mqtt-c交叉编译_paho-mqtt c

- 3Java---抽象类和接口_java 抽象类和抽象接口

- 4【安装Anaconda3 + Tensorflow + Keras + Jupyter笔记本】_检查keras是否已经安装

- 5手把手教你用 Github Actions 部署前端项目

- 6python基础学习_pathy基础学习

- 7tomcat漏洞扫描,tomcat隐藏版本号,处理ajp漏洞

- 8送快递的最短路径_物流派送员送快递最短路径

- 9【Linux取经路】冯诺依曼结构体系与操作系统的碰撞_冯诺依曼体系结构确定改进技术

- 10HTTP Strict Transport Security (通常简称为HSTS)_strict-transport-security

python做语音信号处理_python 语音信号处理

赞

踩

作者:凌逆战

时间:2019年11月1日

博客园地址:python做语音信号处理 - 凌逆战 - 博客园

音频信号的读写、播放及录音

python已经支持WAV格式的书写,而实时的声音输入输出需要安装pyAudio(PyAudio: PortAudio v19 Python Bindings)。最后我们还将使用pyMedia(http://pymedia.org)进行Mp3的解码和播放。

音频信号是模拟信号,我们需要将其保存为数字信号,才能对语音进行算法操作,WAV是Microsoft开发的一种声音文件格式,通常被用来保存未压缩的声音数据。

语音信号有四个重要的参数:声道数、采样频率、量化位数(位深)和比特率。

- 声道数:可以是单声道、双声道 ...

- 采样频率(Sample rate):每秒内对声音信号采样样本的总数目,44100Hz采样频率意味着每秒钟信号被分解成44100份。换句话说,每隔$\frac{1}{44100}$秒就会存储一次,如果采样率高,那么媒体播放音频时会感觉信号是连续的。

- 量化位数(Bit depth):也称为“位深”,每个采样点中信息的比特(bit)数。1 byte等于8 bit。通常有8bit、16bit、24bit、32bit...

- 比特率(Bit rate):每秒处理多少个Bit。比如一个单声道,用44.1KHz/16Bit的配置来说,它的比特率就为44100*16*1=705600,单位是bit/s(或者bps),因为通常计算出来的数字都比较大,大家就用kbit/s了,也就是705.6kbit/s。在对音频进行压缩时,比特率就成为了我们的一个要选的选项了,越高的比特率,其音质也就越好。一些常用的比特率有:

-

- 32kbit/s: 一般只适用于语音

- 96kbit/s: 一般用于语音或低质量流媒体

- 128或160kbit/s: 中等比特率质量

- 192kbit/s: 中等质量比特率

- 256kbit/s: 常用的高质量比特率

- 320kbit/s: MP3标准支持的最高水平

如果你需要自己录制和编辑声音文件,推荐使用Audacity,它是一款开源的、跨平台、多声道的录音编辑软件。在我的工作中经常使用Audacity进行声音信号的录制,然后再输出成WAV文件供Python程序处理。

如果想要快速看语音波形和语谱图,推荐使用Adobe Audition,他是Adobe公司开发专门处理音频的专业软件,微博关注vposy,下载地址见置顶。他破解了很多adobe公司的软件,包括PS、PR...

读取音频文件

wave库

wave库是python的标准库,对于python来说相对底层,wave不支持压缩/解压,但支持单声道/立体声语音的读取。

wave_read = wave.open(file,mode="rb")

参数:

- f:语音文件名或文件路径

- mode:读或写

- "rb":只读模式

- "wb":只写模式

返回:读取的文件流

该open()函数可用于with声明中。当with块完成时,wave_read.close()或wave_write.close()方法被调用

文件路径:

例如voice.wav文件在路径C:\Users\Never\Desktop\code for the speech的文件夹里

则file有以下三种填写格式:

r"C:\Users\Never\Desktop\code for the speech\voice.wav"

"C:/Users/Never/Desktop/code for the speech/voice.wav"

"C:\\Users\\Never\\Desktop\\code for the speech\\voice.wav"

三者等价,右划线\为转意字符,如果要表达\则需要\\,引号前面加r表示原始字符串。

wave_read.getparams():一次性返回所有的音频参数,返回的是一个元组(声道数,量化位数(byte单位),采样频率,采样点数,压缩类型,压缩类型的描述)。(nchannels, sampwidth, framerate, nframes, comptype, compname)wave模块只支持非压缩的数据,因此可以忽略最后两个信息。

str_data = wave_read.readframes(nframes):读取的长度(以取样点为单位),返回的是字符串类型的数据

wave_data = np.fromstring(str_data, dtype=np.float16):将上面字符串类型数据转换为一维float16类型的数组。

现在的wave_data是一个一维的short类型的数组,但是因为我们的声音文件是双声道的,因此它由左右两个声道的取样交替构成:LR

wave_data.shape = (-1, 2) # -1的意思就是没有指定,根据另一个维度的数量进行分割,得到n行2列的数组。

wave_read.close() 关闭文件流wave

wave_read.getnchannels() 返回音频通道的数量(1对于单声道,2对于立体声)。

wave_read.getsampwidth() 以字节为单位返回样本宽度

wave_read.getframerate() 返回采样频率。

wave_read.getnframes() 返回音频帧数。

wave_read.rewind() 将文件指针倒回到音频流的开头。

wave_read.tell() 返回当前文件指针位置。

读取通道数为2的音频信号

librosa库 (推荐)

这是我最常用也是最喜欢的语音库,librosa是python第三方库,我们在使用前需要在cmd终端运行: pip install librosa ,关于librosa的介绍我专门写了一篇博客librosa语音信号处理。

import librosa y, sr = librosa.load(path, sr=fs)

该函数是会改变声音的采样频率的。如果 sr 缺省,librosa.load()会默认以22050的采样率读取音频文件,高于该采样率的音频文件会被下采样,低于该采样率的文件会被上采样。因此,如果希望以原始采样率读取音频文件,sr 应当设为 None。具体做法为 y, sr = librosa(filename, sr=None)。

音频数据 y 是直接经过归一化的数组

scipy库

from scipy.io import wavfile

sampling_freq, audio = wavfile.read("***.wav")

audio 是直接经过归一化的数组

写音频文件

wave库

在写入第一帧数据时,先通过调用setnframes()设置好帧数,setnchannels()设置好声道数,setsampwidth()设置量化位数,setframerate()设置好采样频率,然后writeframes(wave.tostring())用于写入帧数据。

wave_write = wave.open(file,mode="wb")

wave_write是写文件流,

- wave_write.setnchannels(n) 设置通道数。

- wave_write.setsampwidth(n) 将样本宽度设置为n个字节,量化位数

- wave_write.setframerate(n) 将采样频率设置为n。

- wave_write.setnframes(n) 将帧数设置为n

- wave_write.setparams(tuple) 以元组形式设置所有参数(nchannels, sampwidth, framerate, nframes,comptype, compname)

- wave_write.writeframes(data) 写入data个长度的音频,以采样点为单位

- wave_write.tell() 返回文件中的当前位置

写wav文件

写WAV文件方法2

librosa库 (推荐)

librosa.output.write_wav(path, y, sr, norm=False)

参数:

- path:str,保存输出wav文件的路径

- y:np.ndarry 音频时间序列

- sr:y的采样率

- norm:True/False,是否启动幅值归一化

在0.8.0以后的版本,librosa都会将这个函数删除,推荐用下面的函数:

import soundfile soundfile.write(file, data, samplerate)

参数:

- file:保存输出wav文件的路径

- data:音频数据

- samplerate:采样率

scipy库

from scipy.io.wavfile import write write(output_filename, freq, audio)

写WAV文件

合成有音调的音乐

合成音调

tone_freq_map

音频播放

wav文件的播放用到的是pyaudio库

p = pyaudio.PyAudio()

stream = p.open(format = p.get_format_from_width(sampwidth) , channels ,rate ,output = True)

stream.write(data) # 播放data数据

以下列出pyaudio对象的open()方法的主要参数:

- rate:取样频率

- channels:声道数

- format:取样值的量化格式 (paFloat32, paInt32, paInt24, paInt16, paInt8 ...)。在上面的例子中,使用get_format_from_width方法将wf.sampwidth()的返回值2转换为paInt16

- input:输入流标志,如果为True的话则开启输入流

- output:输出流标志,如果为True的话则开启输出流

- input_device_index:输入流所使用的设备的编号,如果不指定的话,则使用系统的缺省设备

- output_device_index:输出流所使用的设备的编号,如果不指定的话,则使用系统的缺省设备

- frames_per_buffer:底层的缓存的块的大小,底层的缓存由N个同样大小的块组成

- start:指定是否立即开启输入输出流,缺省值为True

播放wav音频

录音

以SAMPLING_RATE为采样频率,每次读入一块有NUM_SAMPLES个采样的数据块,当读入的采样数据中有COUNT_NUM个值大于LEVEL的取样的时候,将数据保存进WAV文件,一旦开始保存数据,所保存的数据长度最短为SAVE_LENGTH个块。WAV文件以保存时的时刻作为文件名。

从声卡读入的数据和从WAV文件读入的类似,都是二进制数据,由于我们用paInt16格式(16bit的short类型)保存采样值,因此将它自己转换为dtype为np.short的数组。

View Code

语音信号处理

语音信号的产生和感知

我们要对语音进行分析,首先要提取能够表示该语音的特征参数,有了特征参数才可能利用这些参数进行有效的处理,在对语音信号处理的过程中,语音信号的质量不仅取决于处理方法,同时取决于时候选对了合适的特征参数。

语音信号是一个非平稳的时变信号,但语音信号是由声门的激励脉冲通过声道形成的,而声道(人的口腔、鼻腔)的肌肉运动是缓慢的,所以“短时间”(10~30ms)内可以认为语音信号是平稳时不变的。由此构成了语音信号的“短时分析技术”。

在短时分析中,将语音信号分为一段一段的语音帧,每一帧一般取10~30ms,我们的研究就建立在每一帧的语音特征分析上。

提取的不同的语音特征参数对应着不同的语音信号分析方法:时域分析、频域分析、倒谱域分析...由于语音信号最重要的感知特性反映在功率谱上,而相位变化只起到很小的作用,所有语音频域分析更加重要。

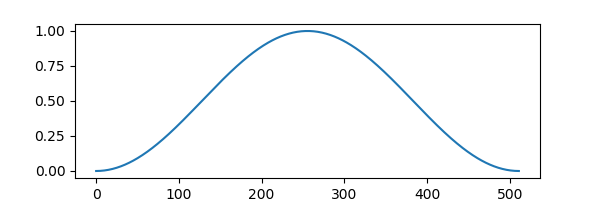

信号加窗

1、矩形窗

2、汉明窗(Hamming)

3、海宁窗(Hanning)

通常对信号截断、分帧需要加窗,因为截断都有频域能量泄露,而窗函数可以减少截断带来的影响。

窗函数在scipy.signal信号处理工具箱中,如hanning窗:

signal.hanning(winl)

信号分帧

在分帧中,相邻两帧之间会有一部分重叠,帧长(wlen) = 重叠(overlap)+帧移(inc),如果相邻两帧之间不重叠,那么由于窗函数的形状,截取到的语音帧边缘会出现损失,所以要设置重叠部分。inc为帧移,表示后一帧第前一帧的偏移量,fs表示采样率,fn表示一段语音信号的分帧数。

信号分帧的理论依据,其中x是语音信号,w是窗函数:

加窗截断类似采样,为了保证相邻帧不至于差别过大,通常帧与帧之间有帧移,其实就是插值平滑的作用。

给出示意图:

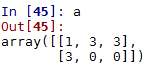

这里主要用到numpy工具包,涉及的指令有:

- np.repeat:主要是直接重复

- np.tile:主要是周期性重复

对比一下:

向量情况:

矩阵情况:

对于数据:

repeat操作:

tile操作:

对应结果:

对应分帧的代码实现:

这是没有加窗的示例:

没有加窗的语音分帧

加窗的语音分帧

overlap and add

将分帧好的语音拼接回完整的语音

def overlap_add(x, window_size, hop_size):

# x (frames, frame_length)

frames, frame_length = x.shape

wav_len = frames * hop_size + window_size - hop_size # 帧长

print("帧长", wav_len)

wav = np.zeros((wav_len,), dtype=x.dtype)

for frame in range(frames):

if frame == frames - 1:

# 最后一帧

wav[hop_size * frame: hop_size * frame + window_size] += x[frame] # 把整帧前加进去

else:

wav[hop_size * frame: hop_size * frame + hop_size] += x[frame][:hop_size] # 把帧前加进去

return wav

语音信号的短时时域处理

短时能量和短时平均幅度

短时能量和短时平均幅度的主要用途:

- 区分浊音和清音段,因为浊音的短时能量$E(i)$比清音大很多;

- 区分声母和韵母的分界和无话段和有话段的分界

短时平均过零率

对于连续语音信号,过零率意味着时域波形通过时间轴,对于离散信号,如果相邻的取样值改变符号,则称为过零。

作用:

- 发浊音时由于声门波引起谱的高频跌落,所以语音信号能量约集中在3kHz以下

- 发清音时多数能量集中在较高的频率上,

因为高频意味着高的短时平均过零率,低频意味着低的短时平均过零率,所以浊音时具有较低的过零率,而清音时具有较高的过零率。

- 利用短时平均过零率可以从背景噪声中找出语音信号,

- 可以用于判断寂静无话段与有话段的起点和终止位置。

- 在背景噪声较小的时候,用平均能量识别较为有效,在背景噪声较大的时候,用短时平均过零率识别较为有效。

短时自相关函数

短时自相关函数主要应用于端点检测和基音的提取,在韵母基因频率整数倍处将出现峰值特性,通常根据除R(0)外的第一峰值来估计基音,而在声母的短时自相关函数中看不到明显的峰值。

短时平均幅度差函数

用于检测基音周期,而且在计算上比短时自相关函数更加简单。

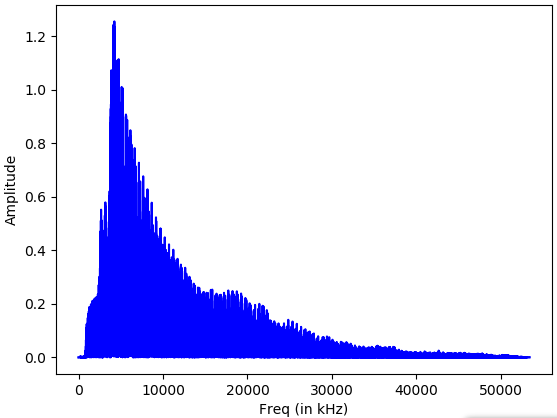

语音信号的短时频域处理

在语音信号处理中,在语音信号处理中,信号在频域或其他变换域上的分析处理占重要的位置,在频域上研究语音可以使信号在时域上无法表现出来的某些特征变得十分明显,一个音频信号的本质是由其频率内容决定的,

将时域信号转换为频域信号一般对语音进行短时傅里叶变换。

fft_audio = np.fft.fft(audio)

绘制语音信号的频谱图

提取频域特征

将信号转换为频域之后,还需要将其转换为有用的形式,梅尔频率倒谱系数(MFCC),MFCC首先计算信号的功率谱,然后用滤波器组和离散余弦变换的组合来提取特征。

提取MFCC特征

语谱图

绝大部分信号都可以分解为若干不同频率的正弦波。

这些正弦波中,频率最低的称为信号的基波,其余称为信号的谐波。

基波只有一个,可以称为一次谐波,谐波可以有很多个,每次谐波的频率是基波频率的整数倍。谐波的大小可能互不相同。

以谐波的频率为横坐标,幅值(大小)为纵坐标,绘制的系列条形图,称为频谱。频谱能够准确反映信号的内部构造。

语谱图综合了时域和频域的特点,明显的显示出来了语音频率随时间的变化情况,语谱图的横轴为时间,纵轴为频率任意给定频率成分在给定时刻的强弱用颜色深浅表示。颜色深表示频谱值大,颜色浅表示频谱值小,语谱图上不同的黑白程度形成不同的纹路,称为声纹,不用讲话者的声纹是不一样的,可以用做声纹识别。

其实得到了分帧信号,频域变换取幅值,就可以得到语谱图,如果仅仅是观察,matplotlib.pyplot有specgram指令:

语谱图

MATLAB语谱图

语音识别

View Code

我对上面这段代码专门写了一篇博客来进一步讲解和分析,想详细了解的读者可以移步Python实现语音识别和语音合成 - 凌逆战 - 博客园,语音数据集在这里。

参考文献

网址:用python做科学计算 http://old.sebug.net/paper/books/scipydoc/index.html#

python标准库wave模块22.4. wave — Read and write WAV files — Python 3.6.15 documentation

《python机器学习经典案例》美Prateek Joshi著

傅里叶变换的介绍:Fourier Transform

各种音阶及其对应的频率 Frequencies of Musical Notes, A4 = 440 Hz

这篇博客的代码https://github.com/LXP-Neve/Speech-signal-processing

【知乎文章】采样率,位深以及比特率