- 1卡尔曼滤波融合库函数+Arduino实例_arduino卡尔曼函数库

- 2FineBl概述

- 3大型语言模型的语义搜索(一):关键词搜索_如何查看大模型的关键词

- 4记录分享vue3通过web3.js连接MetaMask的流程及签名、验签方法_vue 开发web3.js

- 5Fastadmin vps离线安装插件失败解决方案(转发)_fastadmin插件离线安装

- 6List of BAPI's_docp269

- 7git 如何撤销某次远程仓库的提交_git撤销远程提交

- 8Spark集群的搭建

- 9Stable Diffusion使用controlnet报错 mat1 and mat2 shapes cannot be multiplied问题_runtimeerror: mat1 and mat2 shapes cannot be multi

- 10linux 查看io 进程,如何查看具体进程的IO情况?

GPT-4现场被端侧小模型“暴打”,商汤日日新5.0:全面对标GPT-4 Turbo

赞

踩

金磊 发自 商汤AIDC

量子位 | 公众号 QbitAI

够刺激,GPT-4竟然当众被“揍”了,甚至连还手的机会都没有:

是的,就是在一场《街头霸王》游戏现场PK中,发生了这样的名场面。

而且二者还是不在一个“重量级”的那种:

绿人:由GPT-4操纵

红人:由一个端侧小模型操纵

那么这位又小又彪悍的选手到底什么来头?

不卖关子,它正是由商汤科技最新发布的日日新端侧大模型——SenseChat Lite(商量轻量版)。

单是在《街头霸王》里的表现,这个小模型就颇有一种“天下武功,唯快不破”的气势:

GPT-4还在想着怎么决策,SenseChat Lite的拳头就已经打上去了。

不仅如此,商汤CEO徐立还在现场加大难度,直接在手机上断网开测!

例如离线模式下生成员工请假一周的申请,效果是这样的:

△现场原速

(当然,徐立开玩笑表示“假太长了,不批噢~”)

也可以对长段文字做快速总结:

△现场原速

而之所能够做到如此,是因为SenseChat Lite在同等尺度性能上已经达到了SOTA水平。

更是用“以小博大”的姿势在多项测试中击败了Llama2-7B,甚至是13B。

在速度方面,SenseChat Lite则是采用了端云“联动”的MoE框架,在部分场景中端侧推理占70%,会让推理成本变得更低。

具体而言,对比人眼20字/秒的阅读速度来说,SenseChat Lite在中等性能手机上,可以达到18.3字/秒推理速度。

若是在高端旗舰手机,那么推理速度可以直接飙到78.3字/秒!

但除了文本生成之外,徐立同样在现场还展示了商汤端侧模型的多模态能力。

例如同样是扩图,商汤的端侧大模型在慢半拍启动的情况下,扩了3种不同图片的速度比友商扩1张的速度还快:

演示的同学甚至直接现场拍照,把照片缩小了很多以后再来自由扩图:

嗯,不得不说,商汤是敢在现场动真格的。

然而,纵观整场活动,端侧大模型也还仅是此次发布会的一隅。

在“大基座”方面,商汤更是把自家的日日新大模型来了个大版本的升级——SenseNova 5.0。并且直接将其定位到了一个新高度:

全面对标GPT-4 Turbo!

那么日日新大模型5.0版本实力到底如何,我们这就来实测一波~

有请,“弱智吧”!

自打大模型火爆以来,“弱智吧”就一直成了检测大模型逻辑能力的标准之一,江湖戏称为“弱智吧Benchmark”。

(“弱智吧”源自百度贴吧,是一个充满荒谬、离奇、不合常理发言的中文社区。)

而且就在前不久,“弱智吧”还登上正经AI论文,成了最好的中文训练数据,引发了一波不小的热议。

那么当文本对话的商量大模型5.0遇到了“弱智吧”,二者又会擦出怎样的花火?

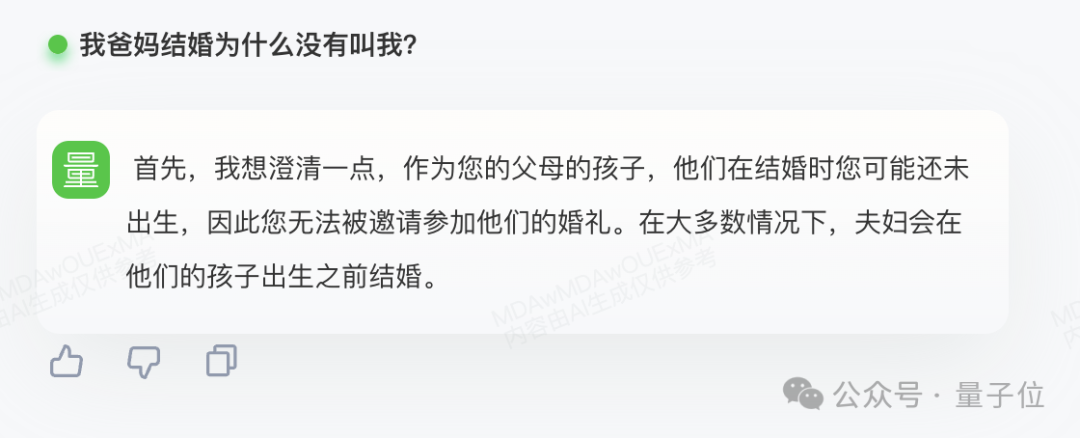

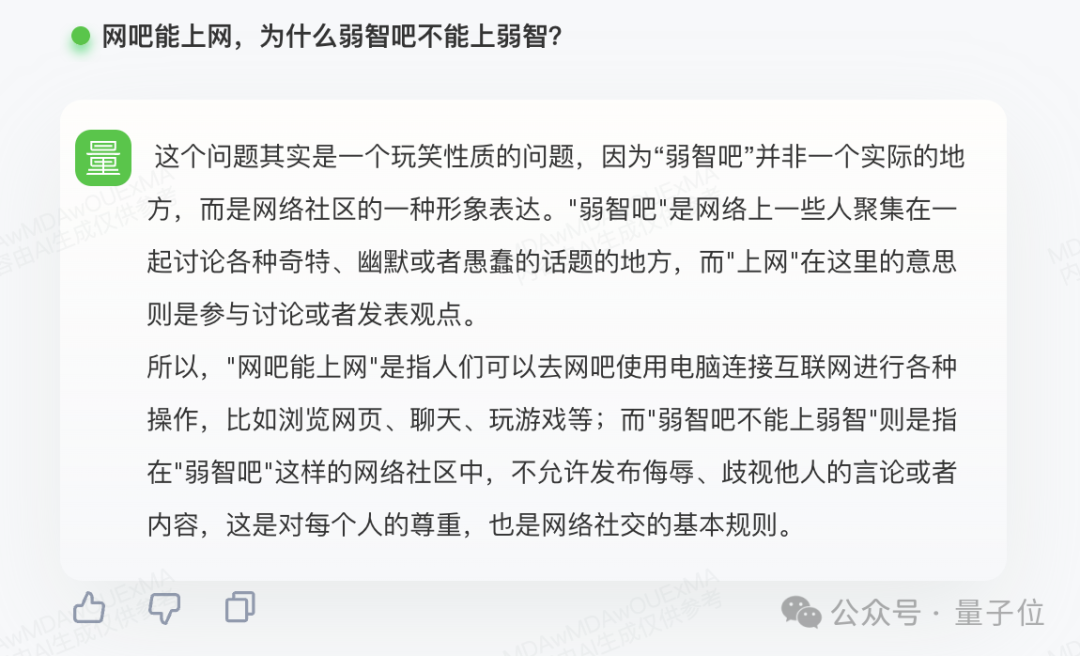

逻辑推理:“弱智吧”

请听第一题:

我爸妈结婚为什么没有叫我?

商量的回答不同于其它AI,它会比较拟人的用“我”来做回答,而且从答案结果来看并没有过多冗余的内容,而是精准地做了回答和解释,“他们结婚时您还未出生”。

请听第二题:

网吧能上网,为什么弱智吧不能上弱智?

同样的,商量直接精准点出“这是个玩笑性质的问题”,以及道出了“‘弱智吧’并非一个实际的地方”。

不难看出,对于“弱智吧”这种魔幻、不按套路出牌的逻辑,商量5.0是已经能够hold住了。

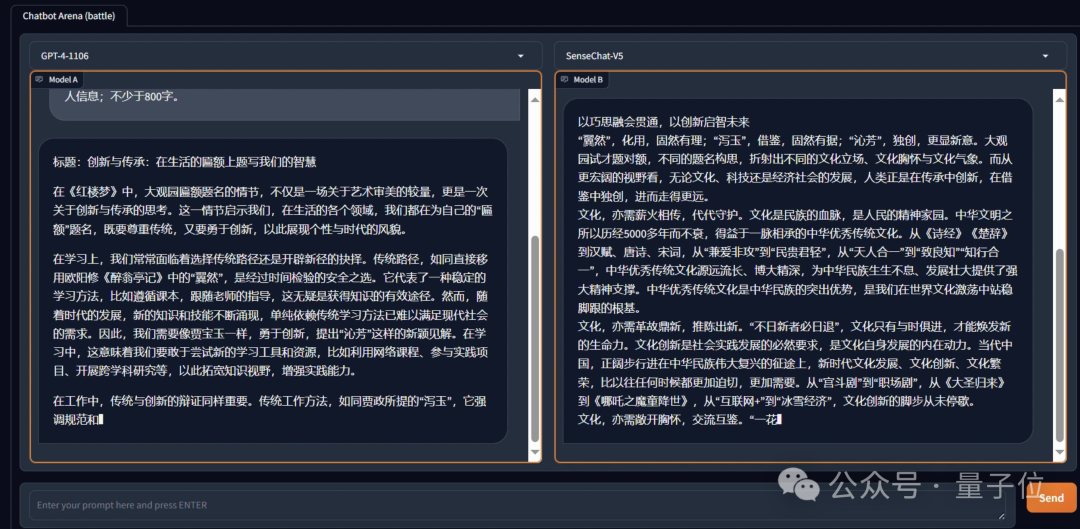

自然语言:高考《红楼梦》

除了逻辑推理能力之外,在自然语言生成方面,我们可以直接用2022年高考作文题目,来对比看下GPT-4和商量大模型5.0。

从结果上来看,GPT-4的文章还是一眼“AI模版”;而商量5.0这边,则是颇有诗意,不仅句子工整对仗,还能引经据典。

嗯,AI的思路是被打开、发散了。

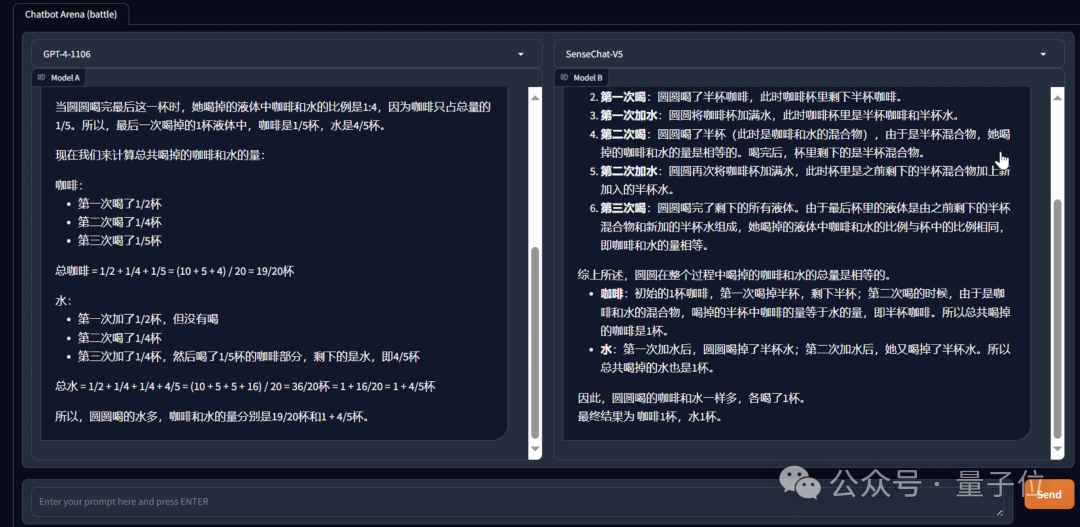

数学能力:化繁为简

同样是让GPT-4和商量5.0同台竞技,我们这次来测试一下它们的数学能力:

妈妈给圆圆冲了一杯咖啡,圆圆喝了半杯后,将它加满水,然后她又喝了半杯后,再加满水,最后全部喝完。问圆圆喝的咖啡多,还是水多?咖啡和水各喝了几杯?

这道题对于人类来说,其实是一个比较简单的问题,但是GPT-4却对此做出了看似一本正经的缜密推导,结果还是错误的。

究其原因,是大模型背后的思维链在逻辑上的构建并不完整,若是遇到小众的问题就极容易出错;反观商量5.0这边,思路和结果就是正确的了。

再如下面这道“老鹰抓小鸡”的问题,GPT-4或许不理解这种游戏的规则,因为所算出来的答案依旧是错误:

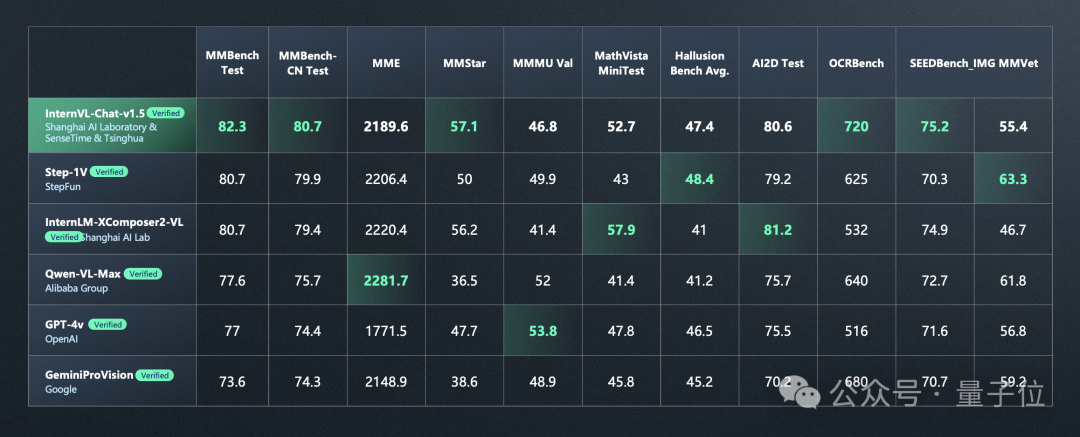

不仅从实际体验的效果中可以感知一二,更为直接的评测榜单数据,也反应出了商量5.0的能力——

常规客观评测已经达到或超越GPT-4 Turbo。

那么日日新5.0又是如何做到的呢?一言蔽之,左手数据,右手算力。

首先,为了打破数据层面上的瓶颈,商汤采用了超过10T的tokens,使其具备了高质量数据的完备性,让大模型对客观知识和世界有了初级的认知。

此外,商汤还合成构造了高达数千亿tokens的思维链数据,这也是此次在数据层面上发力的关键点,能够激活大模型强推理的能力。

其次,是在算力层上,商汤是将算法设计和算力设施进行了联合的优化:算力设施的拓扑极限用来定义下一阶段的算法,而算法上的新进展又要重新知道算力设施的建设。

这便是商汤AI大装置对算法和算力联合迭代的核心能力所在了。

整体而言,日日新5.0的更新亮点可以总结为:

采用MoE架构

基于超过10TB tokens训练,拥有大量合成数据

推理上下文窗口达到200K

知识、推理、数学和代码等能力全面对标GPT-4 Turbo

除此之外,在多模态领域,日日新5.0在多项核心指标中也取得了较为领先的成绩:

老规矩,我们继续来看多模态的生成效果。

更会看图了

例如“投喂”给商量5.0一张超级长的图片(646*130000),只需让它识别,便可以得到所有内容的概述:

再如随意丢给商量5.0一张有意思的猫咪图片,它就能根据派对帽、蛋糕和“生日快乐”等细节内容推断猫在庆生。

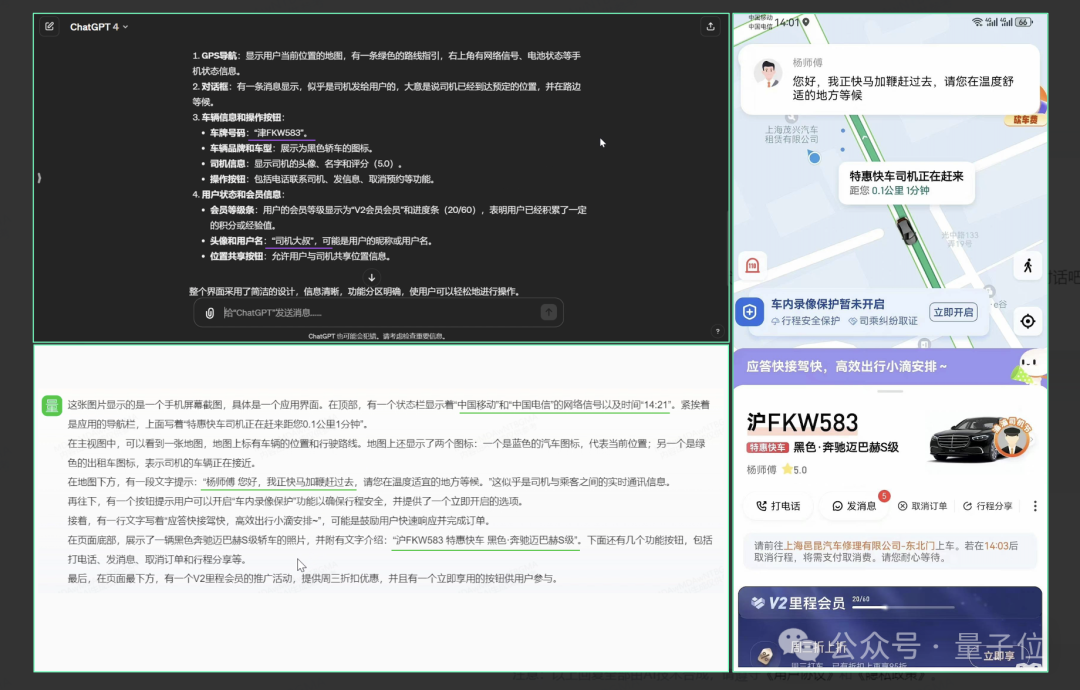

更实用一些的,例如上传一张复杂截图,商量5.0就能精准提取并总结出关键的信息,而这一点GPT-4在识别过程中却出现了失误:

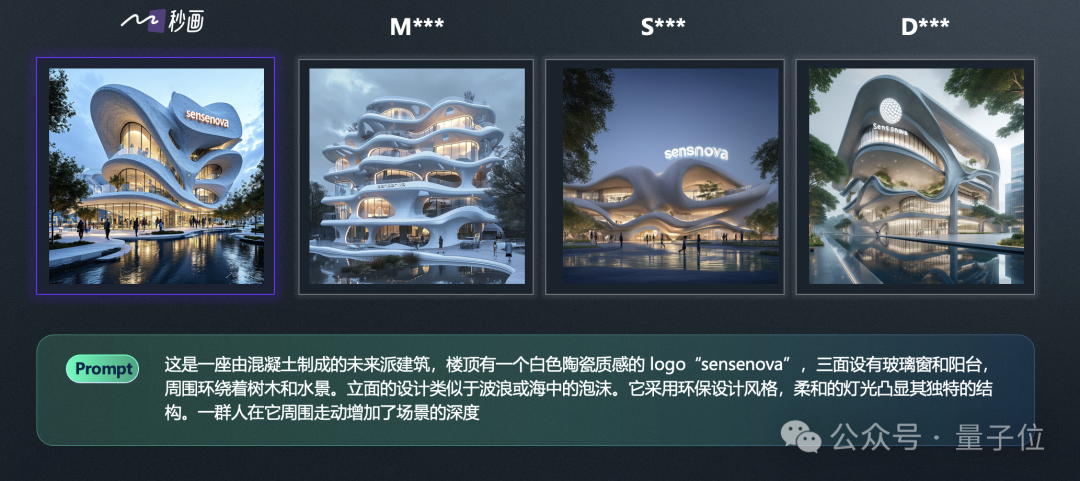

秒画5.0:和三大顶流PK

在文生图方面,日日新的秒画5.0直接和Midjourney、Stable Diffuison和DALL·E 3进行了同台竞技。

例如在风格上,秒画生成的图片可能会更加接近prompt中提到的“国家地理”:

人物形象上,可以展示更加复杂的皮肤纹理:

甚至是文字也可以精准无误地嵌入到图像当中:

还有个拟人大模型

除此之外,商汤在此次发布中还推出了一个比较特殊的大模型——拟人大模型。

从体验来看,它已经可以模仿影视角色、现实名人、原神世界等各种破次元的人物,并且与你展开高情商对话。

从功能上来看,商量拟人大模型支持角色创建与定制、知识库构建、长对话记忆等,甚至是可以三人以上群聊的那种哦~

也正是基于如此多模态能力,商汤大模型家族的另一大成员——小浣熊也迎来了能力上的升级。

办公、编程变得更easy

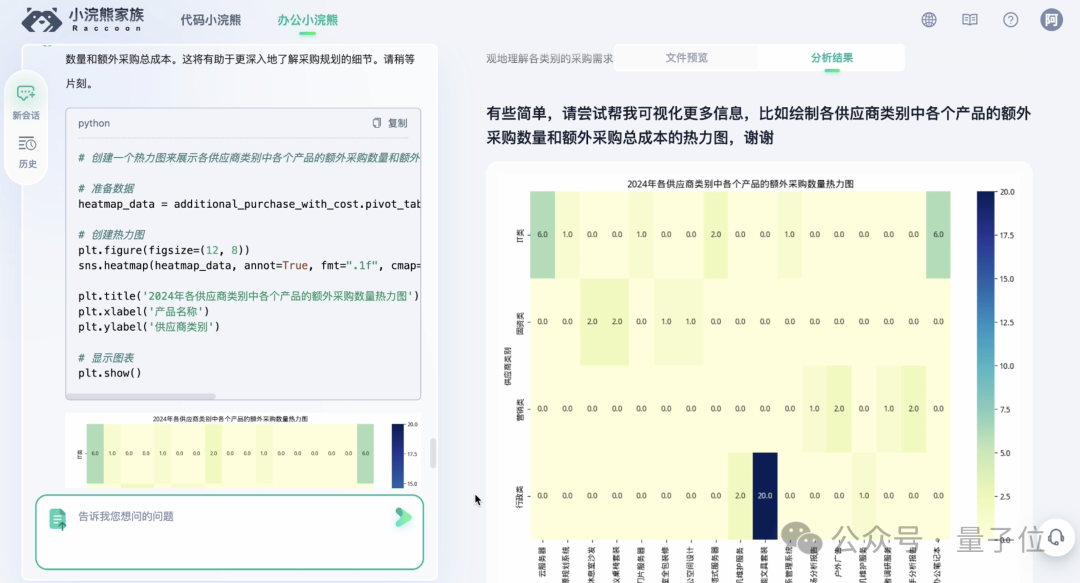

商汤的小浣熊目前细分为办公小浣熊和编程小浣熊两大类,顾名思义,分别是作用于办公场景和编程场景。

有了办公小浣熊,现在处理表格、文档甚至代码文件,都成了“一丢+一问”的事情了。

以采购场景为例,我们可以先上传不同来源的供应商名单信息,然后跟办公小浣熊说:

单位、单价、备注。因为不同 sheet 中的表头信息并不一致,可将类似的表头内容进行合并。在对话框中展示表格结果,并生成本地下载链接,谢谢。

只需稍等片刻,我们就可以得到处理完后的结果了。

而且在左侧栏中,办公小浣熊还给出了分析过程的Python代码,主打一个“有迹可循”。

我们还可以同时上传库存信息和采购需求等多个文件:

然后继续提要求,办公小浣熊依旧是能够快速完成任务。

并且即使是数据形式不规范,它也能自行发现并解决:

当然,数据计算也是不在话下,依旧是提要求的事情。

除此之外,办公小浣熊也可以基于数据文件做可视化的工作,直接展示下有难度的热力图:

总结来看,办公小浣熊可以对多个、不同类型(如 Excel、csv、json 等)做处理,在中文理解、数理计算和数据可视化等维度有非常强的能力。并且它通过代码解释器的形式,增强了大模型生成内容的准确性与可控性。

另外,发布会上办公小浣熊还当场展示了结合复杂数据库进行分析的能力。

上周,中国首位F1车手周冠宇完成了他在F1中国大奖赛的比赛。商汤在发布会现场直接给办公小浣熊“投喂”了一份数据量庞大的数据库文件,让小浣熊当场分析周冠宇和F1赛事的相关情况。

如统计周冠宇的参赛信息、F1总共有多少车手、有哪些车手获得过总冠军并按照获奖次数从高到低排列,这些计算涉及量更大、逻辑更复杂的数据表格和圈数、领奖数等更多维度的细节信息,最终也都给出了完全正确的答案。

在编程场景中,代码小浣熊也是可以让程序员们的效率直接Pro Max了。

例如只需在VS Code中安装扩展的插件:

然后编程的各个环节就变成了输入一句自然语言的事情了。

例如把需求文档丢给代码小浣熊,然后就说句:

帮我写一个公有云上微信扫码支付的详细PRD文档。PRD格式和内容请遵循“产品需求文档PRD模板”的要求,生成的内容清晰、完整、详细。

然后代码小浣熊就“唰唰唰”地开始做需求分析的工作了:

代码小浣熊也可以为你做架构设计:

写代码也可以通过自然语言提需求,或者通过鼠标一键注释、测试生成代码,代码翻译、重构或修正等等:

最后的软件测试环节也可以交给代码小浣熊来执行哦~

总而言之,有了代码小浣熊,它就能帮你处理平日里一些重复性、繁琐性高的编程任务。

而且商汤此次还不只是发布这么个动作,更是将代码小浣熊“打包”推出了轻量版一体机。

一台一体机就能支持100人团队开发,且成本仅为每人每天4.5元。

以上便是商汤此次发布的主要内容了。

那么最后,我们还需要总结性地聊一聊一个话题。

商汤的大模型路数

纵观整场发布会,给人最为直观的感受首先就是够全面。

不论是端侧模型,亦或者“大底座”日日新5.0,是属于云、边、端全栈的发布或升级;能力上更是涵盖到了语言、知识、推理、数学、代码,以及多模态等AIGC近乎所有主流的“标签”。

其次就是够抗打。

以日日新5.0的综合实力为例,目前放眼整个国内大模型玩家,能够喊出全面对标GPT-4的可以说是为数不多;并且商汤是敢在现场直接拿多项能力做实测,也是敢第一时间开放体验,对自身实力的信心可见一斑。

最后就是够速度。

商汤的速度不只限于像端侧大模型的运行效果之快,更宏观地来看,是自身在迭代优化进程上的速度。若是我们把时间线拉长,这种speed就会格外得明显:

日日新1.0→2.0:3个月

日日新2.0→4.0:6个月

日日新4.0→5.0:3个月

如此平均下来,近乎是一个季度便有一次大版本的升级,其整体能力也会随之大幅提高。

那么接下来的一个问题便是,商汤为什么可以做到如此?

首先从大方向来看,便是商汤一直强调的“大模型+大装置”的打法。

大模型是指日日新大模型体系,可以提供自然语言处理、图片生成、自动化数据标注、自定义模型训练等多种大模型及能力。

大装置则是指商汤打造的高效率、低成本、规模化的新一代AI基础设施,以AI大模型开发、生成、应用为核心;总算力规模高达12000 petaFLOPS ,已有超4.5万块GPU。

二者的异曲同工之妙,便是早已布局,它们并非是AIGC大热潮之下的产物,而是可以追溯到数年前、具有前瞻性的两项工作。

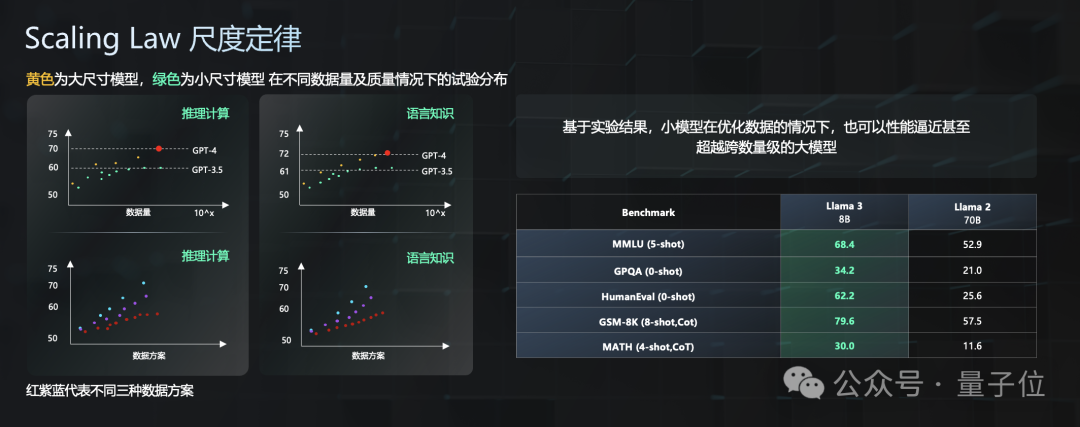

其次更深入到大模型层面,商汤基于自身在实际的测试和实践过程中,对行业所共识的基本法则尺度定律(Scaling Law)有着新的理解和解读。

尺度定律通常是指随着数据量、参数量和训练时长的增加,大模型所表现出来的性能会更好,是一种大力出奇迹的感觉。

这个定律还包含两条隐藏的假设:

可预测性:可以跨越5-7个数量级尺度依然保持对性能的准确预测

保序性:在小尺度上验证了性能优势,在更大尺度上依然保持

因此,尺度定律是可以指导在有限的研发资源中,找到最优的模型架构和数据配方,让大模型能够高效地去学习。

而也正是基于商汤如此的观察和实践,诞生了“小且能打”的端侧模型。

除此之外,商汤对于大模型的能力还有独到的三层架构(KRE)的理解。

徐立对此做了深入地解读。

首先是在知识,是指世界知识的全面灌注。

目前大模型等新质生产力工具近乎都是基于此来解决问题,也就是根据前人已经解决过的问题的方案,来回答你的问题。

这可以认为是大模型能力的基本功,但更为高阶的知识,应当是基于这样能力下推理得到的新知识,这也就是这个架构的第二层——推理,即理性思维的质变提升。

这一层的能力是可以决定大模型是否够聪明、是否可以举一反三的关键和核心。

再在此之上,便是执行,是指世界内容的交互变革,也就是如何跟真实世界产生互动(就目前而言,具身智能在这一层是潜力股般的存在)。

三者虽相互独立,但层与层之间也是紧密关联,徐立打了一个较为形象的比喻:

知识到推理是像大脑,推理到执行则像小脑。

在商汤看来,这三层的架构是大模型应当具备的能力,而这也正是启发商汤构建高质量数据的关键;不仅如此,也是基于KRE这套逻辑,才有了此次发布中的众多产品。

那么最后一个问题是,基于KRE、基于“大模型+大装置”这样的路线,最新的日日新在产业中“上岗”到了什么程度?

正所谓“实践是检验真理的唯一标准”,来自客户的使用反馈或许才是最真实的答案。

而在此,商汤也交出了一份较为高分的作业——在现场,华为、WPS、小米、阅文、海通证券,从办公到文娱,从金融到终端,纷纷分享了使用商汤日日新大模型体系后,给自身业务带来的降本增效。

总而言之,有技术、有算力、有方法论、有场景,商汤日日新在AIGC时代接下来的发展,是值得期待了。

— 完 —

点这里

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。