热门标签

热门文章

- 1[ 环境搭建篇 ] 安装 java 环境并配置环境变量(附 JDK1.8 安装包)_如何安装环境1.8

- 2MySQL 约束详解_mysql的约束

- 3HTML期末大作业-小米商城_html期末作业选小米商城的理由

- 4开发模式-敏捷开发_敏捷开发模型

- 5构建大语言模型的四个主要阶段_大语言模型一共要经历几个阶段

- 6互联网工作 常用名词及基础知识扫盲

- 7Eclipse——导出可执行jar包_eclipse导出可执行jar包

- 8Java空指针异常:java.lang.NullPointException_simpledateformat.format java.lang.nullpointerexcep

- 9主成分分析(PCA)中的特征值与特征向量,特征值是不是数据在特征向量方向上的方差_pca 的特征值 特征向量

- 10Gradle和IDEA的匹配关系_idea gradle 版本对照

当前位置: article > 正文

阿里发布高质量图像转视频AI模型I2VGen-XL_阿里i2vgen-xl

作者:花生_TL007 | 2024-04-04 21:09:41

赞

踩

阿里i2vgen-xl

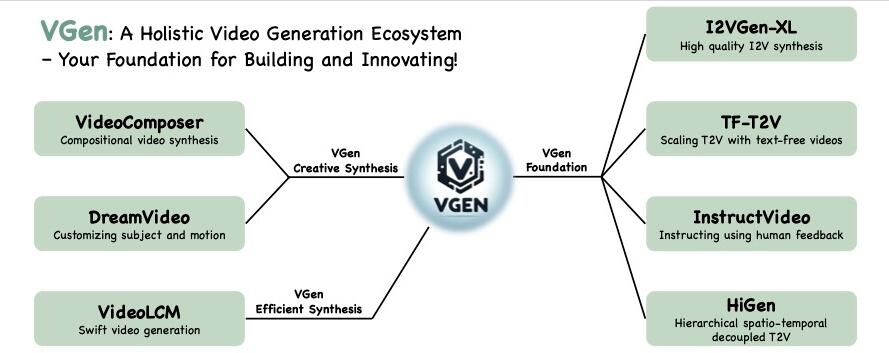

受益于扩散模型快速发展,视频合成近年来取得了显著进步。然而,在语义准确性、清晰度和时空连续性方面仍存在挑战。这主要源于缺乏良好对齐的文本视频数据以及视频的复杂结构,使得模型难以同时确保卓越的语义和质量。

阿里团队提出了一种级联I2VGen-XL方法,通过解耦这两个因素来增强模型性能,并通过利用静态图像作为关键引导形式来确保输入数据的对齐。I2VGen-XL由两个阶段组成:

基础阶段:通过使用两个分层编码器,保证连贯的语义并保留输入图像的内容。

细化阶段:通过合并额外的简短文本来增强视频的细节,并将分辨率提高到1280×720。

为了提高多样性,阿里团队收集了约3.5亿个单镜头文本-视频对和60亿个文本-图像对来优化模型。通过这种方式,I2VGen-XL可以同时增强生成视频的语义准确性、细节连续性和清晰度。

通过大量实验,阿里团队研究了I2VGen-XL的基本原理,并将其与当前顶级方法进行了比较,证明了其在各种数据上的有效性,并公开源代码和模型。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/花生_TL007/article/detail/361127

推荐阅读

相关标签