- 1蓝易云:Ubuntu 22.04环境下clang++编译错误:/usr/bin/ld: 找不到 -lstdc++: 没有那个文件或目录的解决方案

- 2【Redis】RedisTemplate和StringRedisTemplate的区别_redistemplate stringredistemplate

- 3初探车载测试技术:从基础认知到入门学习要点_自学车载测试基础门槛

- 4DP动态规划(Fibonacci),完全背包例题_fibonacci beanstalkd

- 5Ubuntu22.04 自建DNS服务器_ubuntu2204 dns

- 6网络攻防技术概述_网络安全攻防技术

- 7如何用python做一个界面,python做一个界面程序_python 创建界面

- 8SQL注入总结_sql注入只有等号

- 9排序算法(一)冒泡&归并_冒泡排序和归并排序

- 10【独家源码】ssm基于微信小程序的校园失物招领系统xh467计算机毕业设计问题的解决方案与方法

大数据----31.hbase安装启动_启动hbase

赞

踩

二.Hbase安装

先前安装:

- Zookeeper 正常部署

首先保证 Zookeeper 集群的正常部署,并启动之。

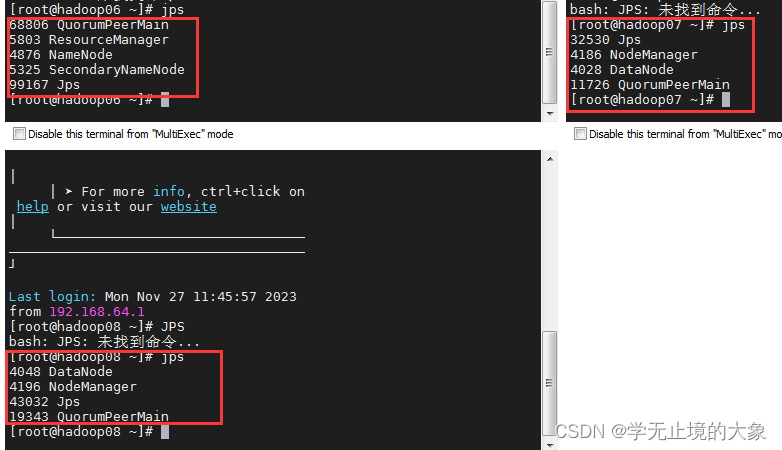

三台机器都执行:zkServer.sh start - Hadoop 正常部署

Hadoop 集群的正常部署并启动。

主节点上进行 :start-all.sh

1.HBase 的获取

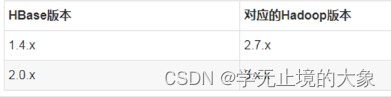

一定要对照他的版本对应;

1.获取hbase软件

http://archive.apache.org/dist/hbase/ 下载地址

我们的版本是 hadoop2.7.3 版本; 使用1.3.2的即可;

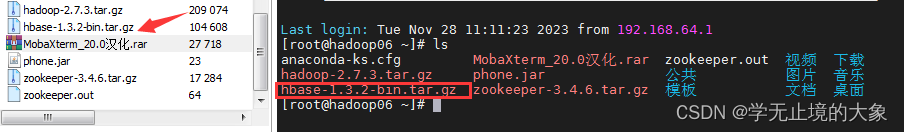

2. 上传到linux服务器中;直接上传到主服务器 hadoop06机器即可(在一台机器上):

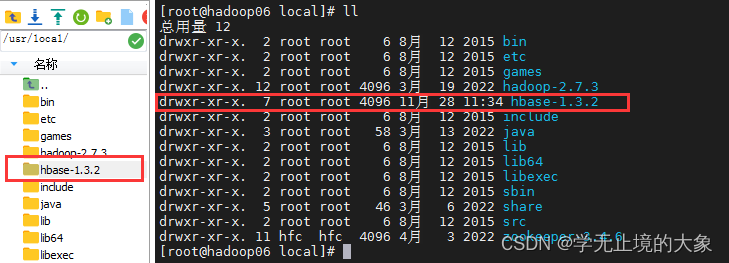

3.解压软件:解压到/usr/local/ 文件夹 (在一台机器上)

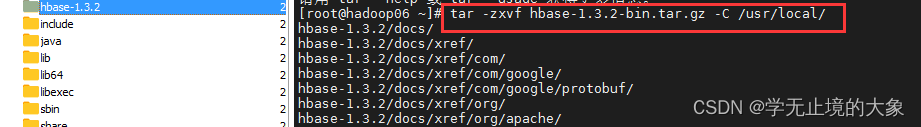

[root@hadoop06 ~]# tar -zxvf hbase-1.3.2-bin.tar.gz -C /usr/local/

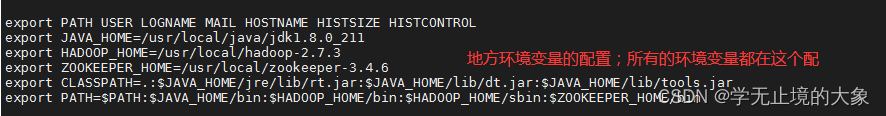

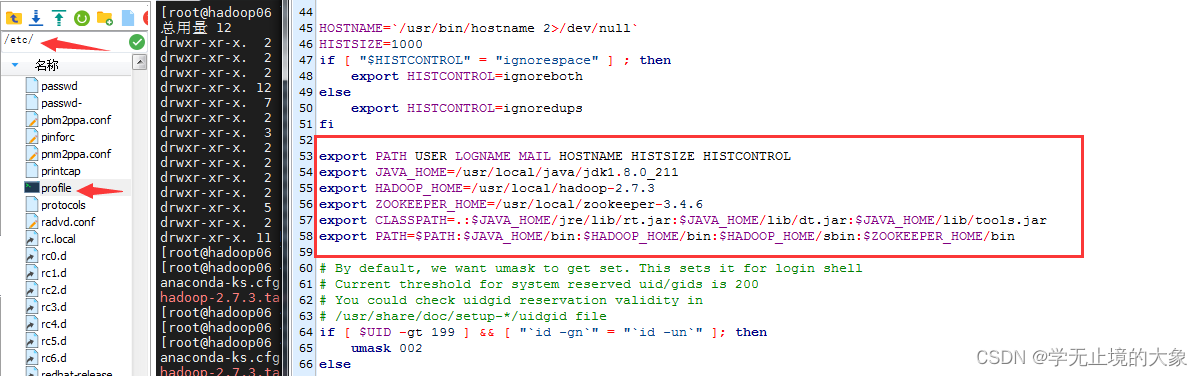

3. 进行环境变量的配置;(在一台机器上进行配置;然后下分发给其他机器)

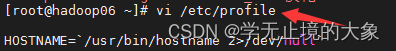

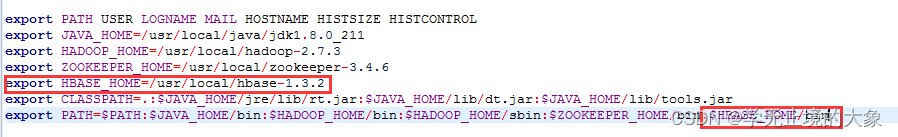

配置环境变量文件:etc/profile

vi /etc/profile

也可以使用工具对他进行编辑:

配置habse的环境变量:

export HBASE_HOME=/usr/local/hbase-1.3.2

在PATH中添加:

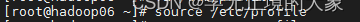

让我们的配置起作用; source /etc/profile

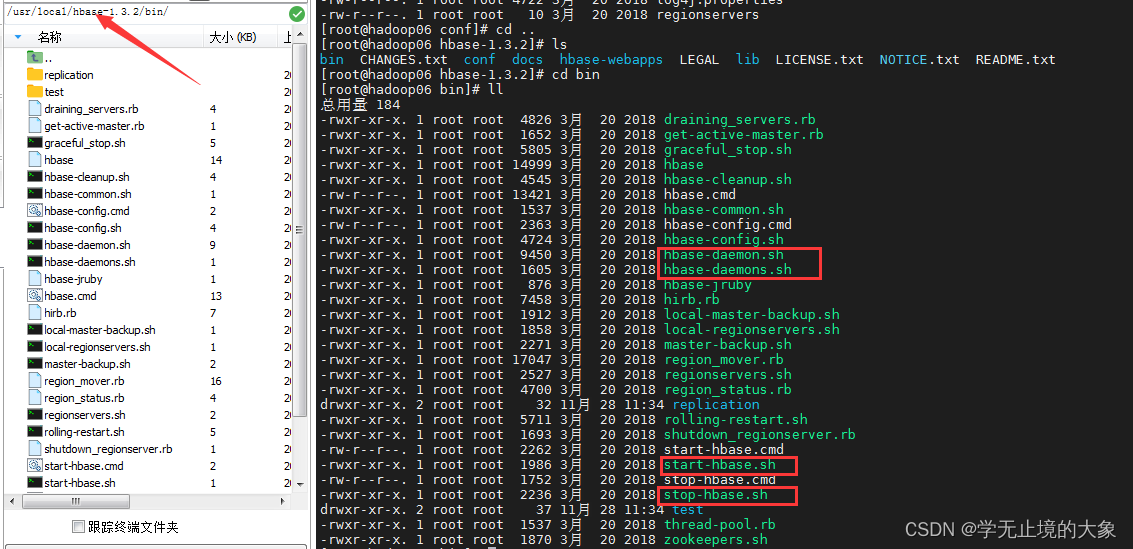

5. 查看下hbase的启动程序所在的位置中的命令:

/usr/local/hbase-1.3.2/bin/

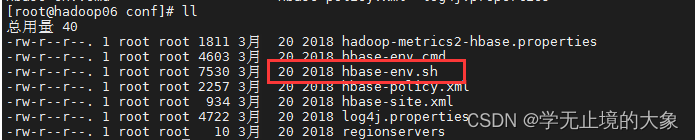

6.进行hbase的配置文件的修改操作:修改文件

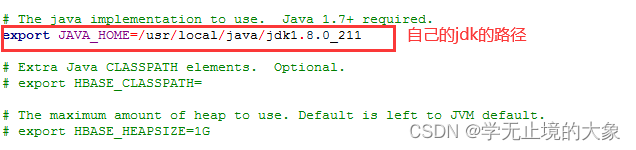

1.hbase-env.sh

需要修改的内容:(分别开启他的注释修改内容即可;)

export JAVA_HOME=/usr/local/java/jdk1.8.0_211/

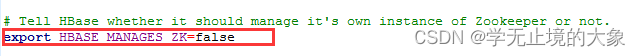

export HBASE_MANAGES_ZK=false,表示不引用 hbase 自带的 zookeeper,用我们自己安装的

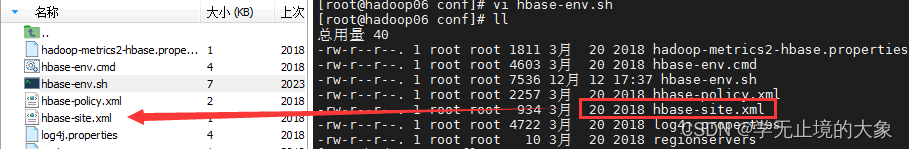

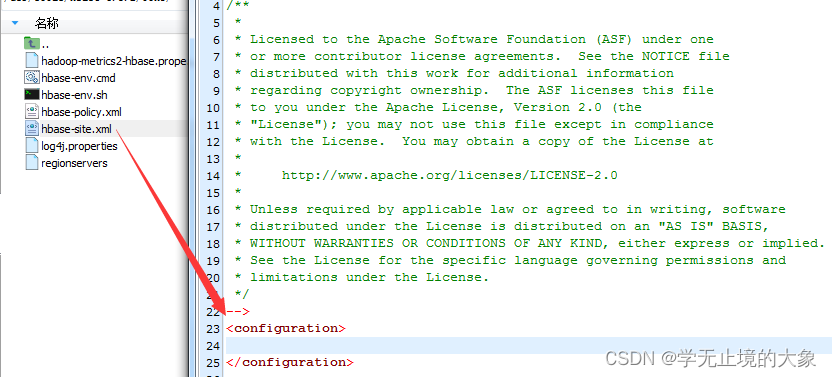

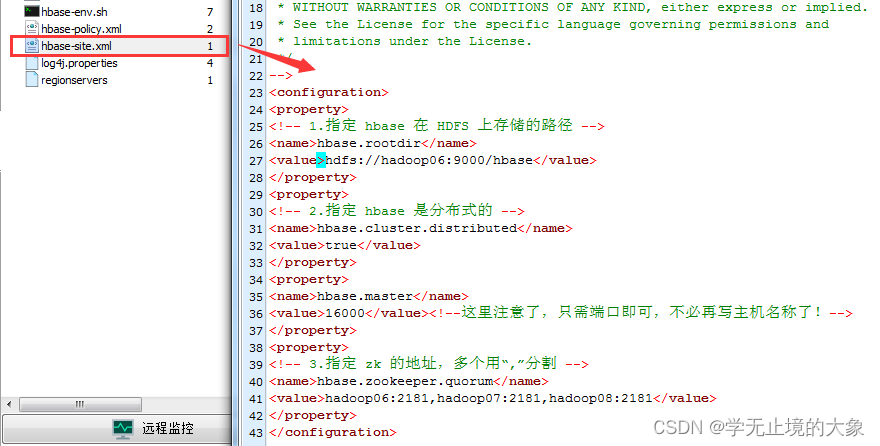

2.修改另一个配置文件:hbase-site.xml 只要修改的是数据存储hdfs位置:

修改的内容为:

需要修改:

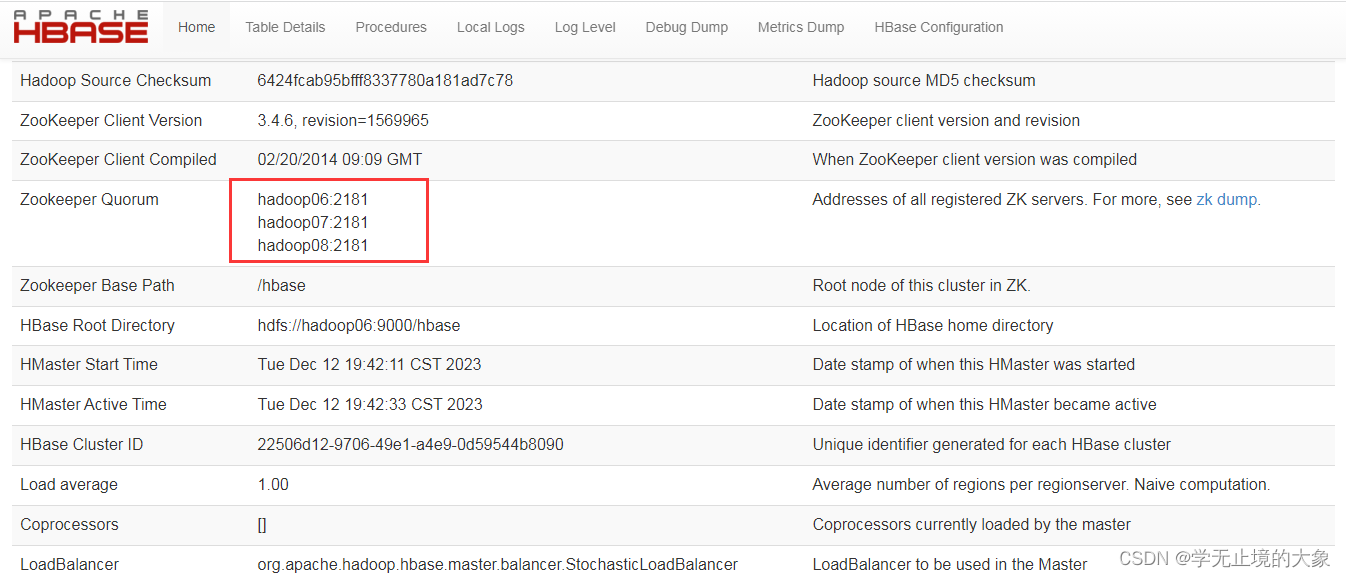

<configuration> <property> <!-- 1.指定 hbase 在 HDFS 上存储的路径 --> <name>hbase.rootdir</name> <value>hdfs://hadoop06:9000/hbase</value> </property> <property> <!-- 2.指定 hbase 是分布式的 --> <name>hbase.cluster.distributed</name> <value>true</value> </property> <property> <name>hbase.master</name> <value>16000</value><!--这里注意了,只需端口即可,不必再写主机名称了!--> </property> <property> <!-- 3.指定 zk 的地址,多个用“,”分割 --> <name>hbase.zookeeper.quorum</name> <value>hadoop06:2181,hadoop07:2181,hadoop08:2181</value> </property> </configuration>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

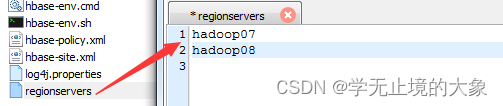

- 修改配置文件 regionservers 规定区域范围

把hadoop06作为主节点;hadoop07;hadoop08 作为从节点使用

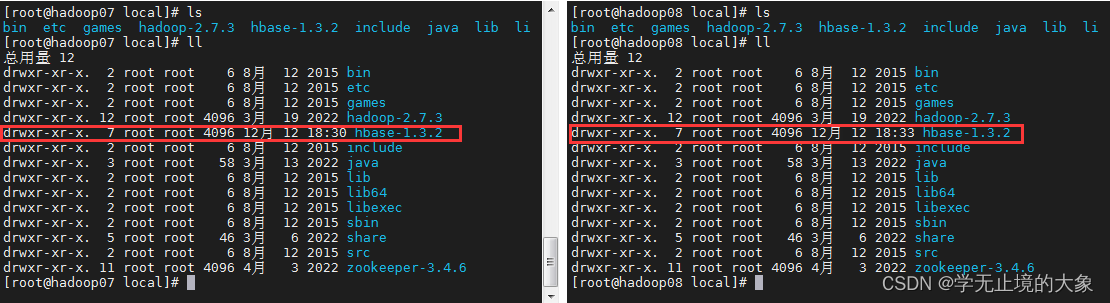

7.把配置好的文件进行分发:

scp -r /usr/local/hbase-1.3.2 hadoop07:/usr/local

scp -r /usr/local/hbase-1.3.2 hadoop08:/usr/local

这个时候我们已经包hbase的所有文件都已经下发到我们的其他机器中:

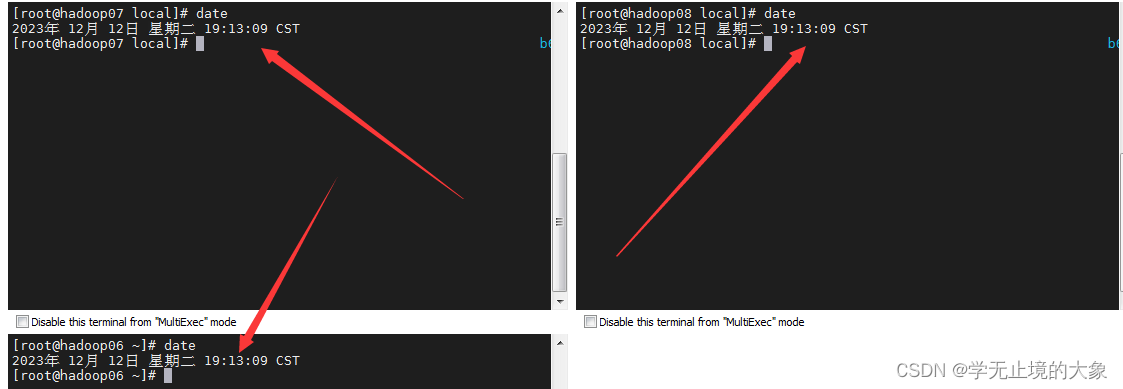

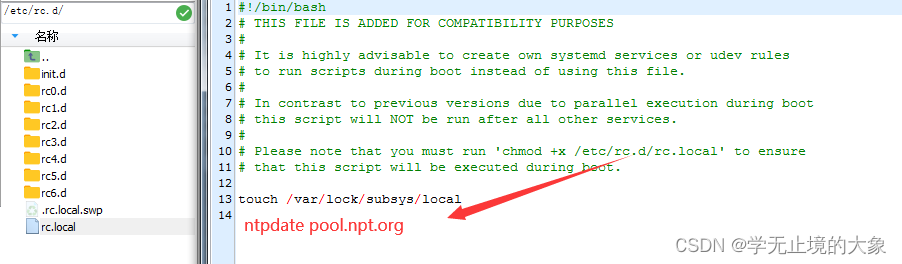

注意:在启动之前需要进行时间的统一;(我们使用的是和主节点的时间同步;)

也可以设置每个的时间服务器:

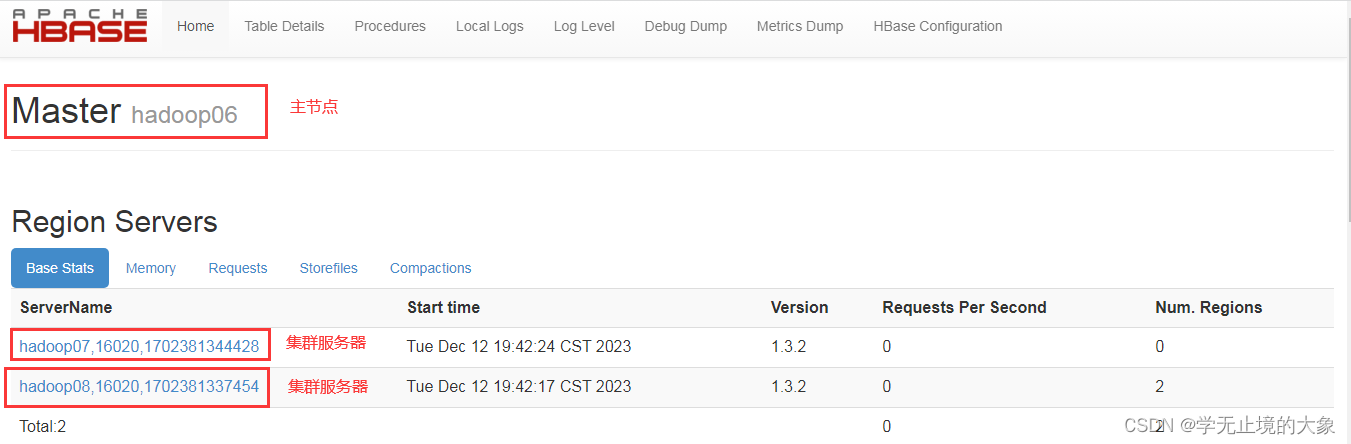

7.开始启动hbase;

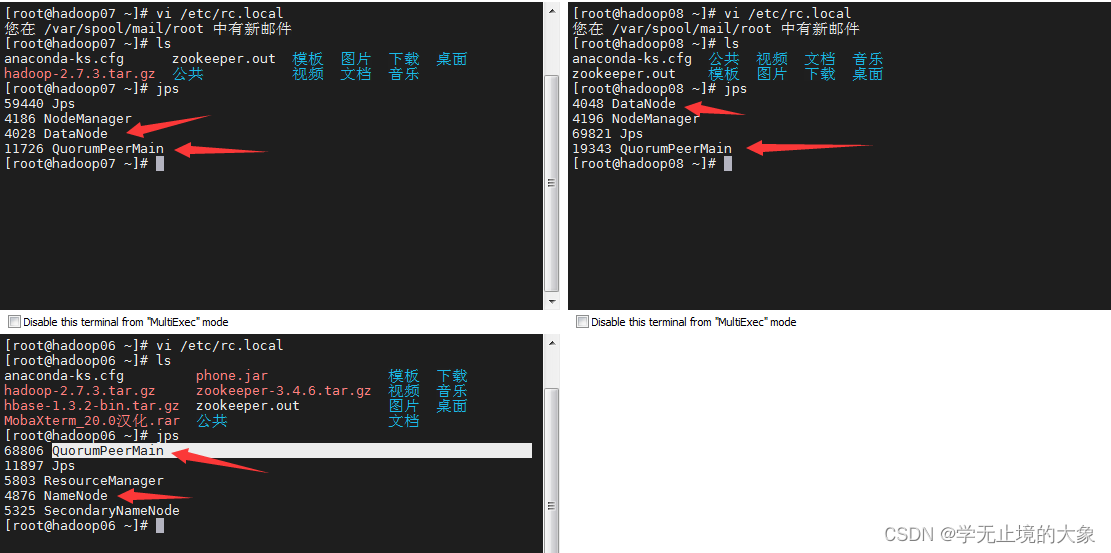

1.检查hadoop启动和zookeeper的q启动:

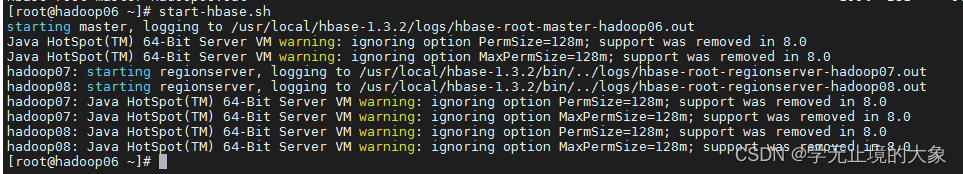

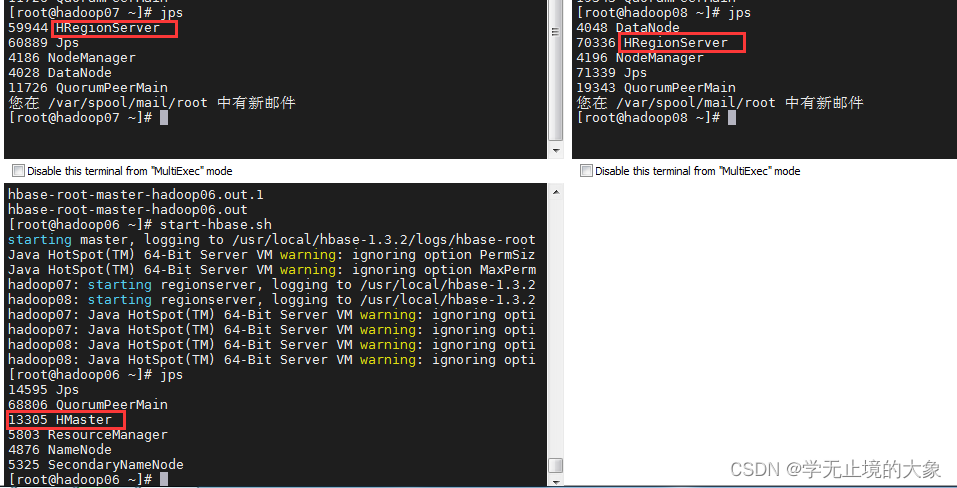

2.启动hbase(在hadoop06上执行) 在主机上启动即可;

start-hbase.sh

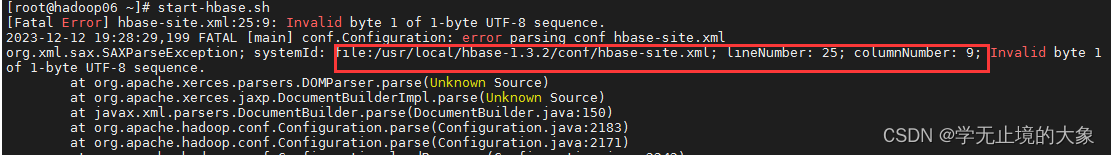

如果报错要注意他的提示:是我们在里边进行了注释:

8. 通过web来访问:http://192.168.64.160:16010/

- 停止命令

stop-hbase.sh

现在就形成了一个使用zookeeper来维护的hbase集群

10. 数据存储在对用的hadoop中的HDFS中;

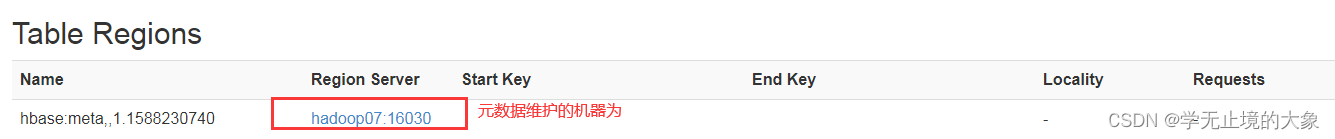

11.原数据存储在对应的管理zookeeper中:

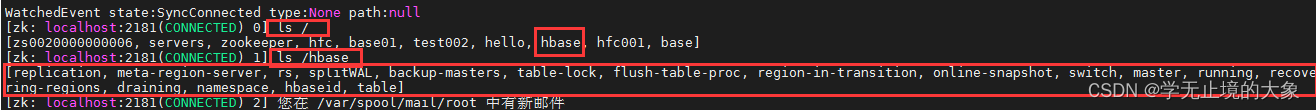

可以通过进行这个机器中的zookeeper中取查看他的具体:

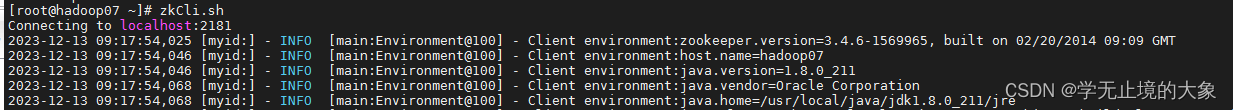

[root@hadoop07 ~]# zkCli.sh

这个就是生产的原数据位置;

当你把这个服务器关闭之后; 他会收到zookeeper的维护; 就会让其他的机器来进行维护;