热门标签

热门文章

- 1阿里云ECS服务器安装nacos,开放端口问题记录_nacos 阿里云 部署 端口 互联网安全性

- 2归一化原理-python实现_python 最大最小归一化

- 3【CentOS 7.9】安装搜狗输入法教程_rhel7.9 安装 搜狗

- 4开放windows服务器端口(以打开端口8080为例)_windows 正在连接192.168.15.8...无法打开到主机的连接。 在端口 8085: 连

- 5使用EasyExcel按照模版导出excel文件_easyexcel根据模板导出excel

- 6实现paho.mqtt.cpp库编译

- 7Android 图片选择器,相机拍摄和图库选择,并进行裁剪_intent.action_pick intent.action_get_content inten

- 8【python二级-练习题】_python二级题库

- 9深入解析大型语言模型:从训练到部署大模型_通用语言大模型训练平台建设

- 10python——peewee简单使用_peewee python3

当前位置: article > 正文

23.卷积神经网络实战-ResNet_resnet实战

作者:菜鸟追梦旅行 | 2024-02-21 08:13:11

赞

踩

resnet实战

一个残差结构

一个weight layer由一个卷积层一个bn层组成。

当ch_in与,ch_out不等时,通过代码使得[b,ch_in,h,w] -> [b,ch_out,h,w],把,ch_in变成,ch_out。

forward中x与out不等时,在x前加一个extra()。

我们4个block中h和w是变化的,只是在此处表达的时候没有变。

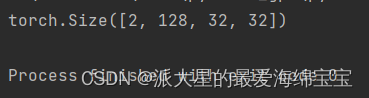

我们进行一个小测试

blk=ResBlk(64,128)

tmp=torch.randn(2,64,32,32)

out=blk(tmp)

print(out.shape)

- 1

- 2

- 3

- 4

我们的channel越来越大,我们的长和宽保持不变,最终导致我们的参数量越来越大。

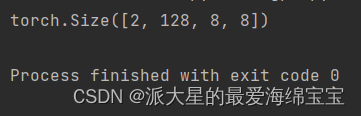

我们需要长和宽减半,我们需要在参数部分添加stride,stride为1时,输入和输出非常接近,当为2时,有可能输出为输入的一半。

blk=ResBlk(64,128,stride=2)

tmp=torch.randn(2,64,32,32)

out=blk(tmp)

print(out.shape)

- 1

- 2

- 3

- 4

- 5

blk=ResBlk(64,128,stride=4)

tmp=torch.randn(2,64,32,32)

out=blk(tmp)

print(out.shape)

- 1

- 2

- 3

- 4

如果是match,就不会报错。

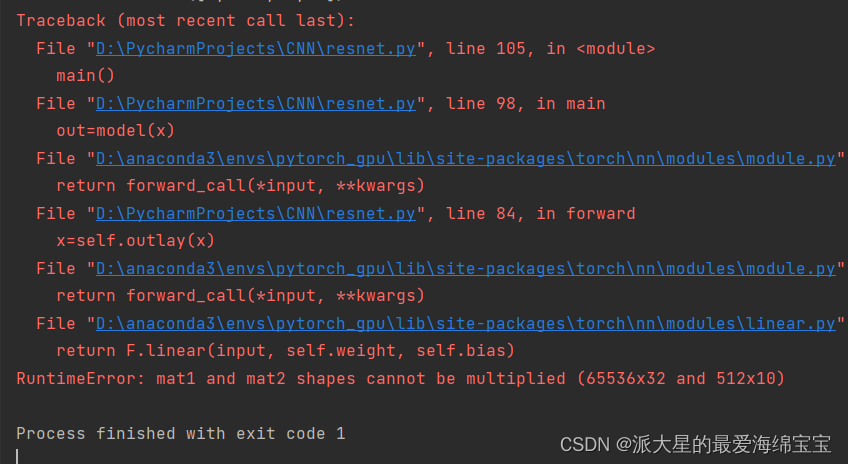

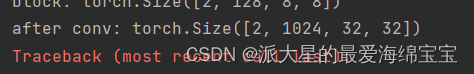

进行人为的调试:

print('after conv:', x.shape)

x=self.outlay(x)

- 1

- 2

修改参数:

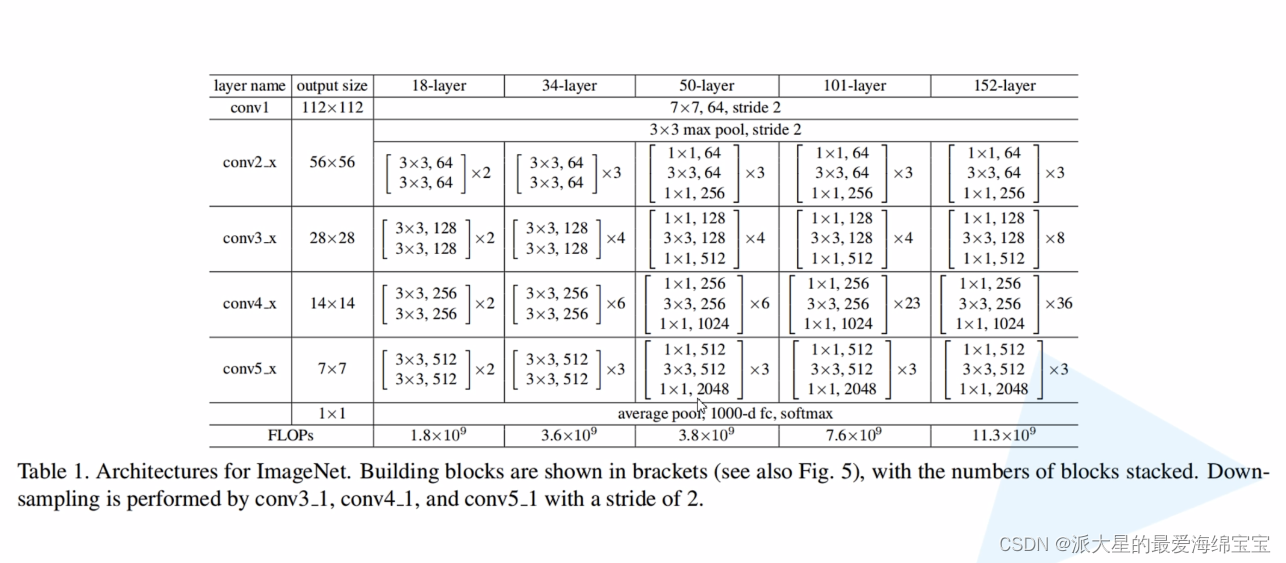

self.conv1=nn.Sequential( nn.Conv2d(3,64,kernel_size=3,stride=3,padding=0), nn.BatchNorm2d(64) ) # followed 4 blocks #[b,64,h,w]->[b,128,h,w] self.blk1=ResBlk(64,128,stride=2) # [b,128,h,w]->[b,2556,h,w] self.blk2=ResBlk(128,256,stride=2) # [b,256,h,w]->[b,512,h,w] self.blk3=ResBlk(256,512,stride=2) # [b,512,h,w]->[b,1024,h,w] self.blk4=ResBlk(512,512,stride=2) self.outlay=nn.Linear(512*1*1,10)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

小结

整体是先对数据做一个预处理,然后进行4个block,每一个block都由2个卷积和一个短接层组成,处理过程中数据的channel会慢慢增加,但是长和宽会减少,得到(512,512),再把这个(512)打平后送入全连接层,做一个分类的任务。这就是ResNet的一个基本结构。

代码

import torch from torch import nn from torch.nn import functional as F class ResBlk(nn.Module): ''' resnet block ''' def __init__(self,ch_in,ch_out,stride=1): ''' :param ch_in: :param ch_out: ''' super(ResBlk, self).__init__() self.con1=nn.Conv2d(ch_in,ch_out,kernel_size=3,stride=stride,padding=1) self.bn1=nn.BatchNorm2d(ch_out) self.con2=nn.Conv2d(ch_out,ch_out,kernel_size=3,stride=1,padding=1) self.bn2=nn.BatchNorm2d(ch_out) self.extra=nn.Sequential() if ch_out != ch_in: self.extra=nn.Sequential( nn.Conv2d(ch_in,ch_out,kernel_size=1,stride=stride), nn.BatchNorm2d(ch_out) ) def forward(self,x): ''' :param x:[b,ch,h,w] :return: ''' out=F.relu(self.bn1(self.con1(x))) out=self.bn2(self.con2(out)) # short cut # extra model:[b,ch_in,h,w] with [b,ch_out,h,w] out=self.extra(x)+out return out class ResNet18(nn.Module): def __init__(self): super(ResNet18, self).__init__() self.conv1=nn.Sequential( nn.Conv2d(3,64,kernel_size=3,stride=3,padding=0), nn.BatchNorm2d(64) ) # followed 4 blocks #[b,64,h,w]->[b,128,h,w] self.blk1=ResBlk(64,128,stride=2) # [b,128,h,w]->[b,2556,h,w] self.blk2=ResBlk(128,256,stride=2) # [b,256,h,w]->[b,512,h,w] self.blk3=ResBlk(256,512,stride=2) # [b,512,h,w]->[b,1024,h,w] self.blk4=ResBlk(512,512,stride=2) self.outlay=nn.Linear(512*1*1,10) def forward(self,x): ''' :param x: :return: ''' x=F.relu(self.conv1(x)) # [b,64,h,w]->[b,1024,h,w] x=self.blk1(x) x=self.blk2(x) x=self.blk3(x) x=self.blk4(x) # print('after conv:', x.shape) # x=self.outlay(x) x=F.adaptive_avg_pool2d(x,[1,1]) x=x.view(x.size(0),-1) x=self.outlay(x) return x def main(): blk=ResBlk(64,128,stride=4) tmp=torch.randn(2,64,32,32) out=blk(tmp) print('block:',out.shape) x=torch.randn(2,3,32,32) model=ResNet18() out=model(x) print('resnet:',out.shape) if __name__ == '__main__': main()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

- 84

- 85

- 86

- 87

- 88

- 89

- 90

- 91

- 92

- 93

- 94

- 95

- 96

- 97

- 98

- 99

- 100

- 101

- 102

- 103

- 104

- 105

- 106

- 107

- 108

- 109

- 110

- 111

- 112

- 113

- 114

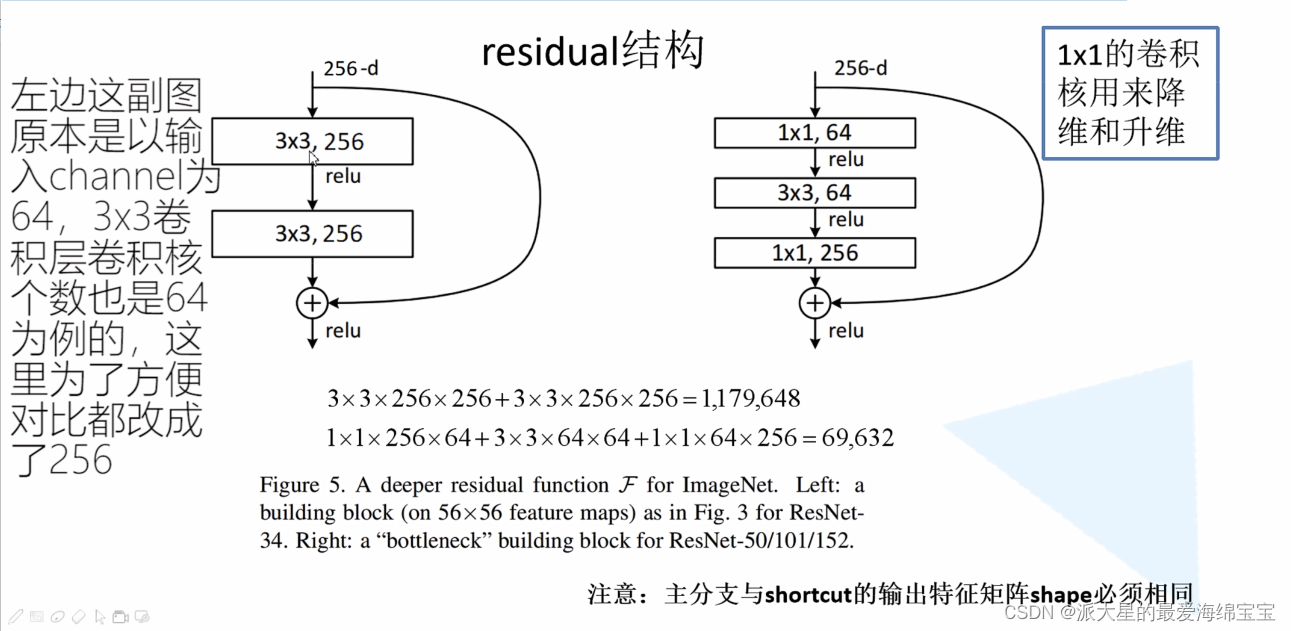

Res残差结构

参考up主:https://www.bilibili.com/video/BV1J3411C7zd?vd_source=a0d4f7000e77468aec70dc618794d26f

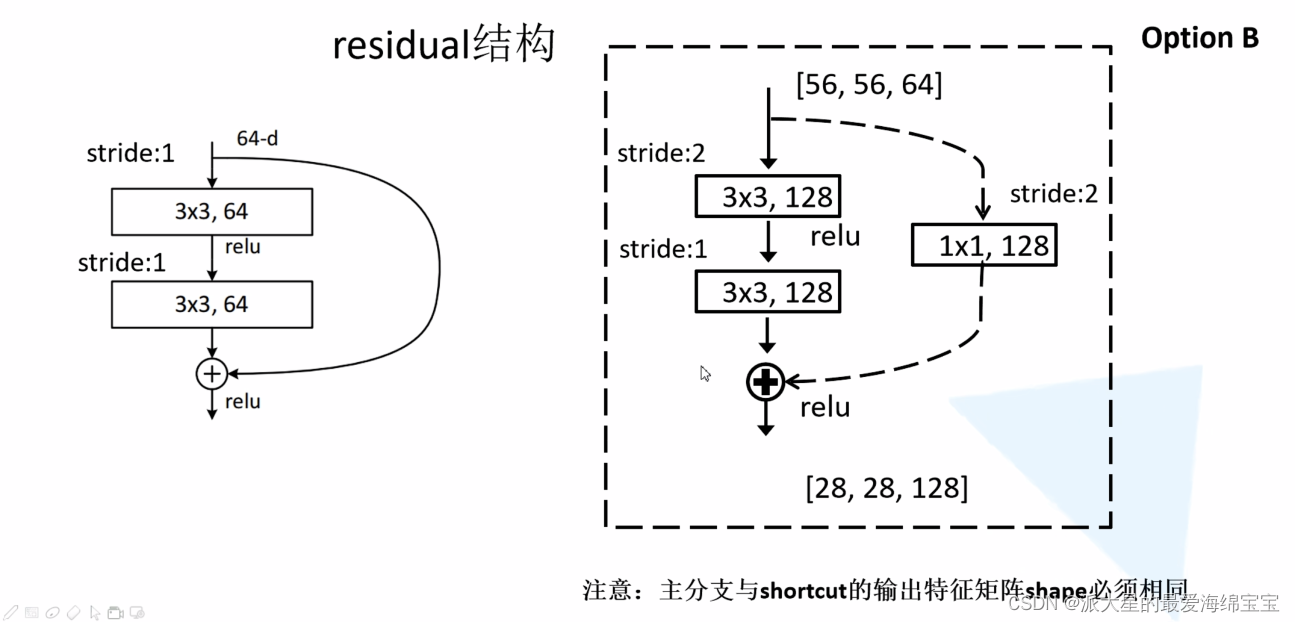

实线与虚线的区别就是相加的维度是否相同。

对于右面,[56,56,64]与[28,28,128]维度不同,高和宽通过stride=2改变,深度64到128通过1×1的卷积核进行升维。

Resnet结构

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/菜鸟追梦旅行/article/detail/121886

推荐阅读

相关标签