- 1深度学习--反向传播_深度学习 反向传播

- 2Hadoop大数据简介_doug cutting和mike cafarella

- 3刷题DAY57 | LeetCode 647-回文子串 516-最长回文子序列

- 4ARM架构和X86架构区别

- 5Kafka 架构深入探索

- 6修复vscode运行vue不能显示network的地址_vdcode network地址

- 7大规模向量检索库Faiss学习总结记录_faiss数据库教程

- 8m基于matlab的光通信误码率仿真,分别对比了OFDM+BPSK和OFDM+4QAM的误码率和星座图_仿真qam或ofdm调制解调实现及误码率分析

- 9神经网络实用工具(整活)系列---使用OpenAI的翻译模型whisper实现语音(中、日、英等等)转中字,从此生肉变熟肉---提高篇(附带打包好的程序)_whisper 幻听

- 10【离线语音专题④】安信可VC离线语音开发板二次开发语音控制LED灯_vc-02 ai-thinker

【Python特征工程系列】教你利用逻辑回归模型分析特征重要性(源码)_逻辑回归 特征重要性

赞

踩

这是Python特征工程系列原创文章,我的第191篇原创文章。

一、问题

应用背景介绍:

如果有一个包含数十个甚至数百个特征的数据集,每个特征都可能对你的机器学习模型的性能有所贡献。但是并不是所有的特征都是一样的。有些可能是冗余的或不相关的,这会增加建模的复杂性并可能导致过拟合。特征重要性分析可以识别并关注最具信息量的特征,从而带来以下几个优势:

- 改进模型性能

- 能减少过度拟合

- 更快训练和推理

- 增强可解释性

前期相关回顾:

【Python特征工程系列】教你利用AdaBoost模型分析特征重要性(源码)

【Python特征工程系列】教你利用XGBoost模型分析特征重要性(源码)

【Python特征工程系列】利用梯度提升(GradientBoosting)模型分析特征重要性(源码)

【Python特征工程系列】8步教你用决策树模型分析特征重要性(源码)

【Python特征工程系列】利用随机森林模型分析特征重要性(源码)

本期相关知识:

逻辑回归模型基于线性回归模型,通过应用逻辑函数(如sigmoid函数)将线性模型的输出映射到0到1之间,从而将其解释为概率。逻辑回归模型的输出表示某个样本属于某个类别的概率。使用sklearn库中的LogisticRegression类创建了一个逻辑回归模型。通过访问模型的coef_属性来获取特征的系数(权重),模型的系数(或权重)来衡量各个特征对预测结果的影响。较大的系数表示对结果影响较大,较小的系数表示对结果影响较小。

二、实现过程

导入第三方库

- import pandas as pd

- from sklearn.model_selection import train_test_split

- from sklearn.linear_model import LogisticRegression

- import matplotlib.pyplot as plt

- import seaborn as sns

2.1 准备数据

- data = pd.read_csv(r'dataset.csv')

- df = pd.DataFrame(data)

2.2 目标变量和特征变量

- target = 'target'

- features = df.columns.drop(target)

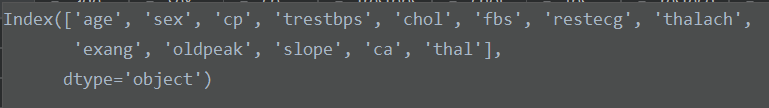

特征变量如下:

2.3 划分训练集和测试集

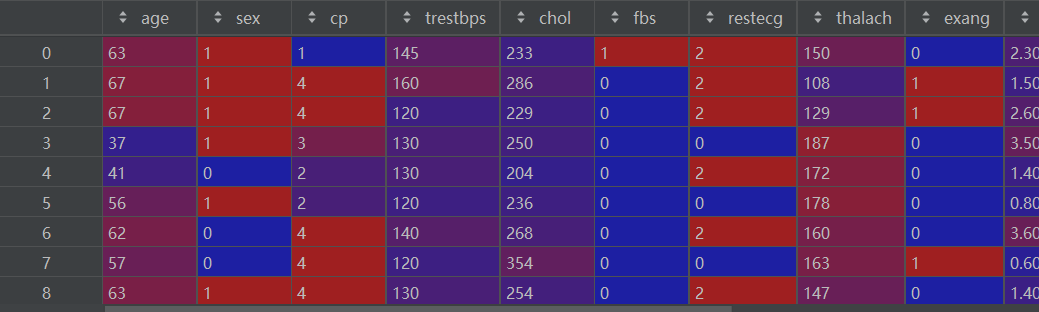

X_train, X_test, y_train, y_test = train_test_split(df[features], df[[target]], test_size=0.2, random_state=0)X_train如下:

2.4 归一化

- # 归一化

- mm1 = MinMaxScaler() # 特征进行归一化

- X_train_m = mm1.fit_transform(X_train)

- mm2 = MinMaxScaler() # 标签进行归一化

- y_train_m = mm2.fit_transform(y_train)

LogisticRegression训练之前需要进行归一化处理!

2.5 训练模型

- model = LogisticRegression()

- model.fit(X_train_m, y_train_m)

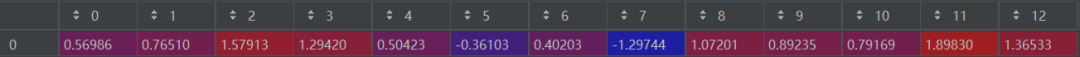

2.6 提取特征重要性

- feature_importance = model.coef_[0]

- feature_names = features

feature_importance如下:

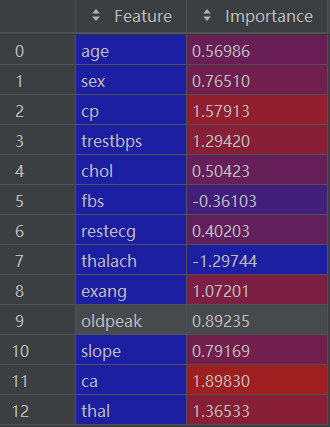

2.7 创建特征重要性的dataframe

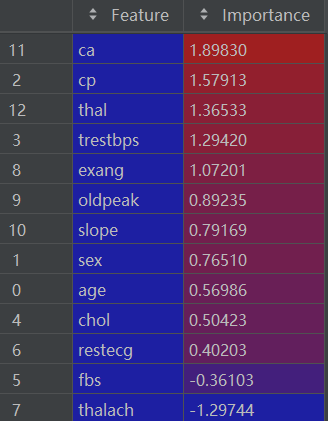

importance_df = pd.DataFrame({'Feature': feature_names, 'Importance': feature_importance})importance_df如下:

2.8 对特征重要性进行排序

importance_df = importance_df.sort_values(by='Importance', ascending=False)排序后的 importance_df如下:

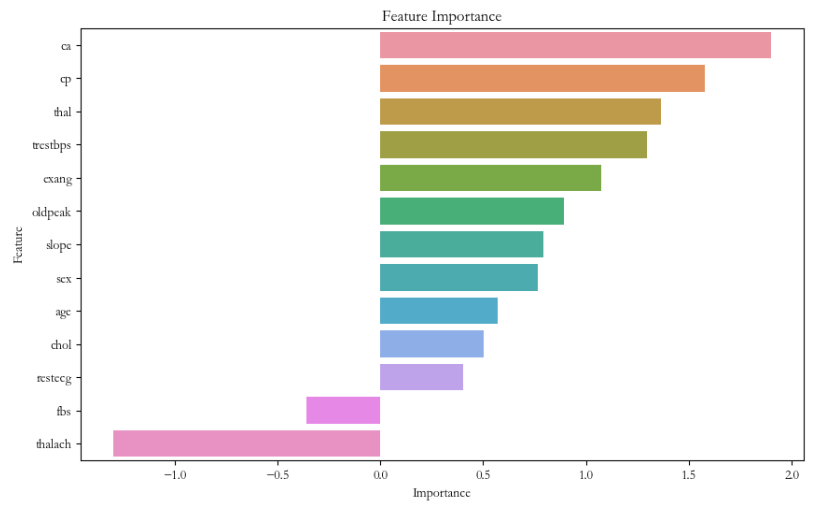

2.9 可视化特征重要性

- plt.figure(figsize=(10, 6))

- sns.barplot(x='Importance', y='Feature', data=importance_df)

- plt.title('Feature Importance')

- plt.xlabel('Importance')

- plt.ylabel('Feature')

- plt.show()

可视化结果如下:

本期内容就到这里,我们下期再见!需要数据集和源码的小伙伴可以关注底部公众号添加作者微信!

作者简介:

读研期间发表6篇SCI数据挖掘相关论文,现在某研究院从事数据算法相关科研工作,结合自身科研实践经历不定期分享关于Python、机器学习、深度学习、人工智能系列基础知识与应用案例。致力于只做原创,以最简单的方式理解和学习,关注我一起交流成长。