热门标签

热门文章

- 1小工具(for朗读软件) ,用python获取bilibili字幕,并清洗序号和时间戳_哔站字幕爬取

- 2MongoDB日常运维之用户管理_mongodb 用户管理

- 3广播的优先级和处理方法_广播优先级

- 4【雕爷学编程】MicroPython手册之 OpenMV Cam LCD显示_openmv lcd

- 5算法——二分查找(一篇搞定)

- 6一个Web前端工程师或程序员的发展方向,未来困境及穷途末路

- 7【TSP问题】基于蚁群算法ACS求解单仓库多旅行商问题MTSP附Matlab代码

- 8JavaScript中不改变原数组的方法:_截取数组不改变原数组

- 9【Spring】使用Spring和AMQP发送接收消息(中)

- 10【内网穿透】如何本地搭建Whisper语音识别模型并配置公网地址_whisper nodejs

当前位置: article > 正文

Spark整合Hive_是spark整合hive

作者:黑客灵魂 | 2024-08-16 11:14:32

赞

踩

是spark整合hive

安装hive

解压hive到指定的目录中,一般解压在/usr/local/hive

tar -zxvf hive-xxx.tar.gz- 1

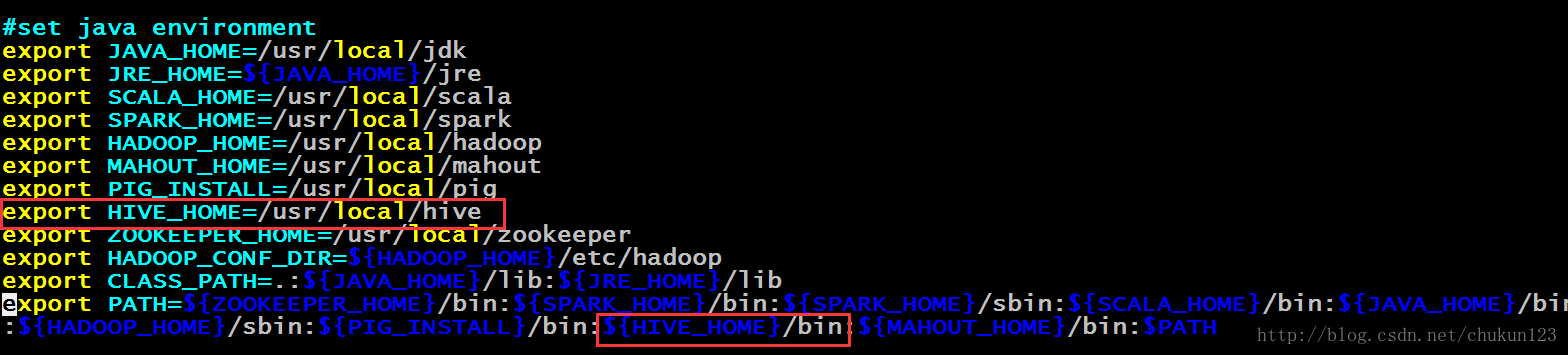

配置系统环境

配置hive-env.sh的环境

配置hadoop的家目录,配置hive的家目录,已及配置hive配置文件的目录

配置hive-site.xml

<property>

<name>hive.metastore.local</name>

<value>true</value>

<description/>

</property>

<!--配置mysql-->

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://192.168.1.3:3306/hive</value>

<description/>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

<description/>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

<description/>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>mysql</value>

<description/>

</property>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

注意,我用的是windows下的mysql,还有,将mysql的驱动jar包放在hive的lib下

启动hive,启动之前必须初始化数据库:我初始化的是mysql数据库

./schemaTool --initSchema --dbType mysql- 1

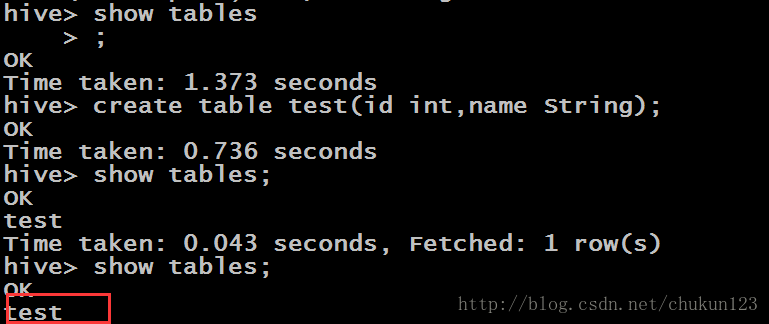

启动hive

./hive- 1

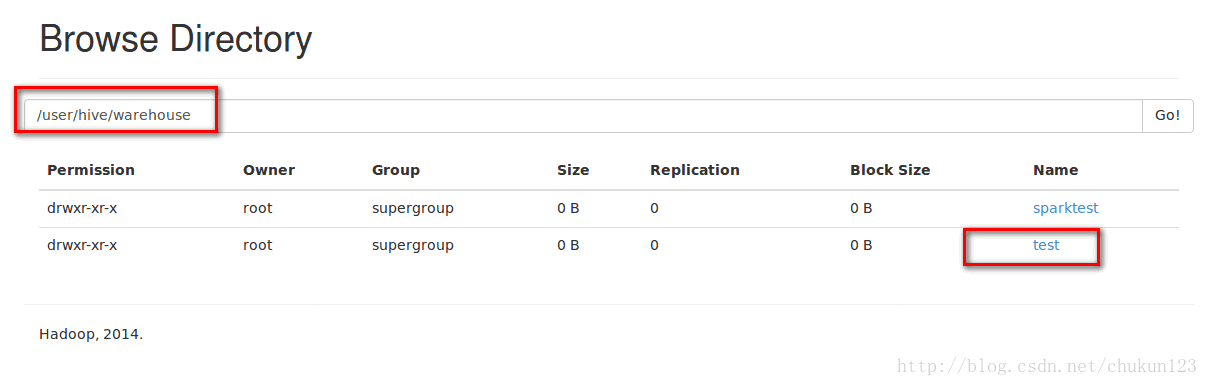

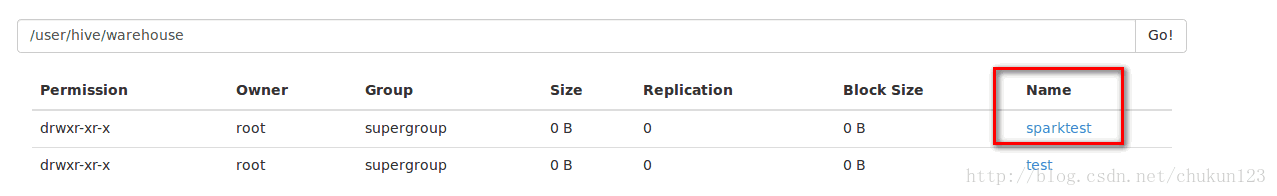

HDFS上面也有建好的数据表

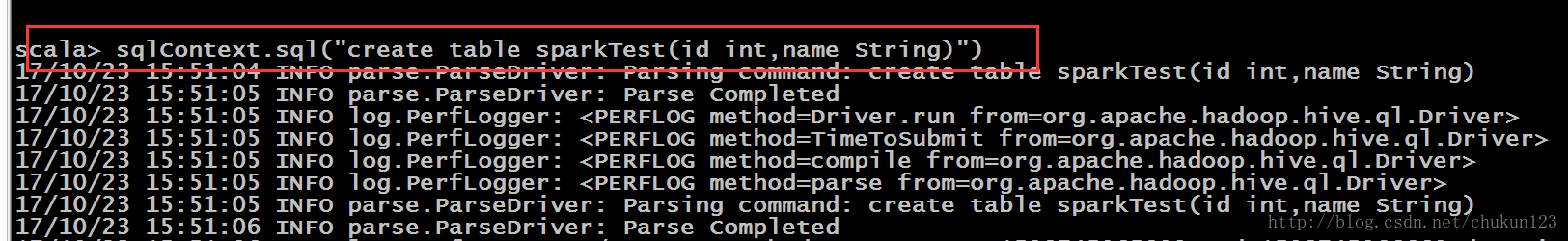

启动spark,启动之前将mysql的驱动包,加入到spark的lib下

启动spark-shell

建表:

HDFS上面也有spark建好的数据表

注意:

1.需要把配置好的hive-site.xml文件copy到spark的安装目录的conf下。

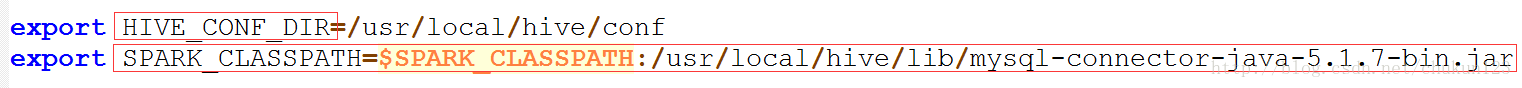

2.在spark的conf下的spark-env.sh中添加hive配置:

Spark整合hive完毕

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/黑客灵魂/article/detail/987960

推荐阅读

相关标签