热门标签

热门文章

- 1[ C语言 ] 用C语言实现小游戏 ---- 三子棋 代码 + 解析_三子棋c语言代码

- 2js : uniapp 同步_uniapp同步接口请求

- 3机器学习-04-分类算法-03KNN算法

- 4vue 从富文本文档中将照片的的路径取出_vue获取富文本中所有图片路径

- 5mysql数据库备份学习笔记

- 6写给初学者的 HarmonyOS 教程 -- ArkTS 容器组件(List)_arkts教程

- 7Flex Box页面布局实战课程-输入框的布局_有没有适合五个框的布局

- 8MetaApp笔试题-在二维数组中查找值/检察树是否是镜像对称树

- 9Python有哪些数据可视化库_python 的地图可视化库

- 10讯飞离线语音合成(离线资源包)_科大讯飞语音文件转语音 离线费用

当前位置: article > 正文

【文献阅读】自适应联邦优化_fedopt

作者:2023面试高手 | 2024-03-16 13:53:39

赞

踩

fedopt

在这项工作中,提出了联邦版本的自适应优化器,包括ADAGRAD、ADAM和YOGI,并分析了它们在一般非凸设置的异构数据存在时的收敛性。

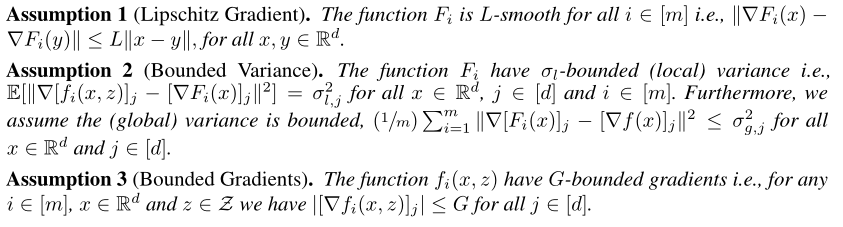

经典三假设,分别是Lipschitz梯度,随机梯度方差有界,梯度值有界:

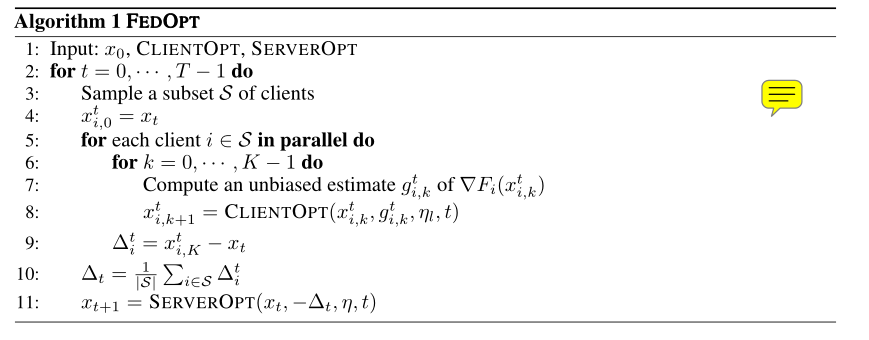

中间定义了一些符号表达,诸如权重参数x的表示,伪梯度的表示等等。然后以下就是算法:

可以看出最重要的部分就是ClientOpt和ServerOpt这两个函数,这两个函数可以替代很多的操作。这让这个FedOpt算法成为一个框架。在接下来我们可以看到,ClientOpt函数多是SGD随机梯度优化,而ServerOpt可以有很多选择。

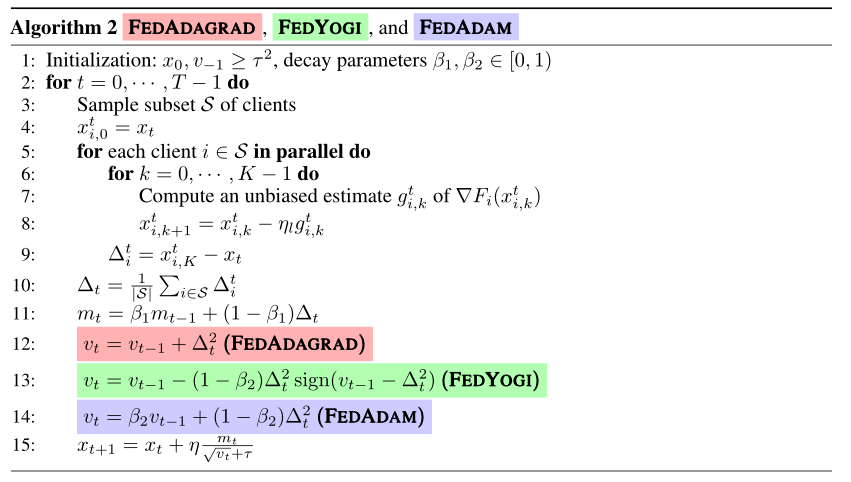

以下为算法的伪代码:

其中控制了算法的自适应程度,越小代表自适应程度越高。

储存了本地在一个本地周期内,权重的变化量。

是各个客户变化量的平均。比较重要的是

和

的计算:

-

被定义为

的动量,由

控制动量比例。

-

则随优化方法而变化,以实现自适应的功能。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/2023面试高手/article/detail/249897

推荐阅读

相关标签