- 1用RegExp解析TXT文件_new regexp('.txt').test(file.type)

- 2zabbix3.0监控centos当主机cpu使用率超过90%的时候报警_zabbix system.cpu.util.avg(1m)}>90

- 3从零开始训练大模型

- 4《TCP/IP 网络编程》第五章——基于 TCP 的服务器端/客户端(2)(学习笔记)_tcp/ip网络编程 第五章

- 551单片机PWM

- 6Django用admin开发的产康中心进销存系统-5_django开启admin二次开发进销存

- 7Spring AOP实现记录mybatis-plus操作数据变化01_aop判断当前sql 是查询还是新增

- 8OpenVINO在Ubuntu 18.04.2 LTS上的安装_怎么查看openvino是否装好ubuntu

- 9华为OD机试2023 最新最全备考攻略助你轻松上岸_华为od机试准备

- 10百度服务器、阿里云服务器开放tomcat端口访问、测试服务器端口_阿里云服务器tomcat打开访问

如何进行深度学习模型的可视化和解释性分析?_深度学习可视化解释模型

赞

踩

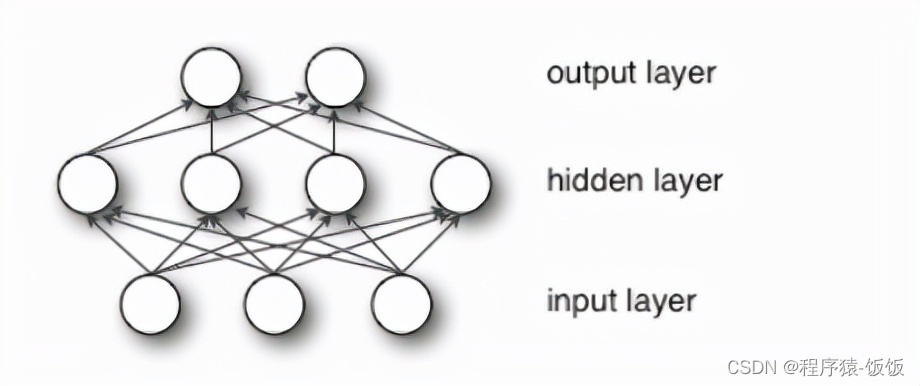

嗨,深度学习探险家们!在深度学习中,模型的可视化与解释性分析是帮助我们理解模型决策过程的重要手段。深度学习模型通常被称为“黑盒”,因为它们在高维空间中进行复杂的计算,难以直观地解释其决策过程。在本文中,我们将探讨深度学习模型的可视化与解释性分析,揭开神秘面纱,洞悉模型的内部。

第一步:特征可视化

特征可视化是深度学习模型可视化的第一步。通过可视化模型的第一层或中间层的特征图,我们可以观察模型在输入数据中学到的低级特征,帮助我们理解模型对不同特征的敏感性。

第二步:热力图和激活图

在可视化模型中,我们可以使用热力图和激活图来显示模型在输入数据中的关注区域。这些图像可以帮助我们了解模型在不同位置和通道上的响应,从而更好地理解模型的决策依据。

第三步:Grad-CAM

Grad-CAM(Gradient-weighted Class Activation Mapping)是一种常用的解释性分析方法,用于可视化模型在输入数据中的重要区域。通过计算梯度权重,Grad-CAM可以生成类别特定的热力图,显示模型对不同类别的判别依据。

第四步:SHAP值分析

SHAP(SHapley Additive exPlanations)值是一种用于解释深度学习模型的预测结果的方法。SHAP值可以帮助我们理解每个特征对于模型预测的贡献程度,从而更好地解释模型的决策过程。

第五步:对抗性样本分析

对抗性样本分析是指通过修改输入数据的微小扰动,使得模型产生错误的预测。通过对抗性样本分析,我们可以了解模型对于输入数据的鲁棒性,从而更好地评估模型的可靠性和稳定性。

第六步:可视化工具

在进行模型可视化与解释性分析时,我们可以使用一些可视化工具来帮助我们更直观地展示分析结果。例如,TensorBoard、LIME等工具都可以用于模型可视化和解释性分析。

感谢大家对文章的喜欢,欢迎关注威 |

❤公众号【AI技术星球】回复(123) |

白嫖配套资料+60G入门进阶AI资源包+技术问题答疑+完整版视频 |

内含:深度学习神经网络+CV计算机视觉学习(两大框架pytorch/tensorflow+源码课件笔记)+NLP等、

|

综上所述,深度学习模型的可视化与解释性分析是揭开“黑盒”模型神秘面纱的重要手段。通过特征可视化、热力图、Grad-CAM、SHAP值分析、对抗性样本分析等方法,我们可以洞悉模型的内部,理解其决策过程。相信通过这些策略,你将能够成功地进行深度学习模型的可视化与解释性分析,从而更好地应用和优化模型!加油,你是最棒的!