热门标签

热门文章

- 1解决from nets import inception_resnet_v2 ModuleNotFoundError: No module named ‘nets‘_modulenotfounderror: no module named 'nets

- 2如何编写testbench的总结(非常实用的总结)

- 3网易有道CEO周枫:大模型应用场景落地的探索与发展_网易有道ceo 周枫 大模型场景落地:应用领域的探索与发展

- 4spring mybatis 动态SQL的insert_insert into 动态sql

- 5mac系统markdown文件编写_markdown mac

- 6硅谷新员工平均低于30岁,程序员靠技术能迈过中年危机吗?

- 7大数据入门-数仓超详细介绍

- 8W10本机docker容器部署springboot项目_springboot+docker+network名连接

- 909. Springboot集成sse服务端推流_springboot sseemitter

- 10Node.js 的适用场景_nodejs

当前位置: article > 正文

讲座笔记:视觉-语言导航新进展:Pre-training与Sim2Real_视觉语言导航vln 离散动作空间到连续动作空间的gap

作者:IT小白 | 2024-07-12 22:33:21

赞

踩

视觉语言导航vln 离散动作空间到连续动作空间的gap

汇报人:吴琦

讲座回放:青源Talk第12期|吴琦:视觉-语言导航新进展:Pre-training与Sim2_哔哩哔哩_bilibili

主题:

①Pre-training:探索order与history在预训练中的作用

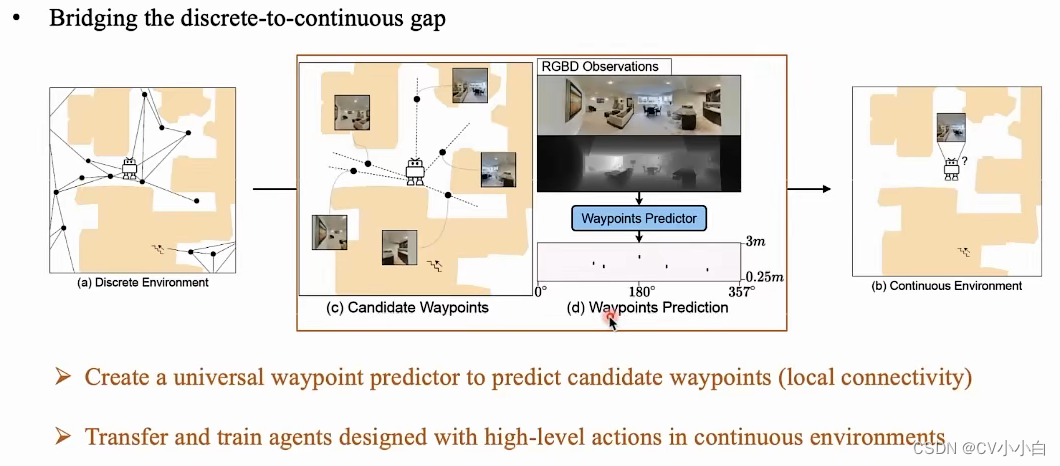

②Sim2Real:减小离散环境和连续环境之间的gap

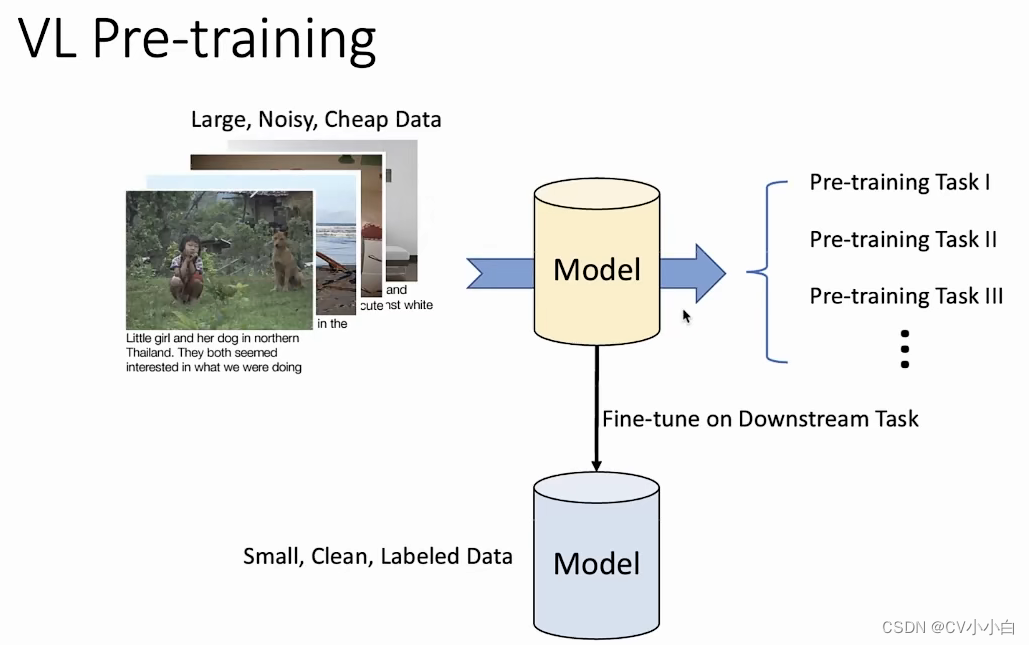

VL Pre-training

注意两个数据集的差异

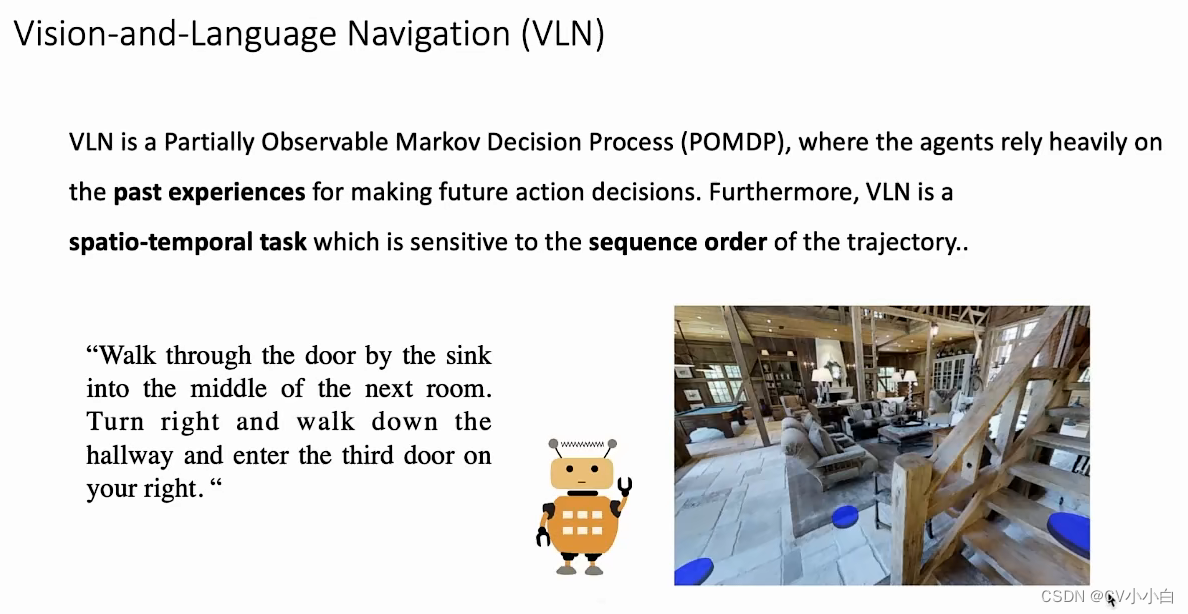

VLN与普通VL的区别:①依赖于“过去的经验”(部分可见的马尔科夫过程);②与空间时序信息有关

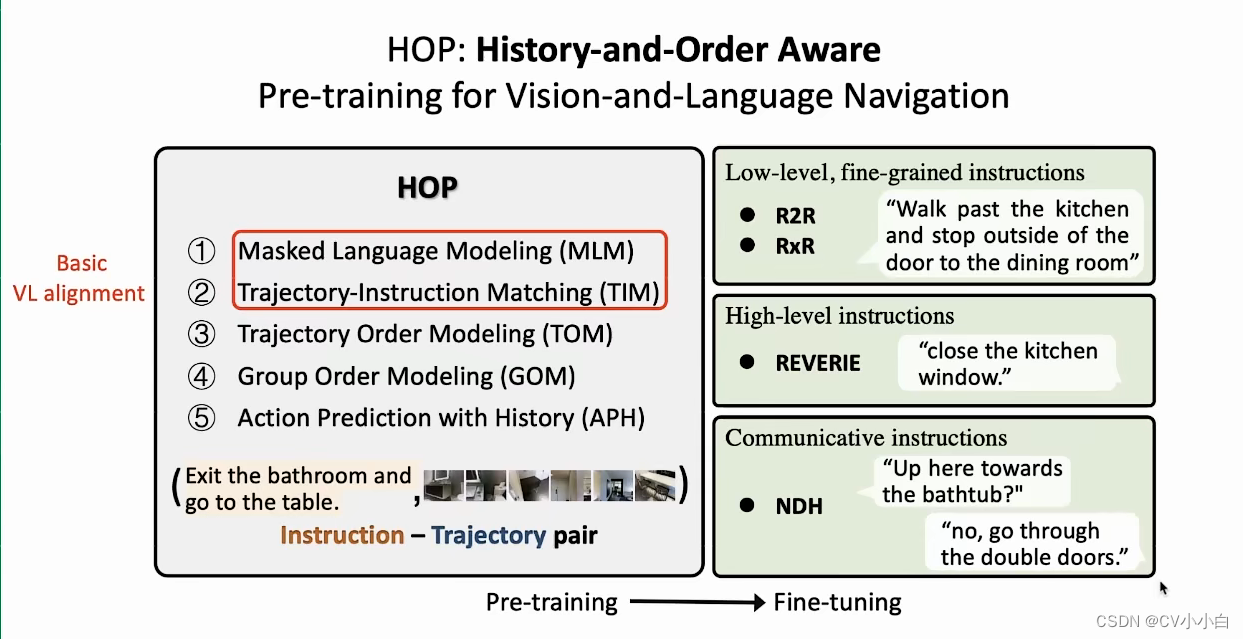

提出了新的预训练范式:三种下游任务;五种预训练任务(其中③④⑤是新提出的)

HOP与之前工作的区别:三个预训练任务,考虑了VLN与VL的区别

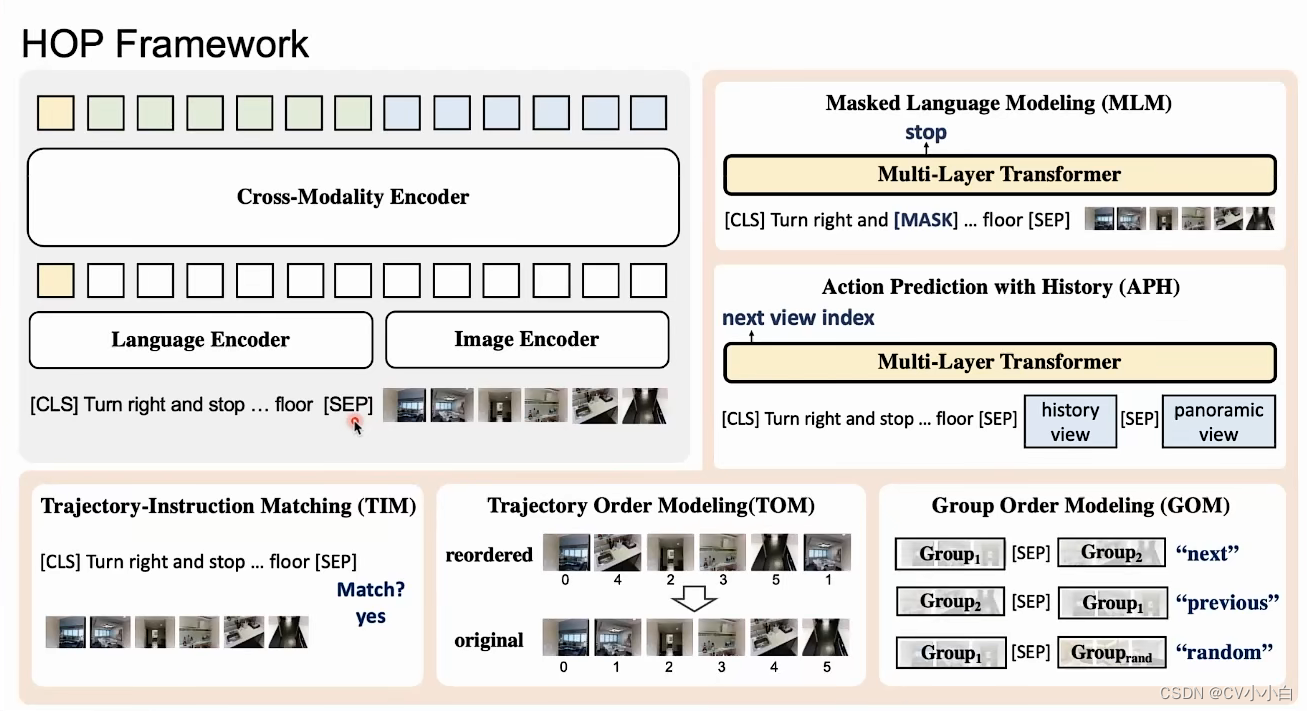

HOP框架:

Architecture:

注意语言端是position,视觉端为orientation

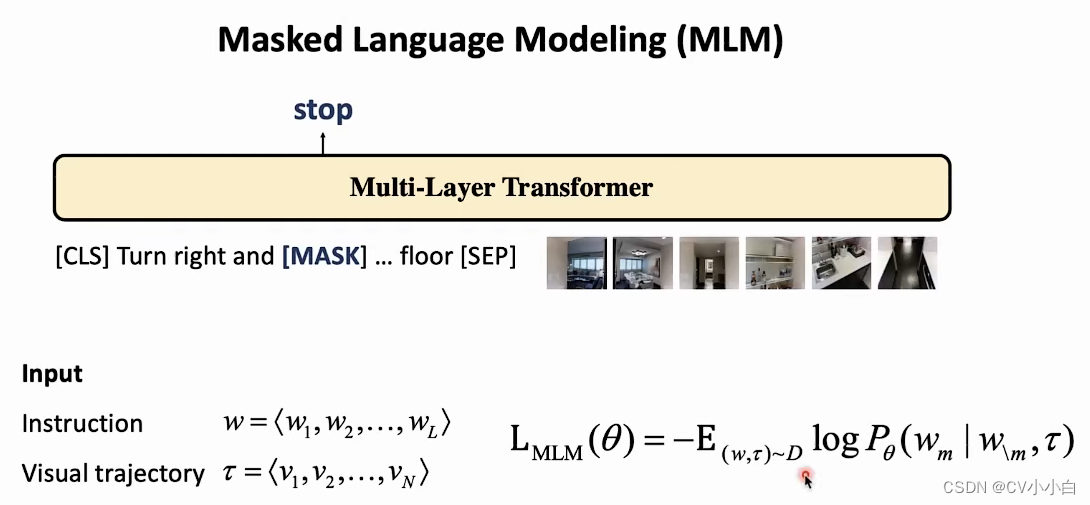

MLM:对某些词进行mask,要求AI根据环境信息进行还原

TIM:判断instruction是否与一系列的图像匹配

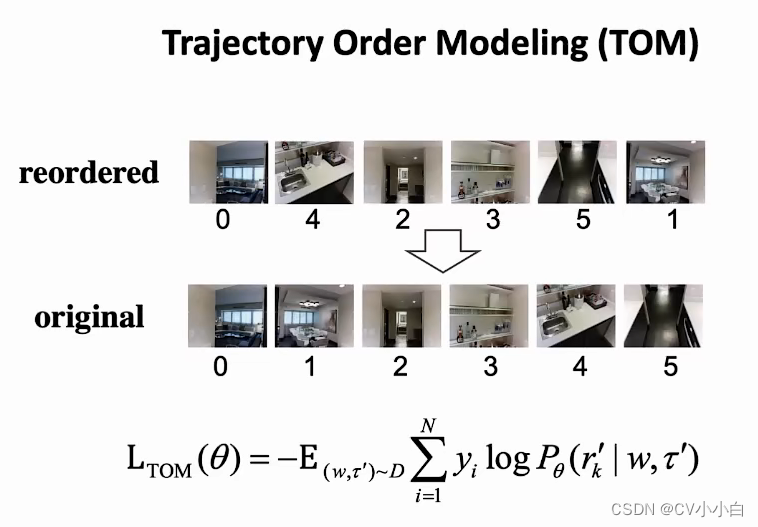

TOM:随机打乱场景顺序,让AI进行排序

GOM:粗粒度的TOM,将group分成两部分打乱;输入instruction与group,判断group为next、previous还是random(即group与instruction无关)

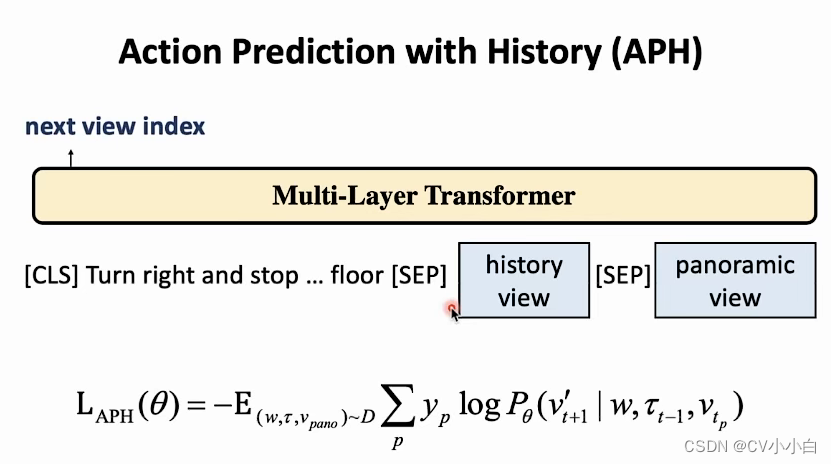

APH:给定history和、instruction和全景图片,让AI判断next view的方向(在全景图片中的方向,一般分为12个)

Sim2Real

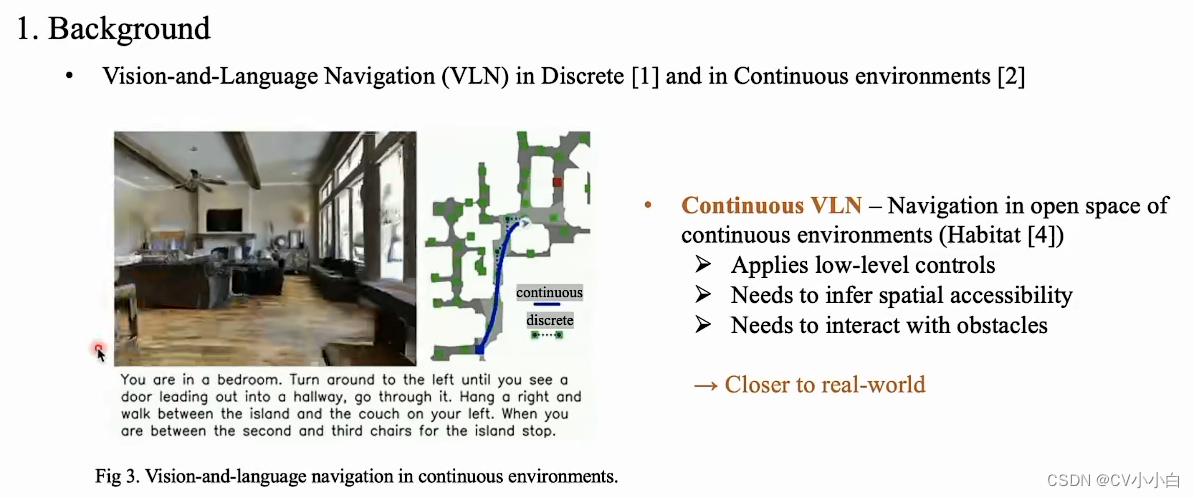

如何要提出这个问题:离散环境与连续环境之间存在gap ,连续环境中需要做的决策会多很多,出错概率较大

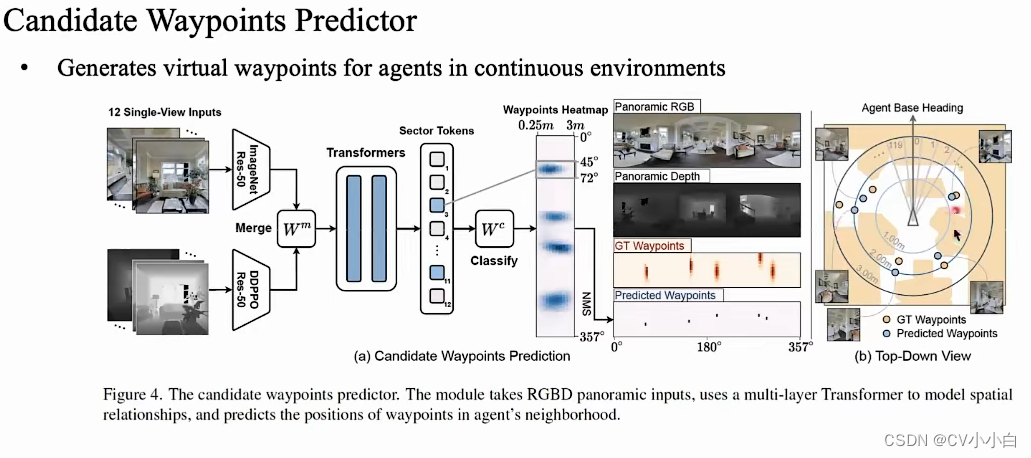

如何解决:在连续的空间中预测离散的点,利用了深度图等信息

如何预测candidate waypoint

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/IT小白/article/detail/816318

推荐阅读

相关标签