- 1ELK安装配置,监控nginx日志

- 2回溯法 —— 求解0/1背包问题(剪枝)_回溯法求解0-1背包问题

- 3手撕HashMap(1.7)

- 4MySQL 连接数过多的处理方法合集 - ERROR 1040 Too many connections - 卡拉云_error 1040: too many connections

- 5Spring Boot 中的 Spring Security 是什么,如何使用_springboot security

- 6【ChatGPT】开源软件:ChatALL —— 我是 GitHub 榜一!(PS: 其实,小编本地 build run 了一下,就是一个组装 Chat UI ……)

- 7云手机在海外电商中的应用优势

- 8vite动态引入报错,vite配置vue-router,封装动态导入控制台报错问题_the above dynamic import cannot be analyzed by vit

- 9第一篇 Java核心技术细讲之ArrayList_arraylist常用的业务场景推荐

- 10java静态变量和成员变量的区别_java中静态变量和成员变量的区别

Attention机制

赞

踩

1. Seq2Seq

https://blog.csdn.net/weixin_44305115/article/details/101461899

向量C就是输入序列通过Encode得到的序列的编码,代表在某一个向量空间的输入序列的编码。

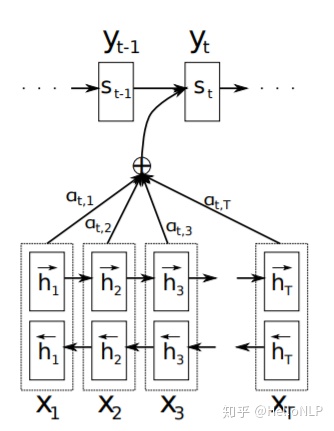

2. Attention机制

但是由于在解码的时候,都依赖于这一个唯一的C,w1,w2,w3在解码的时候,所关注的部分是没有区别的,所以提出Attention机制,来优化Seq2Seq。

理想情况下,在一位一位进行解码的过程中,C应该有所区别,代表当前解码时,Decoder更关注的是输入序列的哪个位置(这个直观想法非常好)

1) Bahdanau Attention

《NEURAL MACHINE TRANSLATION BY JOINTLY LEARNING TO ALIGN AND TRANSLATE》

2)LuongAttention

《Effective Approaches to Attention-based Neural Machine Translation》

计算过程:

3)location-based attention

上两个图是pytorch Seq2Seq with attention 的toturial,use location-based attention。

4)多种Attention:

参考:

https://blog.csdn.net/u010960155/article/details/82853632

https://blog.csdn.net/weixin_44305115/article/details/101461899

https://zhuanlan.zhihu.com/p/272662664

https://github.com/graykode/nlp-tutorial/blob/master/4-2.Seq2Seq(Attention)/Seq2Seq(Attention).py (LuongAttention)

https://blog.csdn.net/wi162yyxq/article/details/103600170