- 1testbench仿真赋值时,为符合真实情况,时序逻辑应延迟一拍_vivado testbench延迟

- 2漏洞挖掘技术综述与人工智能应用探索:从静态分析到深度学习,跨项目挑战与未来机遇_机器学习与人工智能算法在超深基坑监测中的应用(1)

- 3HDFS读写流程(最新史上最详细)

- 4Java-序列化和反序列化_java序列化和反序列化

- 5yolov5旋转目标检测遥感图像检测-无人机旋转目标检测(代码和原理)_yolov5可以实现什么功能

- 6mysql学习--使用navicat查看数据库密码_navicat查看mysql密码

- 7C++操作xlsx初体验:OpenXLSX(建议使用)、libxl

- 8HarmonyOS应用开发者初级认证试题库(鸿蒙)_华为初级考试题库

- 9navicat连接MySQL数据库创建数据库的字符集和排序规则配置_用navicat运行sql文件时排列规则选什么

- 10layerNorm和batchNorm

学习笔记--神经网络与深度学习之循环神经网络_循环图神经网络recurrent graph neural networks

赞

踩

目录

全前馈神经网络,信息单向传递,网络易学习,但能力被减弱。网络输出只依赖于当前的输入。输入输出维数固定。

循环神经网络,具有短期记忆能力。其中的神经元可接收 其他神经元的信息和 本身的信息。输入输出可不固定。参数学习可通过随时间反向传播算法学习。输入序列较长时,错误信息向前传递过长,存在梯度爆炸和梯度消失问题,即长程依赖问题,一种有效的改进方式:门控机制。

循环神经网络易拓展到更广义的记忆网络模型: 递归神经网络、 图网络。

1. 给网络增加记忆能力

时序数据处理需要历史信息。前馈网络无记忆能力。

介绍三种方法给网络增加记忆能力:

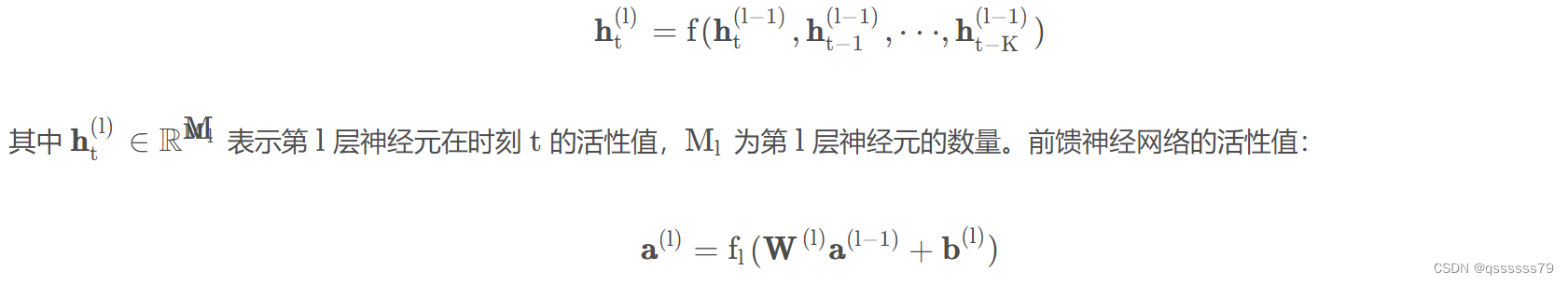

1.1 延时神经网络

延时神经网络通过在前馈网络的非输出层中都添加一个延时器,记录神经元的最近几次活性值,增加前馈网络的短期记忆能力。在 t时刻,第 l 层神经元的活性值依赖于第 l − 1 层神经元的最近 K 个时刻的活性值:

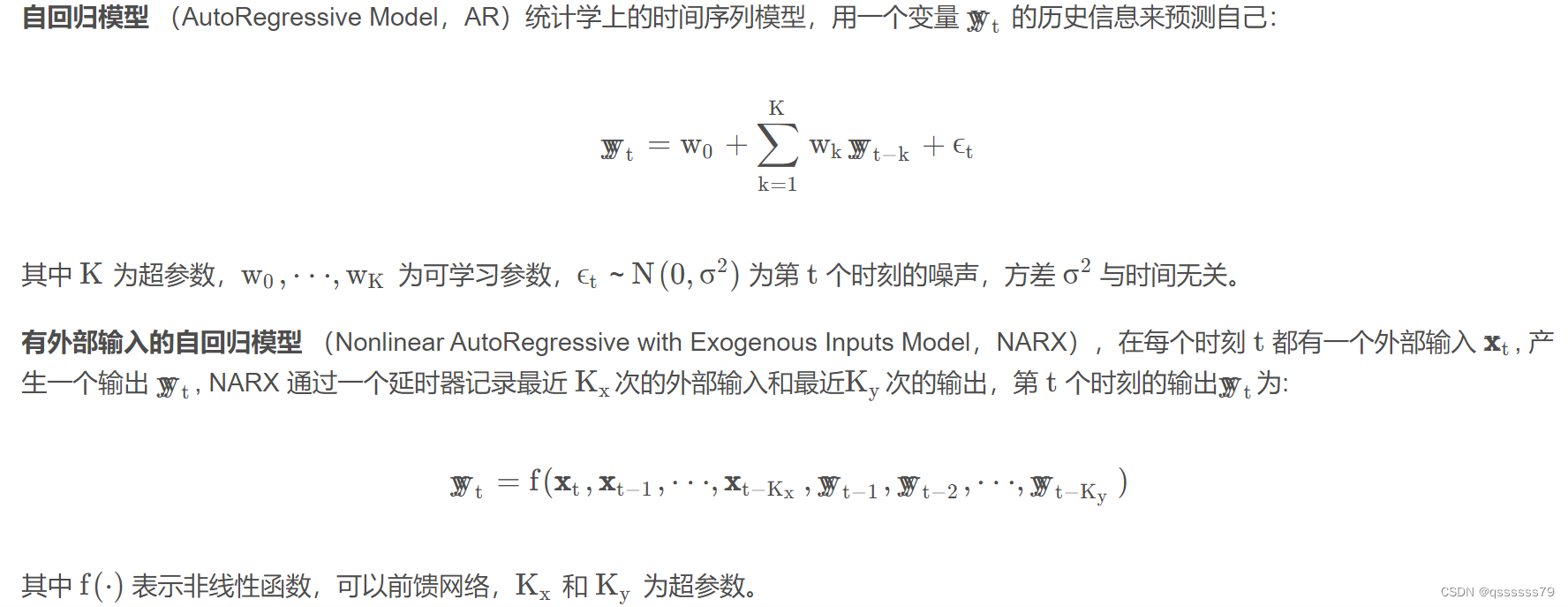

1.2 有外部输入的非线性自回归模型

1.3 循环神经网络

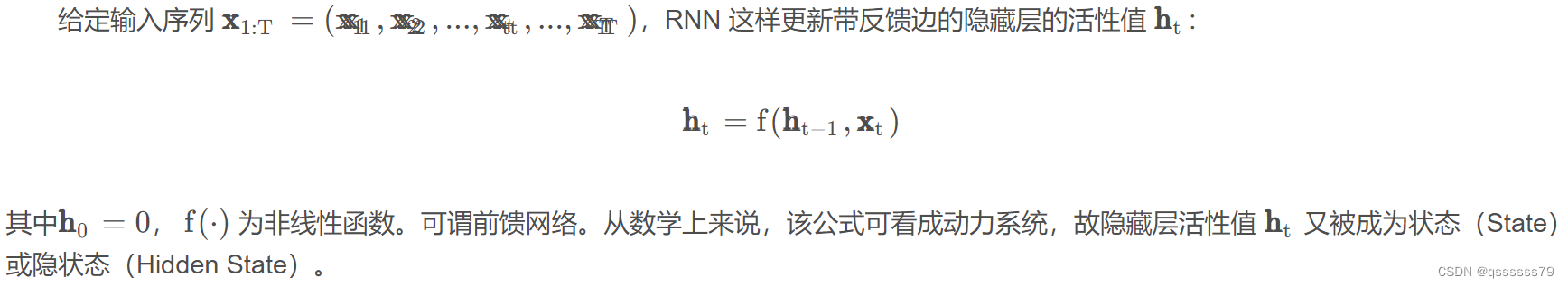

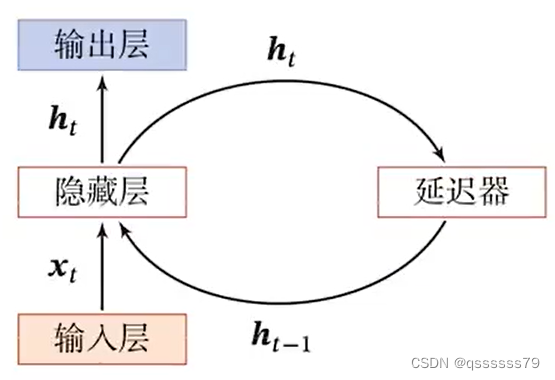

循环神经网络 (Recurrent Neural Network,RNN)通过使用带自反馈的神经元处理任意长度的时序数据。

图 循环神经网络

2. 简单循环网络

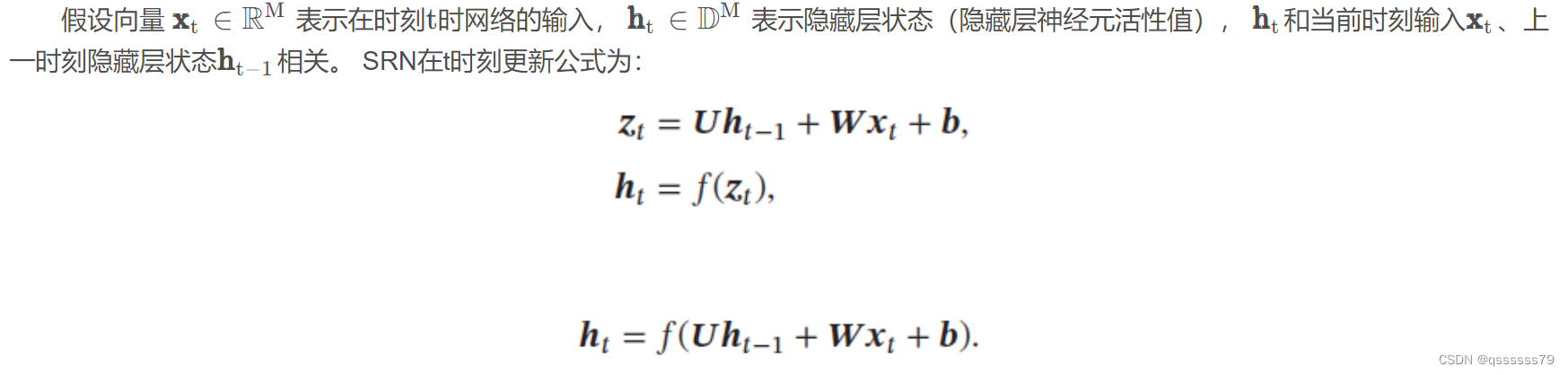

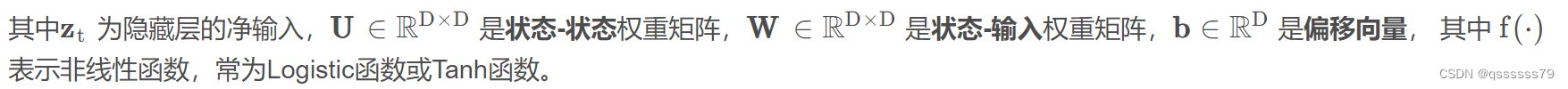

简单循环网络(SRN)只有一个隐藏层。在一个两层的前馈神经网络中,连接存在相邻的层与层之间,隐藏层的节点之间无连接。简单循环网络增加了隐藏层到隐藏层的反馈连接。

若把每个时刻的状态都看做前馈神经网络的一层,循环神经网络可看做在时间维度上权值共享的神经网络。按时间展开的循环神经网络:

2.1 循环神经网络的计算能力

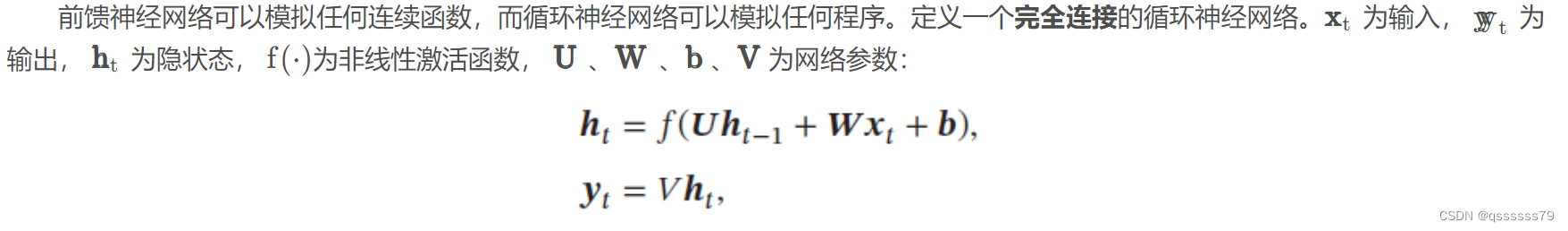

2.1.1 循环神经网络的通用近似定理

循环神经网络的拟合能力也十分强大。一个完全连接的循环网络是任何非线性动力系统的近似器。可用通用近似定理解释:

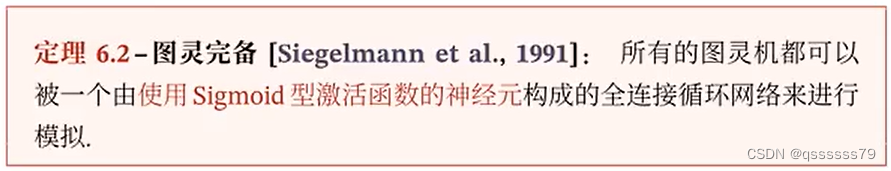

2.1.2 图灵完备

图灵完备(Turing Completeness)是指一种数据操作规则,比如一种编程语言,可以实现图灵机(Turing Machine)的所有功能,解决所有的可计算问题。

故一个完全连接的循环神经网络可以近似解决所有的可计算问题。

3. 应用到机器学习

循环神经网络可以应用到三种模式的机器学习任务::序列到类别模式、同步的序列到序列模式、异步的序列到序列模式。

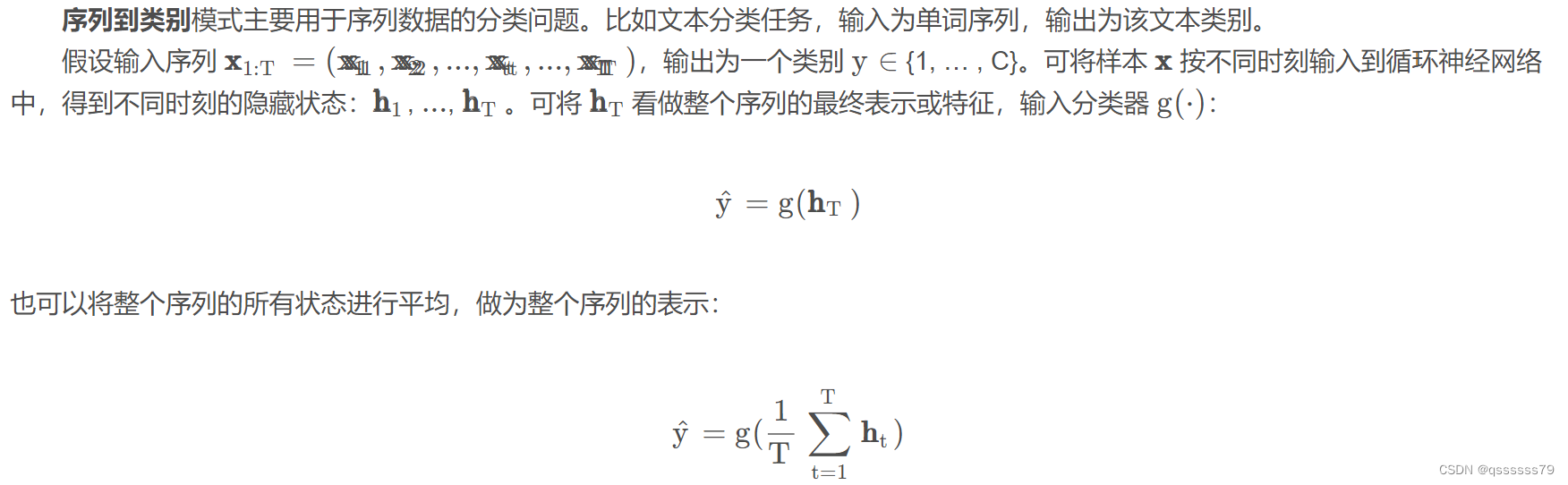

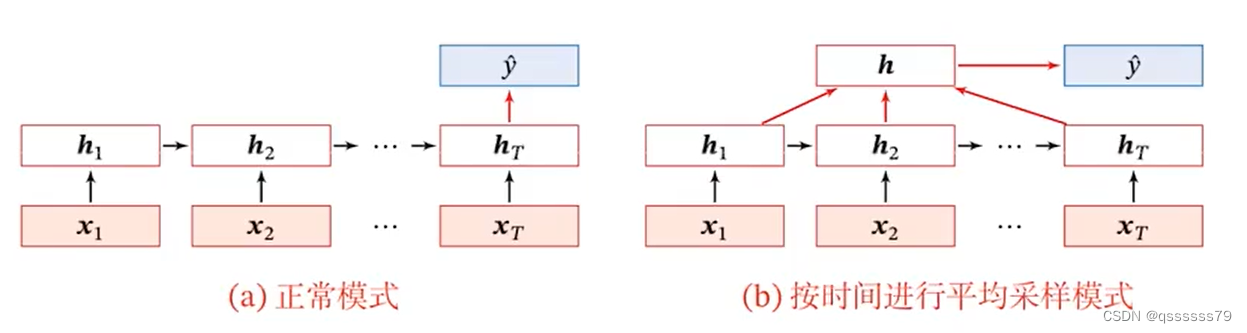

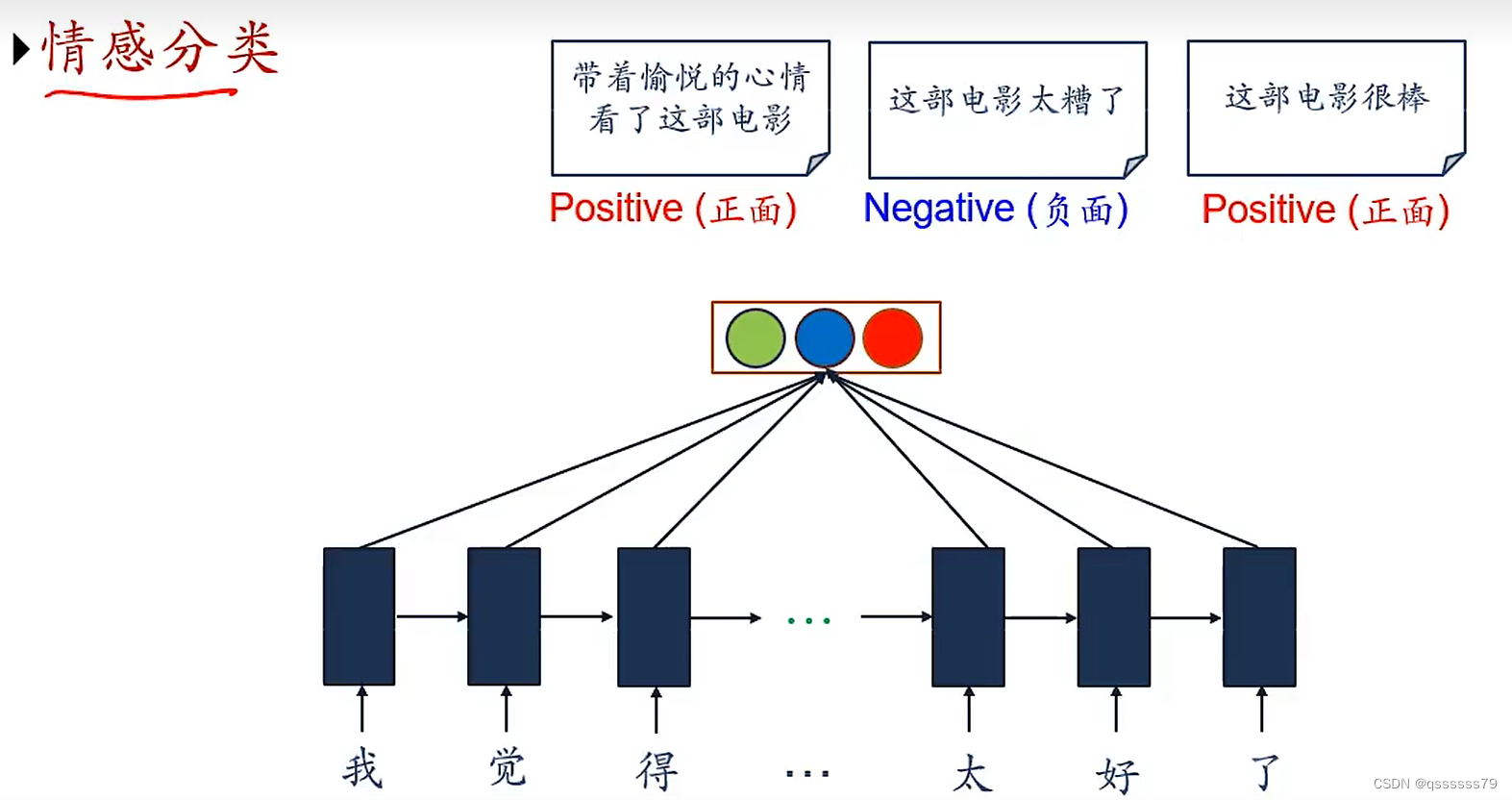

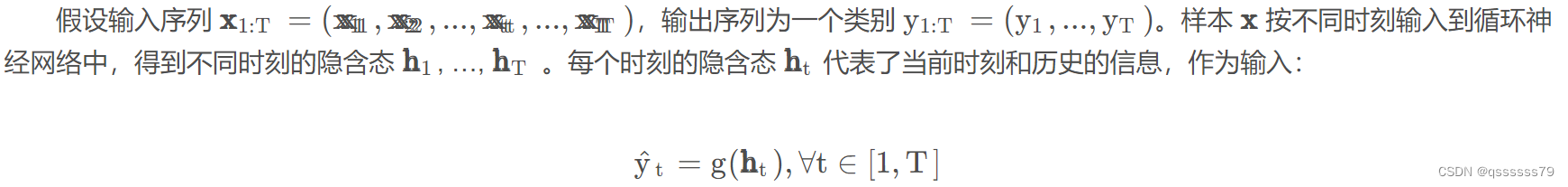

3.1 序列到类别模式

序列到类别模式主要用于序列数据的分类问题。比如文本分类任务,输入为单词序列,输出为该文本类别。

两种图示:

两种图示:

运用场景:

运用场景:

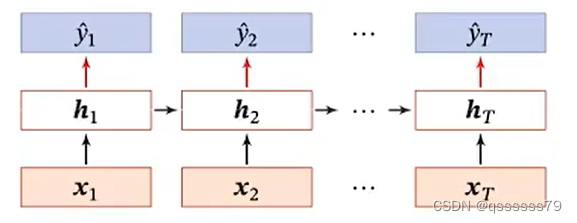

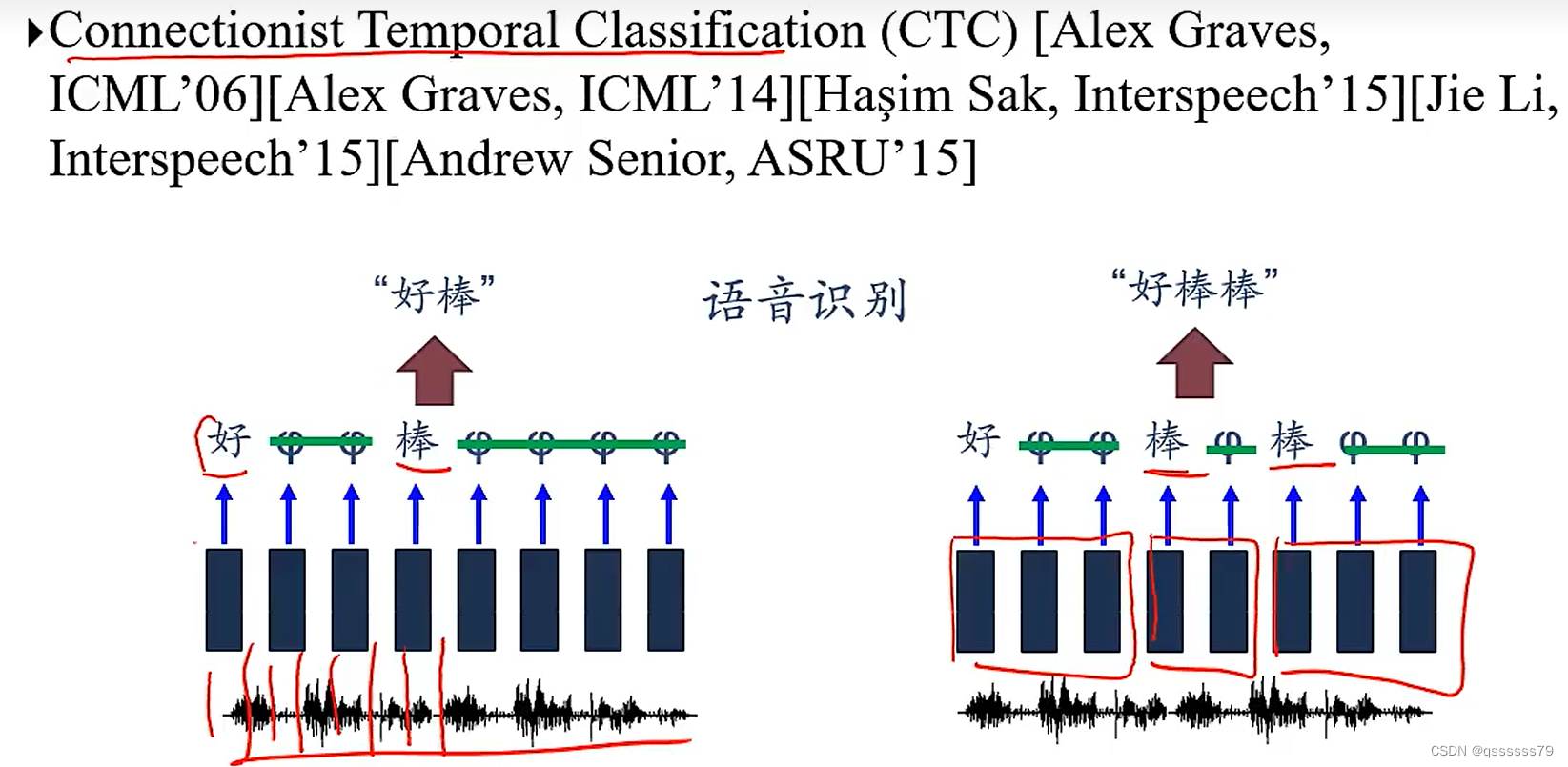

3.2 同步的序列到序列模式

同步的序列到序列模式主要用于序列标注(Sequence Labeling)任务,即每一时刻都有输入输出,输入输出序列长度相同。比如在词性标注(Part-of-Speech Tagging)中,每一个单词需要标注其词性标签。

图示:

图示:

应用:

中文分词:(s-start、b-beginning、e-ending)

信息抽取:

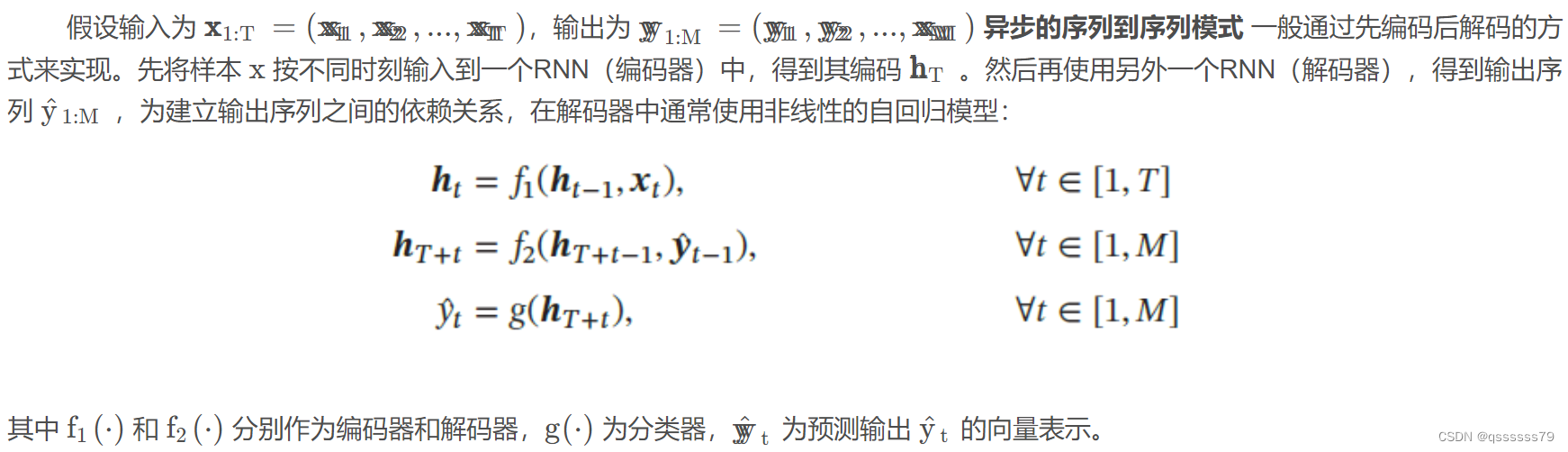

3.3 异步的序列到序列模式

异步的序列到序列模式 又称编码器-解码器(Encoder-Decoder)模型,即输入序列和输出序列不需具有严格的对应关系,也不需相同长度。比如机器翻译任务中,输入为源语言单词序列,输出为目标语言单词序列。

异步的序列到序列模式示例如下图,其中〈

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。