热门标签

热门文章

- 1Linux yum与apt安装区别与联系_yum install apt

- 2华为OD 技术综合面,手撕代码真题整理(二一):寻找缺失的数字 | 矩阵路径最小和_华为手撕代码 csdn

- 3opencv如何利用掩码将两张图合成一张图_cv2带掩码的图像合成

- 4全方位指南:从零基础到实战精通,大模型学习教程全面解析!_大模型学习和使用_大模型实战大纲

- 5如何将heic图片转jpg图片格式?5种转换方法可以试试!_heic文件和jpg文件知乎

- 6python的selenuim爬虫爬取实例_sele爬虫点击标题跳转的链接怎么看

- 7redis服务器

- 8加密算法-BASE64_base64加密算法

- 9用哈希表封装unordered_map(以及unordered_set)【C++】

- 10linux精简指令集,精简指令集(MIPS为例)常用指令特点及其格式

当前位置: article > 正文

ChatGPT开源的whisper音频生成字幕_whisper transcribe

作者:代码探险家 | 2024-08-09 15:58:50

赞

踩

whisper transcribe

1、前言

好了,那接下来看一下whisper开源库的介绍

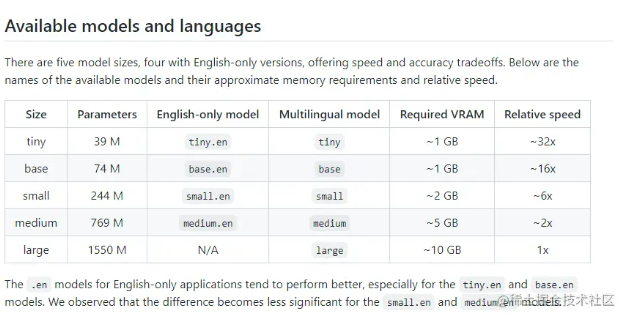

有五种模型大小,其中四种仅支持英语,提供速度和准确性的权衡。上面便是可用模型的名称、大致的内存需求和相对速度。如果是英文版的语音,直接想转换为英文。

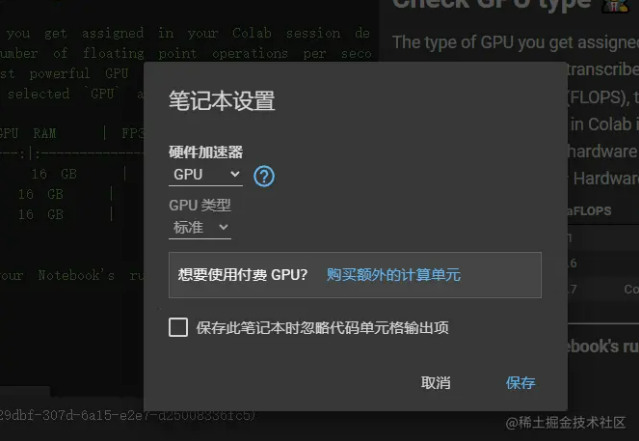

本来我是想直接在我的本地电脑上安装环境的,也就是无非安装python、ffmpeg、以及whisper,但是发现电脑配置太低了,而且我想测试一下large模型,CPU 肯定是不行,但是如果用本机的 GPU也是快不到哪里去的。 所以这里我想到谷歌的colab.research.google.com 免费在线运行,而且我可以启用GPU硬件加速,感觉上还是非常快的,当然如果需要你还可以购买。

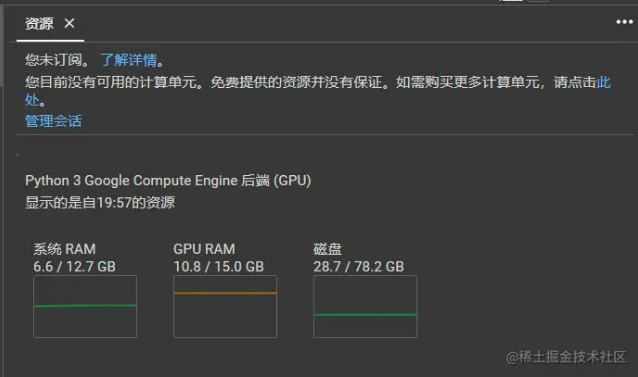

下面是我的免费配置 colab.research.google.com

运行起来还是非常流畅,真的香喷喷,如果需要我都想付费了。

可以应用于那些场景

- 会议记录: 直接将录音转换为文字

- 个人视频制作: 很多时候都希望有字幕的效果,听说剪映的效果都没有这个好

- 课堂记录转写:将课堂上的内容记录下来,这样后面直接查看文字版本也是非常方便

- 通话记录:有些重要的电话可将其录音,转换为文字以备后面查询也是非常不错的

- 字幕组:这个就不用说了 有可能还涉及到多语言,准备率很高的话 可以省很多事情

- 实时语音翻译:这个服务器配置够高的话,理论上就非常快速

2、开始实践

2.1、检查colab环境

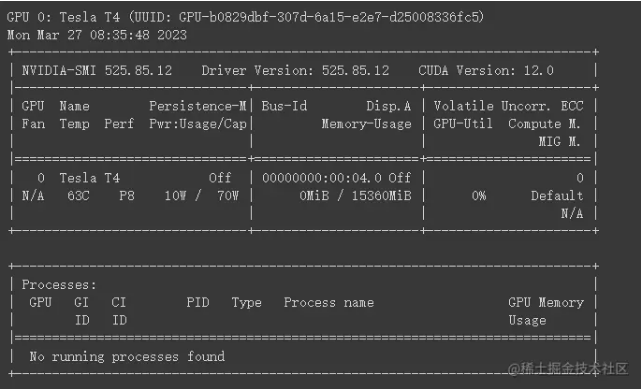

!nvidia-smi -L !nvidia-smi

运行两个指令结果如下:

1.!nvidia-smi -L:-L 参数用于列出系统上安装的所有 NVIDIA GPU 设备。运行此命令后,您将看到关于可用 GPU 的信息,包括其型号和 UUID。

2.!nvidia-smi:不带任何参数运行 nvidia-smi 会显示有关 NVIDIA GPU 的详细信息,包括:

-

- GPU 设备的编号、名称、总内存和温度。

- GPU 使用率(如计算、内存和显存使用率)。

- 运行在 GPU 上的进程以及它们的相关信息(如进程 ID、显存占用等)。

只不过这里我还没开始使用GPU而已,所以显示的是空的。

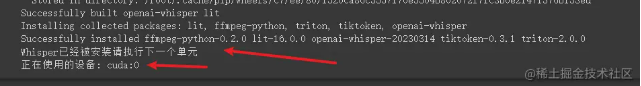

2.2、安装whisper

!pip install requests beautifulsoup4

!pip install git+https://github.com/openai/whisper.git

import torch

import sys

device = torch.device('cuda:0')

print('正在使用的设备:', device, file=sys.stderr)

print('Whisper已经被安装请执行下一个单元')

这里主要就是安装whisper

2.3、 whisper模型选择

#@markdown # ** whisper Model选择** 声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/代码探险家/article/detail/954065

推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。