热门标签

热门文章

- 1Sora 究竟有多烧钱?Sora的推理与训练的计算成本被扒出来了

- 2分享一个解决的bug:训练Rasa的时候出现“Error running graph component for node train_DIETClassifier4”_rasa.engine.exceptions.graphcomponentexception: er

- 3打破工作“二八法则” UniPro用AI提升工作效率_研发二八定律

- 4鸿蒙初体验_鸿蒙4.0 设备安装路径要和项目路径一致么

- 5从政府工作报告中的IT热词统计探计算机行业发展(三)智能网联新能源汽车:2次

- 6第六章:计算机视觉大模型实战6.2 目标检测与识别6.2.3 实战案例与技术进阶_大模型目标检测

- 7Qt 学习资料整合_qt资料

- 8全网最通俗易懂的 Self-Attention自注意力机制 讲解_self attention机制

- 9python层次聚类选择类别_不写代码,教你用聚类算法,刻画一个升级版的RFM模型......

- 10合格的程序员之GitHub_where the world builds software

当前位置: article > 正文

神经网络学习笔记(二)GRNN广义回归神经网络

作者:凡人多烦事01 | 2024-03-24 15:46:22

赞

踩

grnn

广义回归神经网络(GRNN)

广义回归神经网络是径向基神经网络的一种,GRNN具有很强的非线性映射能力和学习速度,比RBF具有更强的优势,网络最后普收敛于样本量集聚较多的优化回归,样本数据少时,预测效果很好,还可以处理不稳定数据。虽然GRNN看起来没有径向基精准,但实际在分类和拟合上,特别是数据精准度比较差的时候有着很大的优势。

关于RBF,GRNN与PNN

-

RBF网络是一个两层的网络,除了输入输出层之外仅有一个隐层。隐层中的转换函数是局部响应的高斯函数,而其他前向型网络,转换函数一般都是全局响应函数。由于这样的不同,要实现同样的功能,RBF需要更多的神经元,这就是RBF网络不能取代标准前向型网络的原因。但是RBF的训练时间更短。它对函数的逼近是最优的,可以以任意精度逼近任意连续函数。隐层中的神经元越多,逼近越较精确.

-

径向基神经元和线性神经元可以建立广义回归神经网络,它是径RBF网络的一种变化形式,经常用于函数逼近。在某些方面比RBF网络更具优势。

-

径向基神经元和竞争神经元还可以组成概率神经网络。PNN也是RBF的一种变化形式,结构简单训练快捷,特别适合于模式分类问题的解决。

一、GRNN网络结构

GRNN是RBF的一种改进,结构相似。区别就在于多了一层求和层,而去掉了隐含层与输出层的权值连接(对高斯权值的最小二乘叠加)。

文字解析:

1.输入层为向量,维度为m,样本个数为n,线性函数为传输函数。

2.隐藏层与输入层全连接,层内无连接,隐藏层神经元个数与样本个数相等,也就是n,传输函数为径向基函数。

3.加和层中有两个节点,第一个节点为每个隐含层节点的输出和,第二个节点为预期的结果与每个隐含层节点的加权和。

4.输出层输出是第二个节点除以第一个节点。

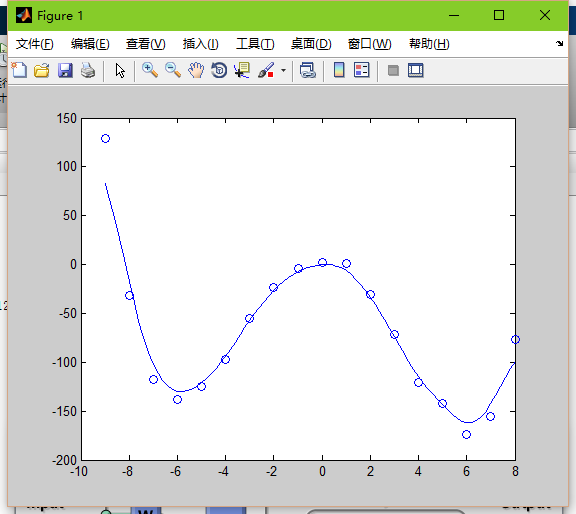

二、GRNN的MATLAB实现

- %设置变量

- data=-9:1:8;

- x=-9:.2:8;

- label=[129,-32,-118,-138,-125,-97,-55,-23,-4,2,1,-31,-72,-121,-142,-174,-155,-77];

- %由于grnn没有权值的处理,不用训练使得他的处理速度很快

- %隐藏层的处理

- spread=1; %默认值

- chdis=dist(x',data)

- chgdis=exp(-chdis.^2/spread);

- chgdis=chgdis';

- %加和输出

- y=t*chgdis./(sum(chgdis))

-

-

-

查看图像效果

plot(x,y,'o')

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/凡人多烦事01/article/detail/303358

推荐阅读

相关标签