- 1深度学习--反向传播_深度学习 反向传播

- 2Hadoop大数据简介_doug cutting和mike cafarella

- 3刷题DAY57 | LeetCode 647-回文子串 516-最长回文子序列

- 4ARM架构和X86架构区别

- 5Kafka 架构深入探索

- 6修复vscode运行vue不能显示network的地址_vdcode network地址

- 7大规模向量检索库Faiss学习总结记录_faiss数据库教程

- 8m基于matlab的光通信误码率仿真,分别对比了OFDM+BPSK和OFDM+4QAM的误码率和星座图_仿真qam或ofdm调制解调实现及误码率分析

- 9神经网络实用工具(整活)系列---使用OpenAI的翻译模型whisper实现语音(中、日、英等等)转中字,从此生肉变熟肉---提高篇(附带打包好的程序)_whisper 幻听

- 10【离线语音专题④】安信可VC离线语音开发板二次开发语音控制LED灯_vc-02 ai-thinker

GPU底层优化 | 如何让Transformer在GPU上跑得更快?

赞

踩

点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达

前言

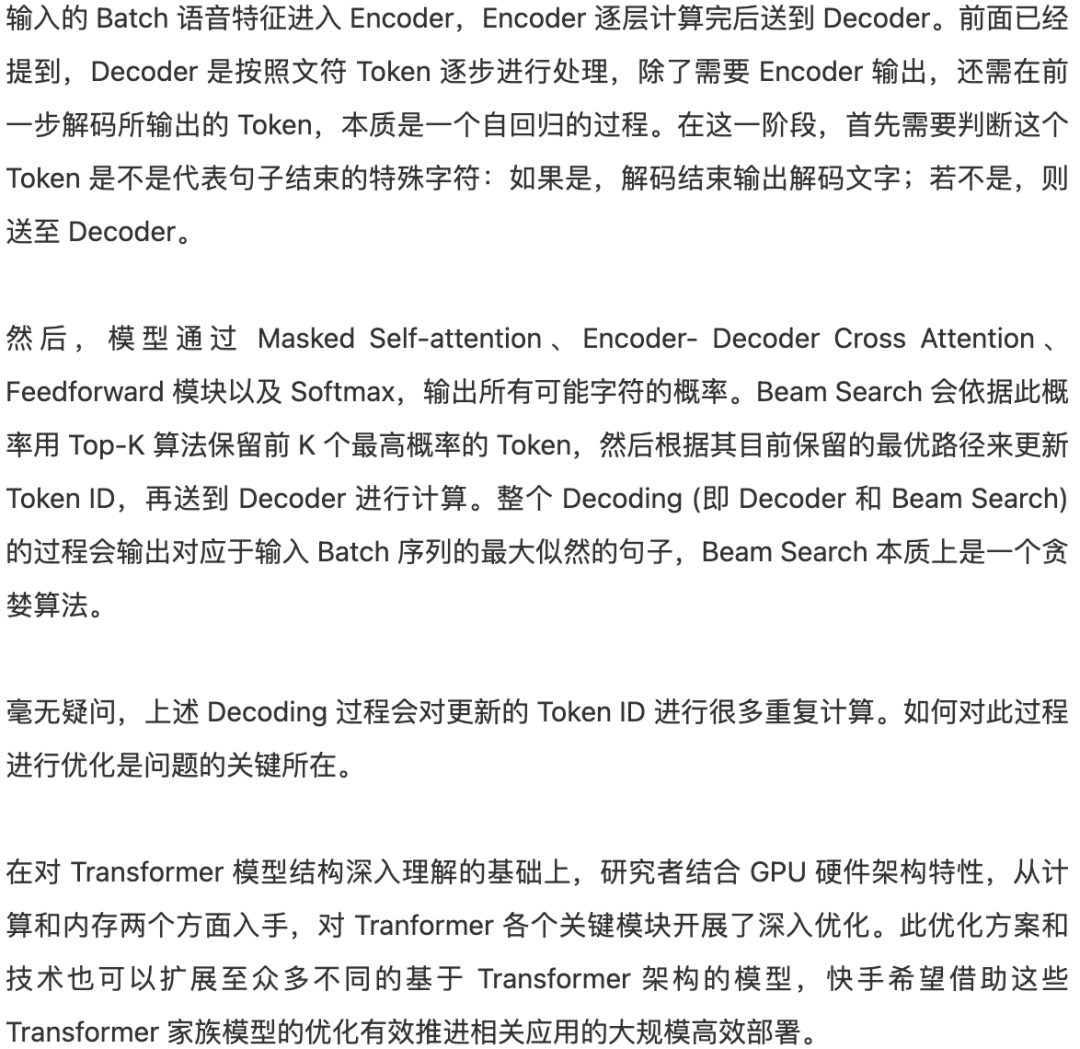

Transformer 对计算和存储的高要求阻碍了其在 GPU 上的大规模部署。文章中,来自快手异构计算团队的研究者分享了如何在 GPU 上实现基于 Transformer 架构的 AI 模型的极限加速,介绍了算子融合重构、混合精度量化、先进内存管理、Input Padding 移除以及 GEMM 配置等优化方法。

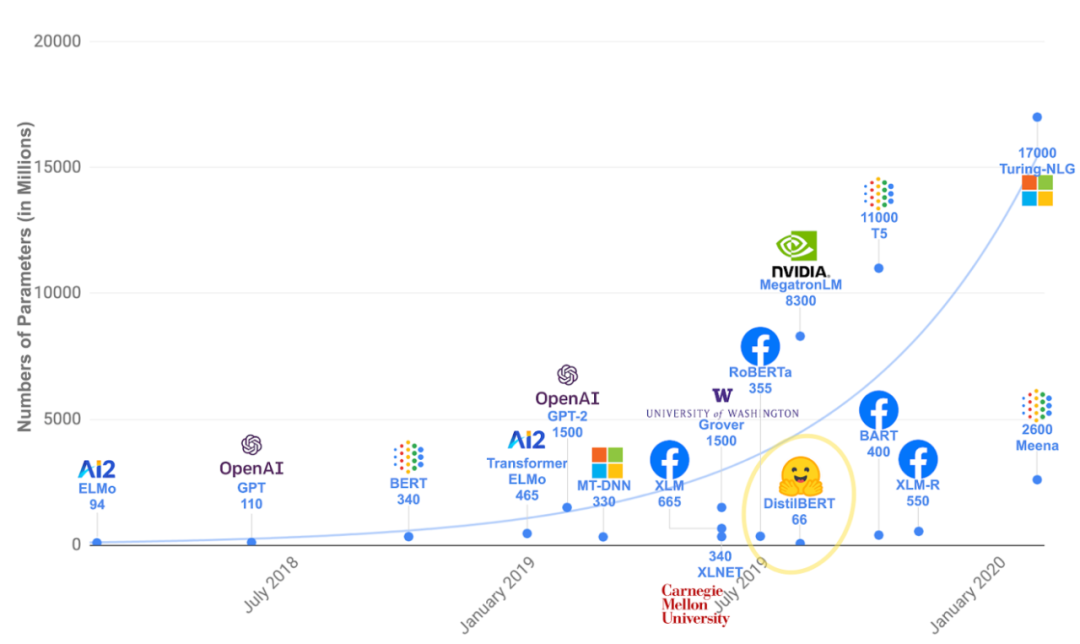

图 1:基于 Transformer 架构的 NLP 模型规模

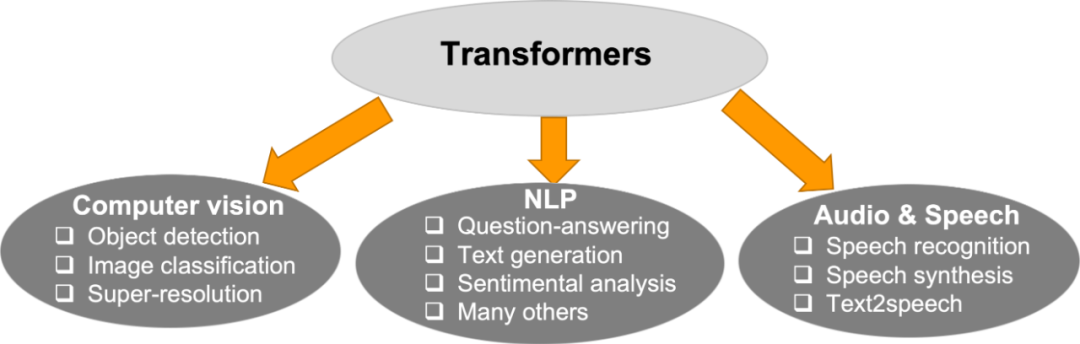

图 2:基于 Transformer 架构的应用

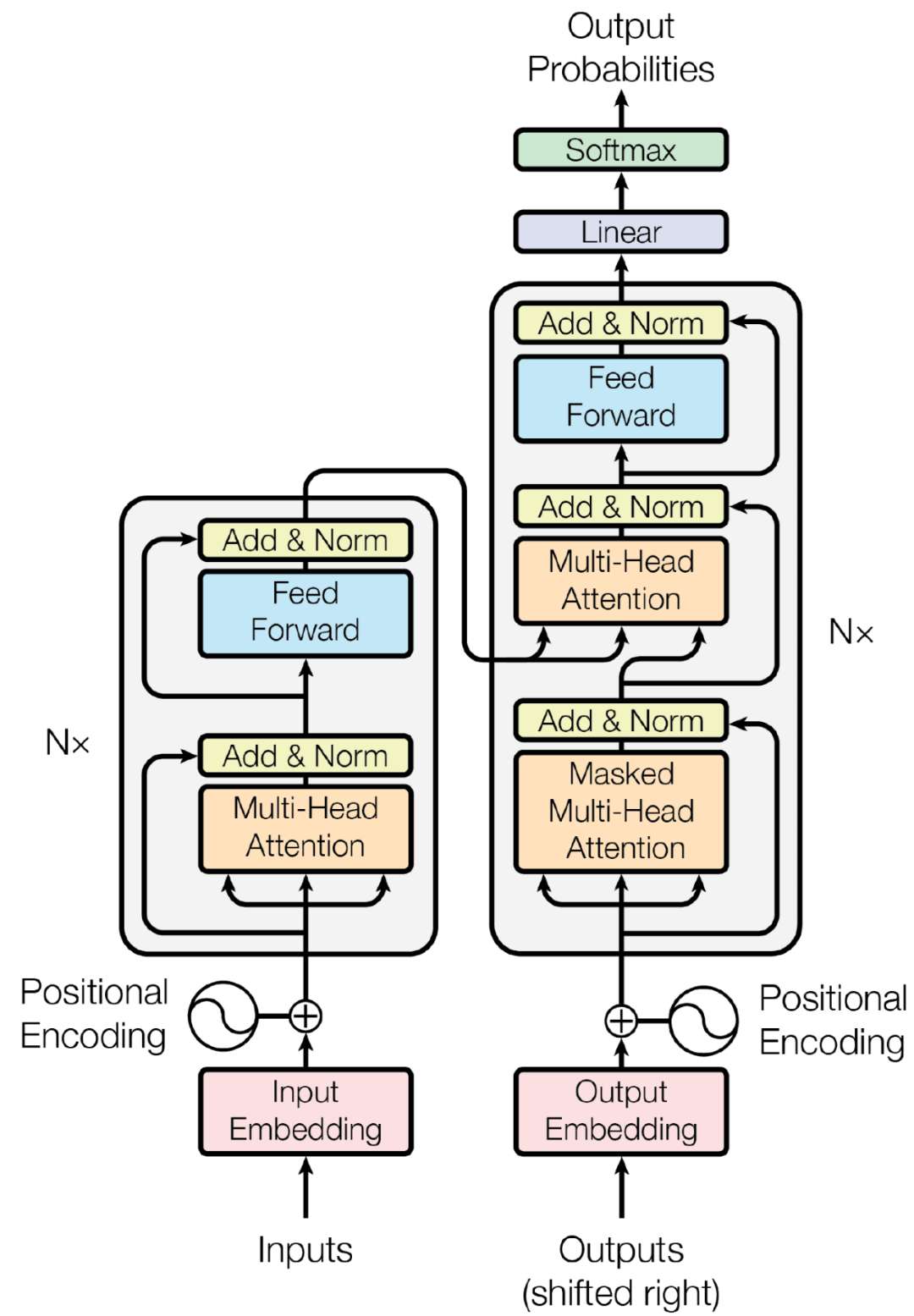

图 3:Transformer 模型的架构

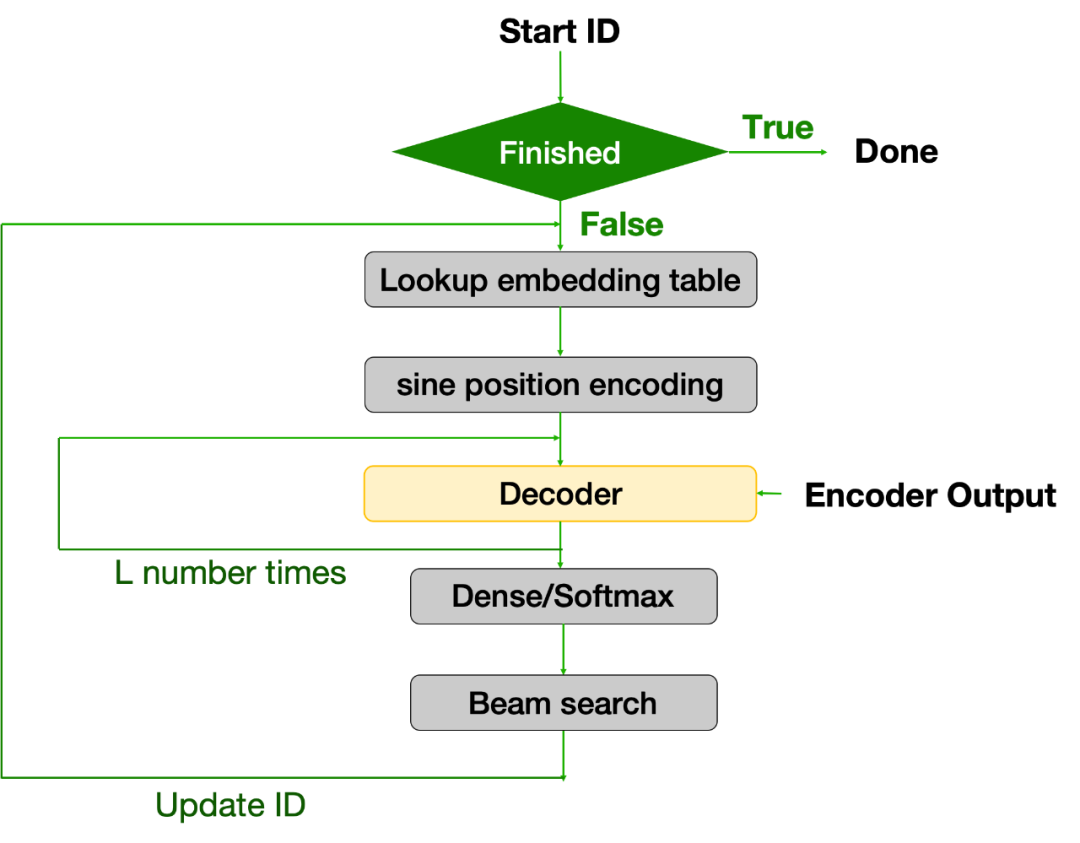

图 4:Beam Search Decoding (Decoder + Beam Search) 流程图

Transformer 家族模型

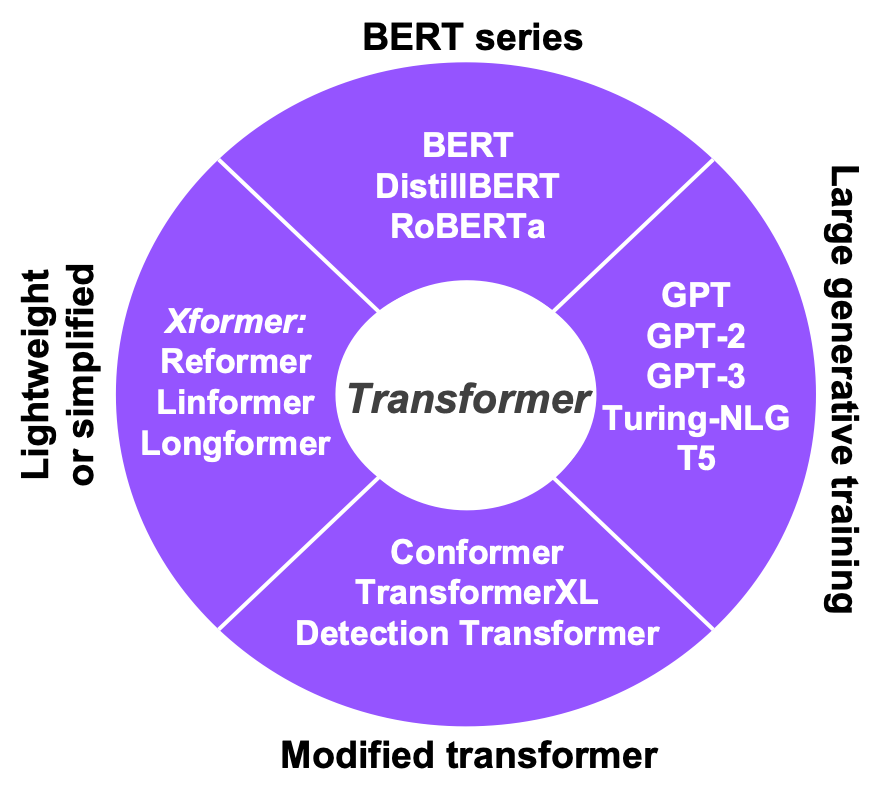

根据具体模型架构和应用的不同,研究者将 Transformer 家族的模型分为四大类(如图 5):

图 5:经典的基于 Transformer 结构的 AI 模型

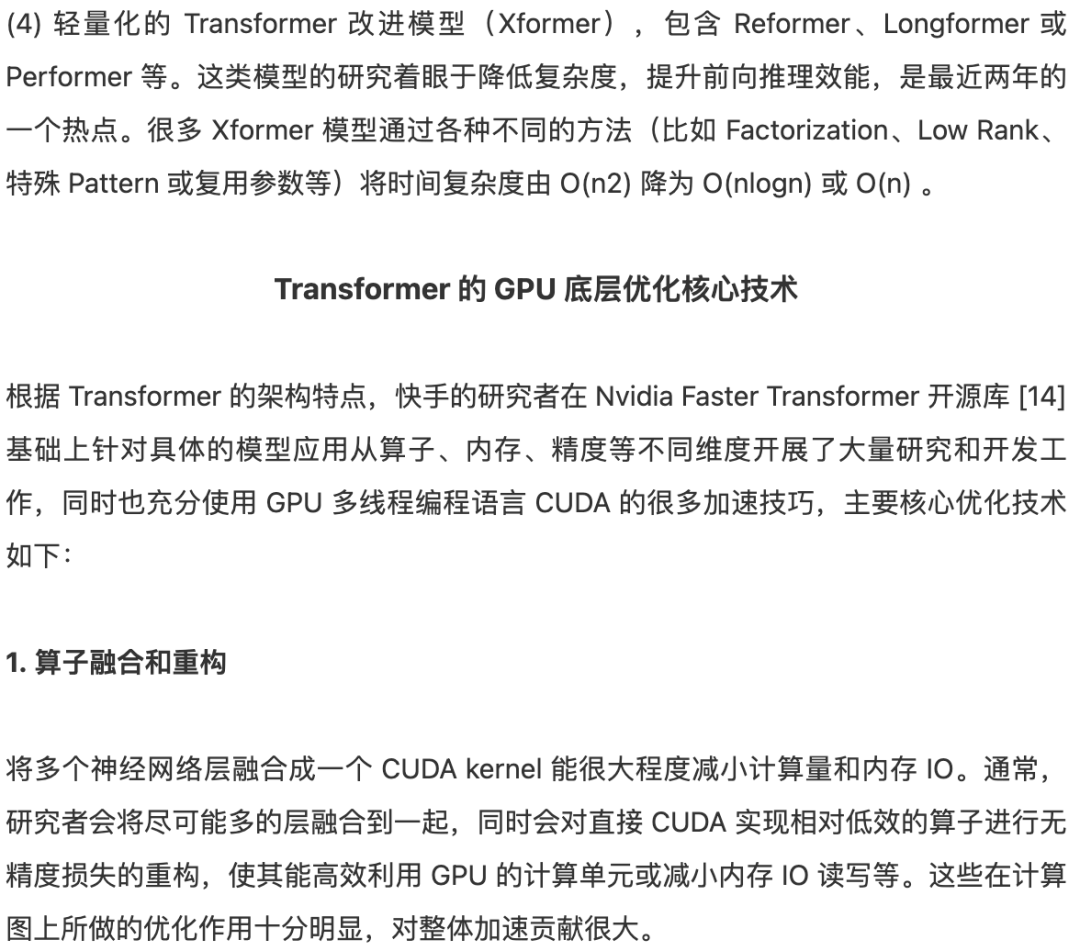

图 6:Transformer 架构中 Self-attention 和 Feedforward 模块的 CUDA kernel 融合和重构,参见[14]

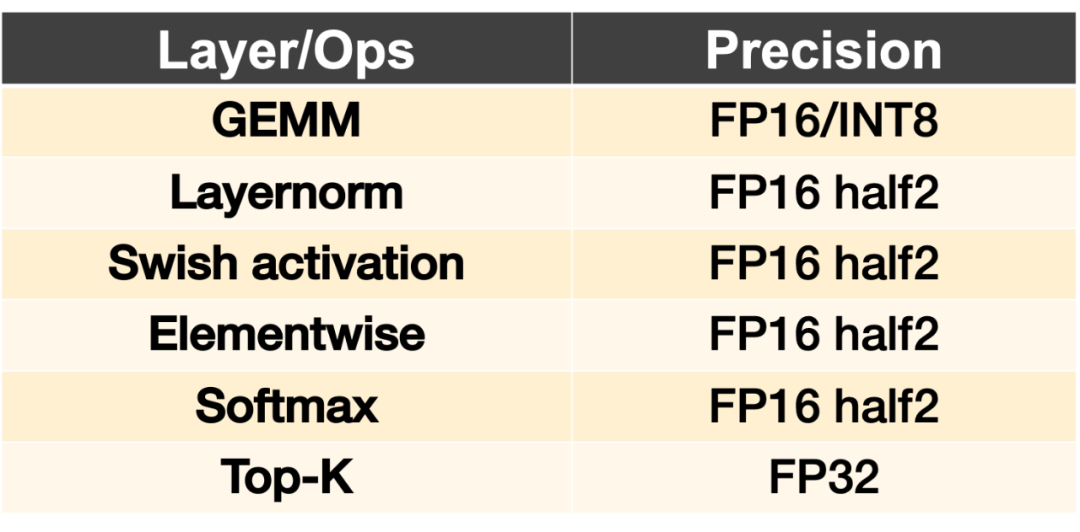

图 7:Transformer FP16 版本的几个关键 CUDA kernel 采用的量化精度

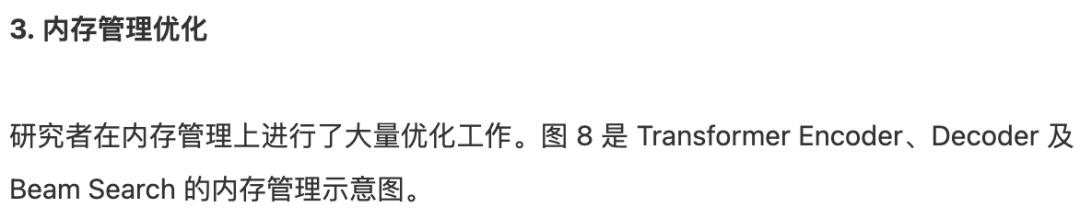

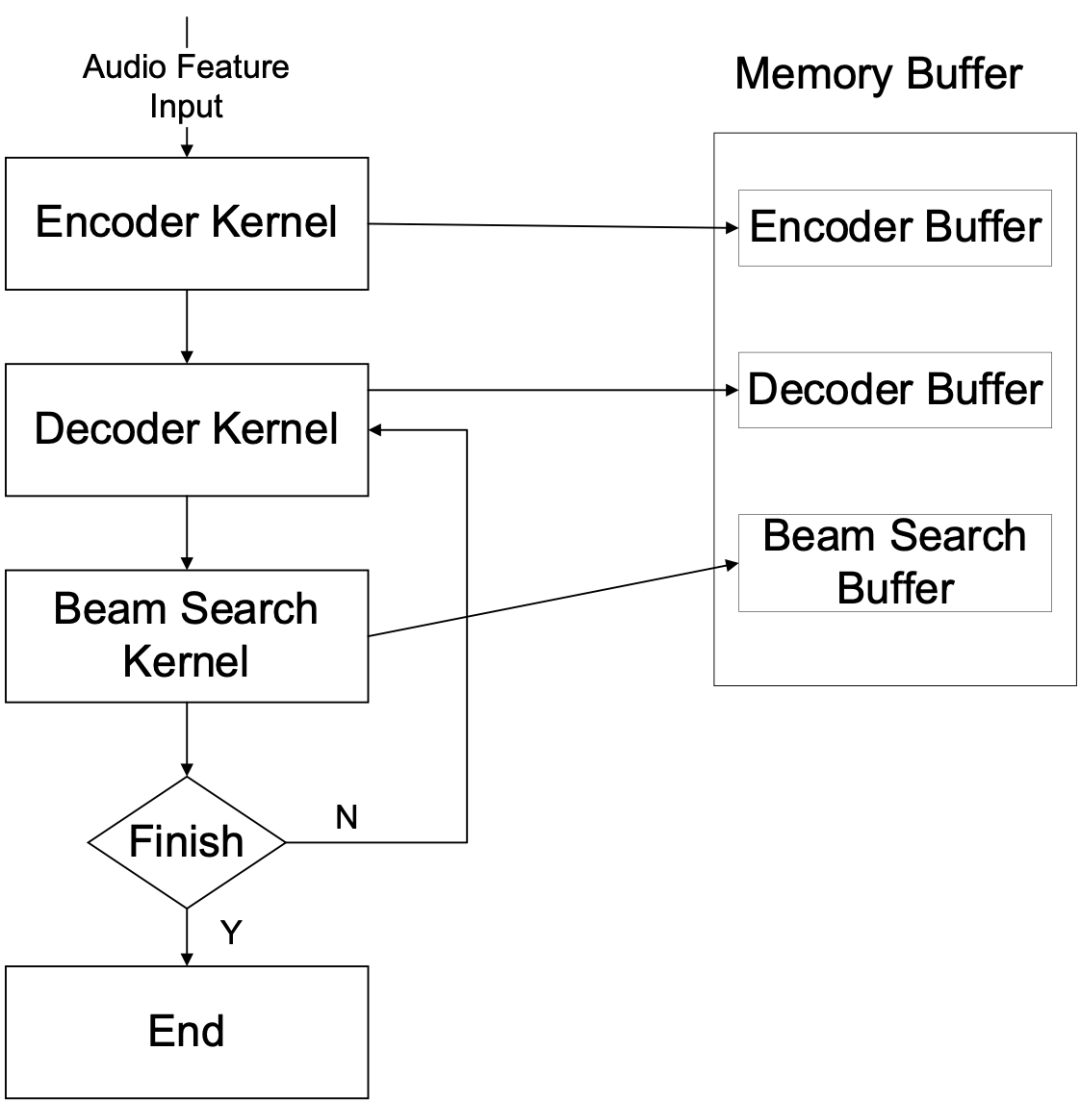

图 8:Transformer CUDA 实现的内存管理

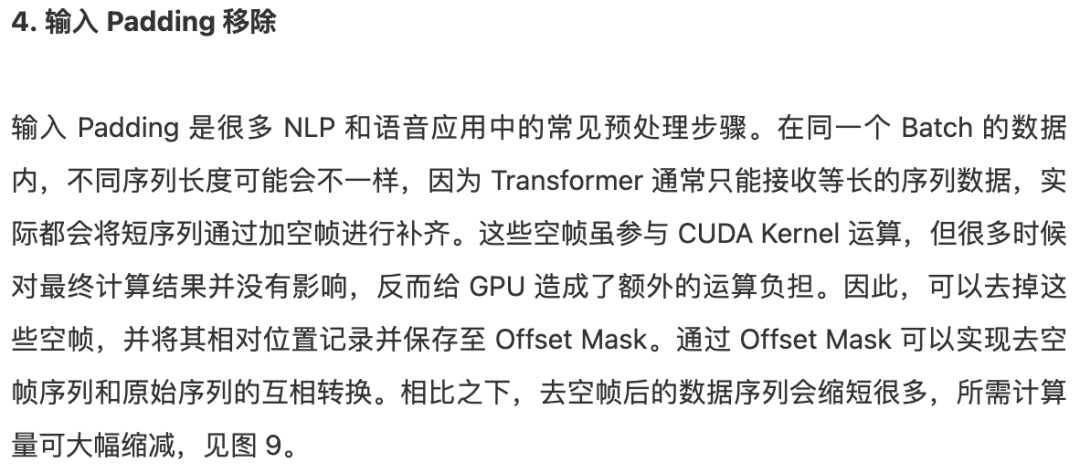

图 9:输入 Padding 移除的方案 - 通过引入 Offset Mask,移除 Padding 的 Sequence 和原始的 Sequence 可以互相转换重建

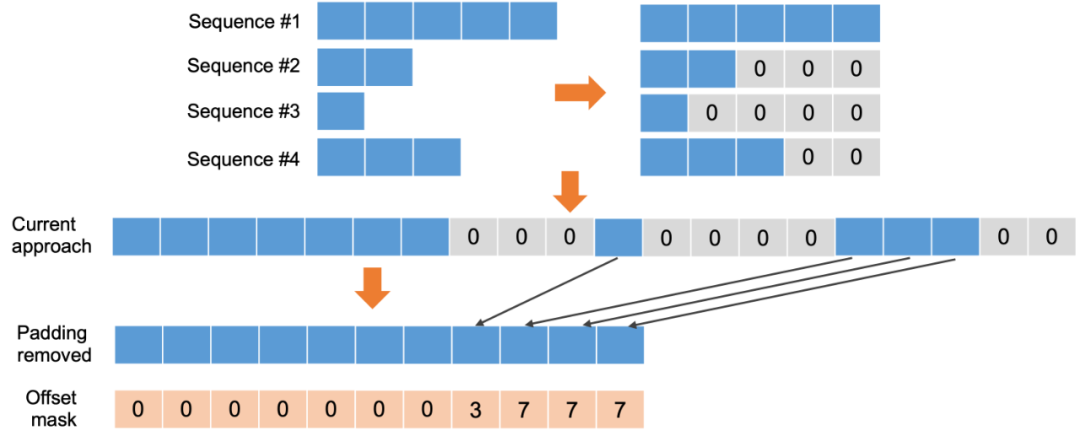

图 10:通过对 CUDA Kernel 的分类判断是否可以移除 Padding

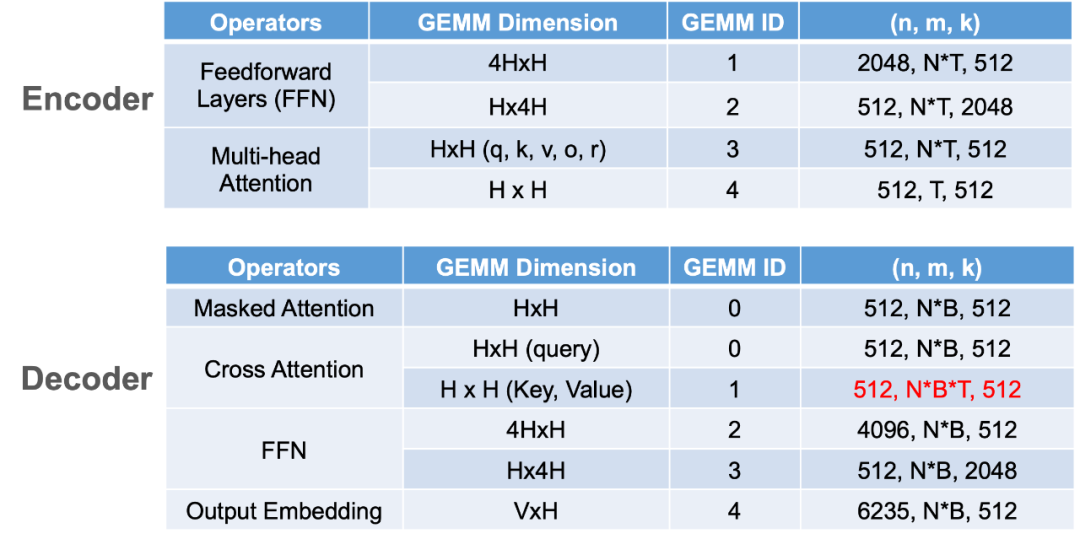

图 11:Transformer GEMM 配置的优化

总结

参考文献

[1] M. Luong et al, Effective Approaches to Attention-based Neural Machine Translation, arXiv:1508.04025v5 (2015).

[2] A. Vaswani et al. Attention is all you need, Advances in neural information processing systems (2017).

[3] J. Devlin et al. Bert: Pre-training of deep bidirectional transformers for language understanding, arXiv:1810.04805 (2018).

[4] A. Radford et al. Language Models are Unsupervised Multitask Learners, 2019.

[5] https://www.microsoft.com/en-us/research/blog/turing-nlg-a-17-billion-parameter-language-model-by-microsoft/

[6] C. Raffe et al. Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer, arXiv:1910.10683v3 (2019).

[7] T. Brown et al, Language Models are Few-Shot Learners, arXiv: 2005.14165v4 (2020).

[8] N. Carion et al, End-to-End Object Detection with Transformers, arXiv: 2005.12872 (2020).

[9] M. Chen et al, Generative Pretraining from Pixels, ICML (2020).

[10] F. Yang et al, Learning Texture Transformer Network for Image Super-Resolution, CVPR (2020).

[11] D. Zhang et al, Feature Pyramid Transformer, ECCV (2020).

[12] Y. Zhao et al, The SpeechTransformer for Large-scale Mandarin Chinese Speech Recognition. ICASSP 2019.

[13] A. Gulati et al, Conformer: Convolution-augmented Transformer for Speech Recognition, arXiv:2005.08100v1 (2020).

[14] https://github.com/NVIDIA/DeepLearningExamples/tree/master/FasterTransformer

- 下载1:OpenCV-Contrib扩展模块中文版教程

-

- 在「小白学视觉」公众号后台回复:扩展模块中文教程,即可下载全网第一份OpenCV扩展模块教程中文版,涵盖扩展模块安装、SFM算法、立体视觉、目标跟踪、生物视觉、超分辨率处理等二十多章内容。

-

-

- 下载2:Python视觉实战项目52讲

- 在「小白学视觉」公众号后台回复:Python视觉实战项目,即可下载包括图像分割、口罩检测、车道线检测、车辆计数、添加眼线、车牌识别、字符识别、情绪检测、文本内容提取、面部识别等31个视觉实战项目,助力快速学校计算机视觉。

-

-

- 下载3:OpenCV实战项目20讲

- 在「小白学视觉」公众号后台回复:OpenCV实战项目20讲,即可下载含有20个基于OpenCV实现20个实战项目,实现OpenCV学习进阶。

-

-

- 交流群

-

- 欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~