- 1kibana 更新 索引模式_Kibana对索引动态加字段显示

- 2Python实现经典小游戏贪食蛇-趣玩Python系列三_phtony编小游戏

- 3一文理清排序算法中的直接插入、快排和希尔排序的区别_插入排序和快速排序的区别

- 4Yakit靶场通关教程|SQL注入篇(一)_yakit 靶场

- 5大数据集群搭建总结_大数据集群搭建报告

- 6day54--面试专题(基础篇)

- 72023年上半年软考高级信息系统项目管理师下午《案例分析》真题答案及解析_案例分析 高级信息系统

- 8vs 2022 打开qt ui文件闪退_vs2022qt打开ui文件闪退

- 9Luma Dream Machine AI视频生成模型:根据文本和图像快速制作高质量、逼真的视频

- 10python网络编程_python中的socket模块socket类的定义

论文浅尝 | 基于知识库的自然语言理解 02#

赞

踩

本文转载自公众号:知识工场。

罗康琦,上海交通大学计算机系2019届博士,研究方向为自然语义理解和知识图谱。2012年获得华中科技大学软件工程学士学位,现就职于京东数据科学实验室(Data Science Lab)。他曾在AAAI,IJCAI,EMNLP等国际顶级会议上发表多篇论文。

本章研究的实体链接任务中,待链接文本为以源语言编写的互联网表格,而知识库则以目标语言编写,因此我们将其称为跨语言的表格实体链接。为了捕捉不同于传统实体链接任务的特性,我们提出了基于神经网络和跨语言词向量的表格链接模型,旨在让不同语言的连续特征空间得以兼容,并捕捉表格具有的多种粒度的匹配特征。

3.1 概述

海量的互联网文本信息中,充斥着以 HTML 编写的表格,即互联网表格[97,98]。和 纯文本相比,互联网表格中的行列形式携带了非常有价值的结构化信息。为了能让机器 理解,并且很好的处理表格中的信息,第一个步骤就是需要识别每个单元格中文本内容 所对应的实体,并映射到一个标准词库,或是知识库上,例如维基百科或 Freebase。这样的一个在互联网表格上进行实体链接的任务,在本章节被称为表格链接[57,99]。

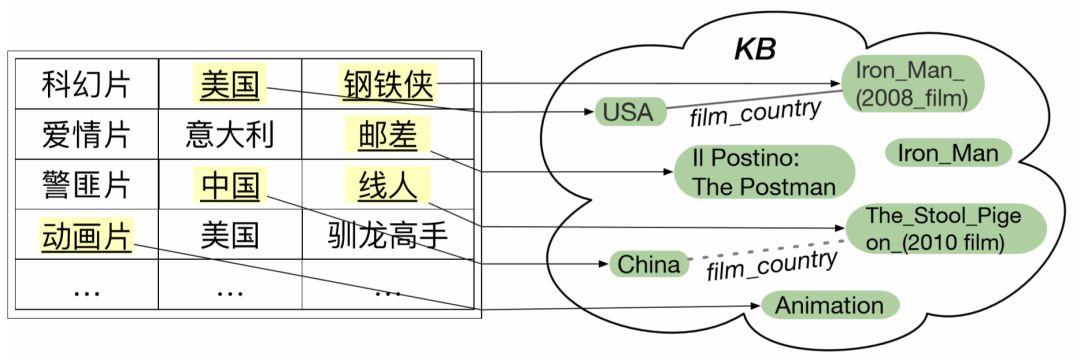

对于表格链接任务,已有的研究工作[51,57] 主要针对英文表格,由于使用知识库也为英文,表格链接是在单一语言场景中进行的。然而,当需要链接的表格以其它语言编 写的时候,对应语言的非英文知识库往往不够全面,无法涵盖目标表格中提及的所有实 体。例如中文版维基百科,其中包含的实体(页面)数量仅为英文维基百科的1/6左右。 基于不同语言知识库大小上的差异,本章探寻一种全新的方式将非英文表格与英文知识库相连,该任务也被称为跨语言表格链接。如图3–1所示,中文表格里的电影“邮差”在中文维基百科里没有对应的实体,但存在对应的英文维基实体“Il Postino: The Postman” ,因此可以建立跨语言的链接。

帮助目标知识库补充事实三元组,是我们尝试跨语言表格链接的另一个动机。英文知识库比其它语言知识库更加庞大,也更加结构化,但仍然包含许多长尾实体。这些实体仅出现知识库的极少数事实三元组中,例如别国的电影、名人等,考虑到英文知识库的贡献者更多以英语为母语,这些实体的相关信息就很容易被忽略。另一方 面,海量非英文的互联网表格成为了与长尾实体相关的丰富的语义信息来源。例如, 图3–1描述了电影与它的原产国之间的关系。国产电影 “线人” 有对应的英文维基页 面 “The_Stool_Piegon_(2010_film)” , 但与之相应的 Freebase 实体却缺少许多相关的知识。若我们准确将该电影链接至维基百科,并根据表格前两列的多个实体对推理出关系 film_country,那么就可为知识库补充新的事实。

图3–1 中文表格到英文知识库的跨语言链接示例。

图3–1 中文表格到英文知识库的跨语言链接示例。

具体论述我们提出的跨语言表格链接方法之前,首先来讨论两种朴素的做法。第一种方式主要基于已有单一语言的表格链接技术,将表格映射到语言一致的非英文知识库,然后再利用知识库之间存在的跨语言链接,将实体翻译至英文知识库。例如不同语言的维基百科之间就存在着人工编辑好的跨语言链接。这种方式的主要问题在于:1)非英文知识库的信息量较低,可能无法覆盖每一个单元格的实体;2)并不是每个非英文知识库都会存在和跨语言链接。

第二种做法中,整个非英文表格的内容首先直接被翻译成英文,然后整个问题便退化成英文上的表格链接,以往方法可以直接套用。它与远距离监督模型很相似,各单元格的(非英文名称,英文实体)对并不直接作为训练数据。此法的缺陷在于对已有翻译工 具准确率的高度依赖:一方面,文本翻译过程仅生成单一结果,一旦错误则对后续链接步骤影响很大;另一方面,翻译工具如同黑盒,无法根据训练数据进行优化。

在本章中,为了使研究具有普适性,我们忽略不同语言知识库之间的跨语言链接, 尝试在不使用任何非英文知识库进行过渡的情况下,解决跨语言的表格链接任务。据我们所知,本章节提出的解决方案,是对跨语言表格链接的第一次尝试。

对于实体链接任务而言,无论是否跨语言,第一个步骤总是为每个单元格生成一组候选实体,之后整个任务转换为排序问题,对每单元格寻找与其描述最接近的候选实体。主要的技术挑战在于表格描述和知识库来自不同的语言,无法依靠任何字面上的相似特征。此外,表格中缺少纯文本里的谓语、状语等相关上下文,给单个实体的消歧义带来了困难。

为了解决上述的两个挑战,我们提出了基于神经网络的联合模型来解决跨语言表格链接问题,它具有以下三个特点。首先,模型主体基于跨语言词向量,我们将单元格的描述短语、上下文、以及知识库的实体映射到不同语言对应的连续向量空间作为语义特征表示,并且使用线性变换的方式,实现不同语言的向量空间统一。其次,模型充分利用表格中同一行列的实体所具有的相关性,并通过神经网络学习不同粒度的相关性特征。最后,模型基于联合训练思路,以优化整张表格的匹配程度作为目标函数,使用成对排序损失函数进行参数学习以及多轮迭代的预测方式,对新的表格完成链接。

本章的贡献可以总结为以下四个部分:

1.我们首次尝试在跨语言场景上进行表格链接;

2. 我们提出了一个基于神经网络的联合训练模型,能有效捕捉原始表格与候选链接表格的语义相关性,并消除不同语言之间的语义间隔;

3. 联合模型除了捕捉单个单元格描述与候选实体间的语义关联特征,还提出了一 种一致性特征,用于捕捉候选链接表格内部不同实体间的联系,有效提升模型的预测准确率;

4. 我们构建了从中文到英文的跨语言表格链接数据集用于实验,本章提出的模型效果显著优于其它基线模型,同时我们进行了一系列分析实验,以验证模型各部分的有效性。

3.2 相关工作

对互联网表格的研究最早开始于 Cafarella 等人的工作[97],文中指出大约有 1.54 亿表格可以作为高质量的关系数据源。例如文献 [100,101] 关注于从表格中寻找不同列之间的关系,从而实现向知识库中补充新的三元组。这些工作都假定实体链接已完成,而若要对更广范围的表格数据进行关系挖掘,表格链接始终是其前置步骤,链接准度直接决定了后续步骤的质量。

和纯文本上的实体链接任务不同,表格文本上的链接聚焦于表格中的每一个单元格,并且对于任何一个待链接的单元格,其它同行或同列的单元格与其有着更加密切的语义联系。目前已有的表格链接研究主要基于特征工程。Limaye 等人[51]以 YAGO 为知识库,解决更加宽泛的表格链接任务,包括将单元格链接至实体、列头链接至类型,以 及两列之间的关系链接至谓词,同时创建了 WebManual 数据集。作者提出了一个概率图模型用于同时完成不同的链接子任务,并通过人为定义的多种势函数表示单元格、实体、类型、谓词语间的组合特征,整个表格链接的目标函数为多种势函数的连乘,不同子任务的决策互相影响,使得模型在捕捉单个单元格与实体相匹配的同时,也能兼顾实体与列头类型的一致性,以及不同列实体间与特定谓词的相关性。Bhagavatula 等人[57] 利用了表格上下文的词汇信息,对于待链接的单元格,将其行或列方向上的其它单元格文本合并形成上下文词袋,与候选实体所对应的词汇进行相似度计算,得到多个相似度特征用于模型训练,并采用迭代更新方式进行预测。Wu 等人[99]首次尝试对中文表格进行链接,提出的模型首先构建由单元格和所有候选实体组成的连通图,然后在图中进行类似 PageRank 算法[102]的随机游走,以选择最佳链接结果,因此是一种非监督学习方式。候选实体是否同行列决定了图中是否存在直接相连的边,而单元格与实体、实体与实体之间所连边的权重则由预定义的相似度公式计算,使用了编辑距离、词袋相似度、 实体于三元组中共现等特征。区别与以上研究,本文的工作基于深度学习,尝试不依赖常用的相似度计算公式,而是利用神经网络挖掘表格和目标实体在多个粒度上的特征。

跨语言的实体链接的主要目的是将文本中的实体短语链接至另一个语言构建的知识库上,近几年的 TAC-KBP 数据集[103-105]中包含了跨语言的实体链接任务。为了解决此类问题,McNamee 等人[106]提出了一种基线方法,利用已有的翻译工具将外文文本转换为英语,再使用传统的单语言链接模型完成任务。为了尽可能减少对翻译工具的高度依赖,模型需要能学习同一个实体或概念在不同语言下的抽象表达,并通过特定运算体现出不同抽象表达之间的联系,以完成语义的跨语言兼容。

基于跨语言词向量的链接模型是一种可行的解决方案,跨语言词向量的相关内容已在2.1.3节中介绍。Tsai 等人[107]首先分别训练英文和外文的词向量,再用典型相关分析( CCA )学习各自语言的转移矩阵,使得不同语言词向量位于同一连续空间,之后依据该词向量计算短语和实体在不同粒度上下文中的余弦相似度,形成多个特征进行训练。Sil 等人[108] 提出了更加复杂的深度学习模型,以学习短语上下文和实体在句子级别和单词级别的相似特征,同时在实验中比较了 CCA 、均方误差等多种生成跨语言词向量的方式。除了跨语言词向量以外,Zhang 等人提出的跨语言主题模型[109]也可用于描述不同语言上的相同语义。传统的 LDA 主题模型[110] 旨在描述文档的语义表示,通过对“文档 —主题” 与 “主题—单词” 间的概率进行建模,将一个文档表示为抽象主题上的概率分布。考虑到同一个实体在不同语言中的维基页面,虽然单词不同,但其主题十分相似, 因此双语 LDA 模型中,同一个抽象主题对应不同语言上的两个 “主题-单词” 概率分布, 从而外语上下文和英语维基页面之间可以在主题层面上概率分布比较,实现链接过程。

本文的工作是表格链接和跨语言实体链接两者的综合体现,同时也是首次对此问题进行研究。

3.3 任务规范定义

输入的互联网表格 是一个具有

是一个具有 行和

行和 列的矩阵,每一个单元格

列的矩阵,每一个单元格 的内容是由语言

的内容是由语言 (例如中文)描述的词语序列。给定由另一种语言

(例如中文)描述的词语序列。给定由另一种语言 (例如英文)编写,并包含大量实体

(例如英文)编写,并包含大量实体 的知识库

的知识库 ,跨语言表格链接的任务是寻找

,跨语言表格链接的任务是寻找 对应的目标链接表格

对应的目标链接表格 ,使得链接表格中的每一个实体

,使得链接表格中的每一个实体 对应单元格

对应单元格 内容的消歧义表示。

内容的消歧义表示。

在具体场景中,输入的表格包括一些无法被链接的单元格,例如数字、日期、时间以及一些知识库中尚不存在的新兴实体。一些已有工作[111] 主要负责在互联网表格中识别这些数字或时间实体,因此在本章中,我们不关注一个单元格是否能被链接的判断方式。具体到任务定义中,P 为输入表格中所有可以被链接的单元格坐标 所构成的集合,并且我们假设在训练集和测试集中,每个输入表格

所构成的集合,并且我们假设在训练集和测试集中,每个输入表格 对应的可链接位置集合 P 都是已知的。

对应的可链接位置集合 P 都是已知的。

传统的实体链接方法通常在模型中定义一个评分函数 ,用于衡量文本

,用于衡量文本  与目标实体

与目标实体 之间的相关程度。在表格链接任务中,这样的做法等同于将不同的单元格分割开,单独计算相似度。然而缺陷在于,相邻或是同行列的目标实体之间的交互完全无法体现在链接模型中。为了将目标链接表格中不同实体间的耦合关系融入任务中,我们定义了在表格层面的评分函数,并以此预测最佳的链接表格

之间的相关程度。在表格链接任务中,这样的做法等同于将不同的单元格分割开,单独计算相似度。然而缺陷在于,相邻或是同行列的目标实体之间的交互完全无法体现在链接模型中。为了将目标链接表格中不同实体间的耦合关系融入任务中,我们定义了在表格层面的评分函数,并以此预测最佳的链接表格 ,如下所示:

,如下所示:

(3-1)

其中 表示由

表示由 生成的所有候选链接表格。该函数描述了输入表格与候选实体表格之间的整体相关性分数。

生成的所有候选链接表格。该函数描述了输入表格与候选实体表格之间的整体相关性分数。

3.4 我们的方法

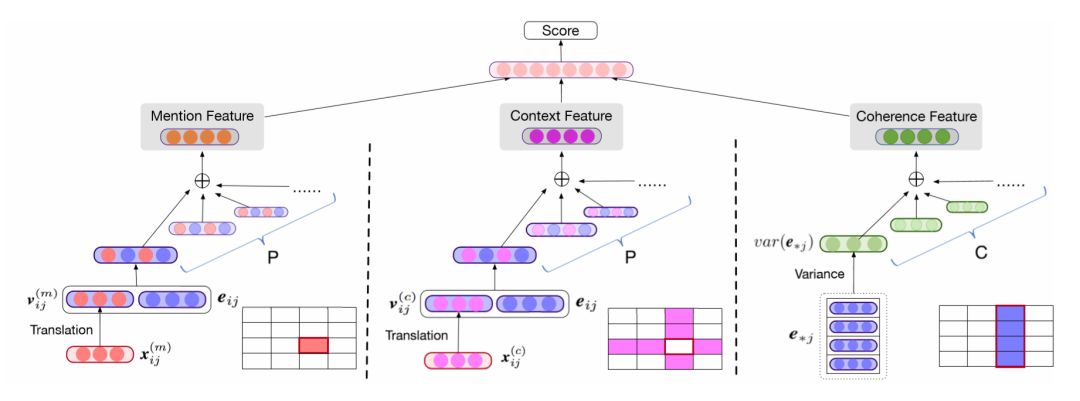

本节中,我们主要阐述使用联合训练模型解决跨语言表格链接的具体细节。图3–2为整个模型的示意图。之所以将整个模型成为 “联合训练模型” ,是因为神经网络的输入包含了整个互联网表格 ,以及对应的一个候选链接表格

,以及对应的一个候选链接表格 ,而模型的输出代表两者的相关性分数

,而模型的输出代表两者的相关性分数 。

。

图3–2 基于神经网络的联合训练模型示意图。

具体而言:1) 我们首先对表格中的每一个单元格内容生成一系列知识库中的候选实体;2)模型对单元格词组和实体进行向量编码,并学习基于它们向量表示的指示特征以及上下文特征;3)为了使不同语言下的语义向量互相兼容,模型利用双语翻译矩阵将向量表示从中文转为英文;4) 模型从候选表格 的内部学习第三类特征,即候选实体间的一致性特征。本节最后将介绍训练和测试的具体流程,以及整个模型中重要的一些实现细节。

的内部学习第三类特征,即候选实体间的一致性特征。本节最后将介绍训练和测试的具体流程,以及整个模型中重要的一些实现细节。

3.4.1 候选实体生成

我们对中文表格 的每一个单元格内容生成一系列英文知识库中的候选实体。在本章的研究中,我们使用英文维基百科作为知识库。由于提出的方法不使用任何中文知识库进行过渡,为了实现语言转换,我们首先利用已有的翻译工具生成中文词组对应的多种翻译结果。接下来,对于每一个翻译结果,我们都使用预先定义的启发式规则,将英文词组转换为候选实体。这些实体的来源主要包括:1) 名称与翻译完全匹配的实体; 2)维基百科中,完全匹配的锚文本所指向的实体;3)通过计算编辑距离( Edit Distance ) 进行模糊匹配,并且相似度足够高的实体。以中文词组 “疑犯追踪” 举例,不同的翻译工具生成的结果不同,例如 “ person of interest ” 或者 “ suspect tracking ” 。整体候选实体来自于每一个翻译结果的映射,例如维基百科中的实体 “ person of interest ” ,“ person of interest (tv series) ”以及“ suspect (1987 film) ”。

的每一个单元格内容生成一系列英文知识库中的候选实体。在本章的研究中,我们使用英文维基百科作为知识库。由于提出的方法不使用任何中文知识库进行过渡,为了实现语言转换,我们首先利用已有的翻译工具生成中文词组对应的多种翻译结果。接下来,对于每一个翻译结果,我们都使用预先定义的启发式规则,将英文词组转换为候选实体。这些实体的来源主要包括:1) 名称与翻译完全匹配的实体; 2)维基百科中,完全匹配的锚文本所指向的实体;3)通过计算编辑距离( Edit Distance ) 进行模糊匹配,并且相似度足够高的实体。以中文词组 “疑犯追踪” 举例,不同的翻译工具生成的结果不同,例如 “ person of interest ” 或者 “ suspect tracking ” 。整体候选实体来自于每一个翻译结果的映射,例如维基百科中的实体 “ person of interest ” ,“ person of interest (tv series) ”以及“ suspect (1987 film) ”。

3.4.2 向量表示及跨语言模块

给定一个单元格的字面描述短语 ,令

,令 代表其自身的语义向量,也称为指示向量。通常单元格字面描述较短(至多三个词语),因此模型计算字面描述包含的词向量的平均,作为

代表其自身的语义向量,也称为指示向量。通常单元格字面描述较短(至多三个词语),因此模型计算字面描述包含的词向量的平均,作为 的值。用

的值。用 表示候选实体

表示候选实体 对应的实体向量,词向量和实体向量分别通过中文和英文的维基百科文本进行预训练。

对应的实体向量,词向量和实体向量分别通过中文和英文的维基百科文本进行预训练。

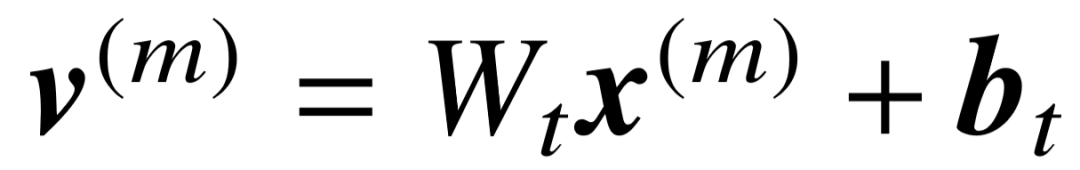

考虑到语言的天生差异,且两者分别训练,因此词向量和实体向量所在维度空间并不兼容,这使得我们无法简单地对来自不同空间的向量进行比较和计算。为了应对这个问题,模型中引入了双语翻译层,将向量从一个语言的维度空间投影至另一个空间。  为中文语义空间上对

为中文语义空间上对 的语义表示,该层通过线性变换将其映射为

的语义表示,该层通过线性变换将其映射为 ,即英文维度空间上的语义向量:

,即英文维度空间上的语义向量: 。其中

。其中 为变换矩阵,

为变换矩阵, 为偏置向量,两者均为模型参数,随着训练迭代而更新。

为偏置向量,两者均为模型参数,随着训练迭代而更新。

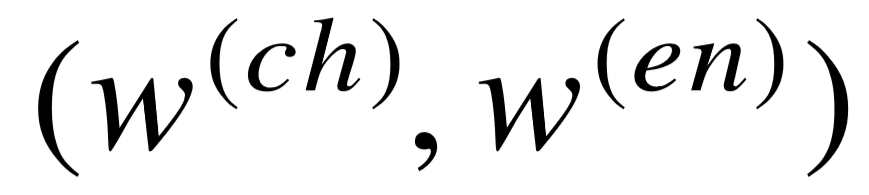

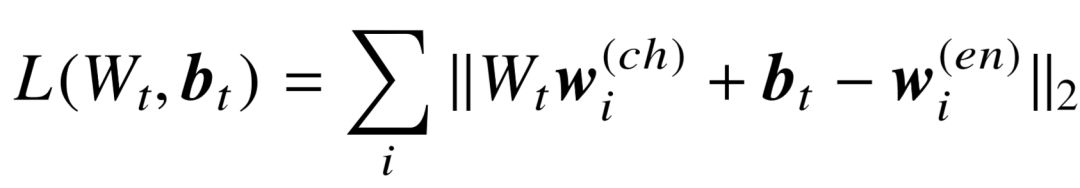

另外,我们通过少量的双语词对 ,对双语翻译层的参数

,对双语翻译层的参数  ,

, 进行预训练。预训练过程的损失函数定义如下:

进行预训练。预训练过程的损失函数定义如下:

(3-2)

即最小化真实的英文词向量与线性变换后的词向量之间的欧氏距离。关于初始化,以及翻译预训练的更多细节,将在3.4.6节中进行叙述。

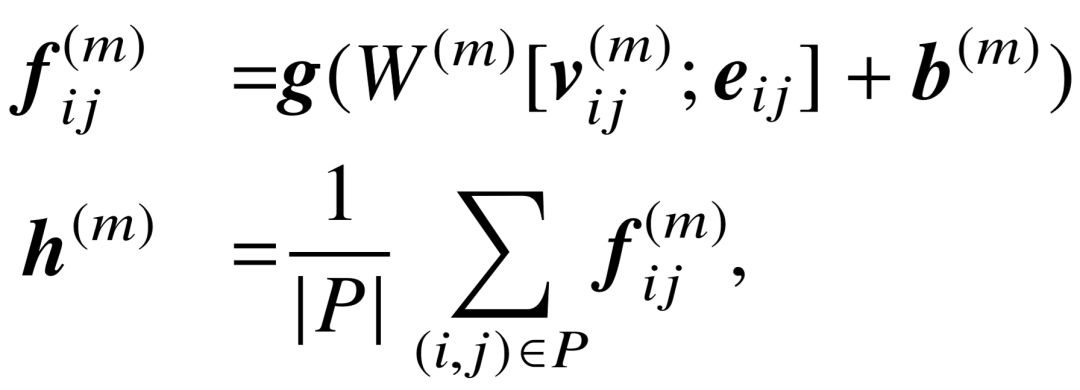

3.4.3 指示特征与上下文特征

如图3–2所示,最左边的部分对应指示特征模块,中间的部分对应上下文特征模块。 两者的共同点在于,它们都关注互联网表格 与候选链接表格

与候选链接表格  之间的相似性或相关性,并且每个单元格各自计算的特征会聚合为一体。因此这两部分具有很相似的网络结构。

之间的相似性或相关性,并且每个单元格各自计算的特征会聚合为一体。因此这两部分具有很相似的网络结构。

首先介绍指示特征,它捕捉一个单元格自身描述与目标实体的对应。给定字面描述 ,我们将英文的指示向量

,我们将英文的指示向量 与实体向量

与实体向量 进行拼接,并送入全连接层,生成单元格在自身指示级别的隐含特征。收集所有需要被链接的单元格的指示特征,并对其求平均,即可得到整张表格上的总体指示特征

进行拼接,并送入全连接层,生成单元格在自身指示级别的隐含特征。收集所有需要被链接的单元格的指示特征,并对其求平均,即可得到整张表格上的总体指示特征 。具体公式如下:

。具体公式如下:

(3-3)

其中 以及

以及 为模型参数,

为模型参数, 为非线性激活函数,实验中使用

为非线性激活函数,实验中使用 函数。

函数。

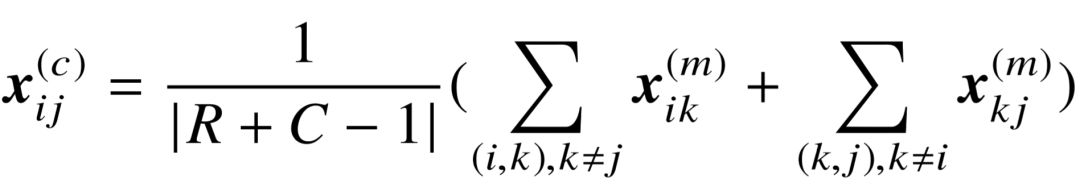

上下文特征的获取与指示特征类似。区别于指示特征的信息仅来自目标单元格,上下文特征还将考虑此单元格周围的有用信息。而在表格之中,位于同一行或同一列的其余单元格则具有直接的关联,因此成为上下文特征的信息来源。我们定义一个单元格的上下文向量 为这些相关单元格指示向量的平均:

为这些相关单元格指示向量的平均:

(3-4)

同样经过双语翻译层的转换,英文空间中每个单元格的上下文向量 将用于生成整个 表格的总体上下文特征,记做

将用于生成整个 表格的总体上下文特征,记做 。具体计算过程类似公式3–3,只需要把所有指示向量改为上下文向量作为输入即可。通过观察表格中的每个<字面描述,候选实体>对,并进行指示特征和上下文特征的学习,模型可以从两张表中捕捉大体上的语义相关程度。

。具体计算过程类似公式3–3,只需要把所有指示向量改为上下文向量作为输入即可。通过观察表格中的每个<字面描述,候选实体>对,并进行指示特征和上下文特征的学习,模型可以从两张表中捕捉大体上的语义相关程度。

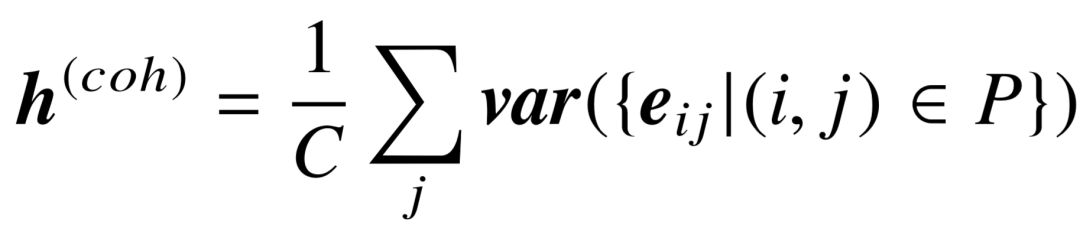

3.4.4 一致性特征

前面叙述的两类特征都是对互联网表格与链接表格之间的契合度进行编码,另一方面,链接表格内部,不同实体之间的关系同样具有价值。之所以有这样的理解,是因为表格中同一列(有时同一行)的实体大多都属于同一种类型,也就是说,往往拥有更加相似的向量表达。例如概述部分的图3–1,表格中从左到右三列,对应的链接实体分别属于电影流派、国家、电影。我们提出的第三种特征,正是用来描述同一列候选实体之 间的契合度。

关于同一类型的实体在表格中是按哪种方向进行排列,这涉及到另一个研究课题名为“表格类型分类”[112,113],主要用于区分表格的多种表现形式。本章中默认表格的形式为“垂直关系型”[113],即和图3–1一样,相同类型实体按列方向排布。考虑到确定表格类型之后,大多数互联网表格都可以实现简单的格式转换,因此这个课题不在我们的讨论范围。

一致性特征的网络结构见图3–2的最右侧部分,为了衡量一列实体向量是否接近,我们对这些向量进行逐位的方差计算,方差越小,表明这些实体在对应位置的隐含语义上差别越小,反之亦然。同样对每一列的方差向量进行求平均的操作,我们便得到整个候选实体表格上的一致性特征 :

:

(3-5)

其中 函数以向量集合作为输入,返回同样维度的逐位方差向量。一致性特征用于描述候选实体互相之间是否有良好的自我组织性,由于和字面描述表格

函数以向量集合作为输入,返回同样维度的逐位方差向量。一致性特征用于描述候选实体互相之间是否有良好的自我组织性,由于和字面描述表格 无关联,该特征可以看做对指示特征与上下文特征的补充。

无关联,该特征可以看做对指示特征与上下文特征的补充。

3.4.5 训练及测试

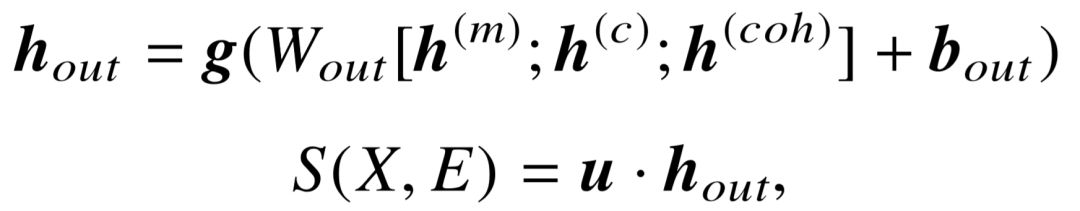

我们首先定义输入表格 与候选链接表格

与候选链接表格 之间的整体相关性分数。前面提及的指示、上下文、一致性特征将被拼接,并送至一个两层的全连接网络得到总体特征

之间的整体相关性分数。前面提及的指示、上下文、一致性特征将被拼接,并送至一个两层的全连接网络得到总体特征 ,第二层的输出维度为1,即表示最终的表格相关度:

,第二层的输出维度为1,即表示最终的表格相关度:

(3-6)

其中 ,

, 以及

以及 均为模型参数。

均为模型参数。

训练集中的每一个互联网表格,都对应唯一一张正确的链接表格作为正样本。为了进行训练,我们需要准备若干张链接表格作为负样本。通过对正样本表格中的实体进行不同程度的篡改,我们可以自动生成一系列负样本表格,具体步骤如下:先随机指定要被篡改的单元格数量,再随机确定这些单元格在表格中的位置,最后将这些单元格的链接实体替换为对应候选集中的一个随机错误实体。这样可以使得篡改后的错误实体不至于太容易被发现。

训练过程中可能使用的更新方式有两种:基于最大间隔损失( Max Margin Loss,即Hinge Loss),或者基于成对排序损失( Pairwise Ranking Loss )。对于前者,模型将最大化正样本表格与负样本表格间的分数差异。对于后者,单个正样本和多个负样本表格两两之间都会进行比较,具有更多正确链接实体的表格,要尽可能比另一张表格获得更高的相关度分值。本章提出的模型采用了 RankNet 算法[114]计算成对排序的损失函数,并使用 Adam 算法[115]进行梯度下降。

测试过程涉及到更多的细节。理想状态下,对于互联网表格 ,我们需要枚举每一 张链接表格

,我们需要枚举每一 张链接表格 ,才能得到全局最优解。然而,候选表格集的数量与单元格的数量呈指数相关,同时每一个单元格又能对应大量候选实体,因此暴力枚举显然是不现实的。

,才能得到全局最优解。然而,候选表格集的数量与单元格的数量呈指数相关,同时每一个单元格又能对应大量候选实体,因此暴力枚举显然是不现实的。

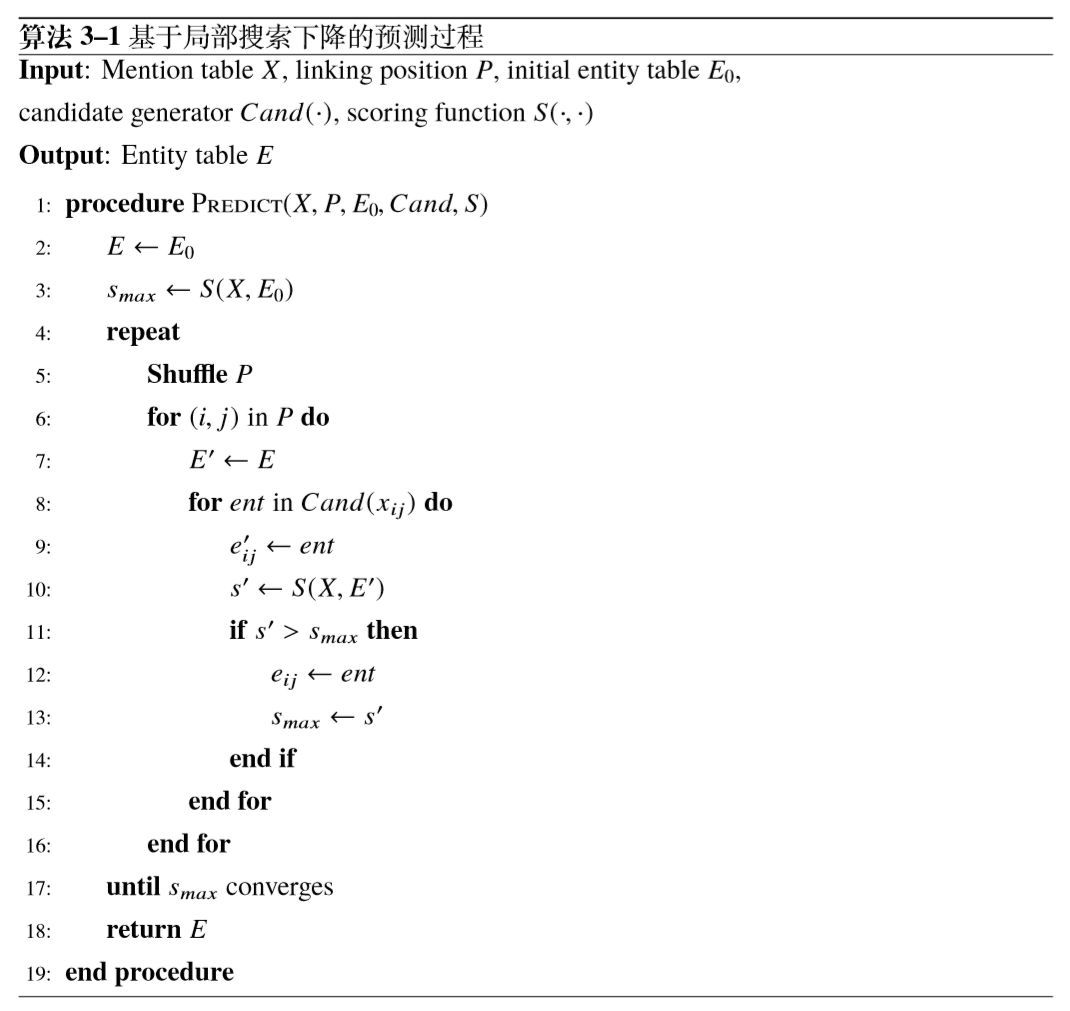

为此,我们使用局部搜索下降( Local-Search Descent )算法来逼近最优的链接表格。 如算法3–1所示, 为链接表格的迭代更新起点,每个单元格填充由生成器

为链接表格的迭代更新起点,每个单元格填充由生成器 产生的候选集中最可能的实体,S 为已学习的评分函数。预测步骤将以迭代形式进行。迭代的每一轮中,所有需要链接的单元格按照乱序进行一一访问 (第6行),对每一个被访 问的单元格,预测算法固定其余单元格的链接结果不变,从该单元格的候选实体中,选择达到局部最优相关性分值的实体,并更新输出表格的对应位置(第12行)。迭代过程将持续进行,直到某一轮结束之后,输出表格

产生的候选集中最可能的实体,S 为已学习的评分函数。预测步骤将以迭代形式进行。迭代的每一轮中,所有需要链接的单元格按照乱序进行一一访问 (第6行),对每一个被访 问的单元格,预测算法固定其余单元格的链接结果不变,从该单元格的候选实体中,选择达到局部最优相关性分值的实体,并更新输出表格的对应位置(第12行)。迭代过程将持续进行,直到某一轮结束之后,输出表格 的相关性分数无法进一步提高。该算法可以类比为离散环境下的随机梯度下降,每个单元格的候选实体视为变量,输出表格的分值沿它们的离散梯度不断上升,打乱单元格的访问顺序则提供了随机扰动,防止预测过程陷入局部最优点。

的相关性分数无法进一步提高。该算法可以类比为离散环境下的随机梯度下降,每个单元格的候选实体视为变量,输出表格的分值沿它们的离散梯度不断上升,打乱单元格的访问顺序则提供了随机扰动,防止预测过程陷入局部最优点。

3.4.6 模型实现细节

模型的主要实现细节包括了候选生成过程,双语翻译层的预训练,以及调参细节,下面将分别对这几个部分进行介绍。

候选生成:我们使用百度翻译,谷歌翻译以及腾讯翻译的 API 用于候选生成。获取翻译结果之后,我们将英文字面描述与维基百科中的每一个实体进行比较,计算粗略的链接置信度。若某实体名称与字面描述完全匹配,或存在字面完全匹配的锚文本指向该实体,则将其置信度设为1。对于非完全匹配的情况,我们去掉字面描述和锚文本中的所有停用词,并计算 Jaccard 相似度,作为字面描述与对应实体的链接置信度。综合各种可能的英文翻译,根据链接置信度对所有实体进行排序,排名前 的实体将被保留,作为原字面描述的候选集。

的实体将被保留,作为原字面描述的候选集。

双语翻译层预训练:我们利用必应翻译的 API 收集了一个双语词典,其中包含 91,346 个单词级别的中英文翻译对,并且每对都关联了一个0到1范围的置信度。为了从中选取有价值的信息,我们保留那些置信度高于 0.5,且中英文词语均完全匹配某维基百科实体的翻译对。经过此法,我们总共收集了 3,655 个翻译词对用于转换矩阵的预训练。

调参细节:

• 每个单元格对应的候选实体数量( )的调参范围为 {1, 3, 5, 10, 20, 30, 40, 50};

)的调参范围为 {1, 3, 5, 10, 20, 30, 40, 50};

• 每个训练表格所生成的负样本表格数量( )范围为{9, 19, 49, 99};

)范围为{9, 19, 49, 99};

• 模型中,指示、上下文、总体特征对应向量的维度( )范围为 {20, 50, 100, 200};

)范围为 {20, 50, 100, 200};

• 学习率 范围为{0.0002, 0.0005, 0.001};

范围为{0.0002, 0.0005, 0.001};

• 我们在每一个隐含特征计算上使用 dropout 层[116],保留概率

范围为 {0.5, 0.6, 0.7, 0.8, 0.9}。

3.5 实验

本节中,我们首先介绍用于实验的跨语言表格链接数据集,以及已有的基线方法, 这些方法主要是由单一语言上的实体链接方法转换而来。我们在跨语言以及单一语言场景下进行了端到端测试,并且通过横向对比实验分析方法中不同模块的重要性。

3.5.1 实验设置

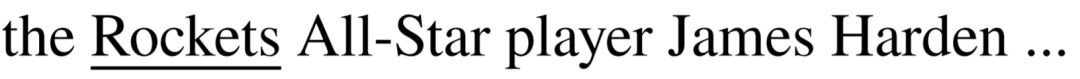

词向量、实体向量学习:我们使用2017年2月版本的中文与英文维基百科语料库,用于学习模型中的词向量与实体向量。语料库中包含 5,346,897 个英文实体以及 919,696 个中文实体。为了学习每个实体向量,我们将维基百科中的锚文本替代为一个特殊词语,与背后的实体一一对应。例如英文句子“ ” 中, 锚文本 “ Rockets ” 对应的实体为“ Houston Rockets ”,因此我们使用与之对应的特殊词语 “ [[Houston_Rockets]] ”替代锚文本。这样处理的好处在于,实体和普通词语之间无差别, 英文的词汇和实体用同一连续语义空间进行表达,这也使得模型经过翻译层后,更容易捕捉字面描述与实体间的相关性。预训练过程采用 Word2Vec [58]分别学习中文和英文语料库上的词向量,特殊词语向量即为对应实体向量。预训练的词向量维度设为100。

” 中, 锚文本 “ Rockets ” 对应的实体为“ Houston Rockets ”,因此我们使用与之对应的特殊词语 “ [[Houston_Rockets]] ”替代锚文本。这样处理的好处在于,实体和普通词语之间无差别, 英文的词汇和实体用同一连续语义空间进行表达,这也使得模型经过翻译层后,更容易捕捉字面描述与实体间的相关性。预训练过程采用 Word2Vec [58]分别学习中文和英文语料库上的词向量,特殊词语向量即为对应实体向量。预训练的词向量维度设为100。

表格链接数据集: 用于实验的跨语言表格数据集包含 150 个中文字面描述的互联网表格,以及对应的链接表格,标注的实体来自于英文维基百科。大部分表格来自 Wu 等人的研究[99],其公布的数据集包含 123 张中文表格,以及映射到中文维基百科上的实体。我们在互联网中收集了另外 40 张大小相似的中文表格,再利用维基百科的跨语言链接以及人工标注,生成所有的英文链接表格。大约 81% 的单元格可以找到对应的英文实体。我们过滤掉表格过小,或可被链接的单元格过少的表格。最终数据集包含150 张表格,共有 3,818 个单元格,其中 2,883 个单元格标注了链接实体,平均每张表格包含 19.22 个链接实体。我们将数据集随机分为训练集、验证集和测试集,比例为 80:20: 50。

3.5.2 基线模型

由于之前并没有直接针对于跨语言场景的表格链接工作,因此我们从两个角度出发,根据已有工作构建用于比较的模型。

第一个方向是单语言的表格链接系统,我们主要关注 Bhagavatula 等人[57] 以及 Wu 等人[99]的工作。这两个系统分别在英文表格链接与中文表格链接上取得了不错的结果,分别简写为  以及

以及  。为了使这两个系统能在跨语言场景中进行测试,我 们通过单一翻译工具将输入中文表格转换为英文,这样整个实验变成了单语言的场景,两个系统可以直接运行。

。为了使这两个系统能在跨语言场景中进行测试,我 们通过单一翻译工具将输入中文表格转换为英文,这样整个实验变成了单语言的场景,两个系统可以直接运行。

第二个方向是跨语言的实体链接系统,我们与 Zhang 等人[109] 的工作进行比较,简写为 TextEL 。该方法对 LDA 主题模型[110] 进行改进,称为双语 LDA 模型。其核心在于同一个隐含主题具有两个不同语言上的词汇概率分布,通过比较字面描述上下文与候选实体在主题概率分布上的相似度,确定最佳的链接结果。为了将该模型用于表格上的实体链接,我们将表格按行遍历方向展开成普通文本,并标记文本中所有需要被链接的短语位置。经过此法,TextEL 可以在文本中捕捉更灵活的上下文信息,但有可能丢失列方向上实体相关的特性。

3.5.3 实验结果

3.5.3.1 候选实体生成测试

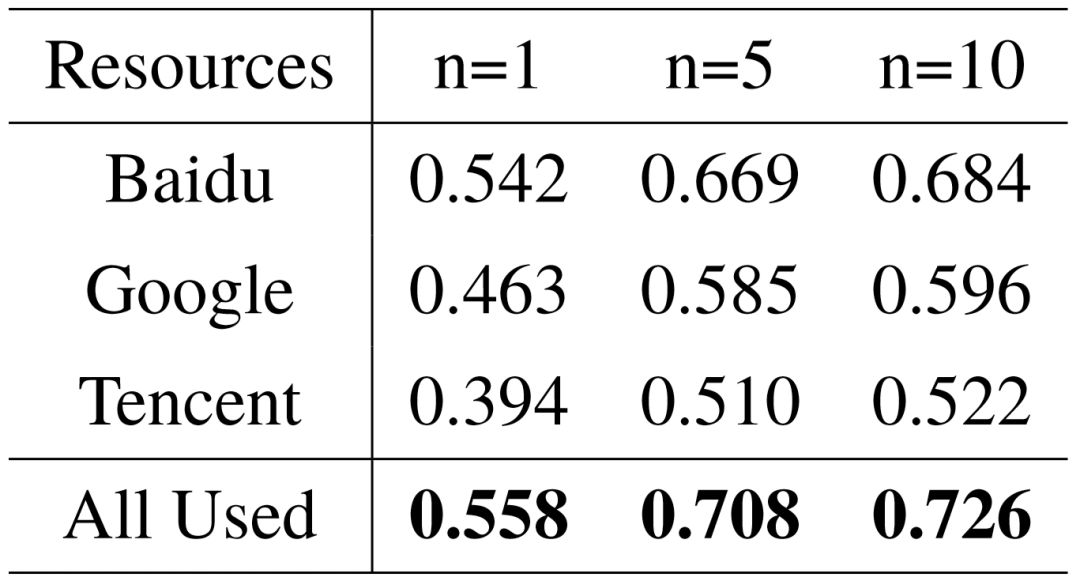

本节中,我们关注将中文字面描述翻译为候选实体的精准度。根据3.4.6节中的介绍,我们使用了三种不同的翻译工具用来生成候选实体。我们通过 Hits@n 指标来衡量候选生成结果的好坏,以比较不同翻译工具带来的差别。Hits@n 的定义为正确的英文实体出现在前 n 个候选实体中的单元格比例。具体比较结果如表3–1所示,从中观察可知,百度翻译的结果稳定优于另外两者,而当所有翻译工具全部使用时,相比百度翻译结果,Hits@5 和 Hits@10 都能稳定增长约 4%。这说明了多个翻译工具之间互相补充,有助于发现更多正确的实体,同时有效的字面相似度的候选排序避免了过多错误的候选实体被引入。

表3–1 候选生成步骤的Hits@n 测评结果。

3.5.3.2 端到端测试

本节中,我们将与其它基线模型  ,

, 和

和  在跨语言场景上进行端到端测试。与已有工作的实验保持一致,我们使用的评价指标为微观准确率( Micro Accuracy )和宏观准确率( Macro Accuracy )。微观准确率统计所有测试表格中,实体链接正确的单元格比例,而宏观准确率定义为每个表格各自链接准确率的平均值,避免了评价指标倾向于更大的表格。

在跨语言场景上进行端到端测试。与已有工作的实验保持一致,我们使用的评价指标为微观准确率( Micro Accuracy )和宏观准确率( Macro Accuracy )。微观准确率统计所有测试表格中,实体链接正确的单元格比例,而宏观准确率定义为每个表格各自链接准确率的平均值,避免了评价指标倾向于更大的表格。

由于  和

和  仅通过一种翻译工具生成输入表格的英文描述,出于公平考量,我与基线模型的比较实验均仅使用百度翻译。与此同时,我们也评估使用所有翻译工具,并且进行预训练的模型准确率。基于测试集上微观准确率的调参,我们使用的模型超参数为

仅通过一种翻译工具生成输入表格的英文描述,出于公平考量,我与基线模型的比较实验均仅使用百度翻译。与此同时,我们也评估使用所有翻译工具,并且进行预训练的模型准确率。基于测试集上微观准确率的调参,我们使用的模型超参数为  = 30,

= 30, = 49,

= 49, =

=  = 100,

= 100, = 200,

= 200, = 0.0002以及

= 0.0002以及  = 0.9。

= 0.9。

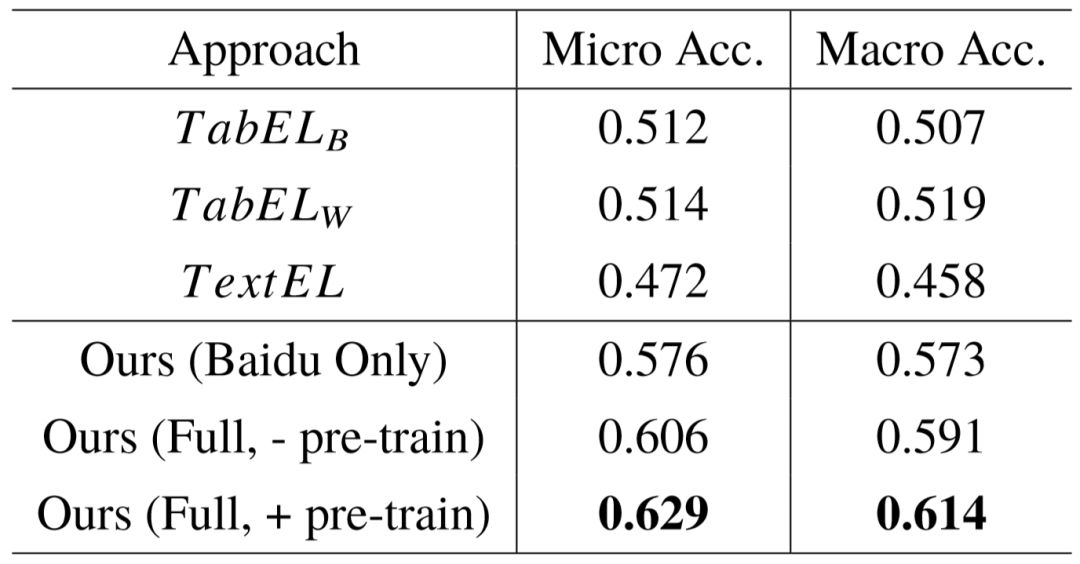

表3–2显示了端到端实验的比较结果。首先关注上面四行仅使用百度翻译的实验,我们模型的大幅度优于其余基线模型,准确率得到了约 12.1% 的相对提升。在此基础之上,使用多个翻译工具模型将微观准确率提升了0.03,再次表明翻译工具之间的互补性给整个系统带来的帮助。双语翻译层的预训练步骤同样具有明显效果,进一步将微观准确率提升了0.023。基于单语言表格链接模型的  与

与  受困于翻译过程带来的局限性:实体预测结果严重依赖唯一的英文翻译,一旦出现偏差便很难纠正,整个系统容错率较低。由于模型的后续训练切断了与原始中文描述之间的联系,这导致了翻译步骤无法收到训练数据提供的反馈,因此错误只能在模型中传播。作为对比,我们提出的模型利用多种英文翻译生成大量候选实体,并将原始中文描述作为输入学习特征表示,尽可能减轻了翻译过程的信息流失。

受困于翻译过程带来的局限性:实体预测结果严重依赖唯一的英文翻译,一旦出现偏差便很难纠正,整个系统容错率较低。由于模型的后续训练切断了与原始中文描述之间的联系,这导致了翻译步骤无法收到训练数据提供的反馈,因此错误只能在模型中传播。作为对比,我们提出的模型利用多种英文翻译生成大量候选实体,并将原始中文描述作为输入学习特征表示,尽可能减轻了翻译过程的信息流失。

表3–2 跨语言表格链接的测试结果,基线模型仅使用百度翻译工具。

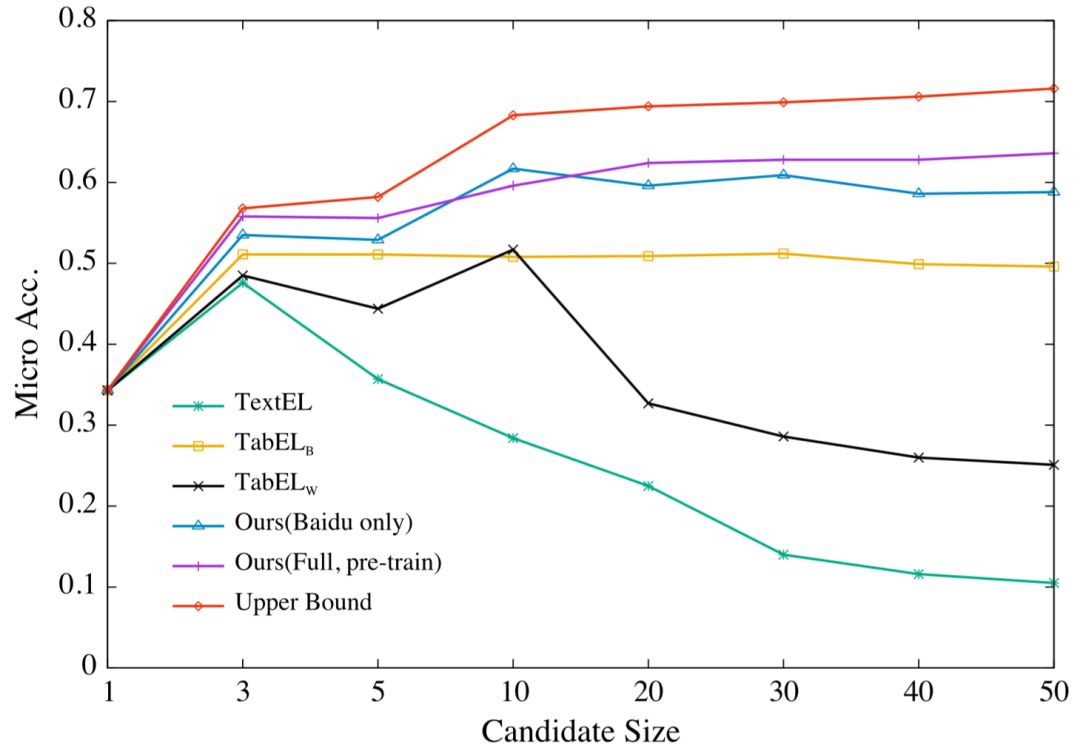

接下来,我们进一步分析候选实体数量  将对模型效果产生怎样的影响。显而易见的是,一方面随着

将对模型效果产生怎样的影响。显而易见的是,一方面随着  增大,候选实体中包含正确实体的概率也随之增大,意味着模型准确率的理论上限将会提高,而另一方面,

增大,候选实体中包含正确实体的概率也随之增大,意味着模型准确率的理论上限将会提高,而另一方面, 增大会引入更多干扰实体,整 个系统也就更难达到理论上限。我们在不同的模型上改变

增大会引入更多干扰实体,整 个系统也就更难达到理论上限。我们在不同的模型上改变  值,进行了多组比较实验,微观准确率结果如图3–3所示,图中标出了微观准确率的理论上限。我们的方法在不同大小的候选数量上均有良好的适应性,随着

值,进行了多组比较实验,微观准确率结果如图3–3所示,图中标出了微观准确率的理论上限。我们的方法在不同大小的候选数量上均有良好的适应性,随着  增大,一直保持着稳定的效果提 升。

增大,一直保持着稳定的效果提 升。 的效果比较稳定,但带有微小的准确率下降。而

的效果比较稳定,但带有微小的准确率下降。而  结果出现了急剧下降,拐点位置的候选数量甚至没有超过10。我们认为主要原因在于双语 LDA 模型基于无监督学习方式,它没有获得任何直接的<中文描述,英文实体>信息用于训练,因此对干扰实体的数量非常敏感。

结果出现了急剧下降,拐点位置的候选数量甚至没有超过10。我们认为主要原因在于双语 LDA 模型基于无监督学习方式,它没有获得任何直接的<中文描述,英文实体>信息用于训练,因此对干扰实体的数量非常敏感。

图3–3 微观准确率随候选实体数量  的变化情况。

的变化情况。

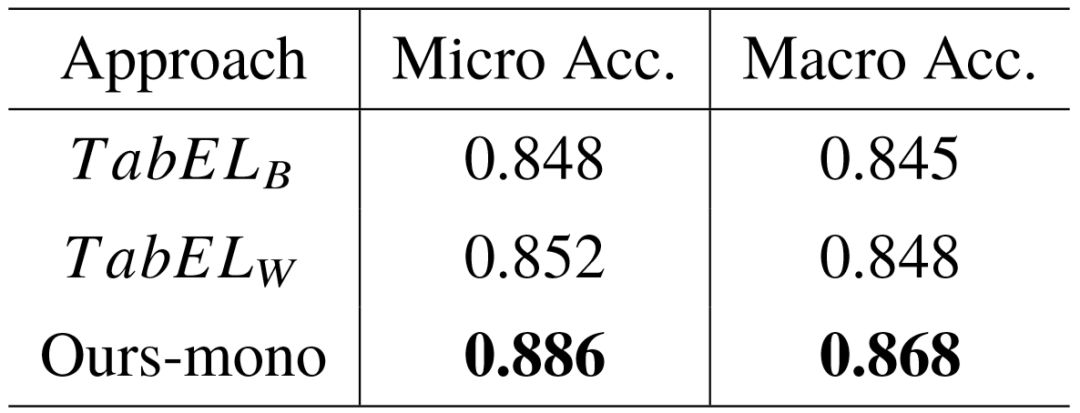

为了更好地证明模型的有效性,我们对单语言场景的表格链接也进行了测试。由于跨语言的数据集利用中英文维基百科之间的链接构建,因此只需把标注实体替换为对应中文维基实体即可。相应地,我们从模型中移除双语翻译层,并保持其余设置不变。用于比较的系统依然为  和

和 ,两者均为表格链接的代表工作,其中后者为中文表格链接任务的最好结果。表3–3列出的实验结果显示,我们模型的单语言版本依然优于两个基线系统,这在一定程度上说明了基于神经网络的联合训练模型的有效性, 可以从表格的行列之中捕捉有意义的语义信息。

,两者均为表格链接的代表工作,其中后者为中文表格链接任务的最好结果。表3–3列出的实验结果显示,我们模型的单语言版本依然优于两个基线系统,这在一定程度上说明了基于神经网络的联合训练模型的有效性, 可以从表格的行列之中捕捉有意义的语义信息。

表3–3 中文环境下的表格链接准确率。

3.5.4 模型分析测试

本节中,我们对提出的神经网络模型进行了更加详细的实验分析,探索模型中指示、上下文、一致性特征各自的贡献程度,以及联合训练的模型架构所带来的优势。

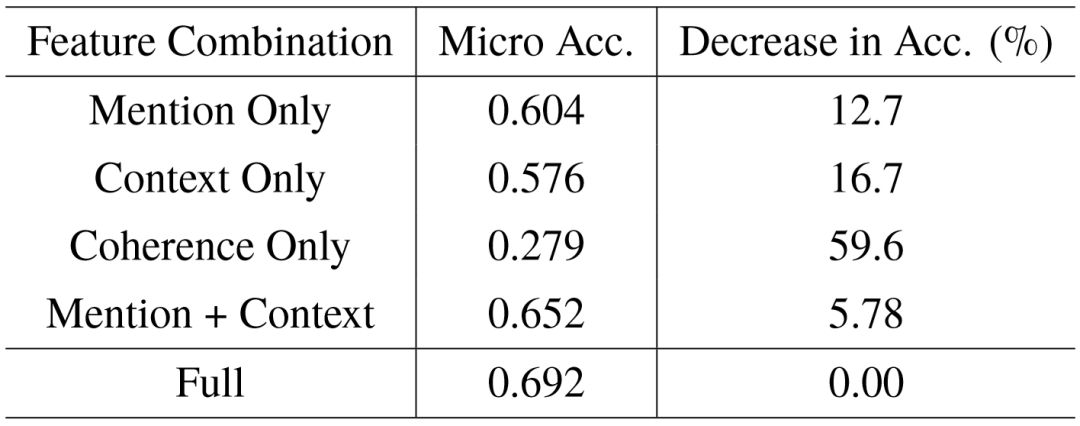

3.5.4.1 三类特征的作用

为了研究模型涉及到的三种不同特征的贡献程度,我们使用不同的特征组合,在跨语言场景中进行对比测试。比较结果如表3–4所示,模型中的每一类特征都对最终的准确率起到积极贡献。其中,指示特征是最重要的特征,因为它提供了字面描述与目标实体之间最为直接的信息。上下文特征的作用也十分明显,在维基百科中,实体对应的锚文本周围很可能出现与其同行或同列的其它描述,因此基于 CBOW 或 Skip-Gram 训练的实体向量包含这些上下文的语义。我们观察到,如果仅使用一致性特征进行训练,准确率的降低十分明显,约为 59.6%,这主要是因为模型难以获取实体与字面描述之间, 最主导和直接的语义关联。但这并不影响一致性特征对指示及上下文特征的补充,若去除该特征,模型准确率将相对下降约 6%,依然是不小的差距。一致性特征旨在从全局角度发现实体之间的潜在关联,用来表征同一列实体之间是否具有一致性,例如隶属于相同的维基百科分类标签。即便模型没有直接利用每个实体的分类标签信息,一致性特征依然可以在向量表示中寻找依据。

表3–4 不同特征组合在验证集上的跨语言链接准确率。

我们用本章开头的图3–1举例讨论一致性特征的有效性。第三列中字面描述 “钢铁侠”具有很高的歧义,在维基百科中,它可以对应超级英雄“ Iron_Man ”,也可以对应电影 “ Iron_Man_(2008_film) ”。作为对比,“驯龙高手”(“ How_to_Train_Your_Dragon_(film) ” )以及“线人”(“ The_Stool_Pigeon_(2010_film) ”)相对来说歧义较小。若只使用指示特征和上下文特征,模型预测的实体为超级英雄,考虑到钢铁侠在更多文本中确实代表超级英雄,因此这样的预测结果可以理解,但却是错误的。当一致性特征引入之后,联系其它两个歧义较低的实体,同一列实体之间强烈的相关性使得模型倾向于这一列都预测电影,因此模型能够实现正确的预测。

3.5.4.2 联合模型的作用

这部分将验证整个联合模型框架的作用。相对于联合模型计算整个输入表格与链接表格的相关度,非联合模型中,单元格之间完全独立,各自计算字面描述与候选实体的匹配程度,最后求平均得到整张表格上的相关度。我们将联合模型进行退化,由于非联合模型仅考虑单个单元格,我们移除模型中的一致性特征模块,并无需对不同单元格的特征输出求平均。作为对比实验,我们同样从已有的联合模型中移除一致性特征,并尝试分别使用 RankNet 模型或最大间隔损失( Max Margin )进行训练。

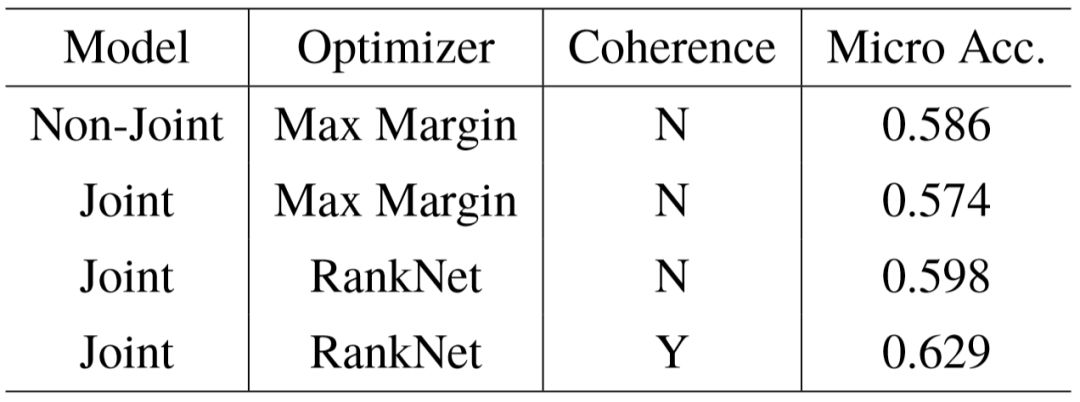

表3–5列出了这一部分实验在测试集上的微观准确率结果。对比前两行结果,我们可以发现,若使用最大间隔损失,非联合模型的效果反而优于联合模型。主要原因有以下两点:1) 非联合模型中,每一个单元格的多个负样本实体都能在训练过程中被利用, 而对于联合模型,由于负样本表格的生成依靠随机采样,并不是所有的负样本实体都会被使用;2)最大间隔损失侧重于正样本表格与不同负样本表格间的分值差距,而对于不同错误程度的负样本表格之间,它们的偏序关系并没有被有效利用。因此,相比于最大间隔损失,基于成对计算损失的 RankNet 更加适合于联合模型。此外,在算法运行速度方面,非联合模型无需迭代预测步骤,因此显然比联合模型更高效。而实验过程显示,联合模型平均只需要 6 轮迭代即可完成对每个测试表格的链接预测,是一个可以被接受的运行速度。

表3–5 不同模型训练方式在测试集上的跨语言链接准确率。

3.6 本章小结

据我们所知,本章的工作是首次提出了在跨语言场景中进行互联网表格的实体链接问题。为了使问题尽可能通用,本文研究在不利用任何非英文知识库作为过渡的情况下, 完成非英文表格到英文知识库(维基百科)的链接。为此,本文提出了一个基于神经网络和跨语言词向量的链接模型,并利用模型学习三种不同粒度的链接特征,分别为单元格自身与目标实体的指示特征,单元格所在行列与目标实体的上下文特征,以及同一列目标实体之间的一致性特征。同时模型遵循联合训练框架,定义整张表格级别的链接匹配程度作为目标函数,并使用迭代更新方式完成所有单元格的链接。本文提出的模型在跨语言表格链接任务中取得了 63% 的准确率,考虑到此任务比单语言链接更具有挑战 性,本文对后续的研究而言是一个良好的开端。在不同设定上的多组对比实验显示,三种粒度的特征对模型均起到明显效果,同时联合训练框架也具有实质性的帮助。

后续的研究主要包括对表格中的单元格判断是否需要被链接,本文的任务定义移除了这个问题带来的影响,但显然,不可链接的单元格在互联网表格中也会普遍存在,因此该研究具有其实际意义。

参考文献

(文中提及的部分参考文献在01#)

了解更多信息请点击知识工场网站主页:http://kw.fudan.edu.cn/

合作意向、反馈建议请联系:

info.knowledgeworks@gmail.com

OpenKG

开放知识图谱(简称 OpenKG)旨在促进中文知识图谱数据的开放与互联,促进知识图谱和语义技术的普及和广泛应用。

点击阅读原文,进入 OpenKG 博客。