热门标签

热门文章

- 1无人机水利巡检系统解决方案

- 2动态规划---最长连续子序列问题

- 3JDBC (基础)

- 4Android MVP模式深入实践探索(二),学Android看这就完事了_preferences.getboolean

- 5【Python】快速了解一个知识点: Python 中的哈希(Hash)_python哈希

- 6解决uview2 u-icon图标不显示问题,亲测必行

- 7八股文之框架篇(Spring Boot、SSM)_ssm八股文

- 8PostgreSQL数据库中的角色(Role)、用户(User)、模式(Schema)_pgsql role和user

- 9matlab算法,2维A*路径规划算法,在地图范围内(大小随意修改) ,可以通过鼠标点击来选择起始点_在二维进行a*在地图上路径规划

- 10某图书馆书籍推荐系统的设计与实现(源码+开题)_图书推荐系统

当前位置: article > 正文

Transformer - layer norm_transformer layernorm结构

作者:煮酒与君饮 | 2024-07-19 16:27:20

赞

踩

transformer layernorm结构

- Encoder structure

2. layer normalization:

-

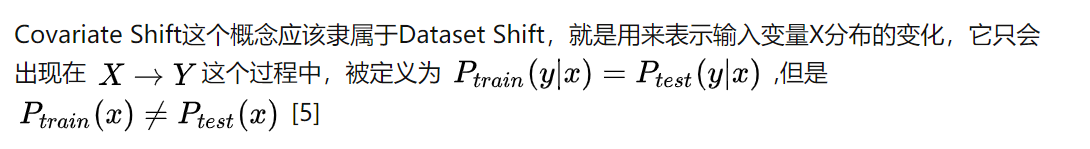

什么是covariate shift?

Covariate shift is the change in the distribution of the covariates specifically, that is, the independent variables.

在机器学习实践中,我们一定要注意训练数据集和实际情况产生的数据分布不同而带来的影响。 -

batch norm vs layer norm

BN:

LN:

- Layer normalized recurrent neural networks

its normalization terms dependonly on the summed inputs to a layer at the current time-step. It also has only one set of gain (g) and bias (b) parameters shared over all time-steps.

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/煮酒与君饮/article/detail/852435

推荐阅读

相关标签