热门标签

热门文章

- 1hive4 从入门到精通

- 2【芯片架构】深入理解嵌入式领域芯片架构:探讨不同类型(ARM Cortex、RISC-V、MIPS、PowerCP)的嵌入式处理器及其在实际应用中的优缺点_cortex r8 a53

- 314 STM32标准库函数 之 实时时钟(RTC) 所有函数的介绍及使用_stm32rtc库

- 4Android SurfaceFlinger导读(04)理解BufferQueue_android bufferqueue

- 5我学计算机的四年

- 6大数据背景下的银行个人征信体系研究_大数据征信

- 7【vscode快捷键】多个终端切换_vscode调试的时候怎样更换终端

- 8kafka canal mysql_Canal+Kafka实现MySql与Redis数据一致性

- 9爬本地视频错误,求大佬诊断_you-get: [error] oops, the current environment doe

- 10Android 架构最新进展 | MVI = 响应式编程 + 单向数据流 + 唯一可信数据源_android mvi开发框架实战

当前位置: article > 正文

Ollma本地大模型沉浸式翻译【403报错解决】_ollama 403

作者:爱喝兽奶帝天荒 | 2024-08-03 14:27:18

赞

踩

ollama 403

最终效果

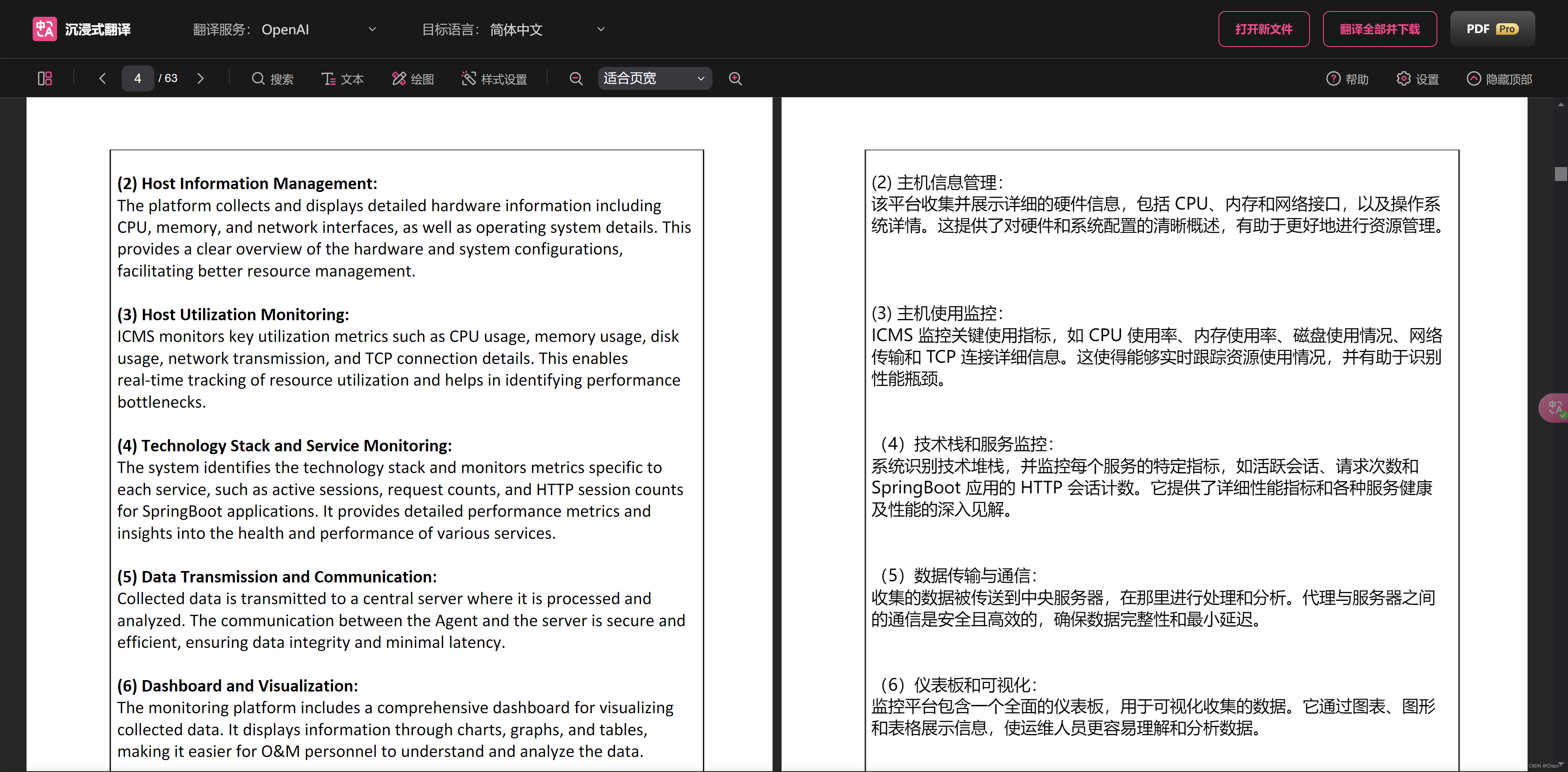

通过Chrome的 沉浸式翻译 插件,用OpenAI通用接口调用本地的Ollma上的模型,实现本地的大模型翻译文献。

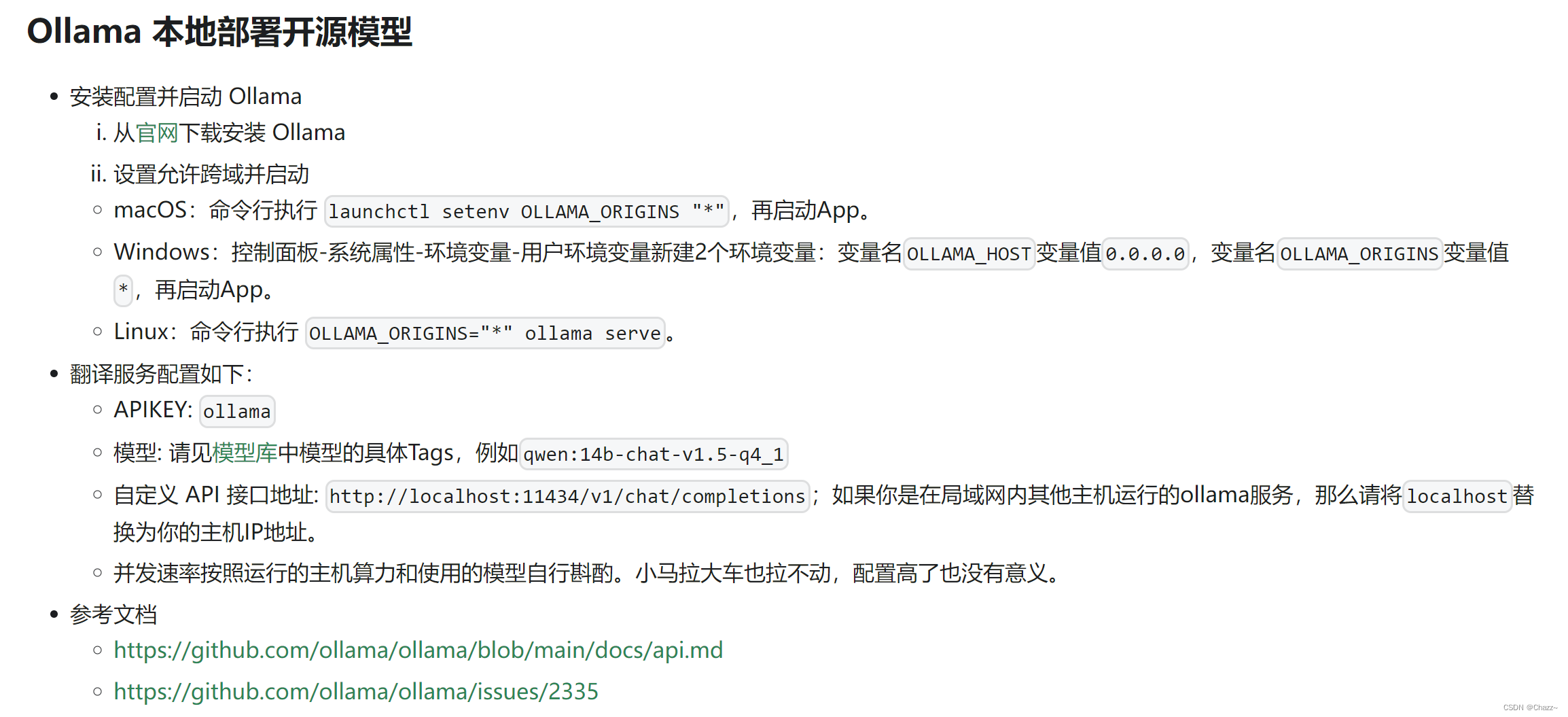

官方文档指导的Ollama的配置:一定要配置环境变量,否则会出现【403报错】

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/爱喝兽奶帝天荒/article/detail/923370

推荐阅读

相关标签