- 1Stata:拉索回归和岭回归-(Ridge,-Lasso)-简介

- 2SAP FI常用事务码_sap fb1s

- 3Linux——缺页中断与内存置换算法,你想知道的都在这里!_lru置换算法计算432143543215

- 4KMP算法详解及其Java实现_kmdkcnnj 哦对;下班必须滴不是客服。觉得

- 5Ollama 常用命令_ollama 命令

- 6【算法】位运算算法——两整数之和

- 7git cherry-pick冲突解决_gerrit中的cherry pick confict

- 8git Cherry-pick Failed your local changes would be overwritten by cherry-pick. hint: commit your

- 9Git多用户,不同项目配置不同Git账号_git 不同项目不同

- 102022年华为杯中国研究生数学建模竞赛C题思路_2022年华为杯c题思路

Hadoop集群环境搭建(超详细)_hadoop集群搭建

赞

踩

1 实验环境

- Oracle Linux 7.4

- JDK 1.8

- Hadoop 2.7.4

2 实验准备

1.实验准备三台机器分别为master,slave1,slave2

2.单击master机器桌面中的konsole图标

3 配置SSH免密登录

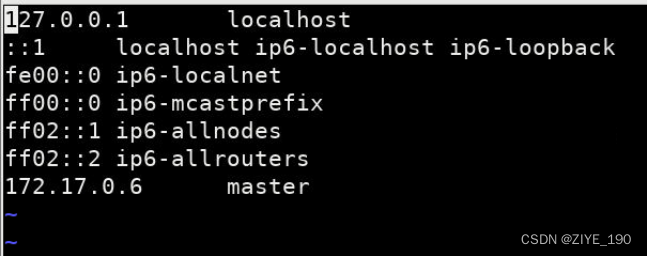

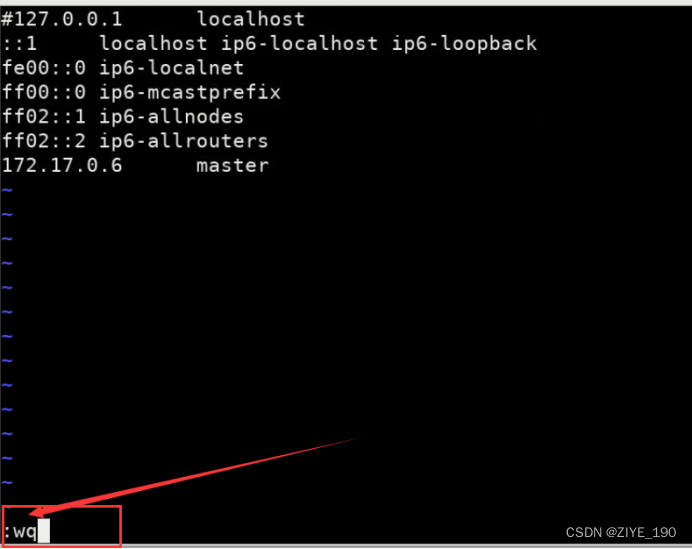

1.编辑/etc/hosts文件,出现如下界面

[Command 001]:

vim /etc/hosts

- 1

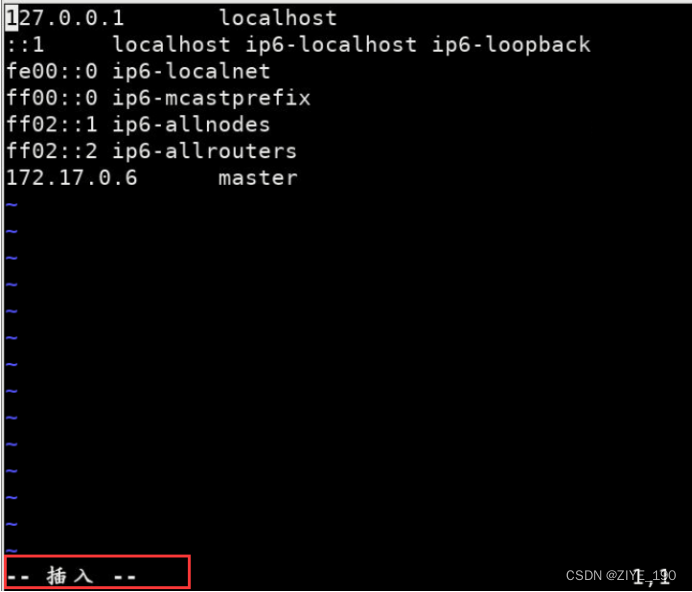

2.按i键,如下图

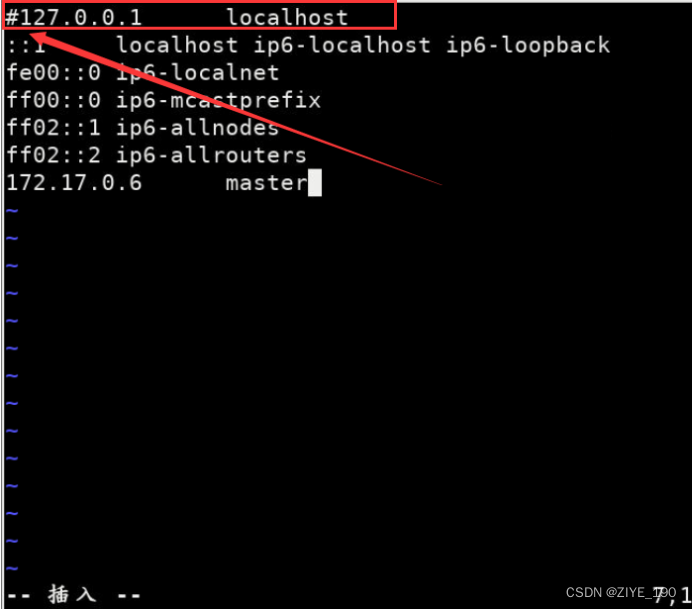

3.第一行前面添加#,如下图

4.按键ESC,按键:wq回车,保存退出。如下图

5.切换到slave1机器,重复1~4步骤

6.切换到slave2机器,重复1~4步骤

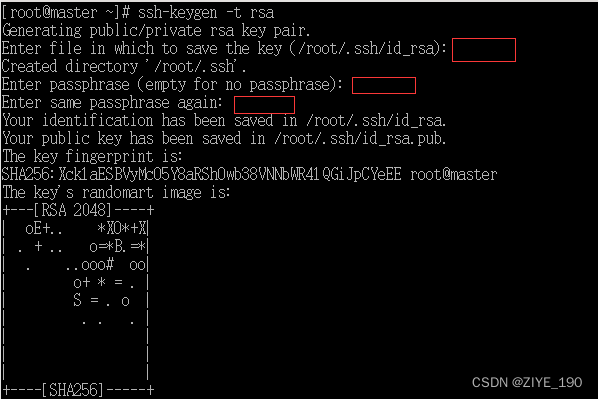

7.切换到master机器,master机器中创建ssh秘钥,输入如下命令,红框位置直接回车即

[Command 002]:

ssh-keygen -t rsa

- 1

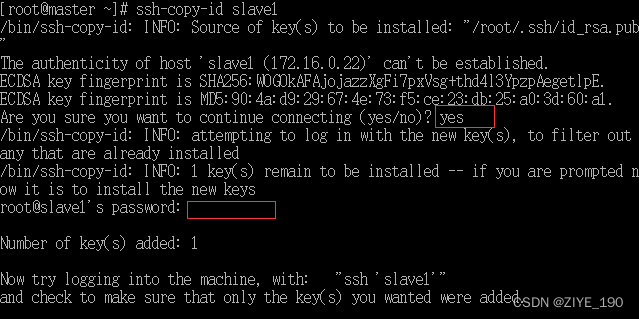

8.将公钥拷贝到slave1机器,第一个红框位置输入yes,第二个红输位置输入root

[Command 003]:

ssh-copy-id slave1

- 1

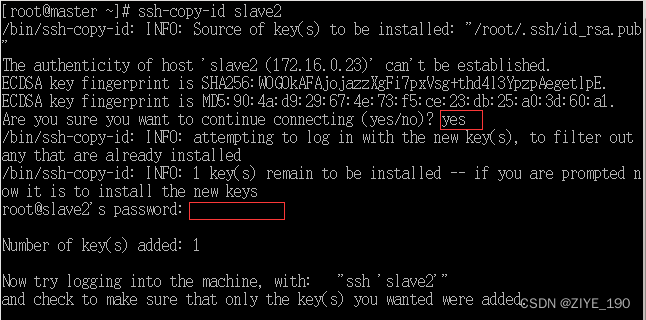

9.将公钥拷贝到slave2机器, 第一个红框位置输入yes,第二个红输位置输入root

[Command 004]:

ssh-copy-id slave2

- 1

10.同样道理,将公钥拷贝到master本机

[Command 005]:

ssh-copy-id master

- 1

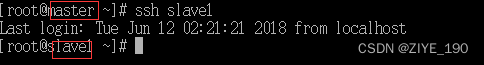

11.验证由master机器通过ssh方式免密登录到slave1

[Command 006]:

ssh slave1

- 1

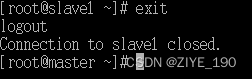

12.退出slave1

[Command 007]:

exit

- 1

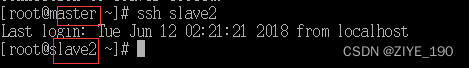

13.验证由master机器通过ssh方式免密登录到slave2

[Command 008]:

ssh slave2

- 1

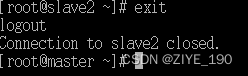

14.退出slave2

[Command 009]:

exit

- 1

4 Hadoop安装与配置

1.解压hadoop压缩文件至/opt目录下

[Command 010]:

tar -zxvf ~/experiment/file/hadoop-2.7.4.tar.gz -C /opt

- 1

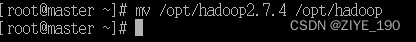

2.修改解压后为文件名为hadoop

[Command 011]:

mv /opt/hadoop-2.7.4 /opt/hadoop

- 1

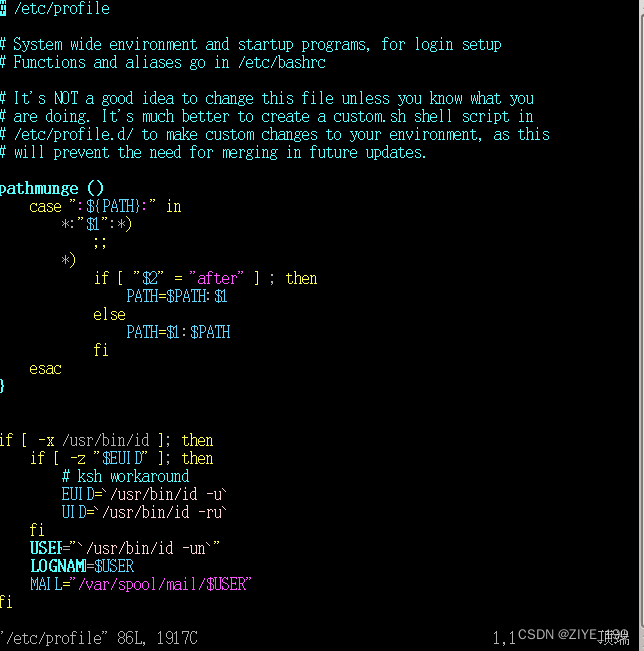

3.修改环境变量

[Command 012]:

vim /etc/profile

- 1

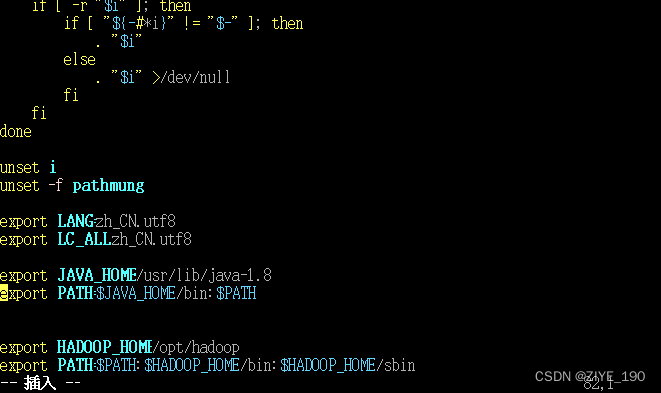

4.按键Shift+g键定位到最后一行,按键 i 切换到输入模式下,添加如下代码

[Code 001]:

export HADOOP_HOME=/opt/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

- 1

- 2

5.按键Esc,按键:wq保存退出

6.刷新配置文件

[Command 013]:

source /etc/profile

- 1

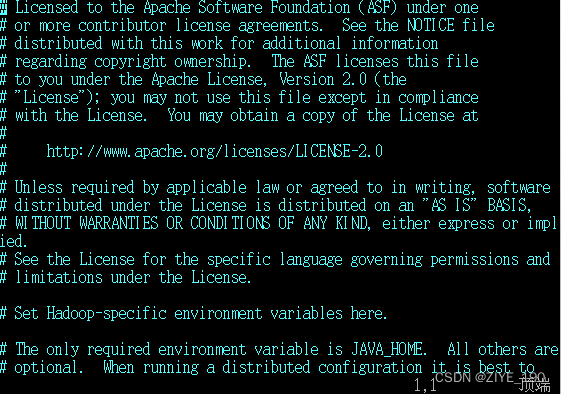

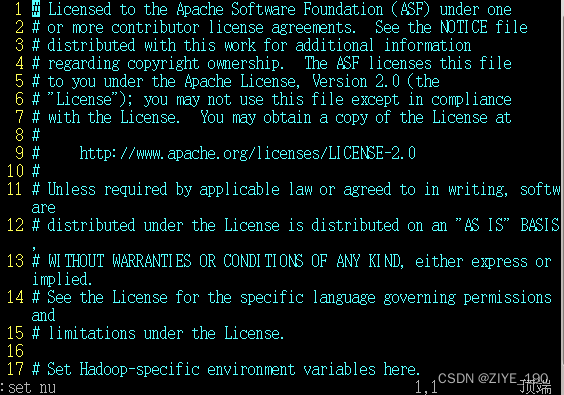

7.编辑/opt/hadoop/etc/hadoop/hadoop-env.sh文件,部分截图如下

[Command 014]:

vim /opt/hadoop/etc/hadoop/hadoop-env.sh

- 1

8.按键:set nu回车设置行号,部分截图如下

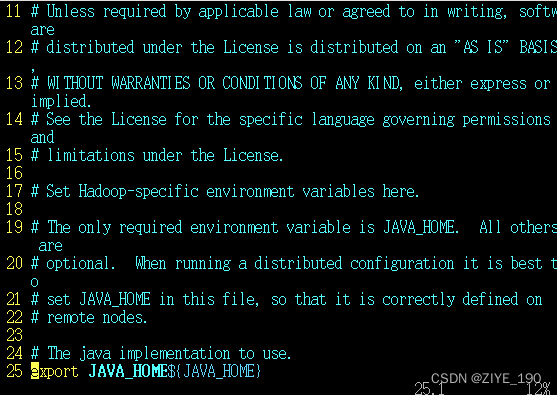

9.按键25gg定位到25行,部分截图如下

10.按键dd删除此行,部分截图如下

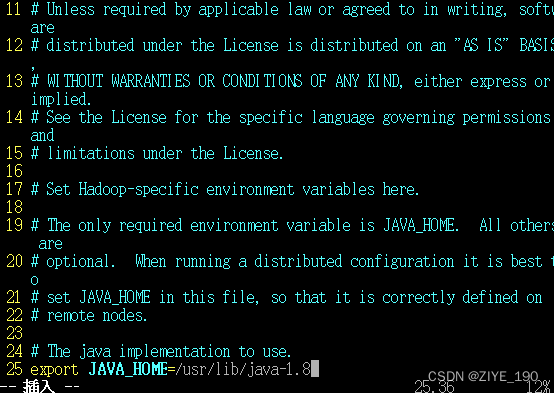

11.按键 i 添加如下代码

[Code 002]:

export JAVA_HOME=/usr/lib/java-1.8

- 1

12.按键Esc,按键:wq保存退出

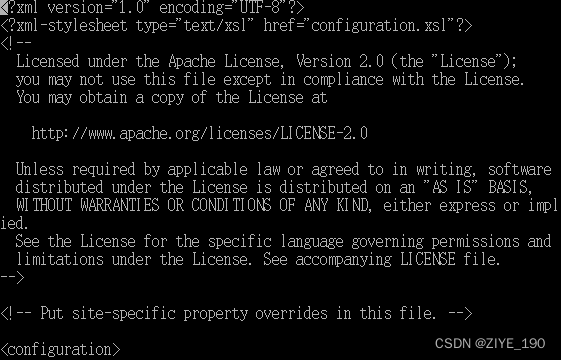

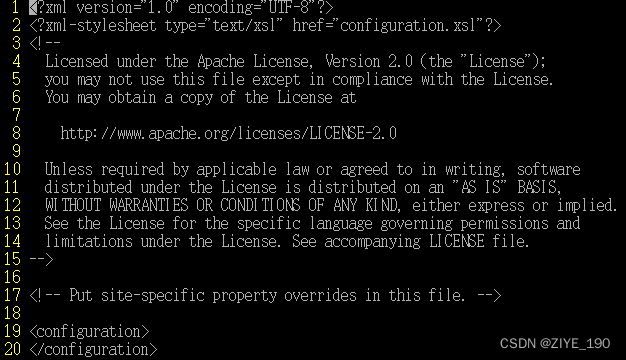

13.编辑/opt/hadoop/etc/hadoop/core-site.xml文件,部分截图如下

[Command 015]:

vi /opt/hadoop/etc/hadoop/core-site.xml

- 1

14.按键:set nu回车设置行号,部分截图如下

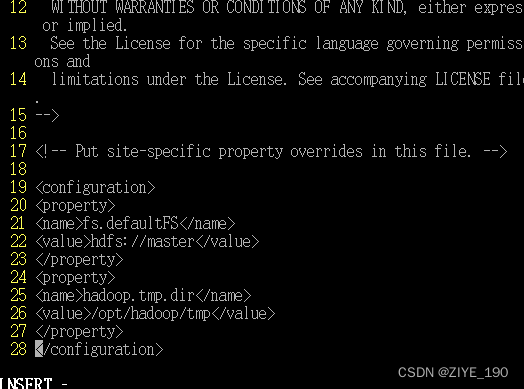

15.按键19gg定位到19行,按键o添加如下代码,部分截图如下

[Code 003]:

<property>

<name>fs.defaultFS</name>

<value>hdfs://master</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/hadoop/tmp</value>

</property>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

16.按键Esc,按键:wq保存退出

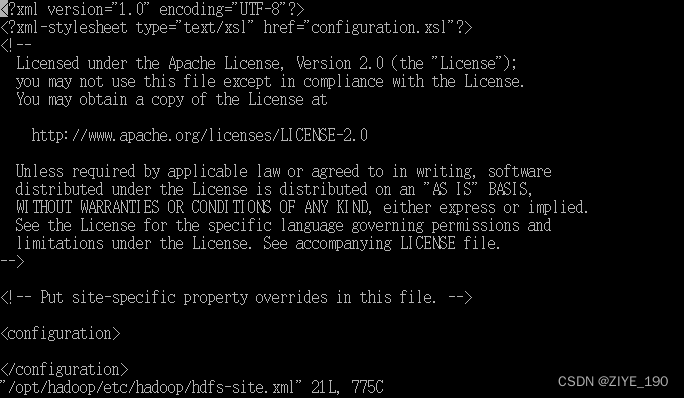

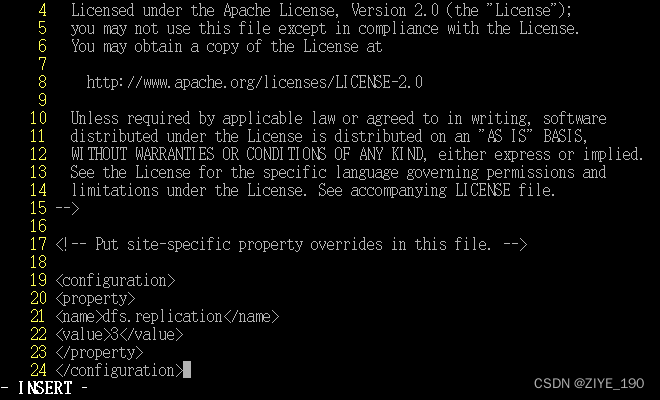

17.编辑/opt/hadoop/etc/hadoop/hdfs-site.xml文件,部分截图如下

[Command 016]:

vi /opt/hadoop/etc/hadoop/hdfs-site.xml

- 1

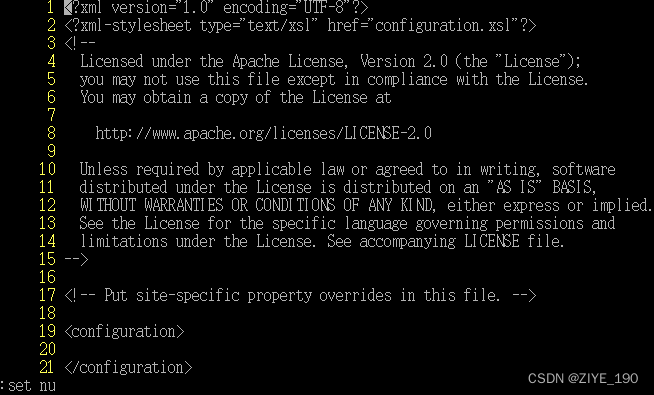

18.按键:set nu回车,设置行号

19.按键20gg定位到20行,按键i添加如下代码

[Code 004]:

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

- 1

- 2

- 3

- 4

20.按键Esc,按键:wq保存退出

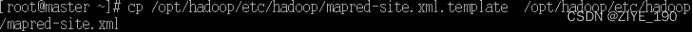

21.复制/opt/hadoop/etc/hadoop/mapred-site.xml.tmplate 名为mapred-site.xml

[Command 017]:

cp /opt/hadoop/etc/hadoop/mapred-site.xml.template /opt/hadoop/etc/hadoop/mapred-site.xml

- 1

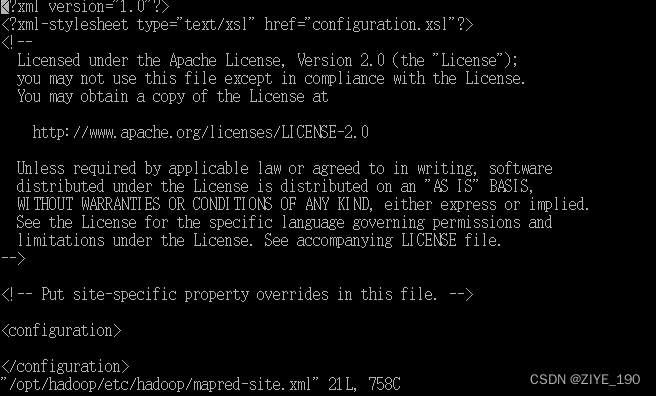

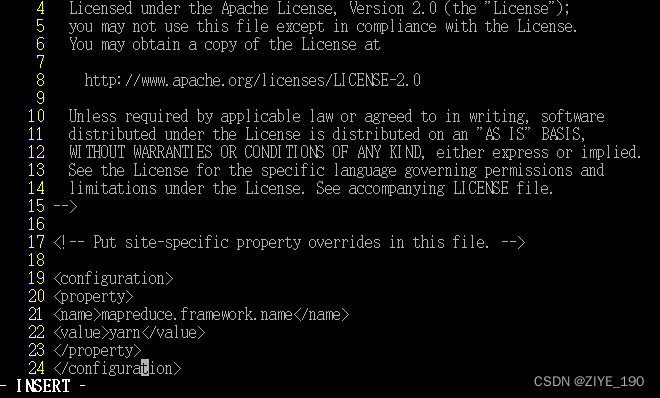

22.编辑/opt/hadoop/etc/hadoop/mapred-site.xml文件,部分截图如下

[Command 018]:

vi /opt/hadoop/etc/hadoop/mapred-site.xml

- 1

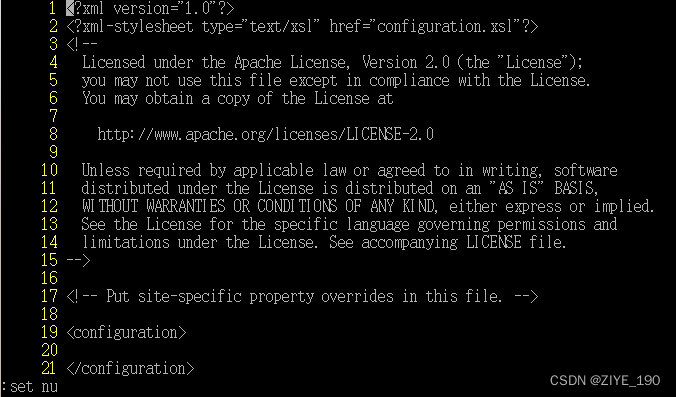

23.按键:set nu回车,设置行号

24.按键20gg定位到20行,按键i添加如下代码

[Code 005]:

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

- 1

- 2

- 3

- 4

25.按键Esc,按键:wq保存退出

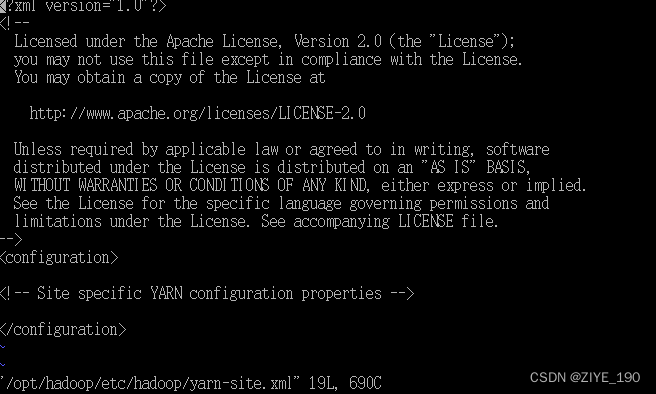

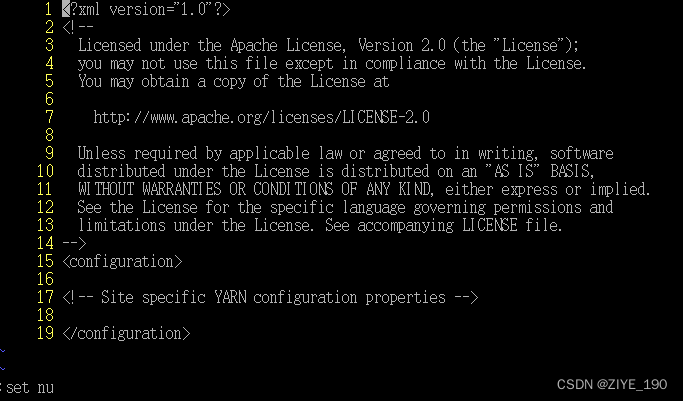

26.编辑/opt/hadoop/etc/hadoop/yarn-site.xml文件,部分截图如下

[Command 019]:

vi /opt/hadoop/etc/hadoop/yarn-site.xml

- 1

27.按键:set nu回车,设置行号

28.按键18gg定位到18行,按键i添加如下代码,部分截图如下

[Code 006]:

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>master</value>

</property>

<property>

<name>yarn.scheduler.minimum-allocation-mb</name>

<value>512</value>

</property>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

29.按键Esc,按键:wq保存退出

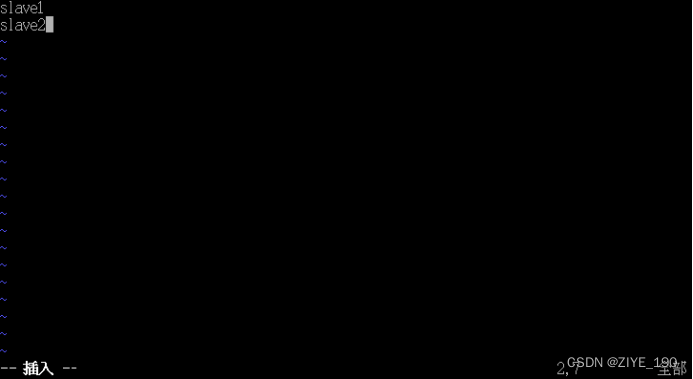

30.编辑/opt/hadoop/etc/hadoop/slaves文件

[Command 020]:

vim /opt/hadoop/etc/hadoop/slaves

- 1

31.按键dd删除首行,按键i添加如下内容

[Code 007]:

slave1

slave2

- 1

- 2

32.按键Esc,按键:wq保存退出

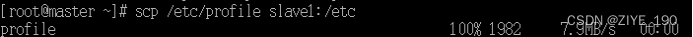

33.拷贝master主机/etc/profile到slave1主机/etc下

[Command 021]:

scp /etc/profile slave1:/etc

- 1

34.拷贝master主机/etc/profile到slave2主机/etc下

[Command 022]:

scp /etc/profile slave2:/etc

- 1

35.拷贝master主机/opt/hadoop到slave1主机/opt下

[Command 023]:

scp -r /opt/hadoop slave1:/opt

- 1

36.拷贝master主机/opt/hadoop到slave2主机/opt下

[Command 024]:

scp -r /opt/hadoop slave2:/opt

- 1

37.slave1机器命令行中执行如下指令

[Command 025]:

source /etc/profile

- 1

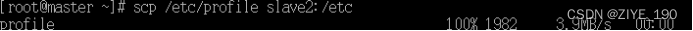

38.同样道理,slave2机器命令行中执行如下指令

[Command 026]:

source /etc/profile

- 1

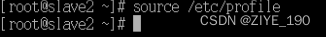

39.master机器命令行中执行如下指令,格式化hdfs,部分截图如下

[Command 027]:

hdfs namenode -format

- 1

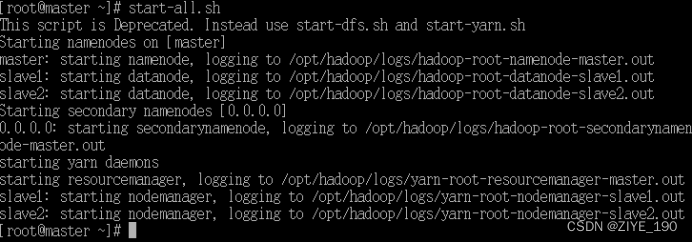

40.master机器命令行中执行如下指令,启动集群

[Command 028]:

start-all.sh

- 1

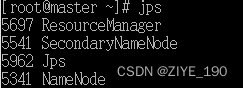

41.master机器命令行中执行如下指令,查看进程

[Command 029]:

jps

- 1

42.slave1机器命令行中执行如下指令,查看进程

[Command 030]:

jps

- 1

43…slave2机器命令行中执行如下指令,查看进程

[Command 031]:

jps

- 1

44.所有配置完成,进程启动完毕