- 1Springboot+Vue项目-基于Java+MySQL的在线视频教育平台系统(附源码+演示视频+LW)

- 2vue 实现项目进度甘特图

- 3Vue为技术栈的前端低代码平台『JNPF』_vue 低代码 开发平台

- 4全志平台BSP裁剪(4)kernel裁剪--File systems & driver & 杂项裁剪_free xx

- 5and-design-vue 3.2.20官方离线文档(中文)_antd中文文档

- 6加载dll出错的解决方法_加载pdapi.dll

- 7计算机网络教育文凭,2020年9月网络教育统考《计算机应用基础》计算机网络模拟题试卷6...

- 8OpenCV开发笔记(七十六):相机标定(一):识别棋盘并绘制角点_opencv chessboard

- 9Git 基础 - tag 的使用_git push tag

- 10c++11特殊类设计,单例模式_c++11 规范的实现一个类

知识增强系列 ERNIE: Enhanced Representation through Knowledge Integration,论文解读

赞

踩

论文全称:通过知识集成增强语义表达

1. motivation

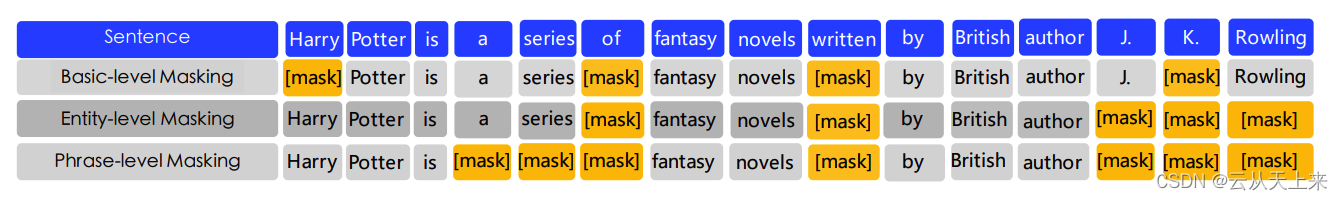

ERNIE 目的在于通过知识屏蔽策略增强语言表示,其中屏蔽策略包括实体级屏蔽(Entity-level strategy)和短语级屏蔽(Phrase-level strategy)。 entity-level 策略通常会掩盖由多个单词组成的实体; Phrase-level 策略会掩盖由几个词共同作为概念单元的整体短语。

2. 模型

论文中对于不同任务使用的模型分为两种,原始Bert结构,和本文针对‘对话数据’额外提出的Dialogue Language Model。

非对话数据:模型整体结构没有改变,依然是Bert的结构,输入仍然是3个部分 token embedding + segment embedding + position embedding,整句话的第一个token是[CLS]。

对话数据:Dialogue Language Model,segment embedding --> dialogue embedding,Q=question;A=answer

3. 知识屏蔽策略,一起训练?还是多阶段依次训练?

3.1 Basic-level Masking(Bert)

将句子视为基本语言单元的序列,对于英语,基本语言单元是单词;对于中文,基本语言单元是汉字。

在训练过程中,随机屏蔽 15% 的基本语言单元,并使用句子中的其他基本单元作为输入,并训练一个transformer来预测Mask的部分。

基于Basic-level Masking,获得基本的单词表示。 因为它是在基本语义单元的随机掩码上训练的,高级语义知识很难完全建模。

3.2 短语阶段 Phrase-Level Masking

第二阶段是使用短语级掩码。短语是一小组单词或字符,它们共同充当一个概念单元。

对于英语,使用词法分析和分块工具来获取句子中短语的边界,并使用一些语言切分工具来获取其他语言(例如中文)的单词 / 短语信息。

随机选择句子中的几个短语,对同一短语中的所有基本单元进行掩码和预测。 在这个阶段,短语信息被编码到词嵌入中。

3.3 实体阶段 Entity-Level Masking

名称实体包含人、地点、组织、产品等,可以用专有名称表示,这一步类似于‘成分切分’ or ‘命名实体识别’。

与短语掩码阶段一样,首先分析句子中的命名实体,然后对实体中的所有槽进行掩蔽和预测。

4. 遗留问题

看论文描述,将3种掩码策略混在一起使用,论文并未有具体描述