- 1Unity导入资源解决报错_unity导入lighting box 2 lit 报错

- 2java 像素转rgb,如何在Java中将getRGB(x,y)整数像素转换为Color(r,g,b,a)?...

- 3python的线上订餐系统_基于python的网上订餐系统

- 4python如何做到只在服务启动时执行_在后台启动时执行python脚本

- 5iOS MJRefresh上拉加载功能,每次运行下面都会有“上拉加载”这句话,中英文切换?_mjrefresh 选择语言

- 6Kafka集群搭建 (2.11-0.9.0.1)

- 7域名备案、服务器备案和网站备案有什么区别?_服务器备案和域名备案的区别

- 8智能照片修复软件Topaz Video AI mac中文新增功能_topaz video ai mac 中文

- 9【js】ajax加ContentType的方式_js ajax content-type

- 10Python:环境变量配置方法 详细教程_设置python环境变量配置

回归预测 | MATLAB实现TCN-LSTM时间卷积长短期记忆神经网络多输入单输出回归预测

赞

踩

回归预测 | MATLAB实现TCN-LSTM时间卷积长短期记忆神经网络多输入单输出回归预测

预测效果

基本介绍

1.Matlab实现TCN-LSTM时间卷积神经网络结合长短期记忆神经网络多变量回归预测;

2.运行环境为Matlab2021b;

3.输入多个特征,输出单个变量,多变量回归预测;

4.data为数据集,excel数据,前7列输入,最后1列输出,MainTCN_LSTMNN.m为主程序,运行即可,所有文件放在一个文件夹;

5.命令窗口输出RMSE、MAE、MAPE多指标评价;

模型描述

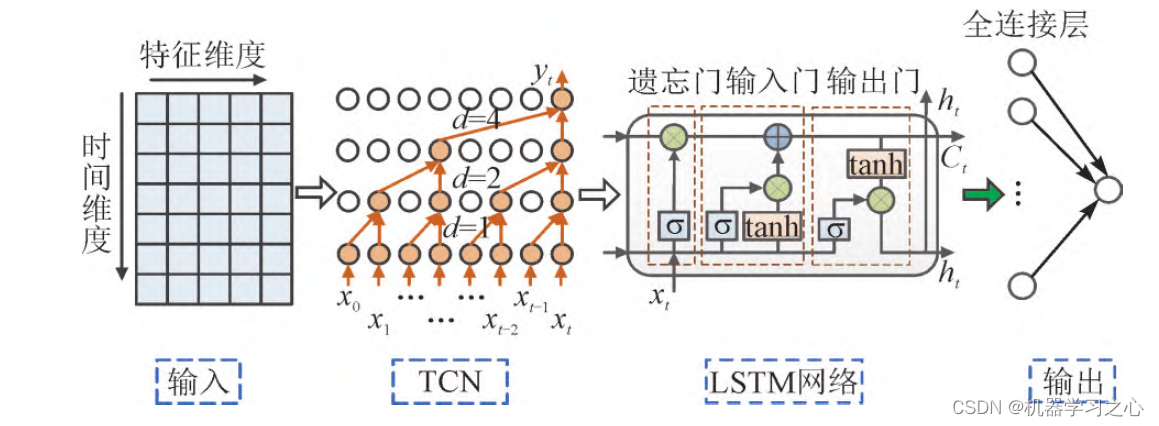

由于TCN 具有扩张因果卷积结构,拥有突出的特征提取能力,因此可对原始特征进行融合获得高维的抽象特征,加强了对特征信息的挖掘。而

LSTM 网络具有强大的时序预测能力,将TCN 和LSTM 网络结合,通过TCN 特征提取后输入至LSTM 网络,提高了LSTM 网络记忆单元的处理效

率,使得预测模型更有效地学习时间序列的复杂交互关系。因此,本文搭建了TCN-LSTM 预测模型。

TCN-LSTM是一种将时间卷积神经网络(TCN)和长短期记忆神经网络(LSTM)结合在一起的神经网络模型。TCN是一种能够处理序列数据的卷积神经网络,它能够捕捉到序列中的长期依赖关系。LSTM则是一种具有记忆单元的递归神经网络,它能够处理序列数据中的短期和长期依赖。

TCN-LSTM模型的输入可以是多个序列,每个序列可以是不同的特征或变量。例如,如果我们想预测某个城市未来一周的平均温度,我们可以将过去一段时间内的温度、湿度、气压等多个变量作为输入序列。模型的输出是一个值,即未来某个时间点的平均温度。

在TCN-LSTM中,时间卷积层用于捕捉序列中的长期依赖关系,LSTM层用于处理序列中的短期和长期依赖。多个输入序列被合并成一个张量,然后送入TCN-LSTM网络进行训练。在训练过程中,模型优化目标是最小化预测输出与真实值之间的差距。

TCN-LSTM模型在时间序列预测和回归问题上表现良好,特别是对于长期依赖的序列数据。它可以被用于许多应用场景,例如股票价格预测、交通流量预测等。

程序设计

- 完整源码和数据获取方式1:私信博主回复MATLAB实现TCN-LSTM时间卷积长短期记忆神经网络多输入单输出回归预测;

- 完整程序和数据下载方式2(订阅《组合优化》专栏,同时获取《组合优化》专栏收录的任意8份程序,数据订阅后私信我获取):MATLAB实现MATLAB实现TCN-LSTM时间卷积长短期记忆神经网络多输入单输出回归预测

%% 预测 t_sim1 = predict(net, p_train); t_sim2 = predict(net, p_test ); %% 数据反归一化 T_sim1 = mapminmax('reverse', t_sim1, ps_output); T_sim2 = mapminmax('reverse', t_sim2, ps_output); %% 均方根误差 error1 = sqrt(sum((T_sim1' - T_train).^2) ./ M); error2 = sqrt(sum((T_sim2' - T_test ).^2) ./ N); %% 相关指标计算 % MAE mae1 = sum(abs(T_sim1' - T_train)) ./ M ; mae2 = sum(abs(T_sim2' - T_test )) ./ N ; disp(['训练集数据的MAE为:', num2str(mae1)]) disp(['测试集数据的MAE为:', num2str(mae2)]) %% 平均绝对百分比误差MAPE MAPE1 = mean(abs((T_train - T_sim1')./T_train)); MAPE2 = mean(abs((T_test - T_sim2')./T_test)); disp(['训练集数据的MAPE为:', num2str(MAPE1)]) disp(['测试集数据的MAPE为:', num2str(MAPE2)]) % MBE mbe1 = sum(abs(T_sim1' - T_train)) ./ M ; mbe2 = sum(abs(T_sim1' - T_train)) ./ N ; disp(['训练集数据的MBE为:', num2str(mbe1)]) disp(['测试集数据的MBE为:', num2str(mbe2)]) %均方误差 MSE mse1 = sum((T_sim1' - T_train).^2)./M; mse2 = sum((T_sim2' - T_test).^2)./N; disp(['训练集数据的MSE为:', num2str(mse1)]) disp(['测试集数据的MSE为:', num2str(mse2)])

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

参考资料

[1] https://blog.csdn.net/kjm13182345320/article/details/128577926?spm=1001.2014.3001.5501

[2] https://blog.csdn.net/kjm13182345320/article/details/128573597?spm=1001.2014.3001.5501