- 1Vue3.0学习 - 第一节,diff算法、静态标记_diff静态标记

- 2程序员的岗位方向和所需技能都有哪些?_研发技术岗的技能

- 3Unity得到脚本名_unity 获得脚本

- 4两地三中心是什么意思

- 5IntelliJ IDEA 2020 如何解决Commit: Local Changes Refresh提交Git代码卡住超级慢(已解决)

- 6Unity DrawCall优化 - UGUI优化_unity drawcall怎么看

- 7unity3d,java,c#,python,rospy的socket通信测试_unity tcpclient收不到报文

- 81096: 水仙花数(函数专题,多实例)_利用实参和形参设计函数,判定水仙花数,实参传入数字,列出所有水仙花数

- 9程序员干到30岁,真的只能转行了么?_程序员30岁真的不能做吗

- 10基于JAVA+SpringBoot+Vue的前后端分离的旅游网站

上采样(UnSampling)、上池化(UnPooling)、反卷积(Deconvolution)与PixelShuffle(像素重组)之间的区别简介_pixelshuffle 反卷积

赞

踩

上采样(UnSampling):即输入特征图,将其缩放到所需大小(比如2*2的宽高--->4*4的宽高),其常用方法是插值方法(如最邻近插值、双线性插值和三次插值),其中,最邻近插值效果最差,放大后的图像有很严重的马赛克,但速度快;双线性插值,效果较好,速度也较快,经常被使用;三次插值,效果好,但速度慢。在深度学习中,我们经常是结合双线性插值和卷积操作来使用的。

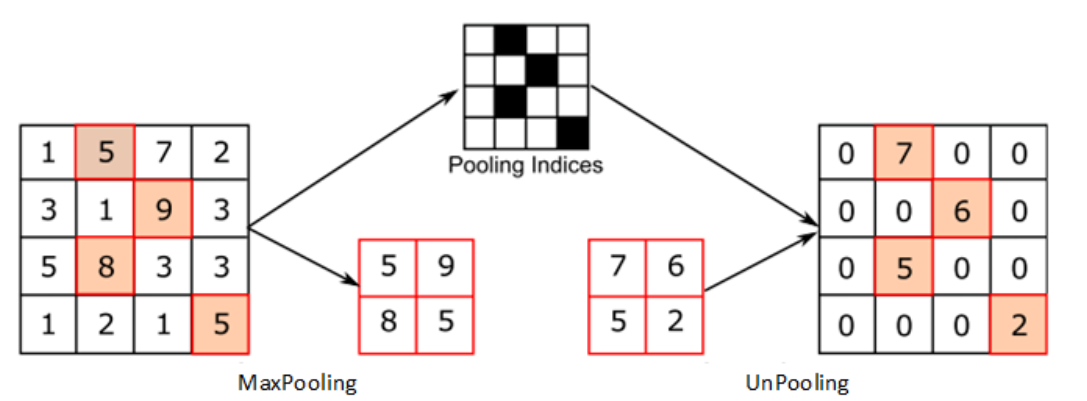

上池化(UnPooling):说到上池化操作,就不得不说最大池化操作(MaxPooling),最大池化操作就是选择池化区域内最大值来传递给下一层(这个过程是没有可学习参数),而上池化就是最大池化的逆过程,最大池化操作是不可逆的(除了最大值被保留),但我们可以记住池化操作中的索引值位置(池化区域内最大值的位置),在上池化的时候,就可以把此层的特征值放到相应索引值位置并且其它位置直接补0就行。

反卷积(Deconvolution):相比上池化,使用反卷积进行图像的“上采样”是可以被学习的(会用到卷积操作,其参数是可学习的)。从下面的动态图,我们可以知道,卷积核大小是3*3,而特征图则被间隔的插入0。但使用反卷积容易产生棋盘效应,详情可以参考我的一篇博客:反卷积(Deconvolution)与棋盘效应(Checkerboard Artifacts)_天竺街潜水的八角的博客-CSDN博客

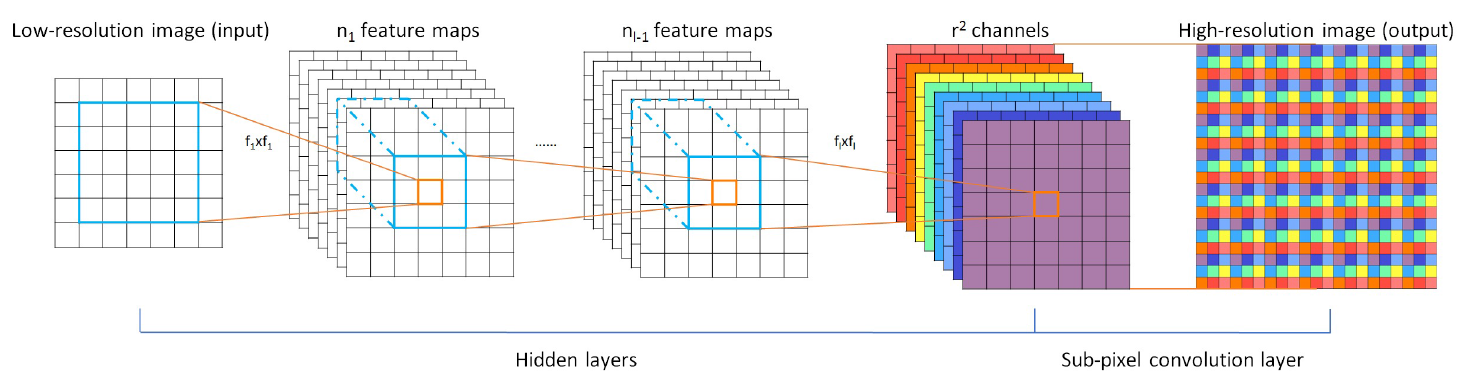

PixelShuffle(像素重组):pixelshuffle的主要功能就是将r*r个通道的特征图转换成新的w∗r,h∗r 的上采样结果(比如原来特征图大小为4*128*128,现在就调整成大小1*(128*2)*(128*2))。具体来说,就是按照一定规则将每个像素点的r*r个通道依次转换为对应的r*r的图像块。应用场所:在图像超分辨和图像增强的算法中需要对特征图进行上下采样的过程,可以解决插值和解卷积的一些人工痕迹问题,当然,也可以解决棋盘效应