- 1基于SpringBoot的教学资源库系统的设计与实现_基于springboot的教学资源文件共享系统的设计与实现

- 2c++小游戏(附源码)_c++小游戏代码

- 3解决:Ubuntu启动后突然进入tty,无法进入图形界面_ubuntu桌面tty1进不去

- 4AI免费一键生成Word、PPT文档,让工作和学习更轻松、更高效、AI办公工具_自动生成word的ai

- 5计算机毕业设计Node.js+uniapp教学质量评价系统小程序(源码+程序+lw+远程调试)_教学互动与评价小程序

- 6好用的三维绘图软件CREO学习标注尺寸_creo三维标注怎么标注直径

- 7AAAI2021 | 图神经网络最新进展解读

- 8HTML之列表标签——无序(ul)、有序(ol)、自定义(dl)_html有序列表标签

- 9babel-plugin-component 按需引入组件时报错 Parsing error: Cannot find module “babel-preset-es2015“ 的解决办法_parsing error: cannot find module 'babel-preset-es

- 10回溯法——利用解空间树解决0-1背包问题_回溯法求解01背包约束条件

一万年太久,只争朝夕 | Foundation model的进展仍不够快_foundation。mod io

赞

踩

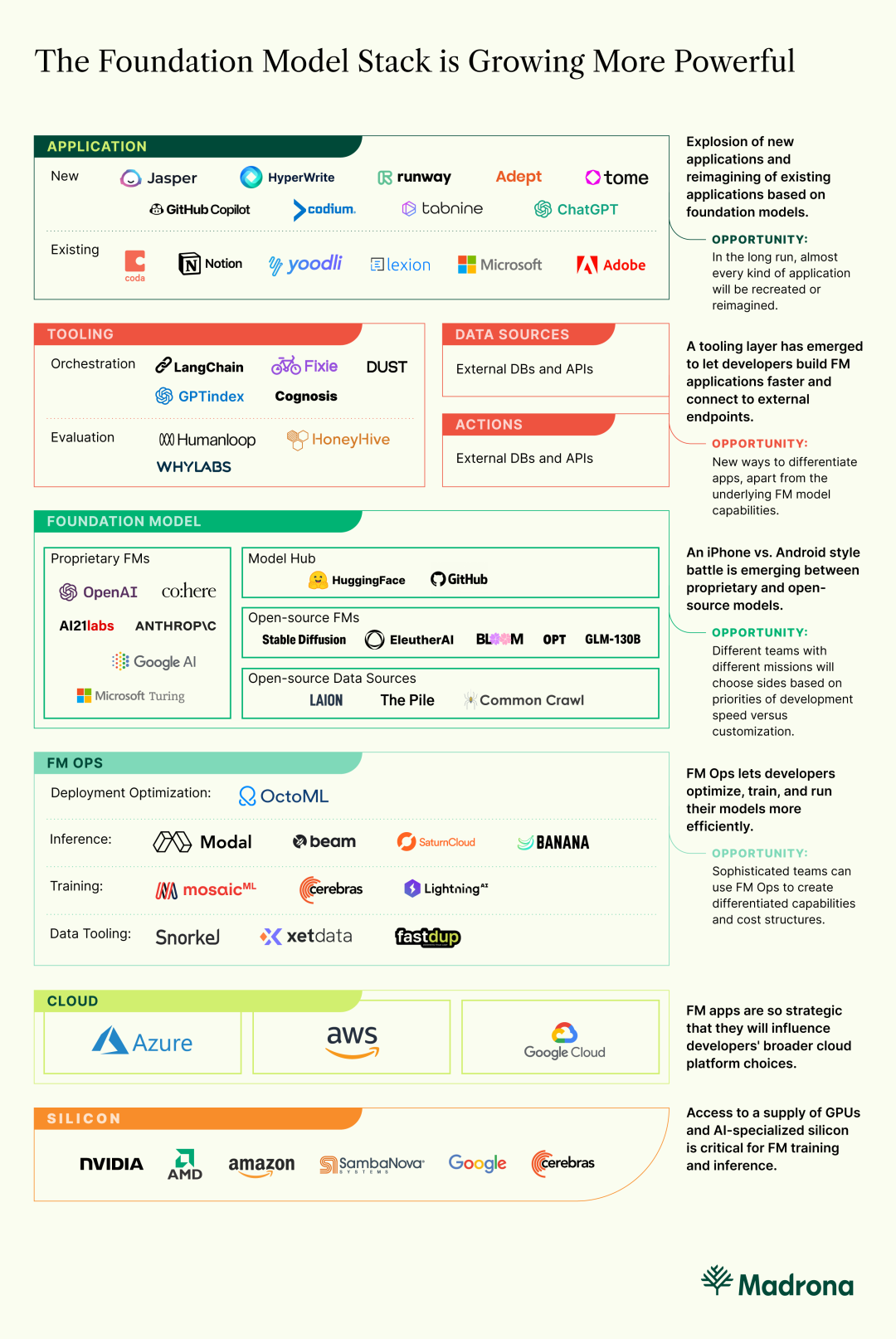

编者按:如今根基模型(Foundation Models)的应用和相关创新正在快速涌现,但仍有很大的提升空间,目前还无法充分发挥根基模型的潜能、将其高效快速地应用于企业级AI应用中。

根基模型的加速应用和落地,带动了基础设施和工具领域的创新。本期IDP Inspiration,我们为大家带来的是创投机构Madrona对于根基模型的发展研判,和大家一同从投资人的视角探寻根基模型发展带来的AI Infra新机遇。

以下是译文,Enjoy!

作者 | Jon Turow, Palak Goel & Tim Porter

编译 | 岳扬

人工智能领域目前的活动速度简直令人惊讶。基于根基模型(Foundation model),生成性AI应用程序和应用于数据的复杂推理的更大范畴的应用程序正在快速增多。 这些应用程序从实际的(加速代码开发[1]和测试[2]、法律合同[3]和奥斯卡提名电影的生产[4])到有趣的(多模态生成说唱对决)再到引人深思的(在美国医学执照考试中或接近通过水平)。而根基模型的能力、模型准确性和基础设施的演变速度至少与之一样快。

如果所有这些感觉都不同,那是因为它们确实不同。以前云计算的出现提供了以前不可能的计算能力,使得包括变换器(Transformer)模型在内的计算机科学的新领域成为可能。该模型[7]可以让人们使用云计算来构建更大的模型,这些模型更好地推广,并且能够完成新任务,例如文本和图像生成、汇总和分类。这些更大的模型已经显示出复杂推理、知识推理和超出分布稳健性的能力[8],而更小的、更专业化的模型都不具备这些能力。这些大型模型被称为根基模型(Foundation Models),因为开发人员可以在它们的基础上构建应用程序。

然而,尽管创新活动和步伐在飞速发展,未来仍然显然不够快,根基模型和生成式人工智能尚未达到目标。

构建者们面临一个不太令人满意的选择:打天下(机遇根基模型构建应用)容易守天下(形成护城河)难,或者相反。 在前一种情况下,根基模型允许开发者在一个周末(或几分钟)内创建应用程序,而此前需要几个月。但是,开发人员受到那些专有模型的现成功能的限制,其他开发人员也可以使用,这意味着开发人员必须富有创造力,找到差异化的来源。在第二种选择中,开发人员可以扩展开源模型体系结构的功能,以构建一些新颖且易于形成护城河的东西。但这需要极高的技术深度,仅有极少数的团队具备这种能力。能力集中在少数人手中与一个行业蓬勃发展所需要的恰好相反——我们需要更多的力量分散到更多的人手中,而不是更加集中。

但是,如果我们将大规模根基模型视为一种新的应用程序平台,提取出更广泛的技术栈,就会发现那些挑战是创业者的机会。我们去年晚些时候写了一篇文章,描述了这个栈,并预测工具层的出现。该栈发展如此之快(工具层也已经快速形成!),现在值得再次审视。

纵观当今根基模型栈的状态,我们发现了三个创业机会:

1)开发新颖的应用程序:技术最先进的团队面临着广阔的前景。有很多创新可以做,特别是在信息检索,混合模态和训练/推理效率方面。这个领域的团队可以推动科学的界限,创建以前不可能的应用程序。

2)寻找差异化:具有出色想法但仅有早期技术能力的团队现在可以访问工具,使得可以使用更丰富的记忆/上下文,更丰富的外部数据源和API,以及评估和缝合多个模型的能力来构建更丰富的应用程序。这为创始人提供了更广泛的途径构建新颖且易防御的产品,即使他们已经使用了广泛可用的技术。

3)开发工具:喜欢基础设施的团队现在有一个高效率的机会,可以在编排Orchestraction(开发人员框架,数据源和动作,评估) 和根基模型操作(部署,训练和推理的基础设施和优化工具) 方面构建工具。更加强大和灵活的工具将加强现有开发者的能力,并使根基模型栈能够被更多的新开发者使用。

1 根基模型Foundation Models

开发根基模型的人面临一个不吸引人的权衡——即基于模型构建新的应用程序的难易和对模型保护的难易之间的权衡,该权衡源于核心基础模型的建立和开源方式。 开发者今天必须在 iPhone/Android,Windows/Linux 风格的战争中选择一方,在每一方都有痛苦的妥协。

一方面,我们看到来自 OpenAI、co:here 和 AI21 等高度复杂、快速演变的专有模型 (我们也可以把谷歌加入到这个名单中,因为他们在这些模型上花费的时间比任何人都长[9],而且计划将模型外部化[10])。另一方面是开源架构,如 Stable Diffusion[11]、Eleuther、GLM130B、OPT、BLOOM、Alexa Teacher Model 等,都在 Huggingface[12] 上组织成社区中心。

1.1 专有模型

专有模型是由拥有雄厚资金和技实力的提供商所拥有的,这意味着他们可以提供行业领先的模型性能。它们的现成模型也意味着开发人员可以轻松上手。Azure的新OpenAI服务使得入门变得比以往更容易,我们预计这将加速开发人员的实验速度。

这些人也在考虑成本——OpenAI 在2022年末将价格降低了60%,Azure 也相应的调整了价格。但是这里的成本仍然很高,限制了商业模式的可持续性发展。按席位许可证(per-seat licenses )和基于使用定价(consumption-based pricing)等模式在早期很普遍,这些可以持续。但是广告支持的业务模型可能不会产生足够的收入来覆盖这一水平的成本。

1.2 开源模型

开源模型的性能不如专有模型,但是在过去一年中有了显著改善。更重要的是,技术复杂度高的建设者可以拥有扩展这些体系结构的灵活性,并建立尚不可能用专有模型实现的差异化功能(这是我们喜欢 Runway 的原因之一,Runway 是一个下一代内容生成套件,提供实时视频编辑、协作等。为了支持所有这些功能,Runway 继续对多模态系统和生成模型的科学做出深入贡献,以加速 Runway 的客户的特征开发)。

专有根基模型和开源根基模型之间的紧张关系已经像iPhone/Android 的战争一样。专有模型的优势是性能和易于上手。开源模型的优势是灵活性和成本效率。 可以肯定的是每个阵营都会加大投资以解决其弱点(使 OSS 模型更容易上手,并使其有可能更深入地扩展OpenAI模型),同时也要充分利用它们的优势。

2 Tooling / Orchestration

强大、灵活的工具能够使现有开发者的能力变得更加强大,使更多的新开发者能够使用根基模型技术栈。

我们在2022年10月写道[13]:“根基模型并不是’just work’仅运行即可,因为它们只是广泛的软件栈中一个组成部分。如今,从根基模型中得到最好的推理效果,需要应用开发者采取很多辅助措施“。

我们确实看到开发人员在软件栈的这一层次上有密切关注。很多最酷的、回报最高的工作将在未来几个月内发生在软件栈之上,特别是在开发者框架、数据源、优化措施以及评估方面。

2.1 开发者框架

过去的经验告诉我们,框架(dbt,Ruby)对于将大型应用程序的各个部分连接起来是很有用的。根基模型开发框架让开发者很容易地将诸如跨多个调用的Context、提示工程和根基模型的选择(或多个模型的顺序) 结合起来。研究人员已经开始量化[14]这些使用根基模型构建的应用有多么强大。LangChain[15]、Dust.tt[16]、Fixie.ai[17]、GPT Index[18]和Cognosis[19]是这部分软件栈中最吸引开发者的项目。不好描述上手其中一些框架是多么容易。但是演示起来真的很容易,所以我们现在就给大家演示一下。下面是LangChain开发者指南中的四行入门代码:

这样的开发者框架使入门使用根基模型变得十分简单,甚至几乎成为一种乐趣。敏锐的开发者可能会注意到,通过上面的代码,如果开发者想要更换已启动的应用程序底层LLM/FM,几乎不费吹灰之力。从长远来看,使开发变得更容易往往会带来更多的开发者,并加速新应用程序的出现。在工具层面的创新速度已经非常快,这为工具的开发者和使用工具创建新应用程序的开发者创造了很多机会!

2.2 数据源和优化措施

如今根基模型只会推理它们接受训练的那些事实。但这对于需要根据变化极快的现实数据做出决策的应用开发者和终端用户来说,是个很大的限制,比如天气、金融市场、旅游市场、供应库存等等。因此,当我们想进行“hot” information retrieval时,这将是一件大事。在这种情况下,我们不需要训练或编辑模型,而是让模型调用外部数据源并实时推理这些数据。Google Research和Deepmind在这个方向上发表了一些不错的研究论文[20],OpenAI也是如此。所以,“hot” information retrieval时代即将到来,特别是目前在这个领域的研究成果转商业应用的速度非常快。

上述提到的开发者框架预见到了根基模型科学的演变,并开始支持一些外部数据源。按照类似的思路,开发者框架也将支持一些”下游“领域的概念(比如调用外部API,如Salesforce、Zapier、Google Calendar,甚至AWS Lambda serverless计算函数)。通过这些外部数据和优化措施的整合,很多新型根基模型应用将变得可能,而这在以前是很难或不可能的,特别是对于在专有模型之上构建应用的早期团队。

2.3 评估

我们在2022年10月[13]写道:“我们必须小心谨慎对待根基模型,因为我们永远不知道它们会说些什么或做些什么。这些模型的提供者,以及建立在它们之上的应用开发者,必须接受承担这些风险的责任。”可以预见开发人员在这方面很快就会变得更加成熟。Academic benchmarks(学术评估基准)是评估模型性能的重要步骤。但是,即使是像HELM这样最复杂的评估基准也是不完美的,因为它们不是面向所有用户群或所有特定使用案例而设计的。

最好的测试集来自于最终用户。生成的建议中有多少被接受?chatbot有多少次对话的 "转折"?用户在一张特定的图片上停留了多长时间,或者他们分享了多少次?这些类型的输入总体上描述了一种模式,然后开发者可以用它来定制或解释一个模型的行为,以达到最大效果。HoneyHive[21]和HumanLoop[22]是两个典型的公司,它们帮助开发者迭代根基模型架构,修改提prompts,过滤和添加新的训练集,甚至提炼模型以提高指定用例的推理性能。

3 Tooling / FMOps

计算是根基模型公司的主要成本驱动因素,制约了他们可以选择的商业模式。新一代的部署优化、训练工具和基础设施,正在帮助开发者解锁新的商业模式。

根基模型对训练和推理有巨大的计算要求,需要大量的专业硬件,这导致应用开发者面临高成本和运营限制 (吞吐量和并发量) 。大公司有实力来维持,微软在2020年建设了世界前5名的超算基础设施用于支持OpenAI发展。但是,即使是巨头公司也面临着供应链和经济上的限制。因此,训练、部署和推理优化是投资的关键领域,在这里我们看到了大量的创新点和机会。

3.1 训练

现在开源根基模型的修改和再训练比以往要容易。 最大的根基模型(foundation models)训练费用超过1000万美元,而Chinchilla[23]和Beyond Neural Scaling Laws[24]等论文表明,根基模型可以用50万美元甚至更少的费用训练,这意味着更多的公司可以自己创建根基模型。如今,AI从业者可以获取很多大规模的数据集,如LAION[25](图像)、PILE[26](多样化的语言文本)和Common Crawl[27](网络抓取数据)。他们可以使用Snorkel[28]、fastdup[29]和xethub[30]等工具来策划、组织和获取这些大型数据集。他们也可以访问HuggingFace获取最新和最强大的开源模型架构。他们还可以使用来自Cerebras[31]、MosaicML[32]等训练基础设施来大规模地训练这些模型。这些资源对于利用最新的模型架构、修改重构这些架构的代码,然后在公共和专有数据的基础上训练私人模型是非常强大的。

3.2 部署和推理

持续的推理成本没有像训练成本那样急剧下降。大部分的计算成本将最终用于推理,而不是训练。推理成本最终对开发者造成了更大的限制,因为它也限制了公司可以选择的商业模式。 Apache TVM[33]等部署框架以及蒸馏和量化[34]等技术都可以帮助降低成本,但这些都需要相当的技术深度才能使用。OctoML[35](TVM的开发者)提供可以降低成本和部署时间的管理服务,并能最大化利用很多算力硬件。这使得更多开发者可以使用这些类型的优化,同时也让开发者能够更有效地工作。很多托管推理公司,如Modal Labs[36]、Banana[37]、Beam[38]和Saturn Cloud[39],也想要使推理比直接在AWS、Azure或GCP等超级服务器上运行更具成本效益。

4 #HereWeGo

对于大规模foundation models(根基模型),我们才刚刚开始触及表面。大型科技公司和资本雄厚的初创公司正在大力投资于更大、更好的模型、工具和基础设施。但最好的创新需要无畏的技术和产品灵感。

围绕根基模型相关的创新仍然会源源不断,但是其速度和质量将会受到很多限制,直到软件栈足够完善能够让仅在某一方面有突出优势的团队也能作出巨大贡献。 这些工作都需要由大科技公司及其创始人、学者、开发者、开源社区和投资者共同完成。同时,所有这些创新都需要考虑有没有伦理道德负面影响,有没有潜在的意外后果,并将必要的防护措施做到位,这至少与推进技术本身具有同等重要性。

要让未来AI驱动的高质量应用源源不断的出现,这需要我们所有人共同努力。我们期待看到企业家们提出什么新的想法来帮助释放根基模型的真正力量,并实现人人期望的广泛创新和影响力。

参考资料

1.https://github.com/features/copilot

3.https://www.lexion.ai/products/ai-contract-assist

5.https://twitter.com/russelljkaplan/status/1617070021406265345?s=20

6.https://www.medrxiv.org/content/10.1101/2022.12.19.22283643v2

7.https://arxiv.org/pdf/1706.03762.pdf

8.https://arxiv.org/pdf/2206.07682.pdf

9.https://ai.googleblog.com/2023/01/google-research-2022-beyond-language.html?m=1

10.https://www.nytimes.com/2023/01/20/technology/google-chatgpt-artificial-intelligence.html

11.https://research.runwayml.com/the-research-origins-of-stable-difussion

14.https://arxiv.org/abs/2212.14024

15.https://langchain.readthedocs.io/en/latest/

18.https://github.com/jerryjliu/gpt_index

19.https://github.com/cognosisai/platform

20.https://arxiv.org/pdf/2211.05110.pdf

22.Humanloop – The platform for GPT-3 applications

23.https://arxiv.org/pdf/2203.15556.pdf

24.https://arxiv.org/pdf/2206.14486.pdf

26.https://arxiv.org/pdf/2101.00027.pdf

29.https://github.com/visual-layer/fastdup

34.https://lilianweng.github.io/posts/2023-01-10-inference-optimization/

本文经原作者授权,由Baihai IDP编译。如需转载译文,请联系获取授权。

原文链接:https://www.madrona.com/foundation-models/

关于原作者: 作者Jon Turow, Palak Goel & Tim Porter来自Madrona Venture Capital,在根基模型基础设施进行了多次投资,并致力于帮助加速根基模型未来的到来。从事或者对根基模型领域的应用程序、根基模型构建及其工具感兴趣的小伙伴,可与原作者(jonturow@madrona.com和palak@madrona.com)联系。