- 1智能物联网与Web3:连接未来数字生活的桥梁

- 2easypoi 导出word并插入echart图片和文件_apipost导出word

- 3java面试不怎么问基础,Java基础(面试必问点)

- 4高斯随机数发生器(verilog实现)_verilog随机数发生器

- 5【Python实战项目】做一个 刮刮乐 案例,一不小心....着实惊艳到我了。_用pycharm实现刮刮乐

- 6第10章 初识Spring MVC框架_spring mvc的特点是spring框架的后续产品

- 7JavaEE----JPA中配置文件persistence.xml_jpa mapping-file

- 8数据结构 Java数据结构 --- 二叉树_java二叉树结构

- 9工程经济学第一章总结_工程经济第一章太痛苦

- 10【Flask 系统教程 5】视图进阶

langchain+通义千问-1_8B-Chat-Int4搭建本地知识库_int4量化 langchain

赞

踩

书接上回,在本地运行了通义千问-1_8B-Chat,又想用通义千问+langchain搭建本地知识库。

首先在GitHub下载 langchain 的包,GitHub上有快速上手教程,我基本上是按照这个教程搭建的。

- # 拉取仓库

- $ git clone https://github.com/chatchat-space/Langchain-Chatchat.git

1. 使用conda新建python虚拟环境,新建环境这里不过多描述,因为GitHub上推荐使用3.11.7,所以我新建环境使用python3.11.7。

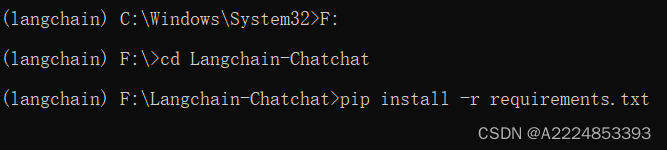

2. 虚拟环境建好之后安装langchain需要的依赖。

- # 进入目录

- $ cd Langchain-Chatchat

-

- # 安装全部依赖

- $ pip install -r requirements.txt

- $ pip install -r requirements_api.txt

- $ pip install -r requirements_webui.txt

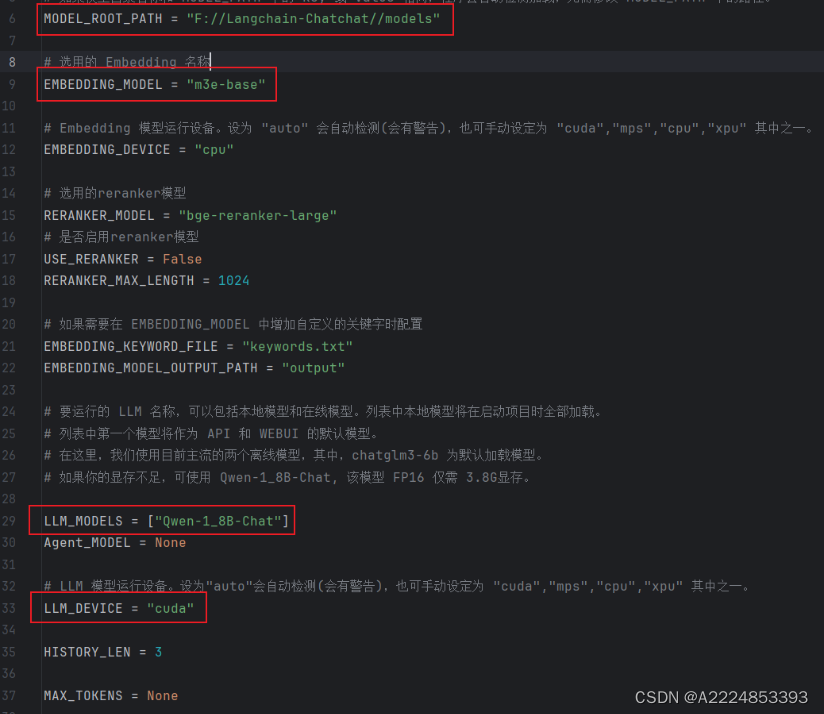

然后下载需要的 LLM 与 Embedding 模型,LLM模型我用的是通义千问-1_8B-Chat-Int4(魔搭社区),Embedding 模型用的是m3e-base(魔搭社区)。LLM模型最开始我使用没有量化的1.8B版本,4G的3050显卡报OOM,显存带不起来,所以换成了int4量化版本,推理最低仅需不到2GB显存,生成2048 tokens仅需3GB显存占用。

在Langchain-Chatchat下新建文件夹models,放置 LLM 模型与 Embedding 模型。

3. 模型下载完初始化知识库和配置文件。

- $ python copy_config_example.py

- $ python init_database.py --recreate-vs

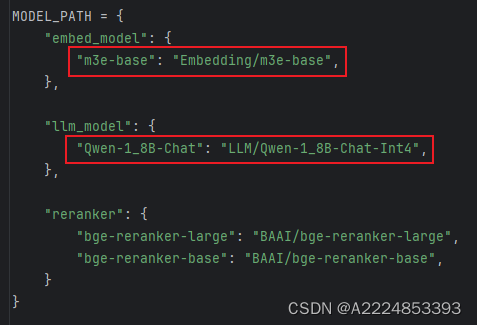

先运行 copy_config_example ,这一步就是复制一份配置文件,运行这一步会覆盖掉已经修改的配置文件。然后修改 Langchain-Chatchat\configs 下的 model_config.py。主要是修改模型的路径和使用哪个模型,运行LLM模型使用显卡。

然后运行 init_database ,初始化知识库。

4. 所有配置已完成就可以启动项目了。

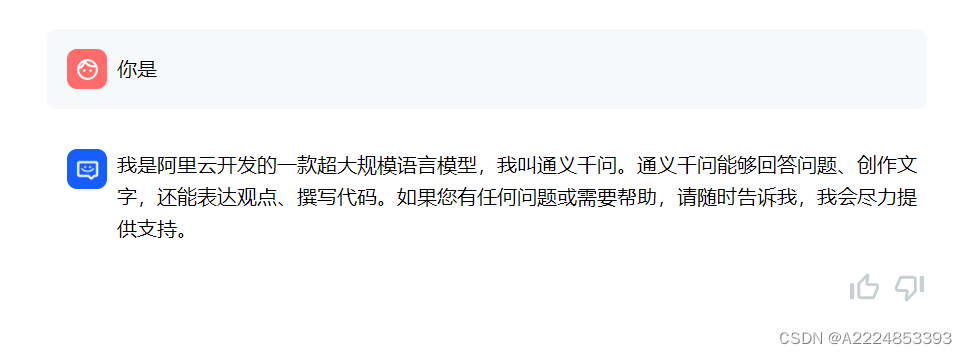

运行成功后会自动打开网页。

可以直接对话。

新建本地知识库,新建知识库名称不支持中文。

新建完知识库回到对话,就可以知识库问答了。

搭建时报的错误,按照报错提示可以解决大部分,剩下的网上可以搜到解决方法。

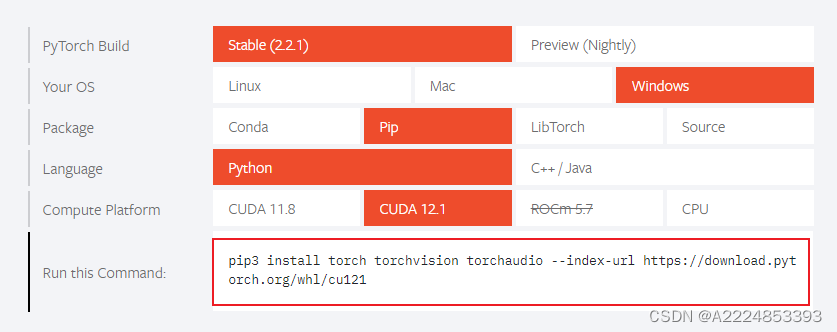

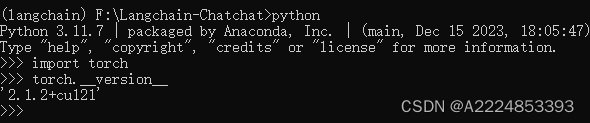

使用显卡运行LLM需要CUDA平台的pytorch。

下面这个地方是报错提示修改,提示加上 disable_exllama=True。