shap,一个神奇的 python 库

赞

踩

今天给大家分享一个神奇的 python 库,shap

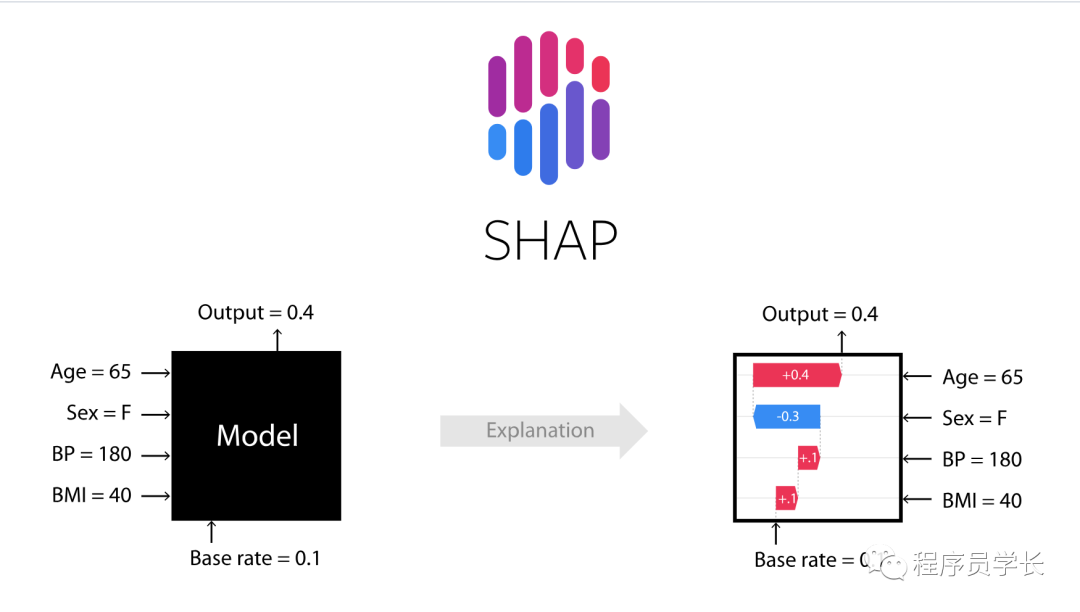

SHAP 是一种流行的机器学习解释性框架,用于解释预测模型的输出。通过利用合作博弈论,SHAP 为每个特征分配一个值,反映其对特定实例预测的贡献。这些 SHAP 值使用户能够理解和解释复杂模型的行为。

SHAP 库特别适用于解释复杂的机器学习模型,如随机森林、梯度增强机和深度神经网络。

为什么可解释性很重要?

可解释性在机器学习中至关重要,主要是因为:

-

模型透明度:了解模型如何进行预测可以让利益相关者信任并采用其结果。

-

监管合规性:在某些行业,例如金融和医疗保健,法规要求模型具有可解释性。

-

模型调试:可解释性技术有助于识别模型中的错误、偏差和意外后果,从而提高其性能和可靠性。

-

道德考虑:确保模型预测的公平性并消除偏差,需要了解模型的决策过程。

SHAP 的特点

-

模型不可知性:SHAP 可以用于各种机器学习模型,不依赖于模型内部的工作机制。

-

基于 Shapley 值:SHAP 使用博弈论中的 Shapley 值来量化每个特征对模型预测的贡献。

-

局部解释:SHAP 着重于提供局部解释,即解释单个预测,这对于理解特定情况下模型的决策过程特别有用。

-

全局解释:通过汇总单个预测的解释,SHAP 也可以提供关于模型整体行为的见解。

-

可视化工具:SHAP 提供了多种可视化工具,这些工具可以帮助用户更好地理解和解释模型预测。

初体验

库的安装

可以直接使用 pip 来进行安装。

pip install shap

- 1

加载数据并训练模型

下面我们训练一个 xgboost 模型。

import xgboost

import shap

# train an XGBoost model

X, y = shap.datasets.california()

model = xgboost.XGBRegressor().fit(X, y)

- 1

- 2

- 3

- 4

- 5

- 6

解释模型的输出

使用 SHAP 来解释 xgboost 模型的预测。

并使用 waterfall 方法可视化第一个预测的解释,其中正值(红色)表示该特征推高了预测结果,而负值(蓝色)表示它降低了预测结果

explainer = shap.Explainer(model)

shap_values = explainer(X)

# visualize the first prediction's explanation

shap.plots.waterfall(shap_values[0])

- 1

- 2

- 3

- 4

- 5

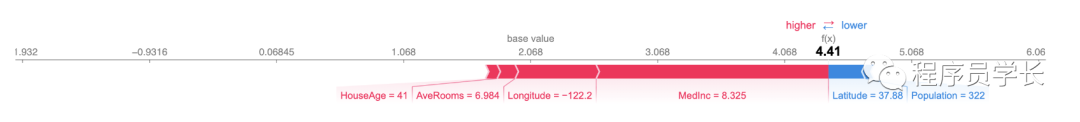

我们还可以使用力图来可视化。

shap.plots.force(shap_values[0])

- 1

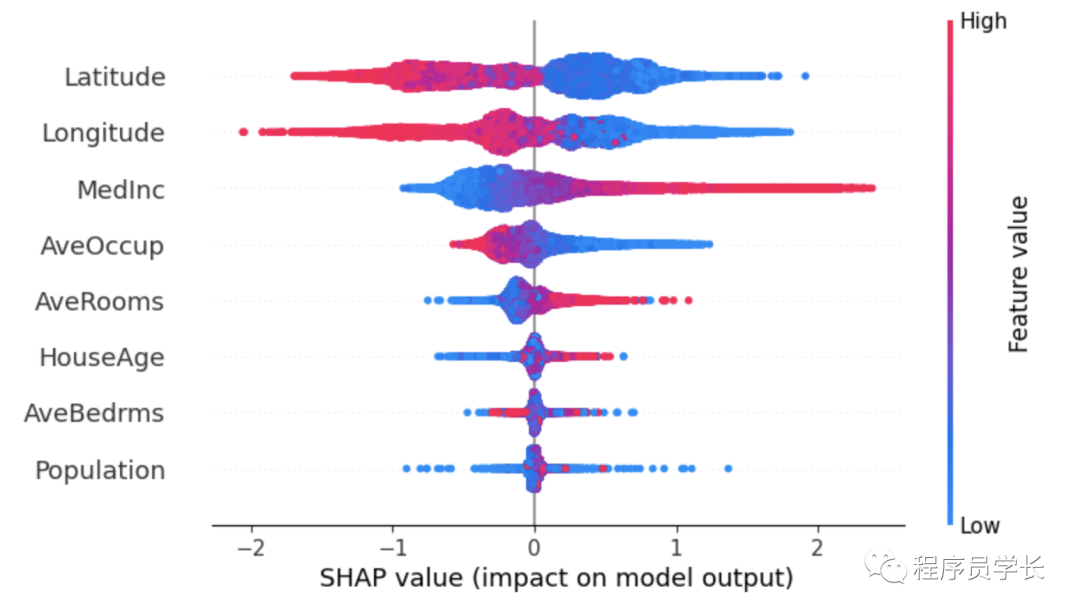

为了概述哪些特征对模型最重要,我们可以绘制每个样本的每个特征的 SHAP 值。下图按所有样本的 SHAP 值大小总和对特征进行排序,并使用 SHAP 值显示每个特征对模型输出的影响的分布。颜色代表特征值(红色高,蓝色低)。例如,这表明较高的中位收入会提高房价的预测。

shap.plots.beeswarm(shap_values)

- 1

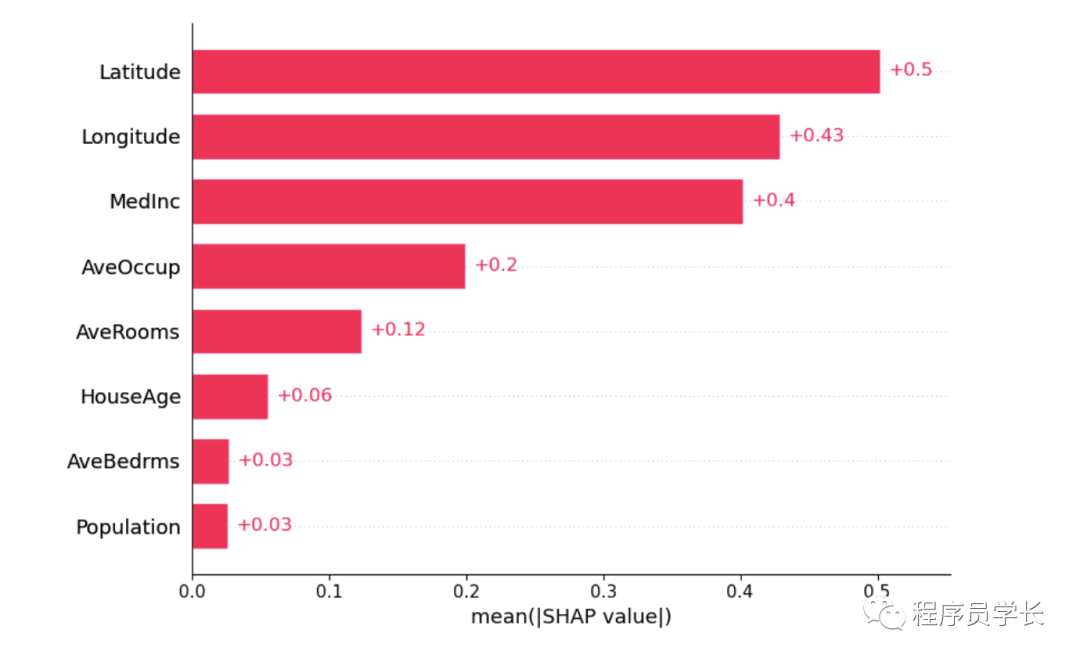

我们还可以只取每个特征的 SHAP 值的平均绝对值来获得标准条形图。

shap.plots.bar(shap_values)

- 1

题外话

感谢你能看到最后,给大家准备了一些福利!

感兴趣的小伙伴,赠送全套Python学习资料,包含面试题、简历资料等具体看下方。

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。